L’intelligenza artificiale è una tecnologia “nuova” che sta trovando applicazione in numerosi campi scientifici, industriali, sociali e politici, e – come per ogni nuova tecnologia – nella sua applicazione possono emergere dei problemi di carattere etico e morale.

In questo post:

- cerco di mettere in rilievo perché sia opportuno dedicare attenzione alla correlazione tra intelligenza artificiale e questioni etiche e morali

- analizzo due casi concreti di utilizzo di tecnologie intelligenti alla ricerca di spunti di riflessione

- provo a rappresentare un esempio di catena di responsabilità nella realizzazione di questo tipo di tecnologie

- e, infine, traggo delle conclusioni di ordine morale – che mi piacerebbe che fossero normative

Per definire convenzionalmente e localmente – giusto per la lettura di questo post – l’Intelligenza Artificiale, mi attengo a questa coppia di definizioni, la prima di “intelligenza”, di E. Scribano, in un suo libro su Descartes, da me modificata in senso più generale, e la seconda di “artificiale”, dal Dizionario Treccani:

- intelligenza: il vivente è una macchina intelligente, se traduciamo questo termine nell’insieme dei comportamenti causati da stati fisici che consentono al corpo vivente di reagire all’ambiente in modo funzionale a degli obiettivi [1], tenendo conto dell’esperienza passata [2]

- artificiale: fatto, ottenuto con arte

Allo stesso livello di generalità prendiamo in considerazione la definizione che si trova sul sito di un gigante delle tecnologie, la Oracle Corporation:

Intelligenza Artificiale (I.A.): sistemi o macchine che imitano l’intelligenza umana per eseguire certe attività e che sono in grado di migliorarsi continuamente in base alle informazioni raccolte [3]

PERCHÈ PARLARE DI ETICA E DI MORALE ASSOCIATE ALL’IA?

La riflessione può nascere in un contesto molto familiare, la guida di una automobile con un sistema intelligente anti-collisione: il sistema ha provocato la frenata, ha letteralmente “inchiodato” la macchina in mezzo al Carrobbio [4], senza che il guidatore (io) capisse perché o potesse intervenire. La ragione della frenata era un gatto che era passato a pochi centimetri dal sensore radar e che, senza anti-collisione, forse non avrei risparmiato.

Le lateralità di questo salvataggio di un gatto del Carrobio sono state, per fortuna, senza conseguenze:

1) il cane di famiglia è finito a gambe all’aria nel bagagliaio

2) l’auto che mi seguiva ha inchiodato a sua volta evitando il tamponamento

Non si può negare, osservando questo caso banale, che un problema morale nell’utilizzo di tecnologie intelligenti c’è.

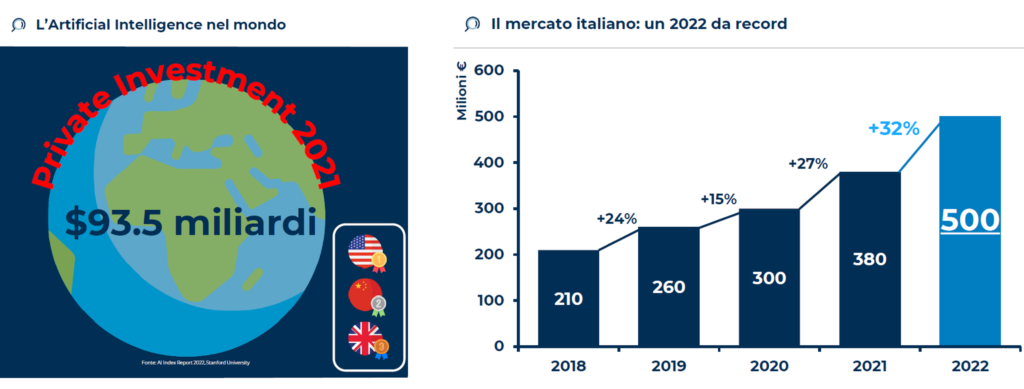

C’è ed è pervasivo: nel 2022 gli investimenti per l’IA sono di 500 milioni di euro in Italia [5] e di più di 90 miliardi di dollari nel mondo[6].

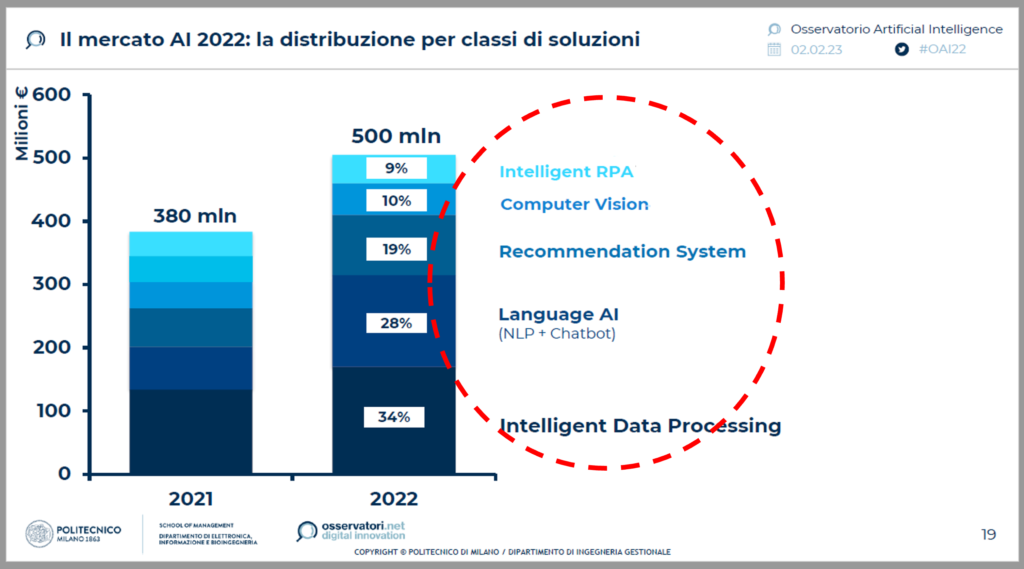

C’è e prende diverse direzioni: gli investimenti in Italia sono destinati all’Elaborazione Intelligente di Dati (34%), alla Comprensione del Linguaggio Naturale (28%), ai Sistemi di Supporto alla Decisione (19%), alla Visione Computerizzata (10%) e all’Automazione Robotica dei Processi.[7]

Il caso della frenata, del gatto del Carrobbio e del cane di famiglia si colloca tra Visione Computerizzata, Elaborazione Intelligente di Dati e Automazione dei Processi.

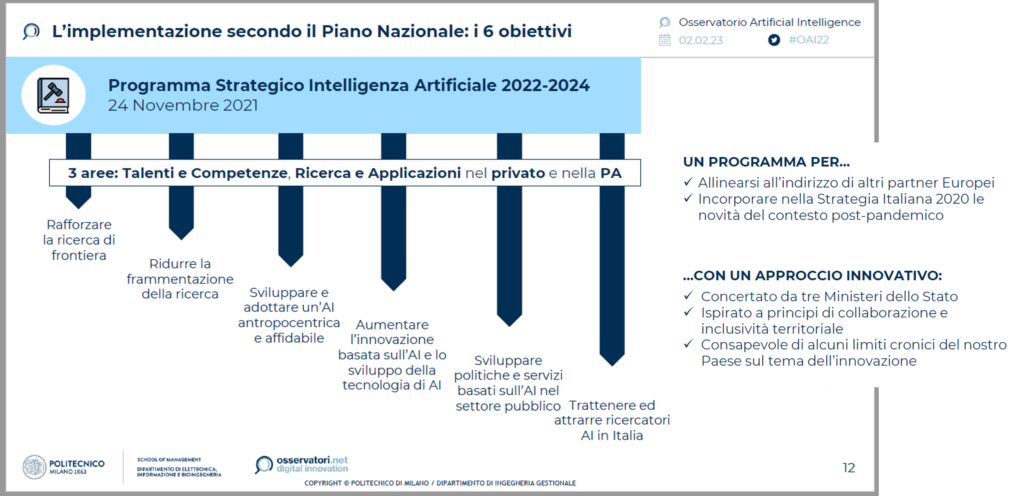

Inoltre, lo sviluppo delle tecnologie di IA è sostenuto dalle Istituzioni: ad esempio, lo Stato italiano ha elaborato un Programma Strategico per gli anni 2022 – 2024, focalizzato su Talenti (da creare o trattenere), Competenze (da generare) e Applicazioni, nel privato e nella Pubblica Amministrazione. [8]

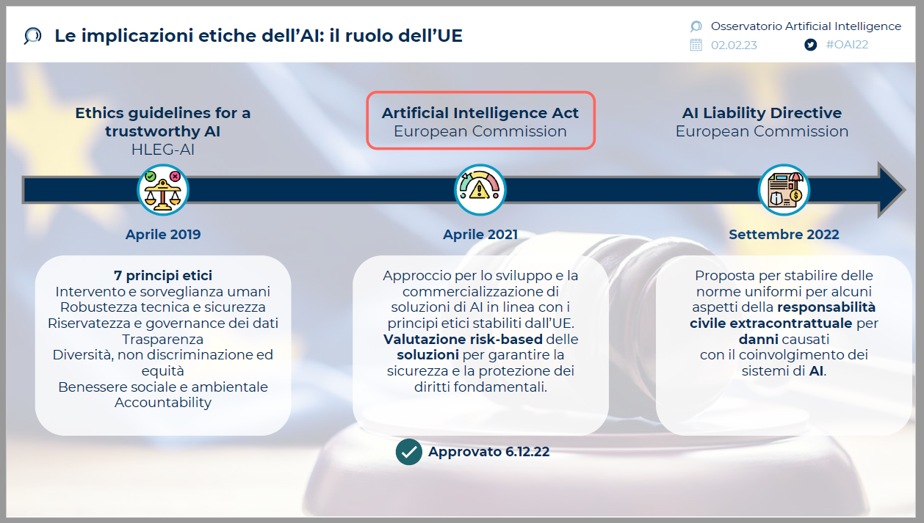

Le Istituzioni non nascondono il problema morale e alcune preoccupazioni; tra il 2019 e il 2022, l’Unione Europea ha varato 3 deliberazioni [9] che cercano di normare le implicazioni etiche della nuova tecnologia: le “Linee Guida per una IA affidabile” si focalizzano sulla robustezza, sul rispetto della sicurezza degli esseri umani (escludendo il gatto del Carrobbio, il cane di famiglia e altri viventi non umani), della trasparenza, della privacy, della non-discriminazione, del benessere ambientale e sociale, e sulla attribuzione di responsabilità per le azioni delle tecnologie; un Atto per l’Intelligenza Artificiale, che delinea l’approccio corretto per lo sviluppo e l’applicazione; una proposta per stabilire delle norme di responsabilità civile in caso di danni.

Il problema morale è enfatizzato dal comportamento delle Aziende: più di un terzo delle Aziende che utilizzano IA non ritiene rilevante il tema etico, il 40% lo prende in considerazione in termini futuri o in modo destrutturato; solo il 21% ha una strategia definita[10] .

——-

L’APPROCCIO DEL PARLAMENTO EUROPEO

Una pubblicazione del Parlamento Europeo, su rischi e vantaggi dell’Intelligenza Artificiale, esprime la visione dell’Istituzione che legifera per l’EU sull’IA:

“L’intelligenza artificiale può consentire lo sviluppo di una nuova generazione di prodotti e servizi, anche in settori in cui le aziende europee sono già in una posizione di forza come l’economia circolare, l’agricoltura, la sanità, la moda e il turismo. Può infatti offrire percorsi di vendita più fluidi e ottimizzati, migliorare la manutenzione dei macchinari, aumentare sia la produzione che la qualità, migliorare il servizio al cliente e risparmiare energia.” [11]

“L’intelligenza artificiale potrebbe significare una migliore assistenza sanitaria, automobili e altri sistemi di trasporto più sicuri e anche prodotti e servizi su misura, più economici e più resistenti. Può anche facilitare l’accesso all’informazione, all’istruzione e alla formazione.” [12]

“L’IA aiuta a rendere il posto di lavoro più sicuro, perché il lavoro più pericoloso può essere demandato ai robot, e offrire nuovi posti di lavoro grazie alla crescita delle industrie dell’intelligenza artificiale.”[13]

E stima l’aumento della produttività del lavoro tra l’11% e il 37% entro il 2035. [14]

L’approccio tradisce la visione scientista, positivista ed efficientista –che proviene dalla pratica scientifica e dalle aziende che ricercano efficacia ed efficienza.

Poco viene detto sulle lateralità negative.

Si potrebbe tradurre: benvenuta la nuova tecnologia che aiuta la crescita e il comfort delle persone che già hanno la gran parte delle opportunità e dei privilegi.

———

DUE CASI CONCRETI ED EMBLEMATICI

Il primo caso esemplare è quello già accennato del radar anti-collisione dell’automobile.

Tra i soggetti potenzialmente coinvolti negli effetti di applicazione ci sono – oltre al gatto del Carrobbio e al cane di famiglia: il guidatore, i passeggeri che possono riportare danni, i passanti che si possono salvare, gli altri automobilisti che hanno tempi di reazione molto minori del sistema e possono subire danni fisici in caso di tamponamento.

Il problema morale, in questo caso, può essere delineato in questi termini:

- il sistema deve intervenire o solo “avvisare”, cioè, suggerire al guidatore un intervento?

- Cosa farebbe un umano senza il sistema?

- Che frequenza e gravità hanno gli effetti collaterali negativi?

- Per gestire il trade-off tra danni ad un vivente e un altro, si deve fornire al sistema una scala di valore delle categorie di esseri viventi per decidere cosa fare?

- Quanto deve essere grande e vicina la sagoma rilevata, per attivare la frenata?

- Si deve lasciare al guidatore la possibilità di disattivare il sistema?

- Come sono influenzate dalle culture locali, in Europa, in USA, in Cina, le categorie logiche che informano il sistema? John, Hu, Michelle, Stella darebbero le stesse istruzioni alla macchina? E quando Jack usa la macchina di Michelle?

Il secondo contesto che esaminiamo è quello delle applicazioni in campo medico, in particolare dei sistemi intelligenti di supporto alla diagnosi, per i quali KBV Research stima 1,3 miliardi di dollari di spesa all’anno.[15]

Le principali applicazioni diagnostiche, basate sui grandi numeri e sull’analisi statistica, sono rivolte a pratiche come:

- la diagnosi differenziale – che è discernimento tra diverse possibili patologie con sintomatologie simili

- la ricerca di pattern fuori focus – cioè, di sintomi, fenomeni, elementi e manifestazioni minori che, se identificati, possono aiutare a diagnosticare patologie che sono fuori dal focus diagnostico principale

- l’analisi ex-post del tasso di errore diagnostico umano, per esempio a fronte di determinati schemi di sintomi che “puntano” a diverse possibili patologie

per ridurre il tasso di errore diagnostico umano.

Una ragione per cui si investono capitali così ingenti sulle tecnologie diagnostiche intelligenti è, infatti, l’incidenza di errori diagnostici dei medici, che si stima causi alcune migliaia di morti in Italia e decine di migliaia negli USA;[16] oltre al costo sociale, questi errori comportano anche costi finanziari ingenti – in termini di ulteriori esami, ricoveri e, soprattutto, risarcimenti.

Le cause degli errori diagnostici, secondo uno studio congiunto di Sidney University e University of Newcastle (Aus), sono per il 15% di tipo cognitivo, legate a:

- uso errato della statistica

- ancoraggi, ossia collegamenti rigidi tra situazioni sintomatiche e diagnosi

- errori di framing

- pletora o carenza di esami

- fissazione su esperienze di successo

- cecità attentiva

In questo senso, i tanti sostenitori dell’utilizzo delle tecnologie intelligenti in diagnostica, che si richiamano al concetto di Medicina Basata sulle Evidenze (EBM, Evidence Based Medicine), ritengono che questi sistemi possano supportare il lavoro diagnostico grazie a:

- l’uso razionale delle informazioni

- l’interpretazione automatizzata dei dati diagnostici

- l’uso intensivo delle statistiche, delle frequenze storiche e delle previsioni probabilistiche

Tuttavia, i sistemi di Intelligenza Artificiale cadono spesso in errori (allucinazioni), come è accaduto a ChatGPT quando ha suggerito che si possono ottimamente sostituire i bisturi con i grissini. [17]

Il problema morale sotteso all’uso di queste tecnologie in diagnostica è correlato a:

- la possibilità di errore sistematico nella progettazione degli algoritmi di apprendimento e di analisi

- la prevalenza della statistica sull’esperienza, che può influenzare il medico sulle occorrenze più probabili e ad ignorare le possibilità meno frequenti, replicando gli effetti degli errori cognitivi

- l’effetto black box, ossia l’accettazione acritica di ciò che suggerisce il sistema.

———–

PROBLEMA DELLA RESPONSABILITÀ

Il problema morale solleva quello della responsabilità, che vede coinvolta una serie di figure professionali quali, p.e.: il progettista, l’ingegnere della conoscenza che controlla l’apprendimento, il programmatore che “scrive” i meccanismi di autoapprendimento, il produttore, l’acquirente – p.e.: il dipartimento acquisti della struttura sanitaria, l’utilizzatore tecnico e l’utilizzatore finale che prende la decisione diagnostica e alimenta il meccanismo di autoapprendimento.

Ad esempio: in caso di danni ad un paziente derivanti da malfunzionamento o da una distorsione del sistema, a chi va attribuita la responsabilità? A chi l’ha realizzato oppure a chi l’ha istruito? Al produttore che lo vende sulla base di una promessa di valore che volutamente tralascia le negatività? All’acquirente abbagliato dai risparmi? Oppure all’utilizzatore finale che prende per buono acriticamente il responso della “macchina”?

La responsabilità morale – a mio avviso – ricade su tutti i soggetti che hanno trascurato, con motivazioni differenti, i rischi di errore e di lateralità del sistema.

In assenza di una norma che regoli tutte le fasi del processo, è evidente che anche la responsabilità giuridica è difficile da attribuire.

Forse è più facile agire affinché questi errori accadano con minore frequenza, grazie alla consapevolezza sui rischi legati all’utilizzo delle tecnologie e a un grado superiore di responsabilizzazione preventiva di tutti i soggetti.

———–

CI SONO DELLE CONCLUSIONI?

Posto che quello della IA può essere un cambiamento epocale con enormi caratteri positivi, vorrei delineare delle possibili raccomandazioni generali di ordine morale:

- non ci si può sottrarre ad una analisi approfondita dei criteri morali che informano i comportamenti delle macchine;

- va tenuto presente che i modelli di apprendimento sono altrettanto sensibili al problema morale; come vengono addestrate le macchine, quali euristiche adottano, quali modelli di percezione [18] vengono usati, sono fattori determinanti per il comportamento delle tecnologie e per l’orientamento delle decisioni umane;

- non è il caso di sostituire l’analisi e l’esperienza con i modelli statistici: in diagnostica, p.e., l’IA può egregiamente svolgere funzioni di supporto ma è preferibile che “non prenda decisioni”

- ci si deve guardare dall’effetto black box, soprattutto se nei sistemi sono incluse funzionalità di apprendimento;

- non vanno mai dimenticate le lateralità sociali

Ma questo vale per tutte le nuove tecnologie.

NOTE

[1] Il testo originale (vedi nota successiva) recitava “alla conservazione della vita”

[2] E. Scribano, Macchine con la mente, Carocci Editore, 2015

[3] https://www.oracle.com/it/artificial-intelligence/what-is-ai/

[4] Il Carrobbio, da quadrivium, è un largo di Milano le cui origini risalgono all’epoca romana. È posto indicativamente alla confluenza fra via Torino, corso di Porta Ticinese, via San Vito, via Cesare Correnti e via del Torchio. Nei dintorni circolano ancora numerosi gatti randagi.

[5] Politecnico di Milano, Osservatori.net – Osservatorio Artificial Intelligence 2023

[6] AI index report 2022, Stanford University

[7] : Politecnico di Milano, Osservatori.net – Osservatorio Artificial Intelligence 2023

[8] Ibidem

[9] Ibidem

[10] Ibidem

[11] Parlamento Europeo – https://www.europarl.europa.eu/news/it/headlines/society/

20200918STO87404/quali-sono-i-rischi-e-i-vantaggi-dell-intelligenza-artificiale

[12] Ibidem

[13] Ibidem

[14] Ibidem

[15] KBV RESEARCH – https://www.kbvresearch.com/artificial-intellgence-diagnostic-market

[16] Morti in ospedale all’anno per errori diagnostici, in Italia: più di 10.000 (M. Motterlini, V. Crupi, Decisioni Mediche, Raffello Cortina Editore, 2005); in Usa: tra 44.000 e 100.000 (Politecnico di Milano, 2002; United States Institute of Medicine, 1999)

[17] Corriere della Sera, 24.01.2023

[18] A breve sarà a disposizione sul blog un articolo di un filosofo orientale che focalizza l’attenzione sulla dimensione epistemologica dell’IA

Autore

-

Laureato in Scienze Filosofiche all’Università degli Studi di Milano e manager. Scrive appunti sul rapporto tra scienze, tecnologie e morale anche quando pedala come un pazzo, la domenica mattina. A volte dice di lavorare.

Molto interessante la questione morale e – a fronte della attuale situazione in ambito medico che vede sempre più frequenti gli scontri e le tensioni tra medico e paziente – trovo altresì irrinunciabile approfondire e normare la questione giuridica relativa al tema della responsabilità.

E ancora, non si deve abbassare l’attenzione sui fenomeni statisticamente irrilevanti. È importante non cadere nell’automatismo della statistica utilizzando algoritmi, in considerazione di quelle che sono le malattie rare, spesso esposte appunto a pletora di esami o tardivamente riconosciute.