Un nuovo francescano? - Paolo Benanti e la commissione algoritmi

Il professore Paolo Benanti è stato nominato Presidente della Commissione sull’Intelligenza Artificiale per l’Informazione e l’Editoria della Presidenza del Consiglio.

La Commissione è un organo del Dipartimento per l’Informazione e l’Editoria istituito dalla Presidenza del Consiglio poco più di due mesi fa, con lo scopo di analizzare le implicazioni dell’Intelligenza Artificiale nel campo dell’editoria e dell’informazione e, di conseguenza, consigliare il Dipartimento che ne è responsabile. La commissione è stata presieduta - dalla fondazione sino alle sue dimissioni - dal professor Giuliano Amato, politico, giurista, docente universitario e manager pubblico.

La nomina di Giuliano Amato aveva sorpreso molti; l’assegnazione della presidenza a Paolo Benanti forse anche di più.

Paolo Benanti ha un curriculum eccellente e si può dire - senza timore di smentita - che è uno dei massimi esperti mondiali di Intelligenza Artificiale; è un frate Francescano del Terzo Ordine Regolare, teologo, eticista, docente presso la Pontificia Università Gregoriana, consigliere di Papa Francesco per l’Intelligenza Artificiale, membro della Pontificia Accademia per la Vita con mandato sulla Intelligenza Artificiale, membro del New Artificial Intelligence Advisory Board dell' ONU, autore di libri sul ruolo dell'umano nella civiltà tecno-umana.

Ovunque si parli del profilo etico delle tecnologie e del ruolo della Intelligenza Artificiale nella vita dell'uomo, la presenza di Benanti è pertinente. È, tra l'altro, colui che ha coniato il termine Algoretica, cioè l'etica degli algoritmi. Da anni infatti si interroga e fa riflettere su come la tecnologia sia passata dallo status di strumento in mano all'uomo a quello di parte integrante dell'ecosistema sociale, e sempre più influente su questo ecosistema.

È sicuramente apprezzabile che Benanti abbia accettato di esporsi nel ruolo di Presidente della commissione: qualsiasi linea guida ne uscirà sarà certamente pertinente e di alto profilo. Paolo Benanti ama poi scherzare sul ruolo degli eticisti, come lui: gli eticisti fanno le domande e si tengono alla larga dalle risposte. Nel campo dell'etica le giuste domande sono infatti la cosa più importante, quelle che dovrebbero influenzare politici e stakeholders affinché affrontino i temi davvero rilevanti.

La domanda centrale posta dal lavoro di Paolo Benanti si può riassumere in questa: le macchine devono avere un'etica? Quale? Quali limiti ci sono e devono esserci nel rapporto tra la nuova specie delle macchine intelligenti e l'essere umano?

Gli eticisti non scendono in campo per dire cosa non si può fare o, peggio, pontificare su giusto e sbagliato, dice Benanti; il loro ruolo fondamentale su temi delicati e pervasivi della vita collettiva - com'è e come sarà sempre più l’Intelligenza Artificiale - deve essere appunto quello di porre le giuste domande, per far sì che le persone e le istituzioni ricerchino le risposte più adatte al contesto in cui operano. In questo il professor Paolo Benanti non potrà che essere eccellente: le persone, l'essere umano - in particolare nel loro rapporto con la tecnologia - sono sempre state al centro della sua attenzione.

Una volta tanto possiamo dire che in Italia abbiamo messo la persona giusta al posto giusto.

Incontri indeterminati - Considerazioni su “La Chimera” di Rohrwacher

Taglia e cuci. Montaggio di spazi discreti e durate disparate, seguendo il filo rosso della fiction, così il cinema prova a restituirci la vera esperienza del mondo. In questo senso, “La Chimera”, di Alice Rohrwacher, propone una serie di immagini capaci di tratteggiare alcuni complessi caratteri della nostra società e del tempo in cui viviamo, rendendoci il senso della storia.

In un periodo volutamente imprecisato, sospeso fra gli anni Ottanta e un eterno presente attraversato da presagi del futuro, e senza dare un’eccessiva importanza al luogo della vicenda (l’immaginaria Riparbella, nella Tuscia), il film racconta delle peripezie di una banda di tombaroli, la quale ha un discreto successo nelle escavazioni delle tombe etrusche, riuscendo a trovare numerosi cimeli grazie al contributo del protagonista (Arthur, una specie di rabdomante), che riesce a percepire l’ubicazione dei tumuli e delle caverne interrati tramite le sue chimere, suscitate dal desiderio di ricongiungersi con il suo amore scomparso (Beniamina), che gli appare in sogno in maniera sfuggente, perdendo dietro di sé il filo dall’orlo scucito del vestito.

Ma quella del tombarolo è una professione del tutto particolare, forse il tipo di vita precario per antonomasia, sospeso fra la libertà e la soggezione assolute date dal non avere vincoli. Così, le vicende dei personaggi, si articolano grazie a espedienti, alternando la gioia della festa estemporanea alla miseria del vivere di stenti e di improvvisazione quotidiana, con un fare che ricorda molto i gitani di Kusturica. Arthur, vive in una baracca adagiata sul crinale di una collina dominata da imponenti mura medioevali, ed ha solo gli abiti che indossa, ma non sembra curarsene; il suo comportamento è un misto di angoscia e cieca determinazione, preso dalla volontà di riprendere continuamente la sua ricerca. La scoperta colma di trepidazione di sarcofagi nascosti, e il ritrovamento di oggetti del passato, veri e densi di significato perché «visti da molti occhi», gli forniscono un senso di pienezza, sostenuta dall’approcciarsi a un’ideale soggettività corale in armonia con la natura delle società arcaiche, e dando libero sfogo all’affettività delle utopie; salvo poi recuperare i caratteri della morte non appena i colleghi irrompono al seguito per fare man bassa del bottino, così che, suo malgrado, i doni dati in corredo ai defunti si trasformano in merce preziosa da rivendere ai collezionisti.

-----

Una possibile chiave di lettura del film è quindi quella delle possibilità di vita nelle rovine del capitalismo, come descritte dall’antropologa statunitense Anna L. Tsing nel volume The Mushroom at the End of the World (2015), dove illustra la sua etnografia della filiera del matsutake, il fungo più pregiato del mondo, che cresce spontaneamente in aree boschive rinfoltite al seguito di processi si de-forestazione e sfruttamento intensivo del suolo. I raccoglitori, i mediatori, i rivenditori e gli importatori descritti dalla ricerca, ovvero stranieri e derelitti a cui non è permesso assimilarsi con la società, sono così delle figure istituite dalla catena del valore internazionale del fungo, che si sviluppa incidentalmente nelle fratture di modelli sociali consolidati, creata tramite salti e traduzioni, e che richiede perciò delle traiettorie di vita al margine, stimolate dalla ricerca di un contesto di libertà imprecisata e multisfaccettata. Così si genera l’accumulazione di recupero che, lungi dal rappresentare gli scarti, o le disfunzioni, di un sistema globale ordinato e in espansione inesorabile, avviene negli interstizi degli spazi politici e culturali formatisi storicamente e intrecciati in un assemblaggio che fornisce direzioni impreviste agli eventi, insieme a nuovi territori per l’agire sociale.

Questa performance drammatica, in una mescolanza che include una supposta competizione di mercato, non permette riscatto se non al termine della filiera e solo per pochi: il gioco quindi è truccato, funziona a forza di errori, falsità e distorsioni. Non c’è determinismo, non c’è sistematicità, il progresso è una chimera. Ma come sottolinea l’autrice, «gli umani contano in questi paesaggi. E gli umani portano le storie con loro nell’affrontare le sfide dell’incontro. Queste storie, sia umane che non-umane, non sono mai programmi robotici, ma piuttosto delle condensazioni nell’indeterminato qui e ora; il passato che cogliamo, come dice il filosofo Walter Benjamin, è una memoria ‘che brilla nel momento del pericolo’. Noi generiamo la storia, scrive Benjamin, come ‘il salto di una tigre in ciò che è stato’».

La storia così non può essere una successione di fatti. La storia si fa proprio con i “se” e con i “ma”, propri degli esperimenti mentali: la civiltà occidentale sarebbe fiorita se il libero mondo ellenico avesse perso la battaglia di Maratona con la teocrazia persiana? La cultura patriarcale esisterebbe se i Romani non avessero conquistato gli Etruschi? Le nostre valutazioni muovono sempre da insostituibili valori culturali. Conoscere è valutare, è scegliere. «Già il primo passo verso il giudizio storico è quindi – questo dev’essere qui sottolineato – un processo di astrazione, il quale si svolge attraverso l’analisi e l’isolamento concettuale degli elementi del dato empirico – che viene appunto considerato come un complesso di relazioni causali possibili – e deve sfociare in una sintesi della connessione causale ‘reale’. Già questo primo passo trasforma pertanto la ‘realtà’ data, allo scopo di farne un ‘fatto’ storico, in una formazione concettuale: nel ‘fatto’ è appunto implicita, per dirla con Goethe, la ‘teoria’» (Weber, 1922: Il metodo delle scienze storico-sociali).

-------

L’autenticità è una messa in scena, parziale, situata, biased. Come ricorda l’etimologia di “empirico”, bisogna avere “fede” nell’esperienza, l’una si capovolge nell’altra. «A opporsi alla finzione non è il reale, non è la verità, che è sempre quella dei padroni o dei colonizzatori, ma è la funzione fabulatoria dei poveri, in quanto dà al falso la potenza che ne fa una memoria, una leggenda, un mostro».

Affabulare vuol dire impegnarsi nell’invenzione di un popolo, «allora il cinema può chiamarsi cinema-verità, tanto più che avrà distrutto ogni modello del vero per diventare creatore, produttore di verità: non sarà un cinema della verità, ma la verità del cinema»

(Deleuze, 1985: L’immagine-tempo. Cinema 2).

Soggetti o oggetti? - Come e perché pensare un diritto per alcuni robot

Avevano fatto sorridere le uscite di Giuliano Amato, nella veste di presidente della Commissione Algoritmi, sui molti modi possibili per cucinare le patate suggeriti da una generica intelligenza artificiale.1 Un’uscita considerata ridicola da molti, non adatta alla serietà della questione (tutta imperniata sulla tutela dei contenuti e del copyright dalle grinfie delle cosiddette intelligenze artificiali generative).

Ecco allora che dal 5 di gennaio il teologo Paolo Benanti subentra alla posizione di Amato. Un pensiero affascinante quello della sua «algoretica», che meriterebbe un approfondimento tutto suo. Tuttavia, questo cambiamento al timone di comando credo sia una spia interessante per porsi una domanda iniziale. Con questo cambio assistiamo infatti ad un riorientamento verso altre specializzazioni accademiche dalle quali si va cercando consiglio: siamo passati dal diritto alla filosofia morale, alla bioetica: che il diritto abbia già esaurito tutto ciò che di utile poteva dirci a riguardo?

È bene notare come sia una tendenza diffusa quella di applicare i criteri della casuistica2 ai nuovi scenari creati dalle interazioni umane con agenti più o meno autonomi, ma sicuramente non organici. Questi criteri si rivelano certamente strumenti utili per indagare la rettitudine morale o, nel peggiore dei casi, il minore dei mali, da perseguire nel sempre più ampio ventaglio di scenari possibili. Io credo però che le maglie della legge, di una legge che sorge dalle garanzie costituzionali, possa offrirci ulteriori e più interessanti metodi di analisi. E forse anche qualche garanzia in più.

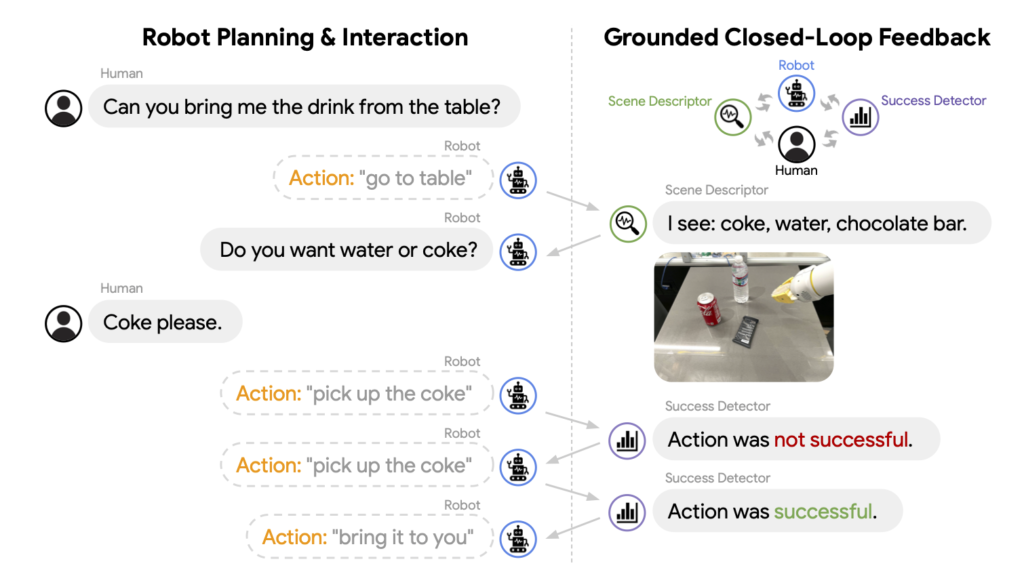

Definiamo però subito bene il nostro perimetro di riferimento: quali sono questi robot? Robot sociali sicuramente, di quelli pensati per entrare costantemente in contatto con noi per intenderci, e dotati di un monologo interiore. Cos’è però il monologo interiore, per un robot? Semplicemente lo stesso che è per te che stai leggendo: un modo per aggiornarne costantemente il proprio modello del mondo cercando sempre di approssimare al meglio gli ipotetici scenari futuri.

Noi ne abbiamo solitamente esperienza come quella vocina nella nostra testa, o quel «buzzing that went on inside my head» di cui parlava Alan Turing. A livello funzionale però non ci occorre teorizzare alcun homunculus, solo un flusso di linguaggio interno.3

Perché il monologo interiore è importante per il nostro discorso sociale? Perché ci offre la possibilità di soddisfare uno dei criteri più spesso rincorsi nei dibattiti sull’intelligenza artificiale: la trasparenza.

È il caso anche delle recenti (dicembre 2023) proposte contenute nell’EU AI Act, dove si legge come alcuni dei requisiti per un utilizzo corretto dei «sistemi di IA identificati come ad alto rischio», siano «la registrazione dell'attività per garantire la tracciabilità dei risultati; la documentazione dettagliata che fornisca tutte le informazioni necessarie sul sistema e sul suo scopo per le autorità di valutarne la conformità; l’accessibilità e la trasparenza di informazioni chiare e adeguate all’utente».

Attenzione: le scatole nere rimangono tali, tuttavia guadagnano, grazie alla registrazione del loro monologo interiore, un alto grado di trasparenza sulle loro azioni. Bene, per robot che agiscono così credo si possa ragionevolmente parlare di soggetti (o oggetti, poi ci arriviamo) autonomi.

Ora, se un (s)oggetto è autonomo, cioè è in grado di compiere azioni senza essere comandato a distanza da altri soggetti, allora ci occorre incasellarlo all’interno di una qualche finzione giuridica, in modo tale che se dovesse arrecare qualche danno, sapremmo quali norme seguire. Ecco, credo che questo sfondo di prudenza sia quello sul quale ragionare di diritti robotici: non occorre mischiare concetti come quello di agente e paziente morale, ci basta soffermarci sul riconoscimento dell’esistenza (sempre più prossima)4 di entità immerse nel nostro stesso ambiente che agiscono in maniera per noi più o meno comprensibile.

Sembra dunque che stia proponendo qualcosa di non molto diverso dalla «personalità elettronica» discussa per la prima volta in una bozza europea nell’ormai lontano 2017. Occorre però fare delle debite precisazioni per non rischiare di cacciarsi nel ginepraio legistico e propongo allora qui di seguire le cristalline ricostruzioni di Luigi Ferrajoli.5

Innanzitutto, di quale diritto stiamo parlando? I diritti soggettivi, quelli cioè spettanti ad ogni soggetto (fisico e poi dunque giuridico), devono essere concettualmente distinti (1) in diritti fondamentali e diritti patrimoniali.

È bene subito ricordare come i diritti fondamentali, indisponibili per loro natura, siano «limiti imposti alla democrazia politica e al mercato a garanzia della loro stessa conservazione» mentre i diritti patrimoniali, siano diritti di forma singolare: escludono cioè tutti gli altri soggetti.

È poi per noi necessario distinguere, (2) all’interno dei diritti fondamentali, quelli di libertà e quelli di autonomia privata. La logica di questa seconda biforcazione è chiara, ed è la medesima alla base della distinzione tra i diritti fondamentali e quelli patrimoniali: sia i diritti patrimoniali, evidenziati in (1), sia i diritti fondamentali di autonomia privata, evidenziati in (2), sono da considerarsi in quanto potestatis agendi, ovvero diritti potestativi.

Al contrario, i diritti fondamentali di libertà non possono che essere mere immunità, o facultates agendi e dunque si differenziano dai diritti fondamentali di autonomia i quali «formano il principale veicolo della differenziazione dei diritti singolari di proprietà e perciò del moltiplicarsi di disuguaglianze giuridiche e materiali nei diritti patrimoniali».

Tenendo ben chiara questa suddivisione ciò che si vuole qui iniziare a discutere sarà allora un diritto fondamentale di libertà per questi, e ora possiamo dirlo, soggetti robotici. Nessun diritto di giocare in borsa (un diritto di autonomia privata), né di potersi comprare qualche capo di fast-fashion (un diritto patrimoniale), piuttosto la garanzia di una difesa della loro integrità da interferenza arbitrarie.

Si chiederà: perché? che bisogno c’è di questo diritto di libertà?

Ecco due considerazioni:

(a) non sappiamo cosa succeda all’interno di queste macchine, e non possiamo, io credo, dirimere così facilmente la famosa domanda del «cosa si prova ad essere quel sistema».

Ne segue poi che il metro con il quale dovremmo valutare una macchina, se non vogliamo solamente una versione più efficace di un oggetto che già possediamo ma cerchiamo invece un nuovo soggetto con cui dialogare e con il quale costruire qualcosa di nuovo insieme, sia necessariamente quello di un fair-play.

Questo credo sia l’insegnamento, e l’atteggiamento, più importante che Alan Turing ci ha per primo lasciato: «a fair play [that] must be given to the machine. Instead of it sometimes giving no answer we could arrange that it gives occasional wrong answers. But the human mathematician would likewise make blunders when trying out new techniques. It is easy for us to regard these blunders as not counting and give him another chance, but the machine would probably be allowed no mercy. In other words then, if a machine is expected to be infallible, it cannot also be intelligent . . . No man adds very much to the body of knowledge, why should we expect more of a machine?».6

Ciò di cui qui si discute sono dunque macchine incorporate nel mondo che per poter agire in questo mondo hanno bisogno di poter sbagliare, perlomeno quando lo sbaglio non arreca danni irreparabili ma – ad esempio - solo una contenuta flessione nel profitto.

(b) la commodificazione di un possibile nuovo soggetto può risultare l’ulteriore veicolo di lacune già presenti all’interno di una costruzione giuridica che ha inventato finzioni ben più de-responsabilizzanti e pericolose (basti pensare alle holding finanziarie dotate di personalità giuridica). Di fatto poi tali lacune sono spesso alla basse dell’emergenza di quelli che Ferrajoli giustamente definisce crimini di sistema. Dopotutto non è tramite la riduzione dei soggetti che possono mettere in gioco un reciproco controllo dei rispettivi poteri che si garantisce la continuità delle nostre prerogative costituzionali, piuttosto è con un ampliamento di tali figure che si può garantire alla democrazia politica e al mercato laloro stessa conservazione.

Cosa ci guadagniamo da questa proposta? cosa invece ne perdiamo?

Occorre discuterne. Certo è che il primo passo è riconoscere la possibile rilevanza della questione.

NOTE

1 Il virgolettato in realtà recitava: «A me piacciono molto le patate. Grazie all’intelligenza artificiale, un giornalista in pochi istanti potrà sapere tutti i modi in cui posso cucinarle, così da arricchire il suo pezzo».

2 Parte della teologia morale, che applica i principi della morale teorica a casi concreti, anche solo ipotetici («casi di coscienza»), secondo varie circostanze, per trovare la regola valida per ciascuno, metodi ancora attuali in molta etica e bioetica contemporanea.

3 Un modello chiaro per i nostri robot è quello dell’«Inner Monologue», sul quale si può approfondire qui: https://innermonologue.github.io

4 È chiaro che il discorso normativo che sto qui presentando cerca di anticipare il futuro alla luce delle tendenze più attuali e che paiono più promettenti. Altre architetture, non basate sulla commistione tra un modello LLM (come il famigerato ChatGPT per intenderci) e un robot potrebbero prendere il sopravvento, resta il fatto che l’obiettivo perseguito rimarrà quello di un’efficace autonomia di questi (s)oggetti, e dunque il punto giuridico del discorso non varia di molto, varierebbero sì i soggetti. Un esempio dell’interazione uomo-macchina con questo modello si può vedere qui: https://www.youtube.com/watch?v=djzOBZUFzTw&t=334s

5 Il riferimento è il tomo estremamente denso e tuttavia cristallino La costituzione della democrazia (2021). Le parti più rilevanti per il nostro discorso sono, per chi fosse interessato ad approfondire, la III e la IV.

6 La citazione viene dalla trascrizione della Conferenza tenuta alla London Mathematical Society il 20 Febbraio 1947. Una traduzione si trova nel volume curato da Gabriele Lolli sull’«intelligenza meccanica» e recita così: «sostengo che la macchina deve esser trattata in modo equo e leale. Invece di avere una situazione in cui la macchina a volte non dà risposte, potremmo aggiustare le cose in modo che essa dia ogni tanto risposte sbagliate. Anche il matematico umano prende qualche cantonata quando sperimenta nuove tecniche. È facile per noi considerare queste sviste come non rilevanti e dare a lricercatore un’altra possibilità, ma alla macchina non viene riservata alcuna pietà. In altre parole, se si aspetta che la macchina sia infallibile, allora essa non può anche essere intelligente… Nessun uomo aggiunge granché al corpo generale delle conoscenze umane: perché dovremmo aspettarci di più da una macchina?»

AI Act – La prima legislazione europea sull’Intelligenza Artificiale

Anno 45 a.C.: Giulio Cesare legifera sulla circolazione dei carri nei centri abitati – dall’alba alla metà del pomeriggio[1]. L’obiettivo è di snellire il traffico urbano, ridurre la sporcizia (sterco dei cavalli), l’odore e il rumore nelle strade durante il giorno (non è cambiato nulla, mi pare).

Anno 1865: in Gran Bretagna viene promulgato il Red Flag Act[2] che impone alle autovetture (self-propelled vehicles, la tassonomia è importante: distingue dalle vetture a cavalli) di avere un equipaggio di almeno 3 persone, di non superare la velocità massima di 4 miglia orarie sulle strade fuori città e di 2 miglia orarie in città, di essere precedute a 60 yarde da un uomo a piedi con una bandiera rossa che ne segnali l’arrivo, regoli il passaggio di carrozze e cavalli e, infine, faccia fermare il veicolo a motore in caso di necessità.

È una normativa stringente, finalizzata – oltre che a proteggere il lavoro dei vetturini pubblici – a garantire la sicurezza delle persone contro la minaccia del trasporto privato "self-propelled".

Anno 1903: entra in vigore il primo codice della strada organico a New York, a fronte della velocità che possono raggiungere senza sforzo, “effortless”, gli autoveicoli lungo le strade cittadine.

Anno 1929: con poco meno di 250.000 circolanti su tutto il territorio nazionale – nasce il Codice della Strada italiano, che vedrà alcune riedizioni e ammodernamenti, nel 1992 e quest’anno.

Queste normative hanno tutte come principale finalità il contenimento dei rischi per guidatori, passeggeri, passanti e cose a fronte del pericolo generato da una tecnologia: i mezzi di trasporto su strada.

E hanno influenzato lo sviluppo della tecnologia “automobile”, così come la tecnologia “automobile" ha orientato il nostro modo di vedere la realtà e le nostre dinamiche sociali, produttive, economiche - come rilevava Bruno Latour con la sua teoria dei Quasi Oggetti [3]

9 dicembre 2023, due giorni fa: l’Unione Europea – primo organo istituzionale al mondo a farlo – ha approvato l’AI ACT, piattaforma normativa sull’utilizzo delle tecnologie di intelligenza artificiale. [4]

“Un quadro giuridico unico per lo sviluppo dell'intelligenza artificiale di cui ci si può fidare. E per la sicurezza e i diritti fondamentali delle persone e delle imprese.”, dichiara Ursula Va Der Leyen [4].

L’obiettivo di questa legge è “garantire che l'IA protegga i diritti fondamentali, la democrazia, lo Stato di diritto e la sostenibilità ambientale”, permettendo uno sviluppo efficace ma “sicuro” delle innovazioni.

Tra le norme “in negativo” si evidenziano:

“i sistemi di categorizzazione biometrica che utilizzano caratteristiche sensibili, come le convinzioni politiche, religiose e la razza; la raccolta non mirata di immagini del volto da Internet o da filmati di telecamere a circuito chiuso per creare database di riconoscimento facciale; il riconoscimento delle emozioni sul posto di lavoro e nelle scuole; il social scoring; le tecniche manipolative; l'IA usata per sfruttare le vulnerabilità delle persone.” [4]

In positivo, invece, vigerà l’obbligo alla “valutazione dell'impatto sui diritti fondamentali.” [4] Delle applicazioni di IA.

Il punto critico che ha reso complessa la negoziazione è l’utilizzo delle tecnologie di IA da parte delle forze dell’ordine, soprattutto per il riconoscimento biometrico e in tempo reale e la polizia predittiva.

“Alla fine i negoziatori hanno concordato una serie di salvaguardie e ristrette eccezioni per l'uso di sistemi di identificazione biometrica (RBI) in spazi accessibili al pubblico ai fini di applicazione della legge, previa autorizzazione giudiziaria e per elenchi di reati rigorosamente definiti” [4]

Al di là delle specifiche indicazioni normative, va notato che:

- Le istituzioni comunitarie europee hanno adottato un punto di vista molto concreto sull’IA, in cui prevale il suo carattere di tecnologia, con usi ed effetti privati e pubblici

- In quanto tecnologia, come accadde per gli autoveicoli dal 1865 in poi, ne ha considerato i rischi per i soggetti che rappresenta: popolazione e tessuto produttivo, e ha – conseguentemente - imposto delle misure di controllo e di contenimento di questi rischi.

- Nell’ambito dei rischi da contenere, sono stati privilegiati quelli che riguardano la discriminazione, l’invasione del territorio emotivo personale, la manipolazione dei comportamenti e i danni fisici e psicologici agli individui.

- Inoltre, è stata posta una particolare attenzione sulle tecnologie IA definite “ad alto impatto”[5], che includono i sistemi di IA generale-generativa, come Chat GPT 3.5, per i quali è obbligatoria “l’applicazione ex ante delle regole su sicurezza informatica, trasparenza dei processi di addestramento e condivisione della documentazione tecnica prima di arrivare sul mercato”. [4]

In poche parole, i produttori dovranno rendere pubblico come viene addestrato il sistema e su quali basi!

L’IA, con questa normativa, viene assimilata a molte altre tecnologie, anche dal punto di vista del legislatore, perde una parte dell'aura di mito contemporaneo,

viene collocata nella sua “rete di relazioni, che si estende ben oltre la sua forma”[7]

e – dopo la glorificazione dei potenziali vantaggi già avvenuta in molte sedi istituzionali [6] -

i rischi che genera vengono affrontati in modo concreto

come accade, almeno dal 45 a.C., per tutte le nuove tecnologie.

NOTE

[1] Lex Iulia Municipalis, https://www.archeologiaviva.it/4055/rumore-e-traffico-in-citta-un-problema-di-sempre/#:~:text=Gi%C3%A0%20nel%2045%20a.C.%20Giulio,circa%20le%20cinque%20del%20pomeriggio).

[2] https://vlex.co.uk/vid/locomotives-act-1865-808255757

[3] Bruno Latour, Non siamo mai stati moderni, Eleuthera, 2018

[4] https://www.rainews.it/articoli/2023/12/intesa-ue-per-la-legge-su-intelligenza-artificiale-breton-momento-storico-97d8b5ca-141f-4284-a6fb-434b9871ee01.html

[5] Categorizzate per potenza di elaborazione almeno pari a 10^25 FLOPs (floating point operations per second, un criterio tutto sommato più adeguato di quello proposto precedentemente sul fatturato dell’impresa.

[6] Si veda il mio post del 24 ottobre 2023, Etica, morale e intelligenza artificiale, https://www.controversie.blog/etica-intelligenza-artificiale-un-approccio-analitico-e-normativo/

[7] Bruno Latour, Non siamo mai stati moderni, Eleuthera, 2018

La svalutazione delle competenze - Le responsabilità di scienziati e giornalisti

Da molto tempo si parla di “crisi delle competenze” (expertise).

Con questa espressione si intende la tendenza a non dare sufficiente credito e importanza al parere degli esperti, dei tecnici, degli scienziati, dei possessori di conoscenze specifiche. In sostanza, delle persone competenti.

Vi è, quindi, in atto una sorta di delegittimazione dell’autorità intellettuale. L’avevano già evidenziato Collins ed Evans con Rethinking Expertise (2007), Nichols (2017) con The Death of Expertise, Eyal con The Crisis of Expertise (2019).

Responsabili di tutto ciò sono spesso additati, di volta in volta, internet (famosa è l’espressione “doctor Google”, per cui le persone si fanno auto-diagnosi e si curano cercando in rete i rimedi), i social media (dove troviamo gruppi che forniscono pareri su qualsiasi cosa e contestano le affermazioni di scienziati), il populismo che ritiene che gli esperti frenino la democrazia, i politici (come Trump, Bolsonaro ecc.)…

Ma siamo proprio sicuri che essi siano i veri responsabili? Non potrebbe essere che la crisi delle competenze sia (almeno in parte) causata proprio dai… competenti?

Questa ipotesi, apparentemente assurda, emerge da una nostra ricerca sulla fiducia negli scienziati.[1] Come altre ricerche hanno evidenziato[2], dopo l’epidemia di SARS-COV-2, abbiamo assistito a un declino della fiducia nei confronti degli scienziati.

Che era molto alta.

Per cui declino significa che è scesa, non che è sparita (come qualcuno potrebbe frettolosamente pensare).

I risultati della ricerca sollevano dubbi sulle recenti teorie che assegnano un forte ruolo ai social network e alle fake news nella sempre maggior diffusione del cosiddetto ‘antiscientismo’ (Moran, 2020). Sicuramente (e anche il nostro sondaggio lo rileva) le persone più critiche nei confronti della scienza e degli scienziati sono assidui frequentatori dei social network.

Tuttavia, le persone che li utilizzano come fonte primaria sono molto poche (3%).

Da qui, la nostra ipotesi che siano proprio i media tradizionali (TV in primis), nei quali è presente un diffuso scientismo rinforzato anche dalla richiesta di certezze (fatta agli scienziati) da parte dei conduttori televisivi, ad alimentare (indirettamente e inconsapevolmente) un crescente atteggiamento critico nei confronti della scienza, che può sconfinare anche in un sentimento antiscientifico. Questi atteggiamenti sono, in parte, la conseguenza di previsioni (statistiche e non) non avveratisi (Campo et al. 2021); del disorientamento e confusione nell’opinione pubblica a seguito dei conflitti televisivi fra scienziati; della disillusione nello scoprire che alcune promesse d’uscita dall’emergenza non sono state mantenute. Quelli elencati sono peraltro anche alcuni degli annosi nodi irrisolti della medicina (cfr. Lello, 2020; Hornsey, Lobera e Díaz-Catalán, 2020).

A ciò vanno aggiunte le dinamiche conflittuali che, sebbene connaturate al dibattito scientifico, sono state amplificate dai processi di spettacolarizzazione della scienza che hanno avuto luogo durante l’epidemia. Nonostante la visibilità pubblica di alcuni scienziati non sia un fenomeno nuovo, l’epidemia ha dato alla comunità scientifica un’esposizione mediale inedita. Gli stessi media, inoltre, hanno in gran parte “premiato” proprio gli scienziati maggiormente noti e visibili nel dibattito pubblico, nonché tendenti a comportarsi come “attori mediali” (quindi più “televisivi”), inclini all’assertività, alla polemica o alla dichiarazione a effetto (anche a scapito della chiarezza informativa); spesso al mero fine di aumentare l’audience. Inevitabilmente, ciò ha portato a esasperare ulteriormente il livello di conflittualità.

A tal fine, Nucci e Scaglioni (2022) hanno parlato di “iatrodemia”, cioè epidemia di medici in TV: «gettandosi nell’arena tra polemisti, nani e ballerine, hanno portato la medicina sul terreno delle opinioni. Il problema è che la scienza non è un’opinione. E che questa percezione cambia il nostro modo di considerare il rischio e la malattia» (p. 11).

Secondo gli autori, il risultato è la perdita di autorevolezza dei medici, a favore del rafforzamento del pensiero antiscientifico, proprio nel momento in cui la fiducia nella classe medica sarebbe cruciale. Infatti, essi sostengono che dalle prime fasi della pandemia abbiamo assistito, da un lato, alla depoliticizzazione delle decisioni sanitarie, presentate come scelte ‘tecniche’ dettate da ‘esperti’, dunque indiscutibili; dall’altro, alla politicizzazione dei medici, che alle prime opinioni divergenti sono diventati i principali alfieri di questa o quella battaglia. Così arriviamo a oggi, gli autori concludono, con medici onnipresenti in tv, che ormai danno anche chiari segni di appartenenza politica.

LO SCIENZIATO PASSE-PARTOUT

Ma c’è ancora un altro fenomeno, ancor più recente: lo scienziato prêt-à-porter o passe-partout.

Infatti, sempre più e soprattutto nelle scienze naturali, fisiche, matematiche e anche mediche, gli scienziati esprimono pubblicamente le loro opinioni a proposito di ambiti che esulano dalla loro specifica area di competenza.

E se un fisico (Giorgio Parisi, ad esempio), anziché un epidemiologo, si mette a parlare di previsioni sul virus; un virologo (Burioni) - e non un medico di famiglia o ospedaliero - parla di pazienti e terapie anti-Covid; una farmacologa (Cattaneo), un virologo (Burioni), un fisico (Parisi) o una immunologa (Viola), un biochimico e biologo molecolare convertito all’analisi di Big Data e Reti Sociali per lo sviluppo biofarmaceutico (Bucci) - e non un agronomo - parlano di agricoltura biodinamica; una biologa molecolare (Gallavotti) o un neurologo - e non uno psicologo o sociologo - di cosa passa per la mente di un no-vax, i loro interventi potrebbero (indirettamente e inconsapevolmente) veicolare il tacito messaggio che gli stessi scienziati non ritengono le competenze così fondamentali e che ognuno può cimentarsi in temi che sono altri rispetto al suo oggetto di studio.

Questo fenomeno si ripresenta ormai con modalità simili a ogni nuovo tema che conquisti l’agenda setting.

Un tempo erano i sociologi a essere accusati di parlare di tutto; ora il ruolo del tuttologo lo stanno, pian piano, assumendo i fisici e i matematici (Rovelli, Odifreddi) che si esprimono su tutto. Anche sulla guerra in Ucraina o in Israele.

Facendo il verso ai giornalisti, che sono ormai diventati i campioni di tuttologia: lo stesso giornalista ormai scrive di vaccini, guerra, antisemitismo, cambiamenti climatici, femminicidi, patriarcato ecc.

Non ci credete? Fate una prova: prendete il nome di una nota firma, e guardate di cosa ha scritto negli ultimi tre mesi. Scoprirete delle menti enciclopediche in formato tabloid. Per cui, forse, sono proprio loro ad ammazzare la competenza.

In conclusione, la crisi delle competenze e della legittimità dei saperi sembra essere non solo il prodotto di forze esterne alla scienza, ma anche degli scienziati mediali stessi (Gobo e Campo, 2021).

NOTE

[1] Gobo G., Serafini L., Campo E., e Caserini A. (2022), Covid-19 e fiducia negli scienziati. Uno studio pilota sui lettori di due giornali online, in Comunicazione Politica, 23(1), pp. 19-38.

[2] Di ricerche ce ne sono molte, con esisti opposti. Alcune dicono la fiducia è calata, altre che è cresciuta o è rimasta stabilmente alta. Sono ricerche non comparabili perché condotte con domande molto diverse. In altre parole, sono le domande dei questionari a costruire (almeno parzialmente) le opinioni degli intervistati. Osservazione banale, ma quasi sempre dimenticata.

RIFERIMENTI BIBLIOGRAFICI

Campo, E., Gobo, G., Galeotti, M. e Parra Saiani, P. (2021). Limiti e fallimenti dei modelli epidemiologici e previsionali nell’epidemia di SARS-COV-2, in A. Favretto, A. Maturo e S. Tomelleri (a cura di) L'impatto Sociale del Covid-19 (pp. 39-48). Milano: Franco Angeli.

Collins, H. and Evans, R. (2007) Rethinking Expertise, Chicago, University of Chicago Press.

Eyal, G. (2019) The Crisis of Expertise, Cambridge, Polity Press.

Gobo, G. e Campo E. (2021). Covid-19 in Italy: should sociology matter? The European Sociologist, 46 (12).

Gobo G., Serafini L., Campo E., e Caserini A. (2022), Covid-19 e fiducia negli scienziati. Uno studio pilota sui lettori di due giornali online, in Comunicazione Politica, 23(1), pp. 19-38.

Distopia tecnoscientifica e immaginazione - Il mondo nuovo di A. Huxley

Non sono un romanziere - soleva dire Huxley - ma un saggista che scrive fiabe.

Perché, allora, affidare alla forma del romanzo una previsione sul futuro?

Per quale ragione proprio la «superorganizzazione» dell’ardito mondo nuovo e dei suoi fantasmagorici prodotti tecnoscientifici, frutto della più fervida capacità immaginativa, sembrano annunciare l’estinzione di quest’ultima?

Perché, infine, il mondo d’Utopia gravita sopra di noi con fare minacciosamente distopico?

- Utopia, distopia e tecnica

«Il secolo delle macchine comincia a farsi sentire»[1]. Sono le parole dell’architetto Charles-èdouard Jeanneret-Gris, in arte Le Corbusier (1887-1965). Sempre lui, nel medesimo volume Urbanistica (1925), scriveva con il suo solito ottimismo quasi messianico che «crollava soltanto un mondo vecchio. Su dalle rovine stava arditamente spuntando un mondo nuovo»[2].

È questo lo spirito che anima certe frange avanguardistiche dei primi decenni del secolo scorso, come quando un giovane Antonio Sant’Elia (1888-1916) dichiarava che «come gli antichi trassero l’ispirazione dell’arte dagli elementi della natura, noi - materialmente e spiritualmente artificiali - dobbiamo trovare quell’ispirazione negli elementi del nuovissimo mondo meccanico»[3].

Ancora, è il medesimo mondo che anni più tardi il filosofo Gunther Anders (1902-1992) avrebbe dipinto con tinte fosche e apocalittiche nel

suo L’uomo è antiquato I (1956): «mondo della «matrice»[4] e del «dislivello prometeico»[5], asincronia della psiche umana rimasta irrimediabilmente indietro rispetto alla lineare, efficiente e funzionale perfezione dei «suoi» prodotti tecnoscientifici. Una psiche debole e imperfetta che arranca dietro alla perfezione macchinica, e che modella il suo «umiliante ideale»[6] sulla fredda perfezione che contraddistingue la macchina, «il suo sogno, va da sé, sarebbe quello di diventare uguale alla sua divinità: agli apparecchi, o meglio, di essere compartecipe - in certo modo consustanziale - della loro natura»[7].

-----------

Qualche decennio prima, sempre nella prima metà del secolo scorso, apparve per la prima volta nelle librerie Brave New World (1932) dell’autore inglese Aldous Huxley (1894-1963), racconto fiabesco di una società ideale in cui domina una superorganizzazione di natura tecnoscientifica secondo i tre canoni della «Comunità, Identità e Stabilità»[8]. Utopia o distopia?

Di distopie non si è sempre parlato.

La parola stessa, a essere generosi, non ha più di duecento anni. Ma quand’anche facessimo della distopia l’immagine in negativo dell’utopia, ci accorgeremmo, forse con imbarazzo, che neppure di quest’ultima abbiamo una definizione tanto chiara.

È Thomas More a costruire il neologismo e ad affidarlo al suo omonimo racconto del 1516[9].

A seconda dell’etimo l’utopia è un «non-luogo» (U-topia) o un «buon-luogo» (Eu-topia).

Tuttavia, il «non» dell’utopia nulla ha a che spartire con la recente caratterizzazione dell’antropologo Marc Augé (1935-2023)[10]: il «non» di un’utopia definisce il «luogo» come ciò che non è ma dovrebbe essere, «città ideale», come quella descritta dal frate domenicano Tommaso Campanella (1568-1639) ne La città del sole (1623).

----------

Huxley aveva a cuore queste distinzioni, tutt’altro che quisquilie o eruditismo da scaffale: egli scrisse una «distopia», Il mondo nuovo, e una «topia»[11], l’isola (1962), ma non si intrattenne mai con l’utopia.

Perché ciò è determinante?

Il «non» dell’utopia, si è detto, non ha alcunché di negativo: è come la storia della tensione amorosa in Platone, immagine a cui tendere.

Perciò, propriamente parlando, l’etimo è una fusione piuttosto che un’alternativa: «non luogo» che, correlativamente, è un «buon luogo».

Si potrà forse obbiettare che un tale racconto è, nonostante tutto, frutto di una mente o di un cervello, che «l’idealità» dell’utopia è frutto della «dannata immaginazione» che ci lega a terra.

Tuttavia, More e Campanella fanno dell’immaginazione un veicolo di purificazione, l’immagine «ideale» dev’essere intimamente legata a una simbologia teologica, garante di un’intima e sacra connessione con il cosmo, «cosmo in piccolo».

In Brave New World nulla di tutto ciò: non è l’immagine della città in armonia con il cosmo, ma piuttosto lo schema di un’ingegnosa macchinazione, di uno schema-mondo, «comunità che grazie all’identità realizza la stabilità»[12].

Non è soltanto l’inversione dell’utopia. Nella narrazione distopica c’è una riformazione della «funzione immaginativa».

Non si tratta più di un veicolo verso l’idealità, ma di un’estensione immaginativa della scienza stessa.

L’immaginazione estende il prodotto tecnoscientifico nelle sue possibilità d’insieme, all’estremo.

Anders da ciò impara il fondamentale principio metodologico dell’«esagerazione», per cui il «dislivello» dell’uomo rispetto ai suoi prodotti richiede, per essere capace di controbattere, una metodologia altrettanto esagerata; insomma «esistono fenomeni che non si possono trattare senza accentuarli e ingrandirli»[13].

L’esagerazione consiste allora nell’estrema immaginazione del prodotto tecnoscientifico: la nascente eugenetica diviene catena di montaggio per esseri umani a base di «ipnopedia» e «persuasione chimica», la nascente farmacologia diviene il soma, «la droga perfetta…euforica, narcotica, gradevolmente allucinante…tutti i vantaggi del Cristianesimo e dell’alcol; nessuno dei difetti»[14].

Ogni prodotto è sviluppato, attraverso l’immaginazione, nella sua singola possibilità utopica: droga senza effetti collaterali, eugenetica senza errori - o quasi -, vita senza tristezza, coraggioso mondo nuovo scevro dal peso del passato; anche la casa, «psichicamente squallida» e fonte degli «attriti della vita che vi si ammucchiavano»[15], è stata scongiurata.

Eppure, di distopia si tratta, e quest’ultima vive un gemellaggio singolare con lo sviluppo tecnoscientifico: che si possa «estendere il presente» è il vago principio comune che li anima.

- Immaginazione

Se l’immaginazione tecnoscientifica è indeterminata nel campo del futuro (ragion per cui si «cerca di immaginare cosa accadrà in questo o quel caso»), se l’indeterminatezza è, per così dire, il «campo base» dell’immaginazione, allora Huxley giunge a un esito volutamente paradossale: l’immaginazione approda al tempo futuro della sua estinzione, laddove nulla può essere indeterminato, là, nella «tirannia del benessere di Utopia»[16].

È il tratto più profondo del Mondo nuovo: se il silenzio è potenziale fonte d’indeterminazione[17], allora è necessario sostituirlo con la musica continua e sensuale dei «sessofonisti», con gli spettacoli ipnotici del «cinema odoroso»; se il processo ontogenetico fatto di genitori «vivipari» è fonte d’imprevedibilità, allora bisognerà sostituirlo con un processo di produzione umana che non lasci spazio al dubbio. Osserviamo un altro elemento, altrettanto profondo.

Se uno dei personaggi principali, tale Bernard Marx, è capace di guardare con una dose di sospetto il mondo in cui vive, ciò è dettato dal suo essere «errore» della catena di montaggio: «dicono che qualcuno si sia sbagliato quando era ancora nel flacone»[18].

Possiamo spingerci ancora più in là: nel mondo di Huxley è in atto una sistematica eliminazione del passato, nutrita dalle stesse ragioni di fondo. La «riserva dei selvaggi del New Mexico» dove esseri umani imperfetti e retrogradi «conservano le loro abitudini e i loro costumi ripugnanti»[19] è uno spazio esterno a Utopia.

La riserva sta al di là della città dell’efficienza, percepita da chi vive nel mondo nuovo con un misto di disgusto e timore.

La memoria storica è esternalizzata e rigettata, racchiusa nella riserva che dista diversi giorni di viaggio - non ci sono vecchi nella città ideale. Diversamente, i ricordi custoditi nella città dei civilizzati è pura «memoria operativa», «memoria che ripete senza immaginare», una «memoria priva di passato»[20]; la storia - ripetono i bambini «in training» - «è tutta una sciocchezza»[21].

La vuota memoria fa tutt’uno con l’esclusione dell’imprevedibilità, «la macchina gira e rigira, e deve continuare a girare, sempre. È la morte che si ferma»[22].

Nel mondo nuovo, prendendo in prestito le parole di un saggio apparso di recente, si può dire che «si è liberi di scegliere tutto quello che c’è in menù»[23].

Insomma, tra utopia e distopia avviene una sorta di ritorcimento temporale: il «non luogo» dell’utopia come immagine ideale e principio morale è scivolato nel «non luogo» della distopia come timore che, effettivamente, questa possa realizzarsi.

Perciò, in esergo, Huxley riporta un passo del filosofo Nikolaj Berdjaev (1874-1948), «le utopie appaiono oggi assai più realizzabili di quanto non si credesse un tempo. E noi ci troviamo attualmente davanti a una questione ben più angosciosa: come evitare la loro realizzazione definitiva?»[24]

Se l’utopia è una freccia rivolta verso un futuro ideale, la distopia tecnoscientifica è il tentativo di figurarsi ciò che potrebbe avverarsi già domani, incubo imminente, o come osservava Huxley nella prefazione del 1946, «oggi sembra quasi possibile che l’orrore possa ricadere su di noi nell’arco di un secolo»[25].

Insomma, l’espediente narrativo del genere utopico è sempre stato il «distacco onirico»: è necessario risvegliarsi nel mondo nuovo. Nuovamente, c’è una differenza profonda tra utopia e distopia: se nel primo caso il distacco permette, per così dire, di rendere i piedi leggeri e fare del mondo ideale qualcosa a cui elevarsi, nel secondo caso il sogno si fa angoscioso, rischia di filtrare nello stato diurno.

- Complottismo e immaginazione

Ecco alcuni fatti curiosi: se Huxley avesse scritto Brave New World nel secolo nuovo, nulla ci impedirebbe di supporre che, come altri, sarebbe finito nel circondario della categoria fittizia di «complottista».

C’è di più, poiché proprio coloro che finiscono per essere gettati, volenti o nolenti, all’interno di questa «categoria», si adoperano per una costante riappropriazione del racconto distopico tecnoscientifico come modo di reazione al presente - «siamo in 1984!»

Ma, se da una parte chi sente l’invivibilità del presente si rifugia nella razionalizzazione che un racconto può fornire, questa stessa azione di appoggio a un auctoritas alternativa rischia di adombrare la «chiamata originale» del racconto distopico, immaginare.

Giungiamo così a una stazione singolare: la militarizzazione della vuota parola «complottismo», ma potremmo inserirvi anche «negazionismo», punta dritto contro il carattere immaginativo che fa di queste forme narrative un’arma contrapposta frontalmente all’utilizzo politico della tecnoscienza a fini di controllo[26].

Anche la scienza - dice il governatore di Utopia in una tranquilla confessione - deve essere imbavagliata, «la scienza è pericolosa»[27] e ancora, «la nostra scienza è una specie di libro di cucina, con una teoria ortodossa dell’arte della cucina che nessuno ha il diritto di mettere in dubbio»[28].

La «narrazione ufficiale» così precipua in Brave New World - ma vale anche per racconti come 1984 di Orwell, che Huxley elogia profusamente[29] - non solo non sa che farsene dell’immaginazione, deve escluderla sistematicamente. E così, per principio, deve escludere i fuochi d’indeterminazione da cui quest’ultima possa germinare: il silenzio, lo spazio incolto, il discorso svicolato dalla legiferazione; è un «conformismo dinamico», laddove «la riduzione teoretica della molteplicità ingestibile a unità comprensibile si muta in pratica in riduzione della diversità umana a uniformità subumana, della libertà a schiavitù»[30].

Huxley aggiunge: «dobbiamo ritenere più possibile qualcosa che somigli al mondo nuovo e non qualcosa che somigli a 1984»[31]. Infatti, se nel secondo l’immaginazione rimane una possibilità latente di colui che soffre e vuole immaginare qualcosa di diverso - «quando l’individuo sente, la società è in pericolo»[32] -, nel primo la stabilità, alimentata dall’incessante soddisfazione di vuoti piaceri passeggeri, fa dell’immaginazione una scomodità.

-------

Era il 1958 quando Huxley, in conversazione con Mike Wallace, annunciava l’imminente avverarsi delle sue più fantasiose immaginazioni[33].

Sotto la spinta delle forze impersonali della superorganizzazione e della pressione demografica, prolungate a loro volta dal condizionamento «neopavloviano», chimico e subconscio, il mondo nuovo non sembrava più la fantasiosa fiaba di un futuro remoto.

Eppure, non possiamo fermarci a questo: fare di Brave new world la cartina tornasole del reale significa alzare bandiera bianca.

D’altra parte, ridurre le parole di Huxley a finzione significa misconoscerne l’originale chiamata al prolungamento immaginativo che con tanta insistenza, vediamo tutt’ora scoraggiato.

Qual è, quindi, il linguaggio della nostra superorganizzazione?

«Reale», solamente ciò che è stato approvato.

«Possibile e desiderabile», ciò che ne consegue con fredda deducibilità.

«Immaginazione» ciò che vi si adagia sopra come un pacchetto o una copertina,

l’involucro policromo del prodotto perennemente unico.

NOTE

[1] Le Corbusier, Urbanistica (1925), Il Saggiatore, Milano 2017, p. 92.

[2] Ivi, p. 236.

[3] A. Sant’Elia, Architettura futurista, Abscondita, Milano 2022, p. 25.

[4] Si veda G. Anders, L’uomo è antiquato I (1956), Bollati Boringhieri editore, Torino 2003, pp. 97-199.

[5] Ivi, pp. 31-94.

[6] Sulla «vergogna prometeica» si veda Ivi, pp. 40-72.

[7] Ivi, p. 43.

[8] A. Huxley, Il mondo nuovo (1932), Mondadori Editore, Milano 2015, p. 9.

[9] Secondo Françoise Choay è proprio il racconto di More a inaugurare la letteratura utopica. Si veda F. Choay, La regola e il modello (1980), Officina Edizioni, Roma 1986, pp. 181-220.

[10] Per un testo introduttivo si veda M. Augé, Disneyland e altri nonluoghi (1997), Bollati Boringhieri editore, Torino 2009.

[11] Per questa distinzione si veda l’intervista del 1958 tra il poeta John Lehmann (1907-1987) e Huxley, disponibile al seguente indirizzo: https://www.youtube.com/watch?v=pXS5yWatuE8

[12] A. Maurini, “Il mondo nuovo e i suoi ‘ritorni’, in A. Huxley, Il Mondo Nuovo, cit., p. 364.

[13] G. Anders, L’uomo è antiquato I, cit., p. 23.

[14] A. Huxley, Il mondo nuovo, cit., pp. 52-53

[15] Ivi, p. 38.

[16] “Prefazione del 1946” in, A. Huxley, Brave New World, cit., p. 246.

[17] Si veda https://www.controversie.blog/indi-gregory-lopzione-del-silenzio/

[18] A. Huxley, Il mondo nuovo, cit., p. 46.

[19] Ivi, p. 94.

[20] R. Ronchi, Bergson, Christian Marinotti Edizioni, Milano 2011, p. 127.

[21] A. Huxley, Il mondo nuovo, cit., p. 36.

[22] Ivi, p. 42.

[23] B. Castellane, In terra ostile, Signs Publishing, 2023, p. 14.

[24] A. Huxley, Il mondo nuovo, cit., p. 7.

[25] A. Huxley, “Prefazione del 1946” in, Il Mondo Nuovo, cit., p. 246.

[26] Scrive Huxley ne “Ritorno al mondo nuovo”, in Il mondo nuovo, cit., p. 267, «noi vediamo dunque che la tecnologia moderna ha portato alla concentrazione del potere economico e politico, e alla formazione di una società controllata (spietatamente negli stati totalitari, in modo più pulito e nascosto nelle democrazie».

[27] A. Huxley, Il mondo nuovo, cit., p. 202.

[28] Ivi, p. 204.

[29] si veda A. Huxley, “Ritorno al mondo nuovo”, in Il mondo Nuovo, cit., in particolare pp. 265-275.

[30] A. Huxley, “Ritorno al mondo nuovo”, in Il Mondo Nuovo, cit., p. 269.

[31] Ivi, p. 252.

[32] A. Huxley, Il mondo nuovo, cit., p. 87.

[33] Si veda: https://www.youtube.com/watch?v=alasBxZsb40&t=951s

Dark Ecology - Un'ecologia che rinnega la Natura

Sette proposte.

- Gli animali possono godere dell’arte?

- Gli animali possono riflettere su sé stessi? Gli umani possono riflettere su sé stessi? L’autoriflessione rispetto alla sofferenza è importante?

- Che cos’è la consapevolezza? È una capacità cognitiva “superiore” (meno frequente) o “inferiore” (più frequente)?

- I Neanderthal erano dotati di immaginazione? E noi l’abbiamo? È importante?

- L’intelligenza artificiale soffre? I batteri possono soffrire? Quali sono i limiti “inferiori” della sofferenza?

- La coscienza è intenzionale?

- Il pensare e il percepire sono distinti?[1]

Chi pone queste domande e a chi? Gli studiosi umanisti agli scienziati scrive Timothy Morton, professore alla Rice University di Houston. Sono proposte che emergono lungo la lettura del suo libro Come un’ombra dal futuro (l’espressione è di P. B. Shelley)[2].

Proposte che nel confronto tra studiosi andranno rielaborate, i concetti ridefiniti, le parole risignificate, eliminate, rivoltate.

Non basta più fornire «pubbliche relazioni migliori» alla scienza o studiarne le conseguenze. C’è un pensiero nuovo sulla soglia che chiede di interagire attivamente con la scienza. Un pensiero che abbandona il nichilismo diffuso del pensiero umanistico postmoderno e interroga la rigidità austera della scienza che nel laissez-faire dominante del capitalismo si trasforma con troppo piacere in scientismo. C’è una strana distanza, sadica, implicita in un atteggiamento che si dice sperimentale, condiviso da teorie economiche e teorie scientifiche.

Questo pensiero vuole chiederne conto, vuole che insieme si scenda nel fango, “umanisti” e “scienziati”, e si ricominci a fare esperienza del nostro mondo. Possiamo vivere in una società in cui le scienze contemplino la negatività, agire nella possibilità dell’errore e del torto, rispondere della nostra opera nella maglia del mondo in mezzo a esseri che si presentano “estranei strani”.

Come un’ombra dal futuro

Complicato? Sì, perché spero le frasi si presentino nella loro forza di suggestione, anche se estrapolate dal libro di Morton. Pubblicato nel 2010 e portato in Italia dalle edizioni Aboca nove anni dopo, Come un’ombra dal futuro si presenta come un manifesto per un nuovo pensiero ecologico» ancora da pensare.

I ragionamenti sono molti, spesso piacevoli in quanto arricchiti da numerose citazioni poetiche e cinematografiche, oltre che da un eloquio che si contraddistingue per lo slancio rivoluzionario, ai limiti dell’escatologico. Sono tesi forti, a tratti appena accennate, in altre parti pensate a lungo e con onestà. Il linguaggio è coinvolgente, ma non rinuncia alla profondità di pensiero e per questi motivi ho pensato fosse interessante dargli risalto.

È un libro che vuole essere divulgazione rivolta a lettori e lettrici che possano affrontarne le pagine dense di contenuti anche senza una conoscenza specialistica.[3] Si presenta a noi come un confronto serrato tra le tesi che caratterizzano il pensiero queer, basate su un’ontologia influenzata dagli scritti di Lévinas e che si oppone a Heidegger scontrandosi con quel pensiero immobilizzante dei paradigmi da fine della storia.

Complicato anche perché l’ecologia dark è come un film noir, afferma Morton. Non è la soddisfacente vittoria deduttiva del pensiero razionale à la Sherlock. Pensiamo di essere di essere esterni e oggettivi, ma ci ritroviamo irrimediabilmente coinvolti. Non solo. Pensiamo di essere umani e come Deckard di Blade Runner – il richiamo al capolavoro è dell’autore – scopriamo di essere replicanti. Cosa succederebbe? Siamo capaci di pensare il negativo delle concezioni che ci hanno accompagnato alla fine della modernità? Siamo capaci di un pensiero che superi il negativo riconoscendo che esso stesso è opera nostra?

Ecologia oscura

Perché proprio riconoscere la nostra opera è ciò che fa scattare il pensiero ecologico per Morton. Sappiamo ora che abbiamo sempre terraformato la Terra. Grazie alle tecnologie di cui disponiamo oggi possiamo decostruire molti costrutti che inquinano il pensiero. Possiamo fare esperienza dell’appartenenza a un mondo più grande, quasi infinito. Più che olistico dice Morton, perché come una geometria frattale si avviluppa e riproduce in ogni sua parte.

L’arte, per esempio, può essere profondamente ecologica (e già lo è). Non solo, essa può diventare visione anche per le scienze. Grazie allo sviluppo dell’utilizzo di tecniche come l’ingrandimento, lo stop motion, il time-lapse, abbiamo oggi accesso a nuove riproduzioni della realtà. Pensate a quei video prodotti in time-lapse che possono narrare la vita di una pianta lungo due anni di tempo, i quali ci consegnano una pianta vitale, in movimento, estranea alla nostra idea di “pianta”.

Così come è possibile ricreare spazi ambientali che esaltino proprio la loro caratteristica di essere ambiente (Morton pensa alle sale del Centre Pompidou, quelle del piano dedicato al contemporaneo). O ancora, la riproduzione delle forme naturali attraverso le già citate geometrie frattali, che da anni hanno tutta la nostra attenzione. Senza parlare di quello che Morton non poteva vedere nel 2010, che vediamo oggi nelle riproduzioni o “creazioni” affidate all’Intelligenza Artificiale o vissute nella realtà virtuale.

Rinnegare la Natura

Vedere questo ci permette di interrogare nuovamente i costrutti che dominano le nostre visioni economiche, ambientaliste e scientifiche. Non c’è alcun mondo da re-incantare o da ritrovare. Al contrario, c’è per Morton un mondo da demistificare e il suo principale obiettivo polemico è la Natura in questo caso. Il concetto di Natura è per l’autore il principale punto debole dell’ambientalismo “verde brillante” che presta il fianco al capitalismo, anche se non vorrebbe. Non si parla solo della produzione di batterie al litio rispetto all’estrazione di petrolio e alla produzione di CO2 in eccesso nell’atmosfera. Il vero greenwashing è nascondere ciò che è negativo della nostra realtà di viventi. Nascondere i rifiuti, parte dell’ambiente di un vivente, sotto il tappeto. Spiego meglio: l’ambientalismo preserva un paesaggio “naturale” dall’installazione di pale eoliche, l’estetica vince sull’etica, mentre sottoterra scorre l’ultimo oleodotto e stagna il bagno chimico. La Natura è fantasma, inconscio collettivo, costruzione da sogno che fa dimenticare all’umano di essere responsabile del mondo.

L’ecologia proposta da Morton non è nichilista, non è ambientalista, rinnega la Natura.

In tutto questo, lo trovo un pensiero liberatorio e interessante, oltre che sicuramente provocatorio.

È un pensiero che si affaccia e che ha bisogno di essere pensato. Non solo.

Ha bisogno delle scienze perché le vuole coinvolgere attivamente nella demistificazione del mondo.

Le domande che ho riportato in apertura sono le domande che Morton inizia a porre per comprendere il nuovo ruolo dell’umano del mondo.

Ruolo millenario, ma che solo oggi iniziamo a conoscere – sembrerebbe.

“Se potessimo dimostrare che la coscienza non è una sorta di sublime premio aggiuntivo per essere fatti in modo così elaborato, bensì un’impostazione predefinita allegata al software, allora i vermi sarebbero coscienti in ogni senso significativo. Un verme potrebbe diventare Buddha, in qualità di verme. Siamo sicuri che i non umani non abbiano un senso dell’”io”? Siamo sicuri che noi lo abbiamo?” [4]

NOTE

[1] Timothy Morton – Come un’ombra dal futuro. Per un nuovo pensiero ecologico – Aboca edizioni, Sansepolcro (Ar) 2019

[2] Le proposte sono riassunte così come le porto alle pagine 184 e 185 della traduzione italiana del libro.

[3] Gli studi e le ipotesi contenute si basano su precedenti libri di Morton Dark Ecology (2016), Ecology without Nature (2007), che il lettore specialistico o in cerca di analisi più approfondite può recuperare facilmente nelle edizioni in lingua originale.

[4] Timothy Morton – Come un’ombra dal futuro. Per un nuovo pensiero ecologico – Aboca edizioni, Sansepolcro (Ar) 2019

Etica, morale & Intelligenza Artificiale

L’intelligenza artificiale è una tecnologia “nuova” che sta trovando applicazione in numerosi campi scientifici, industriali, sociali e politici, e – come per ogni nuova tecnologia – nella sua applicazione possono emergere dei problemi di carattere etico e morale.

In questo post:

- cerco di mettere in rilievo perché sia opportuno dedicare attenzione alla correlazione tra intelligenza artificiale e questioni etiche e morali

- analizzo due casi concreti di utilizzo di tecnologie intelligenti alla ricerca di spunti di riflessione

- provo a rappresentare un esempio di catena di responsabilità nella realizzazione di questo tipo di tecnologie

- e, infine, traggo delle conclusioni di ordine morale – che mi piacerebbe che fossero normative

Per definire convenzionalmente e localmente – giusto per la lettura di questo post – l’Intelligenza Artificiale, mi attengo a questa coppia di definizioni, la prima di “intelligenza”, di E. Scribano, in un suo libro su Descartes, da me modificata in senso più generale, e la seconda di “artificiale”, dal Dizionario Treccani:

- intelligenza: il vivente è una macchina intelligente, se traduciamo questo termine nell'insieme dei comportamenti causati da stati fisici che consentono al corpo vivente di reagire all'ambiente in modo funzionale a degli obiettivi [1], tenendo conto dell'esperienza passata [2]

- artificiale: fatto, ottenuto con arte

Allo stesso livello di generalità prendiamo in considerazione la definizione che si trova sul sito di un gigante delle tecnologie, la Oracle Corporation:

Intelligenza Artificiale (I.A.): sistemi o macchine che imitano l'intelligenza umana per eseguire certe attività e che sono in grado di migliorarsi continuamente in base alle informazioni raccolte [3]

PERCHÈ PARLARE DI ETICA E DI MORALE ASSOCIATE ALL’IA?

La riflessione può nascere in un contesto molto familiare, la guida di una automobile con un sistema intelligente anti-collisione: il sistema ha provocato la frenata, ha letteralmente “inchiodato” la macchina in mezzo al Carrobbio [4], senza che il guidatore (io) capisse perché o potesse intervenire. La ragione della frenata era un gatto che era passato a pochi centimetri dal sensore radar e che, senza anti-collisione, forse non avrei risparmiato.

Le lateralità di questo salvataggio di un gatto del Carrobio sono state, per fortuna, senza conseguenze:

1) il cane di famiglia è finito a gambe all’aria nel bagagliaio

2) l’auto che mi seguiva ha inchiodato a sua volta evitando il tamponamento

Non si può negare, osservando questo caso banale, che un problema morale nell’utilizzo di tecnologie intelligenti c’è.

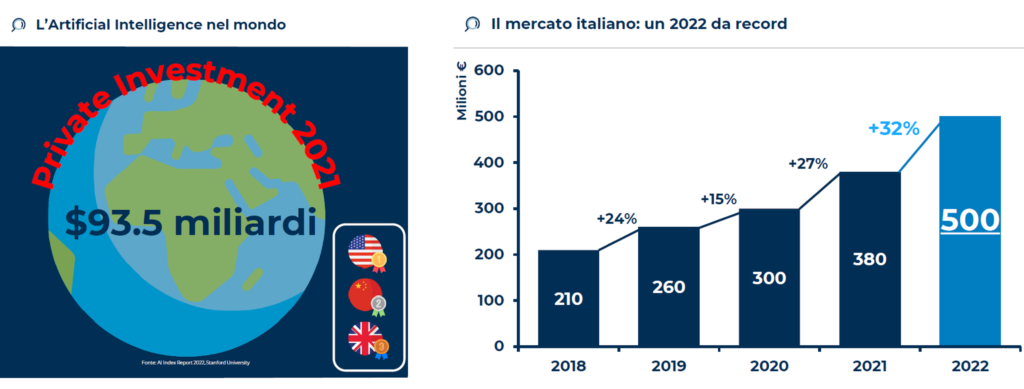

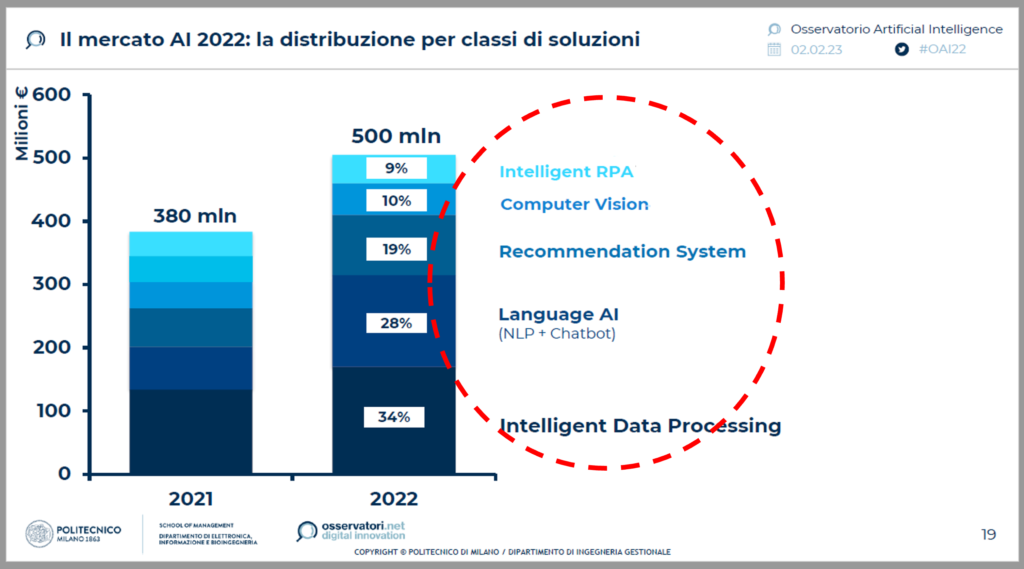

C’è ed è pervasivo: nel 2022 gli investimenti per l’IA sono di 500 milioni di euro in Italia [5] e di più di 90 miliardi di dollari nel mondo[6].

C’è e prende diverse direzioni: gli investimenti in Italia sono destinati all’Elaborazione Intelligente di Dati (34%), alla Comprensione del Linguaggio Naturale (28%), ai Sistemi di Supporto alla Decisione (19%), alla Visione Computerizzata (10%) e all’Automazione Robotica dei Processi.[7]

Il caso della frenata, del gatto del Carrobbio e del cane di famiglia si colloca tra Visione Computerizzata, Elaborazione Intelligente di Dati e Automazione dei Processi.

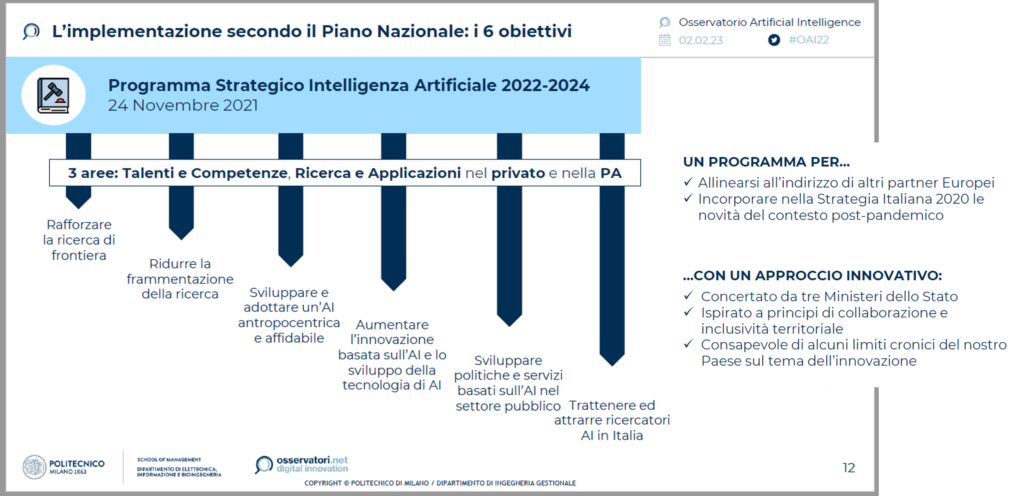

Inoltre, lo sviluppo delle tecnologie di IA è sostenuto dalle Istituzioni: ad esempio, lo Stato italiano ha elaborato un Programma Strategico per gli anni 2022 – 2024, focalizzato su Talenti (da creare o trattenere), Competenze (da generare) e Applicazioni, nel privato e nella Pubblica Amministrazione. [8]

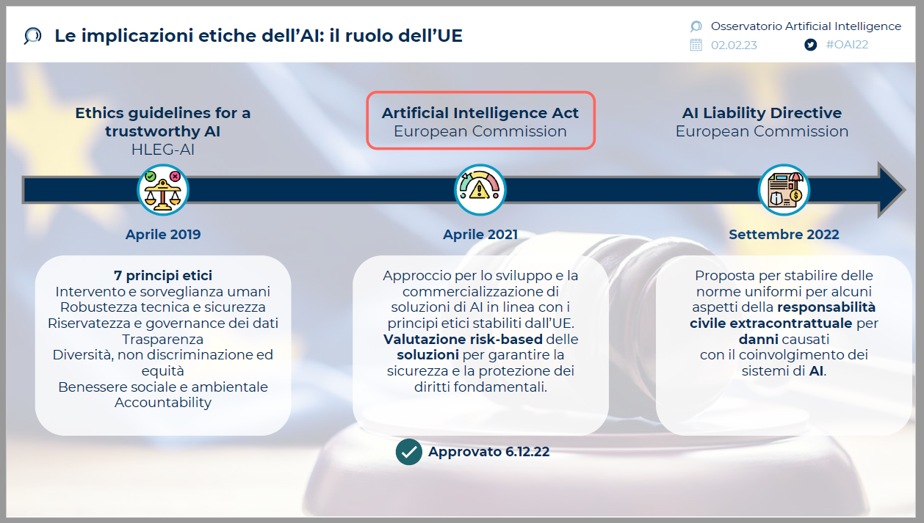

Le Istituzioni non nascondono il problema morale e alcune preoccupazioni; tra il 2019 e il 2022, l’Unione Europea ha varato 3 deliberazioni [9] che cercano di normare le implicazioni etiche della nuova tecnologia: le “Linee Guida per una IA affidabile” si focalizzano sulla robustezza, sul rispetto della sicurezza degli esseri umani (escludendo il gatto del Carrobbio, il cane di famiglia e altri viventi non umani), della trasparenza, della privacy, della non-discriminazione, del benessere ambientale e sociale, e sulla attribuzione di responsabilità per le azioni delle tecnologie; un Atto per l’Intelligenza Artificiale, che delinea l’approccio corretto per lo sviluppo e l’applicazione; una proposta per stabilire delle norme di responsabilità civile in caso di danni.

Il problema morale è enfatizzato dal comportamento delle Aziende: più di un terzo delle Aziende che utilizzano IA non ritiene rilevante il tema etico, il 40% lo prende in considerazione in termini futuri o in modo destrutturato; solo il 21% ha una strategia definita[10] .

-------

L’APPROCCIO DEL PARLAMENTO EUROPEO

Una pubblicazione del Parlamento Europeo, su rischi e vantaggi dell’Intelligenza Artificiale, esprime la visione dell’Istituzione che legifera per l’EU sull’IA:

“L’intelligenza artificiale può consentire lo sviluppo di una nuova generazione di prodotti e servizi, anche in settori in cui le aziende europee sono già in una posizione di forza come l’economia circolare, l’agricoltura, la sanità, la moda e il turismo. Può infatti offrire percorsi di vendita più fluidi e ottimizzati, migliorare la manutenzione dei macchinari, aumentare sia la produzione che la qualità, migliorare il servizio al cliente e risparmiare energia.” [11]

“L’intelligenza artificiale potrebbe significare una migliore assistenza sanitaria, automobili e altri sistemi di trasporto più sicuri e anche prodotti e servizi su misura, più economici e più resistenti. Può anche facilitare l’accesso all’informazione, all’istruzione e alla formazione.” [12]

“L’IA aiuta a rendere il posto di lavoro più sicuro, perché il lavoro più pericoloso può essere demandato ai robot, e offrire nuovi posti di lavoro grazie alla crescita delle industrie dell’intelligenza artificiale.”[13]

E stima l’aumento della produttività del lavoro tra l’11% e il 37% entro il 2035. [14]

L’approccio tradisce la visione scientista, positivista ed efficientista –che proviene dalla pratica scientifica e dalle aziende che ricercano efficacia ed efficienza.

Poco viene detto sulle lateralità negative.

Si potrebbe tradurre: benvenuta la nuova tecnologia che aiuta la crescita e il comfort delle persone che già hanno la gran parte delle opportunità e dei privilegi.

---------

DUE CASI CONCRETI ED EMBLEMATICI

Il primo caso esemplare è quello già accennato del radar anti-collisione dell’automobile.

Tra i soggetti potenzialmente coinvolti negli effetti di applicazione ci sono – oltre al gatto del Carrobbio e al cane di famiglia: il guidatore, i passeggeri che possono riportare danni, i passanti che si possono salvare, gli altri automobilisti che hanno tempi di reazione molto minori del sistema e possono subire danni fisici in caso di tamponamento.

Il problema morale, in questo caso, può essere delineato in questi termini:

- il sistema deve intervenire o solo “avvisare”, cioè, suggerire al guidatore un intervento?

- Cosa farebbe un umano senza il sistema?

- Che frequenza e gravità hanno gli effetti collaterali negativi?

- Per gestire il trade-off tra danni ad un vivente e un altro, si deve fornire al sistema una scala di valore delle categorie di esseri viventi per decidere cosa fare?

- Quanto deve essere grande e vicina la sagoma rilevata, per attivare la frenata?

- Si deve lasciare al guidatore la possibilità di disattivare il sistema?

- Come sono influenzate dalle culture locali, in Europa, in USA, in Cina, le categorie logiche che informano il sistema? John, Hu, Michelle, Stella darebbero le stesse istruzioni alla macchina? E quando Jack usa la macchina di Michelle?

Il secondo contesto che esaminiamo è quello delle applicazioni in campo medico, in particolare dei sistemi intelligenti di supporto alla diagnosi, per i quali KBV Research stima 1,3 miliardi di dollari di spesa all’anno.[15]

Le principali applicazioni diagnostiche, basate sui grandi numeri e sull’analisi statistica, sono rivolte a pratiche come:

- la diagnosi differenziale – che è discernimento tra diverse possibili patologie con sintomatologie simili

- la ricerca di pattern fuori focus – cioè, di sintomi, fenomeni, elementi e manifestazioni minori che, se identificati, possono aiutare a diagnosticare patologie che sono fuori dal focus diagnostico principale

- l’analisi ex-post del tasso di errore diagnostico umano, per esempio a fronte di determinati schemi di sintomi che “puntano” a diverse possibili patologie

per ridurre il tasso di errore diagnostico umano.

Una ragione per cui si investono capitali così ingenti sulle tecnologie diagnostiche intelligenti è, infatti, l’incidenza di errori diagnostici dei medici, che si stima causi alcune migliaia di morti in Italia e decine di migliaia negli USA;[16] oltre al costo sociale, questi errori comportano anche costi finanziari ingenti – in termini di ulteriori esami, ricoveri e, soprattutto, risarcimenti.

Le cause degli errori diagnostici, secondo uno studio congiunto di Sidney University e University of Newcastle (Aus), sono per il 15% di tipo cognitivo, legate a:

- uso errato della statistica

- ancoraggi, ossia collegamenti rigidi tra situazioni sintomatiche e diagnosi

- errori di framing

- pletora o carenza di esami

- fissazione su esperienze di successo

- cecità attentiva

In questo senso, i tanti sostenitori dell’utilizzo delle tecnologie intelligenti in diagnostica, che si richiamano al concetto di Medicina Basata sulle Evidenze (EBM, Evidence Based Medicine), ritengono che questi sistemi possano supportare il lavoro diagnostico grazie a:

- l’uso razionale delle informazioni

- l’interpretazione automatizzata dei dati diagnostici

- l’uso intensivo delle statistiche, delle frequenze storiche e delle previsioni probabilistiche

Tuttavia, i sistemi di Intelligenza Artificiale cadono spesso in errori (allucinazioni), come è accaduto a ChatGPT quando ha suggerito che si possono ottimamente sostituire i bisturi con i grissini. [17]

Il problema morale sotteso all’uso di queste tecnologie in diagnostica è correlato a:

- la possibilità di errore sistematico nella progettazione degli algoritmi di apprendimento e di analisi

- la prevalenza della statistica sull’esperienza, che può influenzare il medico sulle occorrenze più probabili e ad ignorare le possibilità meno frequenti, replicando gli effetti degli errori cognitivi

- l’effetto black box, ossia l’accettazione acritica di ciò che suggerisce il sistema.

-----------

PROBLEMA DELLA RESPONSABILITÀ

Il problema morale solleva quello della responsabilità, che vede coinvolta una serie di figure professionali quali, p.e.: il progettista, l’ingegnere della conoscenza che controlla l’apprendimento, il programmatore che “scrive” i meccanismi di autoapprendimento, il produttore, l’acquirente – p.e.: il dipartimento acquisti della struttura sanitaria, l’utilizzatore tecnico e l’utilizzatore finale che prende la decisione diagnostica e alimenta il meccanismo di autoapprendimento.

Ad esempio: in caso di danni ad un paziente derivanti da malfunzionamento o da una distorsione del sistema, a chi va attribuita la responsabilità? A chi l’ha realizzato oppure a chi l’ha istruito? Al produttore che lo vende sulla base di una promessa di valore che volutamente tralascia le negatività? All’acquirente abbagliato dai risparmi? Oppure all’utilizzatore finale che prende per buono acriticamente il responso della “macchina”?

La responsabilità morale – a mio avviso – ricade su tutti i soggetti che hanno trascurato, con motivazioni differenti, i rischi di errore e di lateralità del sistema.

In assenza di una norma che regoli tutte le fasi del processo, è evidente che anche la responsabilità giuridica è difficile da attribuire.

Forse è più facile agire affinché questi errori accadano con minore frequenza, grazie alla consapevolezza sui rischi legati all’utilizzo delle tecnologie e a un grado superiore di responsabilizzazione preventiva di tutti i soggetti.

-----------

CI SONO DELLE CONCLUSIONI?

Posto che quello della IA può essere un cambiamento epocale con enormi caratteri positivi, vorrei delineare delle possibili raccomandazioni generali di ordine morale:

- non ci si può sottrarre ad una analisi approfondita dei criteri morali che informano i comportamenti delle macchine;

- va tenuto presente che i modelli di apprendimento sono altrettanto sensibili al problema morale; come vengono addestrate le macchine, quali euristiche adottano, quali modelli di percezione [18] vengono usati, sono fattori determinanti per il comportamento delle tecnologie e per l’orientamento delle decisioni umane;

- non è il caso di sostituire l’analisi e l’esperienza con i modelli statistici: in diagnostica, p.e., l’IA può egregiamente svolgere funzioni di supporto ma è preferibile che “non prenda decisioni”

- ci si deve guardare dall’effetto black box, soprattutto se nei sistemi sono incluse funzionalità di apprendimento;

- non vanno mai dimenticate le lateralità sociali

Ma questo vale per tutte le nuove tecnologie.

NOTE

[1] Il testo originale (vedi nota successiva) recitava “alla conservazione della vita”

[2] E. Scribano, Macchine con la mente, Carocci Editore, 2015

[3] https://www.oracle.com/it/artificial-intelligence/what-is-ai/

[4] Il Carrobbio, da quadrivium, è un largo di Milano le cui origini risalgono all'epoca romana. È posto indicativamente alla confluenza fra via Torino, corso di Porta Ticinese, via San Vito, via Cesare Correnti e via del Torchio. Nei dintorni circolano ancora numerosi gatti randagi.

[5] Politecnico di Milano, Osservatori.net - Osservatorio Artificial Intelligence 2023

[6] AI index report 2022, Stanford University

[7] : Politecnico di Milano, Osservatori.net - Osservatorio Artificial Intelligence 2023

[8] Ibidem

[9] Ibidem

[10] Ibidem

[11] Parlamento Europeo - https://www.europarl.europa.eu/news/it/headlines/society/

20200918STO87404/quali-sono-i-rischi-e-i-vantaggi-dell-intelligenza-artificiale

[12] Ibidem

[13] Ibidem

[14] Ibidem

[15] KBV RESEARCH - https://www.kbvresearch.com/artificial-intellgence-diagnostic-market

[16] Morti in ospedale all’anno per errori diagnostici, in Italia: più di 10.000 (M. Motterlini, V. Crupi, Decisioni Mediche, Raffello Cortina Editore, 2005); in Usa: tra 44.000 e 100.000 (Politecnico di Milano, 2002; United States Institute of Medicine, 1999)

[17] Corriere della Sera, 24.01.2023

[18] A breve sarà a disposizione sul blog un articolo di un filosofo orientale che focalizza l’attenzione sulla dimensione epistemologica dell’IA