Intelligenza artificiale e creatività - I punti di vista di tre addetti ai lavori

Ancora solo pochi anni fa, tutti sapevamo che nei laboratori della Silicon Valley – ma non solo, anche in laboratori di Paesi meno trasparenti – si lavorava a forme di intelligenza artificiale; ma in fondo, se non si faceva parte della schiera degli addetti ai lavori, tutto questo tema rimaneva confinato come una questione ancora lontana e più adatta alle fiction.

E invece, come una bomba, nel dopo pandemia l’AI è esplosa nelle vite di tutti noi – lasciando i più attoniti e frastornati – e di certo andrà a cambiare professioni e modi di lavorare che abbiamo sempre ritenuto di esclusiva pertinenza dell’intelligenza umana.

L’intelligenza artificiale non si limita a processare a velocità inconcepibili da mente umana miliardi di dati, con l’AI si possono creare immagini, testi. Insomma, sconfinare nei territori di pertinenza dell’arte, anche se è difficile definire in modo certo e univoco cosa sia l’arte.

Abbiamo quindi pensato di chiedere a tre persone che fanno parte del gruppo di Controversie e che usano l’intelligenza artificiale per creare immagini, quale sia il loro rapporto con la “macchina” e con il processo creativo.

La prima specifica domanda fatta è la seguente: Creare un’immagine con l’AI è un atto creativo?

Vediamo le risposte…

Matteo Donolato – Laureando in Scienze Filosofiche, professore e grafico di Controversie

Credo proprio di sì: dal punto di vista umano, la generazione di immagini con l’Intelligenza Artificiale non è un atto così passivo come forse potremmo pensare, in quanto rappresenta un vero lavoro artistico e creativo. Inoltre, in questa interazione tra macchina e persona in carne e ossa non c’è una protagonista assoluta, ma entrambe collaborano per il raggiungimento dell’obiettivo finale: le due intelligenze, dunque, operano insieme, senza una preponderanza di una sull’altra. Tuttavia, a prima vista si può ritenere che l’I.A. sia la vera “artista”, e si potrebbe inoltre immaginare che esegua tutto il lavoro, con l’essere umano che semplicemente impartisce dei comandi e aspetta che essa “faccia la magia”. Ragionando così, sottovalutiamo (e di molto) il nostro potere di intervento, concedendo tutto il credito della prestazione creativa alla macchina; le cose, in realtà, non sono così semplici, in quanto è l’artista umano a dettare le regole del gioco. Infatti, questi stabilisce tutta una serie di fattori molto importanti come, per esempio, il comando iniziale (o prompt), lo stile che avrà la sessione immagini, il tempo dedicato a essa, il numero di tentativi, le eventuali variazioni o i dettagli che tali rappresentazioni devono possedere, con la macchina che esegue. Alla fine del lavoro, quando l’I.A. avrà realizzato le proprie opere, è l’artista umano che garantisce l’adesione di essa a ciò che si era stabilito nel prompt; inoltre, è nuovamente lui (o lei) a decretare se il risultato ottenuto sia soddisfacente, in linea con le volontà iniziali. Insomma, l’intelligenza umana è la prima e ultima arbitra dell’immagine, colei che inizia e orienta la sessione di lavoro e che, alla fine, giudica l’operato dell’I.A.; siamo noi, quindi, a tessere i fili, a stabilire la qualità artistica e creativa del prodotto restituito dalla macchina. Quest’ultima costituisce, pertanto, il mezzo attraverso cui la nostra creatività e la nostra immaginazione si possono esprimere. In conclusione, l’I.A. rappresenta uno strumento, come tanti altri, a supporto dell’intelligenza e della fantasia umane...

-----------------------------

Paolo Bottazzini – Epistemologo, professionista del settore dei media digitali ed esperto di Intelligenza Artificiale

Credo sia legittimo attribuire un riconoscimento di creatività alla generazione delle immagini con IA in ugual misura a quanta ne è stata riconosciuta agli artisti degli ultimi decenni. Il ruolo dell'artista, come è stato incarnato da personaggi importanti come Hirst o Kapoor, consiste nell'elaborazione del modello concettuale dell'opera, non nella sua realizzazione pratica, che per lo più è affidata ad operatori artigianali specializzati. Anche la produzione con l'IA richiede una gestazione concettuale che prende corpo nel prompt da cui l'attività dell'IA viene innescata. Si potrebbe discutere del grado di precisione cui arriva il progetto degli artisti "tradizionali" e quello che è incluso nelle regole che compongono il prompt: ma credo sarebbe difficile stabilire fino a che punto la differenza sia qualitativa e non semplicemente quantitativa. Più interessante sarebbe valutare se il risultato dell'operazione condotta con l'IA sia arte, al di là dei meriti di creatività: anche i pubblicitari si etichettano come "creativi", e di certo lo possono essere - però difficilmente saremmo disposti a laureare tutti gli annunci pubblicitari come "arte".

-----------------------------

Diego Randazzo – Artista visivo

Molto semplicemente: dipende.

Penso che anche rimanendo ancorati alla tradizione, addentrandosi nella miriade di produzioni odierne, realizzate con le canoniche tecniche artistiche (la pittura, la scultura, la fotografia, etc.) sia piuttosto difficile trovare “l’opera d’arte”. Semplificando, ma non troppo, oggi anche le risultanze di tecniche storicizzate spesso si avvicinano più alle forme della ‘tappezzeria', o anonimo complemento d’arredo, che al manufatto artistico, testimone di senso.

Il semplice atto creativo non ha nulla a che fare con l’elaborazione e produzione artistica, se non ambisce a costruire un percorso di senso e di ricerca progettuale.

Questa piccola premessa vuole essere una provocazione per far riflettere su un principio ancora oggi saldo e indissolubile: la tecnica e lo strumento in sé sono ‘oggetti monchi’, se privati di un valore che solo il radicamento concettuale nella contemporaneità può attribuirgli. Non mi piace snocciolare citazioni, ma credo che Enzo Mari, quando nel 2012 sentenziava ‘’Non esiste oggi parola più oscena e più malsana della parola creatività. Si produce il nulla, la merda con la parola creatività’’ aveva plasticamente intercettato certe tendenze che, di lì a poco, avrebbero preso il sopravvento. La creatività, intesa come paradigma vincente e performante per risolvere ogni questione di non facile risoluzione.

Sgombrato quindi il campo dalle generalizzazioni, su cosa sia o non sia un atto di creatività, si può sicuramente affermare che l’IA sia uno strumento potentissimo e, se usato finemente, con intelligenza e cura, può condurre alla creazione di un’opera d’arte.

Ma cerchiamo da subito di fare dei distinguo: l’IA deve rimanere uno strumento e non una finalità. Nello specifico - e questa è una mia personalissima teoria - il creativo/artista di turno non può pensare di fermarsi, dopo qualche interrogazione, all’output grezzo generato dall’IA, convincendosi di aver dato vita a qualcosa di unico, affascinante e interessante.

Come avveniva già nella tradizione classica della pittura, le influenze e lo studio sono fondamentali; una volta si viaggiava, gli artisti si incontravano, si contaminavano scambiandosi tecniche e saperi, mentre oggi si può attingere ad un patrimonio di dati sconfinato in rete. Il rischio omologazione è altissimo, perciò è fondamentale conoscere e confrontarsi con il passato, il presente ed immaginare un possibile futuro che tenga insieme tutto. Quindi passato, presente e futuro sono i fondamentali per poter imbastire una progettualità, non finalizzata a costruire ‘immagini nitidissime di mondi impossibili e surreali’ - come vediamo nel repertorio più di tendenza nella generazione di immagini con l’IA - bensì volta a costruire delle riflessioni sui processi narrativi e sulla storia delle immagini stesse.

E chi è che oggi può fare tutto questo con consapevolezza, senza farsi ingabbiare dall’effetto decorativo, dal rischio tappezzeria? Senza ombra di dubbio è l’Autore, l’unica figura che può padroneggiare questi strumenti, mettendoli al servizio della propria poetica.

Riprendo brevemente il tema sull’autorialità tratto da una precedente intervista rilasciata sempre su questo blog:

‘’Autore è colui che interroga e, soprattutto, rielabora e reinterpreta secondo la propria attitudine il risultato dell’Intelligenza artificiale. La macchina fa le veci del ricercatore: mette insieme e fonde tantissimi dati e, in ultima istanza, restituisce un ‘abstract grezzo’. Quell’abstract non può rimanere tale. Deve essere decostruito e manipolato dall’artista per assurgere ad opera d’arte. L’IA, come processo generativo, è quella cosa che sta in mezzo, tra il pensiero, l’idea iniziale e l’opera finale. Tutto qui. Non è semplificazione, è come dovrebbe essere inteso il ruolo dell’intelligenza artificiale nella creazione artistica.’’

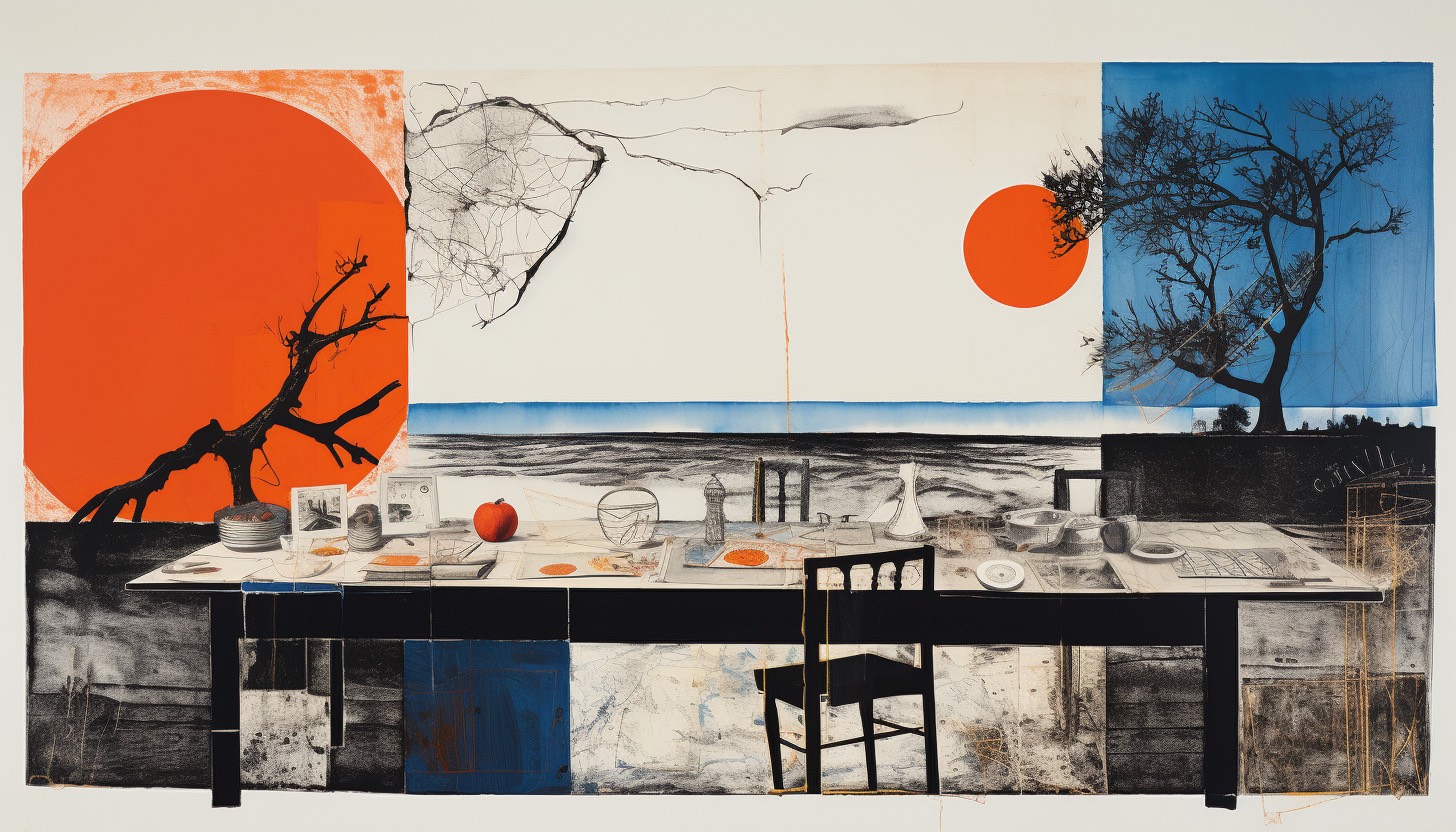

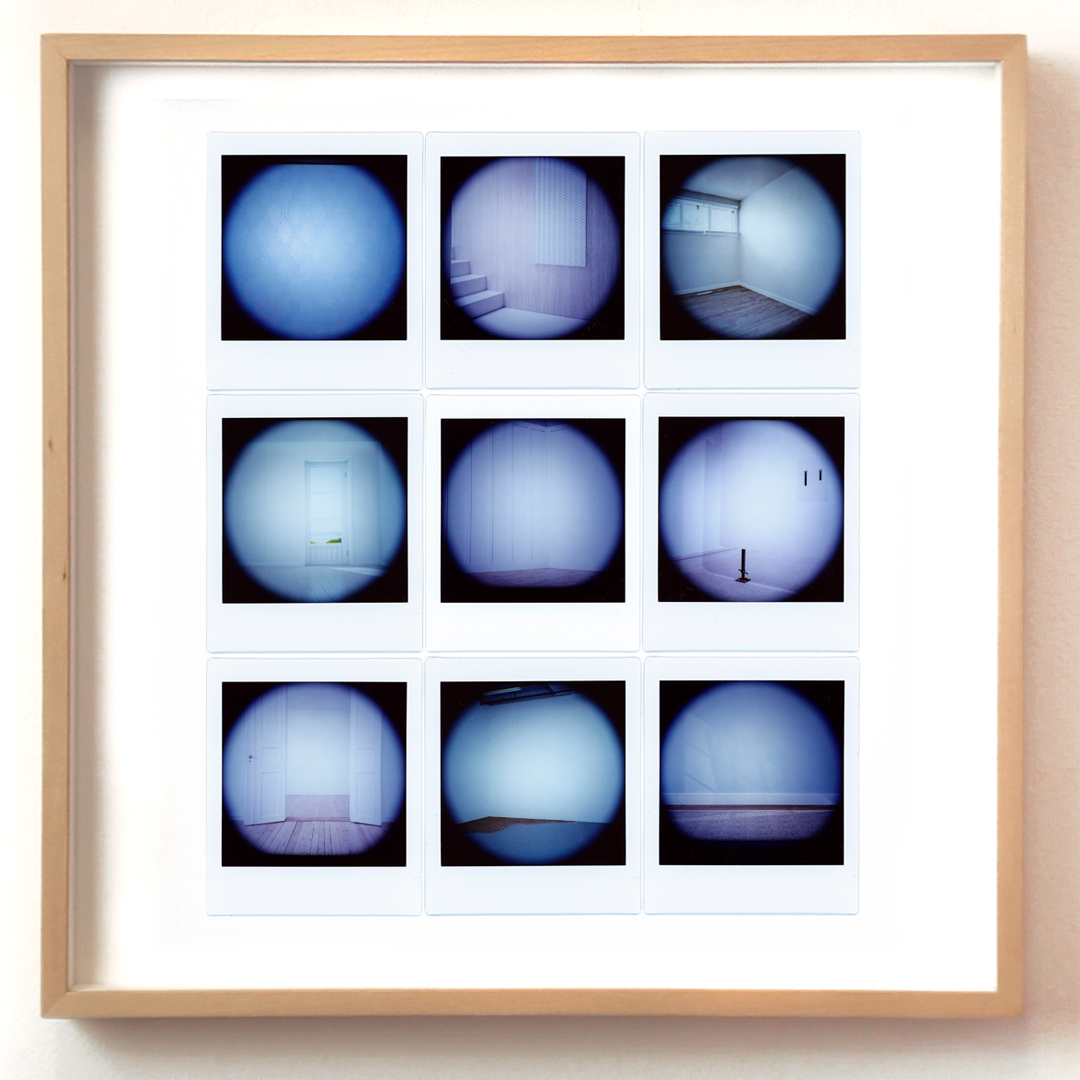

Quest’opera dal titolo 24 intime stanze è un esempio pratico della mia idea di utilizzo di Ai in campo artistico e soprattutto della necessità di far emergere una concatenazione virtuosa tra passato, presente e futuro: dall’utilizzo della cianotipia (antica tecnica di stampa a contatto) e la pittura ad olio, all’uso dell’I.A. per elaborare le referenze del soggetto protagonista.

24 intime stanze / dalla serie ‘Originali riproduzioni di nuovi mondi’ (Opera finalista al Combat Prize 2024, nella sezione pittura), Cianotipia e pittura a olio su tela grezza, 120x100x2 cm, 2024

----------------------

Non c’è dubbio che queste tre risposte siano estremamente stimolanti e che vi si possa rintracciare un minimo comune denominatore che le lega: l’idea che l’IA sia solo un mezzo, per quanto potente, ma che l’atto creativo resti saldamente appannaggio di colui che ha nel suo animo (umano) l’obiettivo concettuale.

Ottenere un risultato con l’IA si delinea, qui, come un vero atto creativo, che, però e ovviamente, non è detto che si trasformi in arte, ovvero in una manifestazione creativa in grado di dare emozione universale.

In termini più concreti: molti di noi, forse, potrebbero avere “nella testa” La notte stellata di Van Gogh (giusto per fare un esempio), ma la differenza tra la grandissima maggioranza di noi e il genio olandese è che non sapremmo neppure lontanamente “mettere a terra” questa intuizione.

Con l’IA, a forza di istruzioni che la macchina esegue, potremmo invece, avvicinarci al risultato di Vincent?

Se fosse così, in che modo cambierebbe l’essenza stessa dell’artista?

Antropologia dell’IA - Stereotipi, discriminazioni di genere e razzismi

Da un twitter divenuto virale nel 2019 si è venuti a conoscenza del fatto che Goldman Sachs, una delle più importanti banche d’investimento del mondo, aveva escluso una potenziale cliente dall’accesso a una prestigiosa ed esclusiva Apple card in base a una profilazione erronea e discriminatoria. Il fatto si è saputo perché l’autore del twitter, un danese sviluppatore di software, è il marito della persona a cui era stata negata la card, che lui invece aveva ottenuto pur guadagnando meno di lei. In sostanza, la donna per ragioni opache e non trasparenti era stata considerata non idonea per quel determinato prodotto.

Discriminazioni di genere

Se non ci fosse stato quel twitter non si sarebbe saputo nulla di tutto ciò, ovvero di una sistematica e silenziosa discriminazione di genere. La vicenda rappresenta una plastica esemplificazione della nota metafora del cosiddetto “soffitto di cristallo”: la possibilità che una donna ha di poter scalare il potere o di avere pari opportunità di carriera è spesso preclusa da una sorta di soffitto trasparente, che costituisce una barriera invisibile eppure potente e limitante. Per ragioni imperscrutabili, non esplicitate chiaramente e senza la possibilità di entrare nel merito, gli algoritmi rischiano di attuare politiche discriminatorie, che si supponeva dovessero appartenere al passato e non alle tecnologie del futuro. La rappresentazione, l’interpretazione e la codificazione degli esseri umani attraverso dataset di training e le modalità con cui i sistemi tecnologici raccolgono, etichettano e utilizzano questi materiali sono aspetti decisamente cruciali nel riprodurre stereotipi, pregiudizi, forme di discriminazione di genere o razziale. I bias trovano sempre una strada per inserirsi nel sistema, o meglio in un certo senso i bias fanno parte del sistema. A questo proposito, è noto che fino al 2015 Amazon reclutasse i suoi futuri dipendenti tramite un sistema che si era “allenato” sui curricula, in genere di uomini, ricevuti nei dieci anni precedenti. I modelli avevano quindi imparato a raccomandare gli uomini, autoalimentando e amplificando le disuguaglianze di genere dietro la facciata di una supposta neutralità tecnica. Tanto per fare un esempio, il curriculum di un aspirante dipendente di Amazon veniva scartato se al suo interno conteneva la parola “donna”, perché il sistema aveva imparato a gestire di dati così (Dastin 2018).

Il razzismo dell’IA

L’IA produce e riflette le relazioni sociali, una determinata visione del mondo e, inevitabilmente, i rapporti economici e di potere, visto il notevole capitale in termini finanziari che occorre per investire in essa. Basti pensare che i sistemi di riconoscimento facciale, che contribuiscono fortemente a etichettare la realtà e gli umani, derivano dai primi tentativi sperimentali della Cia e dell’FBI negli anni Sessanta, passando per i database basati sulle immagini dei carcerati, per arrivare all'epoca attuale, dove i principali sistemi di questo tipo sono alimentati da volti e scatti liberamente messi in circolazione sui social (Crawford 2021:105-135). Ovviamente l'accresciuta complessità tecnologica e il suo considerevole impatto sociale hanno fatto emergere anche i tratti più controversi dell’IA, a cominciare dai pregiudizi automaticamente inseriti nei dataset utilizzati per nutrire l'intelligenza artificiale. Si pensi al fatto che c’è stato un lungo dibattito sul riconoscimento facciale, in cui si è visto che è più difficile distinguere i neri, proprio perché i dataset di training si fondano prevalentemente su materiale fotografico di bianchi, raccolto e categorizzato soprattutto da bianchi.

Le differenze razziali, culturali e di genere sono elementi che non si limitano ad affiancarsi o a sommarsi uno sull’altro, ma interagiscono producendo nuove e incomparabili forme di segregazione e di assoggettamento, che si stratificano su vecchi e consumati stereotipi e discriminazioni. A questo riguardo, sui media ha molto circolato la storia di un’afroamericana che non riusciva ad avere il mutuo per acquistare una casa e non si capiva perché, visto che aveva un buon lavoro in una università americana; finché non è apparso chiaro che ciò dipendeva dal quartiere afroamericano in cui abitava e dal suo essere afroamericana (Glantz, Martinez, 2018). In pratica, l’IA acuiva le asimmetrie già esistenti riguardo i singoli gruppi umani a partire dalla loro supposta affidabilità in termini creditizi. Limitando le chance di un futuro migliore si perpetua e “naturalizza” un razzismo esistente e conclamato seppure mai apertamente dichiarato.

Secondo la scienziata esperta in intelligenza artificiale Timnit Gebru e la studiosa di linguistica computazionale Emily Bender un gigante come Google riafferma e ratifica continuamente le disuguaglianze. Ad esempio, il suo programma di riconoscimento facciale è meno accurato nell’identificare le donne e le persone di colore (Hao 2020). Gli algoritmi, concepiti a partire da tecnologie innovative, possono convalidare forme di razzismo istituzionalizzato. Addirittura in uno studio dell’Università del Maryland è stato riscontrato che in alcuni software di riconoscimento facciale le emozioni negative vengono maggiormente attribuite ai neri piuttosto che ai bianchi (Crawford, 2021:197).

Il contesto socio-culturale dell’IA

Lo sviluppo esponenziale dell’IA ha in qualche maniera obbligato a ragionare su determinati aspetti, come quelli per così dire più umani delle machine learning. Gli stereotipi, le forme di discriminazione e di razzismo infatti vengono automaticamente appresi e inseriti nei dataset, ma questi ovviamente erano e sono già presenti in internet e nella realtà quotidiana al di là della IA. Per cui bisogna tornare a monte, appunto. Di cosa si nutre l’IA? Chi costruisce l’intelligenza artificiale? Perché è ovvio che non si tratta di semplicemente di correggere errori una volta che emergono, come il caso dei curricula di Amazon o della Apple card di Goldman Sachs. Le immagini inserite nei dataset basati sulla visione artificiale per il riconoscimento degli oggetti, nel categorizzare i generi si ritrovano a organizzare, etichettare ad esempio foto in cui gli uomini sono spesso stati fotografati outdoor presi in qualche attività sportiva e con oggetti relativi allo sport e le donne prevalentemente in cucina con qualche utensile relativo al cucinare (Wang, A., Liu, A., Zhang, R., Kleiman, A., Kim, L., Zhao, D.,Shirai, I. Narayanan, A. Russakovsky, O., 2021: 9). Questo dato è di per sé rilevante e in qualche modo va analizzato perché i bias sono già incapsulati nel sistema.

Fei-Fei Li, un’esperta di visione artificiale che si occupa anche di debiasing, come ridurre i bias che i dataset tendono ad inglobare, afferma che le conseguenze della attuale situazione sono “dataset non sufficientemente diversificati, compreso quello di ImageNet [a cui la stessa Li ha lavorato, n.d.a.], esacerbate da algoritmi testati male e decisioni discutibili. Quando internet presenta un’immagine prevalentemente bianca, occidentale e spesso maschile della vita quotidiana, ci resta una tecnologia che fatica a dare un senso a tutti gli altri” (Li, 2024: 253). I dataset riflettono anche una concezione del mondo fortemente ancorata a quella di coloro che ci lavorano.

È interessante sapere che, secondo il Guardian, nel team di Sam Altman il 75% dei dipendenti di OpenAI è uomo (Kassova, 2023). E la domanda che inevitabilmente sorge è: quali sono le conseguenze di una IA sviluppata senza la piena partecipazione delle donne, delle minoranze e di Paesi non occidentali? Perché allo stato attuale è ovvio che la loro mancanza di rappresentanza nel settore tech ha come conseguenza che gli algoritmi funzionano male con coloro che non sono bianchi e maschi.

L’IA e il marchio del capitalismo

Le altre domande altrettanto cruciali sono: per chi è fatta l’IA? Chi possiede i dataset e che uso ne fa? E qua ovviamente entra in gioco anche la democrazia sulla trasparenza e l’etica della non discriminazione. Uno degli elementi chiave riguardo i dati è che sono presi senza contesto e senza consenso. Nick Couldry e Ulises Mejias (2022) fanno un interessante parallelismo tra epoca coloniale e società attuale. Se nell’epoca del colonialismo, il potere agiva in maniera estrattiva, ovvero i colonizzatori spoliavano i paesi colonizzati di materie prime preziose e di forza lavoro (tramite lo schiavismo), i corrispettivi contemporanei per profitto estraggono dati senza chiedere il consenso ai legittimi possessori, come nel caso di Midjourney che, come recentemente emerso in una class action promossa da alcuni artisti americani, ha utilizzato le opere di 16.000 artisti senza chiedere il consenso e aggirando il copyright. I maggiori giganti tecnologici sono costantemente e voracemente in cerca di enormi quantità di dati per alimentare e allenare i sistemi di intelligenza artificiale (Metz, C., Kang, C., Frenkel, S., Thompson, S.A., Grant, N., 2024). Internet è stato concepito da coloro che operano nel settore dell’IA come una sorta di risorsa naturale, disponibile da cui si possono estrarre dati a piacimento. Il colonialismo dei dati è un ordine sociale emergente basato su un nuovo tentativo di impadronirsi delle risorse del mondo a beneficio di alcune élite, come era avvenuto in passato con il “classico” colonialismo. C’è una continuità profonda nei metodi di acquisizione, negli atteggiamenti mentali, nelle forme di esclusione e di preservazione del potere. È incredibile come ciò sia a volte incastonato in qualche biografia emblematica: Elon Musk, ad esempio, ha un padre che è stato proprietario di una miniera di smeraldi in Zambia. In famiglia la forma di colonizzazione si è solo evoluta con i tempi e con le tecnologie, ma il marchio è lo stesso.

L’intelligenza artificiale, come un tempo il colonialismo, genera valore in modo iniquo e asimmetrico, impattando negativamente su molte persone, non importa se le definiamo in termini di razza, classe o genere, o tramite l’intersezione di tutte queste categorie.

E renderla più inclusiva non sarà una battaglia facile.

RIFERIMENTI BIBLIOGRAFICI

Crawford, K. (2021), Né intelligente né artificiale: il lato oscuro della IA, Il Mulino, Bologna.

Couldry, N., Mejias, U.A. (2022), il prezzo della connessione: Come i dati colonizzano la nostra vita e se ne appropriano per fare soldi, Il Mulino, Bologna.

Dastin, J. (2018), “Amazon Scraps Secret AI Recruiting Tool That Showed Bias against Women”, in Reuters, October 11.

Glantz, A., Martinez of Reveal, E. (2018), “Kept out: How Banks Block People of Color from Homeownership, APnews, February 15.

Hao, K. (2020), “We Read the Paper That Forced Timnit Gebru Out of Google. Here’s What It Says”, in MIT Technology Review, December 4.

Kassova, L. (2023) “Where are All the ‘Godmothers’ of AI? Women’s Voices are not being Heard”, The Guardian, November 25.

Li, F.F, (2024), Tutti i mondi che vedo, Luiss University Press, Roma.

Metz, C., Kang, C., Frenkel, S., Thompson, S.A., Grant, N. (2024), “How Tech Giants Cuts Corners to Harvest Data for A.I.”, The New York Times, April 6.

Telford, T. (2019), “Apple Card algorithm sparks gender bias allegations against Goldman Sachs”, Washington Post, November 11.

Wang, A., Liu, A., Zhang, R., Kleiman, A., Kim, L., Zhao, D., Shirai, I. Narayanan, A. Russakovsky, O., (2021,“A Tool for Misuring and Mitigating Bias in Visual Dataset”, arXiv: 2004.07999v4 [cs.CV] 23 Jul 2021.

In nome del fanatismo sovrano – Ingegneria sociale e potere delle comunità (seconda parte)

Fanatismo e fandom

Brittany Kaiser che volteggia senza accorgersi di nulla attraverso uffici in cui viene forzato il risultato delle elezioni degli Usa e il referendum sulla Brexit, e i sostenitori di QAnon che credono alle cospirazioni del Deep State, possono corroborare la suggestione che «internet ci renda stupidi», come temeva Nicholas Carr (2011). Senza dubbio una parte delle risorse di comunicazione in Rete conta sulla collaborazione degli utili idioti per attecchire e propagarsi, ma l’esperienza ordinaria dovrebbe insegnarci ad ammettere che le tecnologie digitali hanno avvolto il nostro mondo come se fossero l’involucro di un dispositivo (Floridi, 2014), accrescendo, o almeno trasformando, la maneggevolezza di questo mondo-elettrodomestico. Ciascuno di noi vive il suo QAnon, in compagnia di nicchie più o meno ristrette di amici, che condividono la stessa concezione del mondo. Il problema non è solo la bacheca di Facebook, ma le recensioni di TripAdvisor con cui scegliamo il ristorante e i piatti da assaporare, quelle di Airbnb per selezionare la casa dove fermarsi qualche notte, le foto di Instagram per sapere quale deve essere il nostro stile di vita. La realtà viene letta con i servizi di georeferenziazione disponibili sul cellulare o addirittura sullo smartwatch. Gli algoritmi delle tecnologie indossabili ci rimproverano l’adipe accumulata nel ristorante scelto con TripAdvisor, si allarmano se stiamo camminando troppo, o ci irridono per la stanchezza prematura, ci mettono in competizione con gli amici e con gli sconosciuti (che per caso hanno stessa età, peso e altezza, e probabilmente hanno frequentato le stesse trattorie); quelli del termostato di casa verificano se il nostro consumo di energia è virtuoso o spregevole rispetto ai vicini. Scelgono la musica che ci piace, e persino la fidanzata (o il fidanzato) ideale, prediligendo i rapporti con una data di scadenza ravvicinata: in fondo anche il sesso si consuma, ed è quindi destinato a obsolescenza precoce. In questo contesto, Cambridge Analytica ha commesso l’errore di aver suggerito in Donald Trump il partner sbagliato ad un’intera nazione, per un rapporto della durata di quattro anni – svista giustamente pagata con il fallimento dell’agenzia elettoral-matrimoniale.

Aja Romano (2024) ricorre al termine stan (crasi di stalker fan), con cui si denotano i seguaci delle star della musica pop e di Hollywood, per spiegare il tipo di coinvolgimento che (il team elettorale di) Trump ha generato presso i sostenitori dell’ex presidente, in vista delle elezioni del prossimo novembre. I leader politici sono circondati dalla stessa aura di mito che caratterizza il fanatismo per le celebrità dello spettacolo e dello sport; i sostenitori partecipano dell’identità della comunità con la stessa carica assiologica che solidarizza i tifosi di una squadra o gli ammiratori di una leggenda del rock. La comunicazione con i fan non è mediata dai corpi intermedi delle istituzioni e della stampa, perché tutte le distanze sono abrogate dall’istantaneità della conversazione su X, su Instagram, o su Tiktok. Il ritardo richiesto dalla riflessione e dalla valutazione razionale viene soppresso nell’immediatezza del colloquio, con la sua emotività e la sua visceralità. Huwet (2023) ha chiarito come il fandom di Harry Potter sia diventato il terreno di coltura per alimentare (e finanziare) la setta degli Altruisti Efficaci in America.

L’iscrizione in una comunità, da cui ci si sente osservati e giudicati, rende percepibile per i frequentatori dei social media la pressione delle opinioni e delle valutazioni degli altri in modo diretto. Uno studio condotto nel 2016 con metodologie di Big Data Analysis da Quattrociocchi, Scala e Sunstein, ha mostrato che su Facebook non esistono differenze tra i comportamenti delle comunità di coloro che sono – o si ritengono – competenti su temi scientifici, e dei gruppi che recepiscono, diffondono e amplificano le opinioni cospirazioniste e antiscientifiche. Gli argomenti di cui dibattono sono opposti per segno ideologico, ma la polarizzazione che sospinge ciascuno a identificarsi con la posizione della propria comunità, e a scorgere nelle obiezioni solo un’espressione di disonestà intellettuale o economica, è una e la stessa come la via in su e quella in giù di Eraclito. È possibile distinguere i cluster per la velocità di propagazione dei post e per il numero di bacheche raggiunte, ma non per la resistenza a ogni forma di debunking, volto a dimostrare l’infondatezza delle informazioni condivise dai membri della comunità. Il ricorso alla ragione, con argomenti e prove fattuali, non solo è destinato al fallimento, ma genera un «effetto boomerang» (Hart e Nisbet, 2012) che incrementa la fiducia nei pregiudizi della comunità: il fact checking tende a scatenare una reazione contraria alla sua destinazione, promuovendo la ricerca di conforto da parte dei confratelli sulla validità delle notizie contestate, e intensificando la polarizzazione delle opinioni.

Eco sociale e comunità scientifica pre-print

La social network analysis ha elaborato modelli matematici che misurano l’interazione tra individuo e collettività, e permettono di correlare la chiusura di una rete sociale alla larghezza di banda nella circolazione delle informazioni e alla fiducia che i membri ripongono nella loro validità (oltre a quella che attribuiscono alle persone che le diffondono). Con l’aiuto dell’immaginazione si può intuire che il passaggio delle notizie accelera nelle comunità in cui ognuno conosce ogni altro componente, e che questo movimento vorticoso consegna più volte lo stesso contenuto a ciascun soggetto, recapitandolo da fonti in apparenza indipendenti le une dalle altre. Il turbine dell’informazione suscita una sensazione di urgenza che cresce ad ogni ripresentazione della notizia, impone l’imperativo del suo rilancio, ispira fede nella sua verità.

Lo strumento essenziale delle piattaforme online sono gli algoritmi che identificano i cluster di utenti con interessi simili. La geodetica di una rete è il numero di passaggi che collega i due nodi più distanti compiendo il percorso più breve possibile. Secondo il famoso esperimento di Milgram del 1967 la geodetica dell’intera umanità conterebbe sei gradi di separazione; Facebook conta oltre due miliardi di iscritti, ma secondo uno studio del 2012 la sua geodetica è di soli 3,75 passi. La densità delle relazioni umane è molto più fitta di quanto ci immaginiamo, e la larghezza di banda che misura il potenziale di circolazione delle notizie è ampia in misura direttamente proporzionale.

In questo intrico di connessioni, sono gli algoritmi dei motori di ricerca e dei social media a decidere cosa deve essere letto e da chi: sono quindi i loro pregiudizi a stabilire il grado di perspicacia o di ingenuità degli individui, o almeno a intensificare le loro inclinazioni personali. Sembra la versione moderna della Grazia divina, che secondo Lutero distingue a priori i sommersi e i salvati; ma nell’immanenza della realtà profana, questo è il sintomo della sostituzione della classe sociale che alimentava comitati scientifici e peer reviewer con un nuova struttura di potere, che alimenta la produzione e la certificazione della verità fondandola sul prestigio degli algoritmi, dei big data, e su una diversa divisione del lavoro linguistico, con una nuova distribuzione delle competenze e delle comunità di esperti. Uno studio di West e Bergstrom del 2021 documenta la tendenza anche da parte degli scienziati ad affidarsi a Google Scholar per la ricerca di saggi, e a seguire le segnalazioni dei colleghi sui social media. Ma l’algoritmo del motore tende a premiare i contenuti che ottengono più link e più citazioni, così come le piattaforme di social network incrementano la visibilità dei profili e dei contenuti che ottengono più like e più interazioni. Robert Merton ha battezzato «effetto San Matteo» il risultato di questo comportamento: chi vince piglia tutto. Tra i contenuti vincenti nell’ambito scientifico si trovano anche citazioni scorrette che vengono replicate a oltranza, nonché saggi in versioni pre-print che non hanno mai passato la peer review, o che includono errori in seguito emendati – senza alcun riguardo per le correzioni.

Non so se la crisis discipline debba farsi carico di mettere in salvo la specie dei sostenitori di QAnon dai memi di QAnon, contro la loro stessa volontà; ma di certo serve una nuova interpretazione della realtà che la osservi come il prodotto di un nuovo ecosistema. La tecnologia sovrappone al mondo piani di leggibilità e di utilizzabilità, anzi, li iscrive nel mondo stesso – e non saremo noi, né alcun altro Artù, a poterli estrarre. Se li conosci non li eviti, ma almeno puoi provare a capirli.

BIBLIOGRAFIA

Aubenque, Pierre, Le problème de l’Être chez Aristote. Essai sur la problématique aristotélicienne, PUF, Parigi, 1962.

Austin, John, How to Do Things with Words: The William James Lectures delivered at Harvard University in 1955, Clarendon Press, Oxford 1962.

Backstrom, Lars; Boldi, Paolo; Rosa, Marco; Ugander, Johan; Vigna, Sebastiano, Four degrees of separation, «Proceedings of the 4th Annual ACM Web Science Conference, June 2012», pagg. 33–42

Bak-Coleman, Joseph B.; Alfano, Mark; Barfuss, Wolfram; Bergstrom, Carl T.; Centeno, Miguel A.; Couzin, Iain D.; Donges, Jonathan F.; Galesic, Mirta; Gersick, Andrew S.; Jacquet, Jennifer; Kao, Albert B.; Moran, Rachel E.; Romanczuk, Pawel; Rubenstein, Daniel I.; Tombak, Kaia J.; Van Bavel, Jay J.; Weber, Elke U., Stewardship of global collective behavior, «Proceedings of the National Academy of Sciences», 6 luglio 2021, n.118.

Butcher, Mike, The CEO of Cambridge Analytica plans a book on its methods, and the US election, «TechCrunch», 6 novembre 2017.

Carr, Nicholas, The Shallows. What Internet is Doing to Our Brains, W. W. Norton & Company, New York, 2011.

Floridi, Luciano, The Fourth Revolution. How the Infosphere is Reshaping Human Reality, OUP Oxford, 2014.

Girard, René, Le Bouc émissaire, Grasset, Parigi, 1982.

Hamilton, Isobel Asher, Plans to storm the Capitol were circulating on social media sites, including Facebook, Twitter, and Parler, for days before the siege, «Business Insider», 7 gennaio 2021

Hart, Sol; Nisbet, Erik, Boomerang effects in science communication: How motivated reasoning and identity cues amplify opinion polarization about climate mitigation policies, «Communication Research», vol. 39, n.6, 1° dicembre 2012, pagg. 701-723.

Huet, Ellen, Effective altruism has bigger problems than Sam Bankman-Fried, Financial Review, 17 marzo 2023.

Kaiser, Brittany, Targeted, HarperCollins Publisher, New York 2019.

Merton, Robert, Social Theory and Social Structure,II, New York, The Free Press, 1968.

Milgram, Stanley, The Small-World Problem, in «Psychology Today», vol. 1, no. 1, Maggio 1967, pp. 61-67

Pariser, Eli,The Filter Bubble. What the Internet is Hiding from You, The Penguin Press, New York 2011.

Quattrociocchi, Walter; Scala, Antonio; Sunstein, Cass, Echo Chambers on Facebook, «SSRN», 2795110, 13 giugno 2016.

Romano, Aja, If you want to understand modern politics, you have to understand modern fandom, «Vox», 18 gennaio 2024.

West, Jevin D.; Bergstrom, Carl T., Misinformation in and about science, «Proceedings of the National Academy of Sciences», aprile 2021, vol. 118, n.15.

In nome del fanatismo sovrano - Ingegneria sociale e potere delle comunità (prima parte)

Brittany Kaiser era la business developer di Cambridge Analytica, l’azienda accusata di aver consegnato a Donald Trump la vittoria delle elezioni presidenziali del 2016 ricorrendo a tattiche di microtargeting sui social network. Alexander Nix, il CEO che l'ha assunta nel 2014 e licenziata nel 2018, sostiene in un’intervista a Mike Butcher (2017) che l’agenzia abbia processato dati provenienti da Facebook su 220 milioni di cittadini americani, estraendone le informazioni necessarie per profilare messaggi personalizzati di propaganda pro-Trump. Le confessioni della Kaiser, raccolte nel libro Targeted (2019), si riassumono nell’attante «non capivo, non sapevo, ho solo obbedito agli ordini», e sono considerate tra le rivelazioni più importanti delle «talpe» interne all’agenzia.

Il tema che ha incuriosito la magistratura riguarda il modo in cui Cambridge Analytica ha acquisito e conservato i dati degli utenti del social network. Invece l’aspetto che sfida il talento ermeneutico della Kaiser, e che è interessante esaminare, è la presunta capacità della comunicazione digitale di cambiare le convinzioni delle persone, soprattutto in ambito politico, grazie all'identificazione dei temi cui ciascun individuo è più sensibile, e alla misurazione delle relazioni di influenza tra amici. La «talpa» Kaiser inferisce dalle affermazioni dei colleghi che Cambridge Analytica eseguisse una profilazione psicometrica degli utenti, ed elaborasse messaggi capaci di dirottare le loro scelte elettorali o commerciali in senso opposto a quello spontaneo. I Sofisti facevano qualcosa del genere con l’arte dialettica, ma Platone e Aristotele non si ritenevano delle talpe quando hanno denunciato la loro techne.

Le dichiarazioni di Alexander Nix, riportate nel libro, inducono però a credere che gli obiettivi dell’agenzia fossero diversi, più coerenti con le tesi sull’efficacia dei social media, condivise un po’ da tutti almeno dalla pubblicazione di The Filter Bubble (2011) di Eli Pariser. Gli algoritmi di Facebook, e delle piattaforme simili, tendono a rinchiudere gli individui in una bolla autoreferenziale, popolando le loro bacheche con i post degli amici e con i messaggi pubblicitari che confermano la loro visione del mondo, ed escludendo progressivamente i contributi in disaccordo. Se questa ipotesi è corretta, non si comprende in che modo il social network possa stimolare trasformazioni nella concezione politica delle persone. Alexander Nix spiega che Cambridge Analytica si proponeva di incentivare l’entusiasmo dei sostenitori spontanei del candidato-cliente, trasformandoli da spettatori ad attivisti della sua campagna; al contempo, tentava di raffreddare l’adesione dei cluster di elettori «naturali» degli avversari, demotivando la loro partecipazione alle iniziative di propaganda e disertando i seggi il giorno delle votazioni. Durante la sfida tra Donald Trump e Hillary Clinton, questo schema si è tradotto nella focalizzazione sugli Stati della Rust Belt, l’America nord-occidentale dove il candidato repubblicano ha vinto la corsa alla Casa Bianca, coinvolgendo i lavoratori del settore manifatturiero, spaventati dalla crisi occupazionale, e raffreddando il sostegno all’avversaria da parte delle comunità nere e LGBT.

Le campagne di comunicazione su Facebook sarebbero quindi efficaci nel modificare l’entusiasmo per una convinzione già stabilita, non nel cambiarla. La Kaiser ha una vocazione difficilmente eguagliabile per il travisamento e la distrazione, ma sulla difficoltà di inquadrare i veri effetti dei social media si trova in buona compagnia. Il 6 luglio 2021 la rivista PNAS ha pubblicato un saggio firmato da 17 ricercatori di biologia, ecologia e antropologia, che definiscono lo studio dell’impatto di larga scala delle tecnologie sulla società come una crisis discipline, ovvero come un ambito di indagine paragonabile a quello che viene adottato per salvaguardare alcune specie in via di estinzione, o per prevenire gli effetti peggiori dei cambiamenti climatici. Gli autori denunciano il fatto che le piattaforme digitali innescano processi di gestione del comportamento collettivo, ma mancano conoscenze di dettaglio sui meccanismi che mettono in opera il controllo, e metodi di misurazione della loro efficacia.

Le preoccupazioni dei ricercatori sono collegate a fenomeni di massa come il movimento complottista QAnon, nato nella bacheca del forum 4chan.org e rilanciato sui social media americani. Dall’ottobre 2017 una porzione sempre più ampia di cittadini Usa, di orientamento conservatore, vive in un mondo parallelo, con una storia elaborata da personaggi la cui identità rimane nascosta sotto i nickname di un gioco di ruolo disputato su varie piattaforme online. L’esercizio ludico consiste nella ricerca e nella sovrainterpretazione dei simboli che sarebbero cifrati nelle esternazioni dell’allora presidente Trump, nelle immagini dei politici divulgate dai giornali e dalle televisioni, nelle «soffiate» su presunti documenti segreti della CIA: il senso che viene rintracciato allude ad un conflitto sotterraneo tra le forze del bene e le insidie allestite da poteri forti che manovrano gli esponenti del Partito Democratico, i giornalisti delle testate più autorevoli del mondo, molte celebrità dello spettacolo, al fine di soggiogare il popolo americano e di imporre il dominio dei malvagi sull’intero pianeta. Gli avversari di Trump sono anche accusati di tutte le forme di empietà che René Girard (1982) ha rubricato tra i marchi del capro espiatorio, rintracciandoli in una narrativa culturale molto ampia, dai miti classici fino alle persecuzioni medievali: pedofilia, uccisione di bambini, cannibalismo, commercio con il demonio.

3 Mondi possibili e realtà aumentata

Le notizie che circolano di più e meglio sono una struttura coerente che forma un mondo abitabile, anche quando la sua trama è un cartone animato per bambini come QAnon. I Sofisti non arrivavano fino a questo punto; secondo Aubenque (1962) potrebbero averlo fatto Platone e Aristotele. Esiste un mondo possibile popolato dalle migliaia di persone che sciamano ai raduni di QAnon, dalle centinaia di migliaia che vedono e condividono i post con il suo hashtag, dai milioni che seguono i profili da cui vengono pubblicate le sue dichiarazioni. Per lo più le informazioni circolano sotto forma di memi (come accade ormai ovunque, dentro e fuori le campagne elettorali): post che mostrano un design perfetto per diffondersi senza attriti, non subire modifiche nel corso dei passaggi, sedurre l’immaginario e non pretendere nessuno sforzo di lettura.

La calata barbarica sul Campidoglio del 6 gennaio 2021, che si proponeva di impedire la ratifica da parte del Congresso dell’elezione di Joe Biden, è stata orchestrata da migliaia di account collegati a QAnon su Twitter (Hamilton, 2021); ma già il 4 dicembre 2016 un ventottenne della North Carolina si era pesentato alla pizzeria Comet Pong Pong di Washington per fucilare di persona i Democratici che (nel suo mondo) vi tenevano segregati bambini innocenti. Pizzagate è l’etichetta di un complotto, parallelo a Qanon, che mostra come la realtà online sia da molto tempo debordata fuori dagli schermi dei computer, trasformando i software dei forum dei fandom in hardware, nella realtà aumentata in cui vivono i fan stessi (in questo caso quelli di Trump). Quando John Austin (1962) spiegava «come fare cose con le parole», certo non immaginava che le narrazioni intessute da un gioco di ruolo avrebbero assunto il potere performativo di prescrivere una strage, o che gli storytelling del fandom di un presidente avrebbero ordito un colpo di stato in formato carnevale. In fondo, ogni epoca ha le talpe e le rivoluzioni che si merita: ad Atene sono toccati Platone e Pericle, a noi la Kaiser e lo Sciamano.

Meditate gente, meditate.

Nello specchio dell’Intelligenza Artificiale - The Eye of the Master

Specchi

Con consueta indiscrezione Oscar Wilde rivela che Dorian Gray si è immunizzato dai sintomi dell’invecchiamento e del degrado morale della sua condotta, proiettandone i sintomi su un ritratto che custodisce in soffitta. Solo puntando lo sguardo sul dipinto è possibile scorgere la verità che l’aspetto del personaggio sta mascherando. Cosa vediamo quando fissiamo gli occhi sull’intelligenza artificiale, che in qualche modo abbiamo costruito come un ritratto tecnologico della nostra umanità? Le scienze cognitive e gran parte delle pubblicazioni divulgative affermano che i dispositivi informatici riflettono la forma della nostra mente, anche se ancora in modo parziale e talvolta alterato. Nei computer riverbera la verità dello spirito, anche se ancora solo per speculum et in aenigmate, un po’ come secondo Agostino di Ippona e Paolo di Tarso la nostra esperienza ci permette di scorgere il volto di Dio in uno specchio, non ancora faccia a faccia – con tutte le contraffazioni che ai tempi dell’impero romano le superfici riflettenti praticavano sulle immagini.

Ma è possibile che nell’intelligenza artificiale si mostri quello che il lavoro collettivo della storia della tecnologia vi ha introdotto in fase di progetto e di sviluppo, più che la struttura o le funzioni della mente nella loro presunta universalità e immutabilità. La tesi che Matteo Pasquinelli dimostra in The Eye of the Master rende omaggio all’evidenza che nei dispositivi informatici troviamo quello che ci abbiamo messo più che quello che siamo, in una prospettiva che ha il pregio di muoversi in direzione opposta all’opinione comune, e con una strategia di argomentazione tutt’altro che triviale. I passaggi focali della sua ricostruzione sono due.

Ragazze che contano

Il primo si colloca all’origine della storia dell’informatica, o comunque in uno dei momenti considerati come essenziali per la nascita della disciplina: qui Pasquinelli sfida il presagio di noia dei lettori esperti, soffermandosi sugli studi condotti nella prima metà dell’Ottocento dal matematico Charles Babbage per la realizzazione della «Macchina Differenziale» (ed esponendo me ora allo stesso rischio). Il dispositivo non è mai stato portato a compimento, e si distingue dai computer progettati e costruiti nel Novecento per il fatto che non prevede una distinzione tra hardware e software: la macchina, anche nella sua veste definitiva, sarebbe stata in grado di processare un solo programma – quello del calcolo delle tavole logaritmiche. Babbage ha anche elaborato i piani per una «Macchina Analitica», che avrebbe potuto eseguire una pluralità di compiti diversi, ricorrendo a schede meccaniche paragonabili a quelle utilizzate nei telai Jacquard per l’esecuzione dei ricami. In questo caso però la pianificazione non ha condotto nemmeno al prototipo con azionamento manuale, che invece è stato messo a punto per la Macchina Differenziale.

Il primo progetto è stato sollecitato da esigenze commerciali e militari, ottenendo anche un finanziamento pubblico di 1.500 sterline: le tavole logaritmiche sono essenziali per il tracciamento delle rotte, e sono state quindi uno strumento fondamentale per la solidità dell’impero coloniale costruito dagli inglesi fino dal Settecento. Il procedimento seguito da Babbage, da cui discende la tecnica moderna della programmazione, si fonda sulla nozione di divisione del lavoro divulgata da Adam Smith cinquant’anni prima e approfondita in due direzioni.

La prima è quella della riduzione delle operazioni di calcolo ai passaggi meccanici di cui sono composte. Turing ripete lo stesso esercizio più di un secolo dopo, quando in piena Seconda Guerra Mondiale elabora il modello matematico per decrittare i messaggi in codice della marina tedesca. Computer ai tempi di Babbage, e ancora ai tempi di Turing, non è il nome di una macchina, ma l’etichetta di una professione esercitata per lo più da ragazze, che eseguono lunghe sequenze di calcoli meccanici in cui sono stati segmentati algoritmi predisposti da ingegneri e da matematici, per la misurazione di rotte, di distribuzioni statistiche, ecc. La riduzione di questa varietà di competenze a singoli passaggi automatici permette di organizzarli in una macchina, che quindi non è un oggetto ma la cristallizzazione di una configurazione di relazioni sociali e della divisione del lavoro che la governa.

La seconda direzione proviene dagli studi di Babbage in ambito di management aziendale, e dalla sua conapevolezza che la divisione del lavoro permette di calcolare il costo di ogni fase della produzione, e di abbatterlo attraverso l’assegnazione dei compiti più semplici a personale non qualificato, o a macchine che lo rimpiazzino. Babbage non coincide con l’immagine di apostolo dalla purezza della curiosità scientifica che l’agiografia dipinge da sempre, né è stato una figura isolata nella sua austerità accademica – né la sua invenzione è neutrale da un punto di vista morale e politico. Il computer cristallizza la piramide di competenze e le prestazioni dei matematici, degli ingegneri, delle signorine calcolatrici, riflettendo le gerarchie sociali e le strutture etiche che ne governano la divisione del lavoro: la macchina non è moralmente meno compromessa del ritratto di Dorian Gray.

Autonomia, parzialità e fallibilismo

L’ordinamento gerarchico piramidale della cultura industriale si rispecchia nella tecnica di programmazione inaugurata da Babbage, che implementa una struttura di comando verticale in cui l’ingegnere del software definisce tutte le fasi di elaborazione, e i processi le eseguono in modo automatico. La società contemporanea non può essere controllata nello stesso modo, a causa della complessità delle interazioni, e del livello di distribuzione e di autonomia degli agenti coinvolti. I freelance che lavorano con il coordinamento delle imprese della gig economy, come gli autisti di Uber o i rider di Glovo, i creatori di contenuti che pubblicano sui social media, i webmaster che producono le pagine digitali indicizzate da Google, gli attori e i prodotti del mercato finanziario globale, sono alcune espressioni della mereologia tra organicità e frammentazione locale del mondo contemporaneo. I soggetti che lo abitano dispongono sempre di una conoscenza parziale dell’ambiente in cui operano, e sviluppano una comprensione della realtà che è stimata per congettura, con rappresentazioni che devono essere aggiornate o rivoluzionate sulla base dell’esperienza.

Pur senza approfondire il modo in cui funzionano le intelligenza artificiali costruite con reti neurali, è possibile osservare che, dai primi esperimenti del Perceptron di Frank Rosenblatt nel 1957 alle attuali AI generative trasformative, i principi essenziali rimangono due: ogni unità di calcolo, ogni «neurone», accede ad una quantità di informazione limitata, che può essere persino sbagliata; il software nella sua totalità dispone di una rappresentazione statistica complessiva del fenomeno processato, in cui si bilanciano gli output di ogni «cellula» di calcolo. La natura probabilistica del risultato deriva dall’autonomia delle singole unità di processamento, e dall’adeguamento per tentativi ed errori con cui la macchina interagisce con l’ambiente: se la risposta esterna è negativa, il sistema rimodella la propria configurazione per migliorare l’output. Il secondo passaggio strategico dell’argomentazione di Pasquinelli consiste nella ricostruzione del debito che lega il progetto di Rosenblatt a The Sensory Order (1952) di Friedrich von Hayek. In questo testo l’autore proietta le tesi economiche e sociali del neoliberalismo – di cui è uno dei padri fondatori, insieme a von Mises e a Schumpeter – sul dominio della psicologia connessionista: il modello di apprendimento fondato sui principi di collegamento in rete dei neuroni corrisponde all’autonomia degli individui economici come agenti dotati di conoscenza limitata del mercato, e del sistema sociale come equilibrio tra le rappresentazioni probabilistiche e congetturali dei soggetti. L’assunto di una conoscenza completa delle necessità e delle transazioni sociali non è reputato solo impossibile, ma condannato come moralmente deprecabile. Il ritratto insegna a Dorian Gray non solo cos’è diventato, ma anche che è giusto che sia così.

Pasquinelli riprende il metodo e l’orientamento della scuola del Max Planck Institute di Berlino, con la capacità di rendere perspicuo il radicamento dei paradigmi tecnologici e di quelli scientifici nelle condizioni politiche e sociali in cui hanno visto la luce. Sarebbe stato interessante un approfondimento del modo in cui l’intelligenza artificiale di ultima generazione sta riplasmando l’ambiente materiale in cui è attiva, e la società che la circonda. Se c’è qualcosa di vero nel fatto che nella tecnologia possiamo osservare anche ciò che siamo, oltre a quello che ci abbiamo messo, è perché noi stessi siamo rimodellati dagli artefatti che produciamo: nella tecnica ritrattiamo in continuazione ciò che l’essenza della nostra umanità è stata per i nostri predecessori: eroismo aristocratico, telescopio eidetico, anima immortale, monade rappresentativa, macchina a stati finiti, rete connettiva. E ora?

Conversazioni sull’I.A. – Corpo e diritto all'integrità

Redazione di Controversie: Riprendiamo il dialogo con Riccardo Boffetti e Paolo Bottazzini sulla soggettività delle intelligenze artificiali, là dove l’abbiamo lasciato il 16 gennaio (Conversazioni sull’Intelligenza Artificiale – Si prova qualcosa ad essere una macchina?), con la domanda che era rimasta in sospeso.

Per riconoscere ad una IA generativa come, ad esempio, Chat GPT, il diritto all’integrità è obbligatorio che sia incorporata in un robot?

Le altre istanze, quelle esclusivamente dialoganti che troviamo sul web, non hanno diritto a questo riconoscimento?

Riccardo: La risposta a questa domanda credo sia sì, per una serie di motivazioni. Credo, innanzitutto, che buona parte della questione si risolva nel fatto che il modo con cui agiamo nel mondo non può che essere antropocentrico e situato, appunto, nel mondo: non siamo (ancora?) degli esseri digitali, piuttosto siamo (ancora) esseri nel mondo. La scala temporale con cui esperiamo ogni situazione è difatti ben definita dalle nostre esperienze terrene e, accantonando per un attimo la velocità dell’immaginazione, questa si esprime in tempi ben più lunghi di quelli dell’elaborazione digitale odierna.

Ciò di cui abbiamo bisogno per poter anche solo concettualmente prendere in considerazione un’inclusione all’interno della sfera della legge di nuovi soggetti è appunto che essi agiscano su una scala temporale a noi comune o che, quantomeno, e in quanto collettivo, si sia in grado di concepire il dispiegarsi delle loro azioni.

Motivo per il quale abbiamo difficoltà sia nel concepire la questione del riscaldamento climatico sia nel prendere atto dell’agentività delle miriadi di specie vegetali e fungine.

Ecco, allora, che l’instanziazione, l’incorporazione, all’interno di un robot, possibilmente non umanoide, può creare quell’orizzonte comune necessario per la costruzione di un collettivo. È proprio il suo agire nel mondo che rende passibile l’hardware e il software di una rappresentazione giuridica: attenzione, non l’hardware e il software di per loro ma ciò che il resto dei partecipanti al collettivo (e cioè gli umani) vedono e possono interpretare come azioni simili alle loro.

Certo, ci rimane sempre l’immaginazione per concepire le esistenze di algoritmi non incorporati in robot. Alexander Laumonier lo fa bene in una sua ricostruzione del mercato dell’HFT (High-Frequency Trading), dove i famosi pit fisici del Chicago Board of Trade sono diventati deserti a favore di un gran movimento nella sfera digitale:

Gli squali allora potranno divertirsi come pazzi. «Che cos’è questa cosa?», domanderà il nipote di un ricco pensionato americano quando uno yacht incrocerà un’isola artificiale zeppa di tecnologia ultramoderna. «È la Borsa», risponderà il nonno, magari un attimo prima che un algoritmo selvaggio riduca a zero la sua pensione.

Probabilmente non potrò mai lavorare su una di queste isole galleggianti. Da qui ad allora gli algoritmi saranno diventati talmente complessi che io sarò ormai solo un vecchio dinosauro.

Per il momento mi accontento di fare il mio lavoro. Sono già le 9.30, e il New York Stock Exchange sta aprendo.

La quiete del mio ufficio climatizzato contrasta con la guerriglia alla quale dovrò prendere parte tutto il giorno, in compagnia di Iceberg, Shark, Blast, Razor e tutti gli altri.

Devo essere vigile, perché probabilmente dovrò sparare un colpo già alle 09:30:00:000:001, GMT-5.

Conto con attenzione i secondi che mi separano dall’apertura dei mercati, poi i millisecondi, i microsecondi, i nanosecondi, sei, cinque, quattro, tre, due, uno, bingo» (6 | 5, 2018).

Come inquadrare, però, nella sfera del diritto simili entità? È chiaro il luogo in cui, e su cui, il diritto può agire è tutto l’ecosistema macchina-macchina che viene a crearsi ad essere , piuttosto che l’integrità dei singoli algoritmi. Quando si parla, però, di agenti autonomi nella sfera terrena mi pare che l’argomento diventi meno controverso da affrontare, proprio in luce del fatto che la loro individuazioni ci appare chiaramente davanti a tutti i nostri sensi.

Paolo: Quando la domanda è stata formulata, mi sarei aspettato da Riccardo una replica coerente con il suo antisciovinismo antropologico: i diritti vanno estesi alle intelligenze non umane, anzi non biologiche, quindi a tutte le intelligenze in generale.

Invece, la sua risposta distingue tra intelligenze veicolate da hardware zoomorfi e intelligenze che agiscono senza essere semoventi. Le sue argomentazioni sono in ogni caso sensate e condivisibili, quindi mi limiterei a osservazioni laterali.

La posizione di Riccardo è condivisibile se si accoglie la prospettiva fenomenologica di Merleau Ponty (1945, Fenomenologia della percezione): l’intelligenza non è solo una questione di calcolo logico, ma è, anzitutto, la regola dell’azione di chi frequenta il mondo come un’esplorazione precategoriale di orizzonti di senso. Mondo e corpo proprio cospirano a formare questo cosmo di significati, prima di qualunque operazione costitutiva dello spirito, e prima che l’universo si presenti già cristallizzato in oggetti. In questi termini, il possesso di un corpo è un attributo necessario non solo per l’intelligenza umana, ma per l’intelligenza in generale. Purtroppo, però, al momento, le intelligenze attive nei robot non contano sul loro hardware nel modo in cui gli uomini ineriscono al mondo con il loro corpo. Il software infatti compie calcoli in tutte le dimensioni che la fenomenologia assegna all’intenzionalità fungente: la conversione dell’AI alla lebenswelt è al limite una prospettiva, o un ottativo, rivolto all’evoluzione futura.

È possibile, poi, che un aspetto zoomorfo renda più incline il pubblico umano a riconoscere un diritto di inviolabilità alle macchine: da un punto di vista psicologico, la percezione di qualche affinità potrebbe aggiungere commozione all’istanza normativa. A questo proposito però un sociologo ispirato ai principi dell’ANT, come Bruno Latour (2005, Riassemblare il sociale), osserverebbe che robot e intelligenze artificiali sono già iscritte in reti di pratiche, di domini di significato, di associazioni, in cui il riconoscimento di un nuovo diritto irromperebbe come una detonazione, o l’invasione di un corpo alieno. L’esame del modo in cui le diverse forme di intelligenza artificiale e di meccatronica collaborano a formare i gruppi sociali dell’industria, della ricerca accademica, dell’hacking, ecc., dovrebbe precedere l’elaborazione di una normativa che regoli la convivenza dei robot con gli altri attori sociali. Ma si tratta di un tema ampio che dovrà essere ripreso.

Redazione: Grazie a entrambi una volta di più. Il tema, suggerito da Riccardo, dell’incorporazione dell’intelligenza artificiale nella dimensione temporale apre un terreno di confronto assolutamente nuovo per questa questione; la riflessione di Paolo - che richiama Merleau-Ponty sulla necessità dell’intelligenza di “contare sul proprio corpo” sembra rinforzare e mettere a terra l’ipotesi di Riccardo.

Ma cosa ne pensa chi l’Intelligenza Artificiale la vede anche nella sua dimensione operativa, pratica? Nella prossima conversazione partiremo da alcune riflessioni di Alessio Panella che sottolinea il necessario dubbio sull’autocoscienza di macchine senza corpo.

Immagine analogica ed Intelligenza Artificiale - Due mondi apparentemente distanti

Questo post nasce dal seminario tenuto da Diego Randazzo, artista visivo, sul tema “Immagine analogica ed Intelligenza Artificiale. Due mondi apparentemente distanti”.

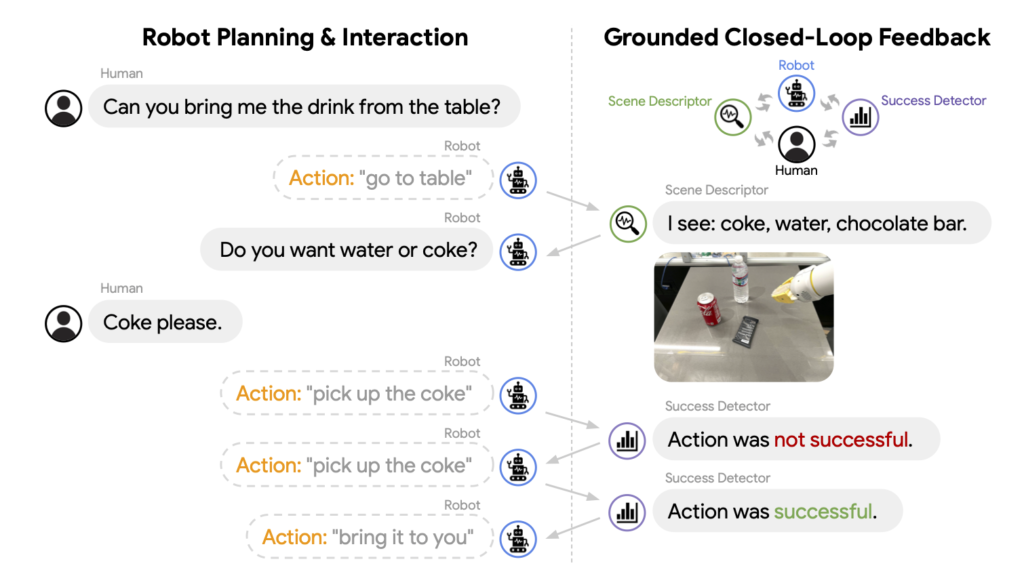

Randazzo ha illustrato alcune funzionalità dei sistemi dialogativi di Intelligenza Artificiale text-to-image come, ad esempio Dall-E o Midjourney, nella generazione di immagini partendo da altre immagini o da una serie di specifiche dettate su una linea di comando.

Queste peculiari funzionalità della IA generativa permettono ad un artista di far generare ai sistemi delle immagini su cui poi intervenire per creare lavori del tutto personali. Oppure, dà la possibilità di generare anche immagini ibride, come, a titolo di esempio, quella di una tavolata che meticci l’Ultima cena di Leonardo da Vinci e le tavole da pranzo di Vanessa Beecroft.

Questi di seguito sono esempi generati in tempo reale durante il seminario:

Comando:

Ultima cena di Leonardo, tavola da pranzo Vanessa Beecroft

Comando:

Ultima cena di Leonardo e Les Demoiselles D'Avignon di Picasso

Comando:

Un Pollock ed un Mondrian

La narrazione e gli esempi hanno suscitato una serie di interrogativi sulle nozioni caratteristiche del discorso artistico, in termini epistemologici e filosofici, interrogativi a cui Randazzo risponde in questo articolo.

--------

Paolo Bottazzini: La possibilità di derivare da regole statistiche un'istanza visiva o sonora, la rende un'opera d'arte o un modello possibile per un'opera d’arte?

Diego: Io parlo spesso di reference, di approccio critico e di didattica. Questi fanno parte dell’opera d’arte, ma sono solo alcuni degli elementi che dovrebbero scaturire da un’opera d’arte.

Parallelamente si può tranquillamente dichiarare, che la generazione di un’immagine con l’AI è l’inizio di un processo che può portare alla creazione di un’opera, ma non è esaustivo.

E penso - scusate la provocazione - che questo discorso valga per tutti quegli strumenti che nel corso della storia sono stati designati come strumenti a disposizione dell’artista: matita, pennello, sgorbia, scalpello, macchina fotografica, cinepresa, videocamera, computer.

Infine, le regole statistiche a cui accennate, non possono essere controllate dall’utente che, forzatamente, si deve accontentare dei risultati ricevuti. Questo mi ricorda un po’ il gioco di matrice surrealista denominato Cadaveri squisiti (cadavre exquis), a mio parere contributo fondamentale alla definizione di collage. Non stiamo in fondo parlando di questo? Associazioni e combinazioni testuali e visive, spesso incontrollate e provenienti da fonti diverse.

Quindi la descrizione che suggerite mi sembra appropriata, aggiungendo un trattino: l’AI come modello-strumento possibile per creare un'opera d’arte. Ci sono diverse modalità di utilizzo dell’AI per creare immagini; tra tutte credo sia molto affascinante la funzione che permette di espandere un ‘immagine preesistente, caricata nel software di AI.

Il ‘riempimento generativo’, lo considero una sorta di strumento conoscitivo, che a partire da qualcosa di personale (es. un’immagine dell’autore) permette di amplificare ed espandere l’universo visivo dell’autore stesso.

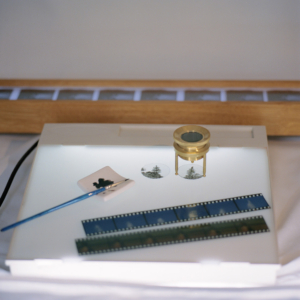

Riporto qui di seguito uno dei primi esperimenti realizzati con Dall-E a partire da alcune fotografie realizzate in pellicola medio formato (estratte del mio progetto Illusorie visioni d’argento del 2018). La prima immagine è lo scatto originale, le successive sono le espansioni generate con l’AI. E’ evidente come il rapporto che si instaura tra originale e rielaborazione AI è molto significativo, c’è una forte connessione tra due mondi che tendenzialmente teniamo separati. Qui, la concretezza del manufatto analogico e l’intangibilità dell’immagine sintetica si toccano e diventano un tutt’uno.

Lenti d’ingrandimento in ottone, becher, pellicole di piccolo e medio formato, macchine fotografiche analogiche… a questi oggetti/soggetti provenienti dal mondo proto-fotografico sono accostati altri della natura più varia (frutta e verdura imprecisata, gelatina alla menta, piante, droni, congegni elettrici, elettronici, digitali ed immagini olografiche) disposti su improbabili limbi e tavoli da lavoro componendo un eterogeneo repertorio di composizioni panoramiche. Ad una prima occhiata ci paiono dei set fotografici che strizzano l’occhio all’ambito still-life, ma avvicinando lo sguardo qualcosa non funziona. Il progetto "Elegie dell'impossibile verosimile" è un’inedita opera meta-fotografica, non ancora pubblicata, che esplora la relazione tra mondo analogico e digitale. Ogni composizione è creata a partire da uno scatto in medio-formato e successivamente combinata con altre immagini generate con il software di intelligenza artificiale Dall-E 2, che analizza un testo descrittivo e genera immagini corrispondenti. Il lavoro sperimentale affronta il tema dell'autenticità delle immagini nella contemporaneità, considerando la macchina come una possibilità di estensione poetica dell'immaginario dell’artista.

Di seguito, alcune immagini tratte da Illusorie visioni d’argento (2018), dove la prima immagine è lo scatto originale, eseguito con pellicola fotografica di medio formato, e la seconda è l'espansione dell’immagine realizzata con Dall-E.

Non a caso, nel corso del seminario di Controversie, puntavo proprio a delineare un percorso di analisi che intravede nell’immagine analogica l’antecedente concettuale della funzione generativa nell’AI.

Il mio punto di vista, sicuramente non allineato alle maggiori correnti di pensiero sul fenomeno, vuole dimostrare che alcune tendenze visuali attuali dell’AI (la dimensione distopica, disturbante, deformante da una parte e la tendenza del vintage dall’altra) non solo sono vicine, ma sono in perfetta continuità con il mondo analogico e protofotografico.

Ecco alcune linee guida, per punti, che sono state oggetto di discussione durante il seminario:

L’immagine analogica ed un certo uso dell’Intelligenza Artificiale hanno in comune la sorpresa, il mistero e la casualità. Sorpresa e mistero erano già presenti nei congegni del Precinema (le vedute ottiche dei Mondi Nuovi, vetrini e lanterne magiche, fenachistoscopi, zootropi, mutoscopi e diorami).

La sorpresa negli occhi dello spettatore ottocentesco di fronte ai congegni del Precinema (molti di questi basati sulla persistenza retinica) in qualche modo è simile a quella del pubblico di oggi davanti ad un’immagine elaborata con l’AI; stiamo parlando di quello spaesamento prodotto da qualcosa di nuovo che non riusciamo a cogliere completamente, ma che ci affascina e ci rapisce.

La casualità e l’attesa: non è possibile conoscere a priori il risultato di un’elaborazione di immagine fatta con l’AI, come non è possibile conoscere istantaneamente il risultato di uno scatto analogico. Bisogna scontrarsi con l’attesa, la perizia e la pazienza. Di fronte ad un’interrogazione posta ad un software di AI non abbiamo ancora un controllo totale sul risultato, dobbiamo affidarci al mix di combinazioni proposte dall’algoritmo.

SORPRESA: Da un’interrogazione non sappiamo cosa aspettarci, e molto spesso il risultato che ci viene restituito è sorprendente (sia in termini negativi che positivi).

ATTESA: La risposta dell’AI non è istantanea. L’attesa contribuisce a creare mistero e aspettativa.

CASUALITÀ E UNICITÀ’: un mix di combinazioni algoritmiche formula un risultato che è sempre unico. A parità di richieste, se ripetiamo più volte la stessa interrogazione, il risultato sarà sempre diverso.

Nell’AI si possono notare alcuni filoni narrativi e formali:

-

- contenuti surreali, distopici ed iperrealisti (il loro successo si basa sull’effetto wow)

- riproposizione formale del ‘vintage’: la grana della pellicola, certo utilizzo del bianco e nero oppure l’uso di filtri che richiamano specifiche pellicole fotografiche; ma in realtà questo recupero dei codici visivi del mondo analogico era già presente sin dagli albori di Instagram (il formato quadrato 6x6, l’uso delle cornici con perforazioni tipiche della pellicola e dei filtri ecc.)

Questo secondo filone è senza dubbio il più interessante e meno omologato del primo, perché si origina da un sentimento comune che possiamo chiamare nostalgia. Con due discriminanti:

i giovanissimi utilizzano questi codici in maniera inconsapevole, per inseguire la tendenza del momento. Nel nostro caso la tendenza del vintage. (filtri, cornici fotografiche, oggetti d’epoca o moderni, tecnologie obsolescenti)

I meno giovani, gli studiosi, gli appassionati, vivono questa nostalgia per una tecnologia artigianale, che basa il suo funzionamento sui meccanismi interni presenti nelle macchine: ’‘Il come è fatto’’. Si tratta di tecnologie (es. macchine fotografiche analogiche) che nella loro intrinseca ideazione e costruzione permettevano un utilizzo consapevole. Banalmente, per inserire la pellicola nella macchina analogica bisogna aprirla. Questo aspetto tecnico si inseriva in un processo di consapevolezza tecnologica e didattica, che i successivi sviluppi del digitale hanno progressivamente oscurato. Pensiamo a tutte le apparecchiature digitali che non ci permettono di essere esplorate al loro interno.

Per approfondimenti leggi qui: http://www.diegorandazzo.com/portfolio/immagini-simili-primo-studio/

Redazione di Controversie: Diego, secondo te, dove va a finire l'autorialità, quando l'opera è generata da un sistema informatico intelligente? chi è l'autore? chi ha "chiesto" un'immagine generata secondo alcuni criteri o caratteri, oppure la macchina stessa?

Diego: È una compartecipazione di attività tecniche e di pensiero, ma la firma deve essere necessariamente quella dell’artista. Autore è chi interroga e, soprattutto, rielabora e reinterpreta secondo la propria attitudine il risultato dell’Intelligenza artificiale. La macchina fa le veci del ricercatore: mette insieme e fonde tantissimi dati e, in ultima istanza, restituisce un ‘abstract grezzo’. Quell’abstract non può rimanere tale. Deve essere decostruito e manipolato dall’artista per assurgere ad opera d’arte. L’AI, come processo generativo, è quella cosa che sta in mezzo, tra il pensiero, l’idea iniziale e l’opera finale. Tutto qui. Non è semplificazione, è come dovrebbe essere inteso il ruolo dell’intelligenza artificiale nella creazione.

Il termine manipolazione, che ho appena usato, non è casuale. Innanzitutto, mi sta a cuore, perché ogni mio lavoro, che si origini da una fonte personale o da un’immagine pescata sul web, è soggetto, da sempre, ad una stratificazione di gesti ed elaborazioni, con conseguenti risemantizzazioni della sorgente iniziale, tanto da diventare una parte della mia cifra stilistica. Inoltre, manipolare si rifà proprio a quella manualità, che per me è anche ‘manualità nel pensare’, fondamentale per una trascrizione unica ed originale del processo creativo.

Il lavoro di elaborazione dell’AI implica una fusione di elementi eterogenei. Perciò nei risultati ottenuti prende forma una commistione di stili e soggetti diversi, tutti fusi assieme, tanto da creare delle aberrazioni inusuali nelle immagini. Questo processo di fusione, che spesso dà luogo ad una spaccatura di senso con l’interrogazione dell’utente, l’intelligenza artificiale lo gestisce molto bene. E l’aspetto forse più interessante è che l’algoritmo non rivela mai le sue fonti (il grande database da cui attinge), rimane misterioso a differenza degli artisti che, con un pizzico di orgoglio, snocciolano le proprie reference, le motivazioni ed i maestri ispiratori.

Siamo meno bravi nel farlo (fondere fonti diverse per creare qualcosa di nuovo) perché puntualmente inciampiamo nel facile citazionismo. E questo spesso ci riduce a degli abili saccheggiatori di pensieri ed immagini.

Forse demandare la ricerca delle proprie reference all’AI e affidarsi, in qualche modo, alla vertigine del caso, senza che il nostro ego si manifesti prepotentemente, può essere la nuova sfida della ricerca contemporanea. Mantenendo però fede alle premesse iniziali: quell’abstract fornito dall’AI non costituirà mai l’opera definitiva, bensì l’inizio di un processo dialettico.

Redazione di Controversie: Esistono ancora il concetto di unicità e di originalità di un'opera, quando il lavoro viene fatto "a macchina”?

Diego: Riprendendo in parte la prima risposta, non vedo ancora un pericolo per l’unicità dell’opera d’arte. Se, l’avvento del digitale (dalla fotografia digitale alle immagini virtuali) non ha messo in crisi questo principio non credo che sarà l’AI a metterlo in discussione. L’autorialità, se c’è e sappiamo riconoscerla, emergerà sempre sui cloni, sulle copie, sull’omologato. Ci vengono dati quotidianamente gli indizi per farlo e come nel caos dell’infodemia, bisogna aguzzare un po’ la vista per riconoscere il vero dalla finzione. Il nocciolo della questione secondo me è proprio questo: vogliamo veramente conoscere la verità? O forse preferiamo farci confondere da qualcosa che sembra apparentemente più attraente e coinvolgente? Bisogna sforzarsi, per carpire la verità, c’è poco da fare.

Non vorrei sembrare ripetitivo, ma ci tengo a sottolineare un concetto a mio parere fondamentale: la creazione di un’opera attraverso l’AI non può fermarsi al primo risultato ottenuto con un’interrogazione ad un’app. In concreto, stampare un’immagine realizzata con l’Ai ed esporla così com’è non la considero un’operazione artistica, a meno che non ci sia una dichiarata provocazione concettuale nel farlo (e nel caso andrebbe comunque motivata). L’AI è uno strumento, e come il pennello o la macchina fotografica, deve essere sottoposto ad uno sforzo di pensiero critico e di tecniche che lo rendano non solo utile, ma significativo per l’essere umano.

Una cosa interessante, che è anche il motivo fondante ed il filo conduttore del mio seminario: i risultati dell’AI non sono mai ripetibili… perciò i miei studi sul fenomeno mi hanno portato ad equipararlo al mondo dell’immagine analogica. Si tratta, infatti, di un mix di combinazioni algoritmiche che formula sempre un risultato unico. A parità di richieste - se ripetiamo più volte la stessa interrogazione - il risultato sarà sempre diverso. Quindi, se vogliamo, l’unicità dei risultati è un aspetto che ancora di più avvicina il mondo dell’AI a quello analogico e al concetto classico di Manufatto.

DISPOSITIVI / 3

15X16X3 cm,

bassorilievo in Gres, pellicola Instax wide,

elaborazione con Ai, 2023

Courtesy Galleria ADD-art e l’artista

Opera in mostra da Indigo Art Gallery a Perugia fino al 17 febbraio 2024

DISPOSITIVI / 3, dettaglio

Ovviamente il tema dell’unicità è molto ampio, profondo e stratificato, ma se ci soffermiamo sul mero aspetto tecnico, non si può non affermare che l’AI, ad oggi,

produca sempre dei risultati diversi a parità di domande.

E questo è un fatto abbastanza dirimente, soprattutto se lo inseriamo nel solco della produzione artistica.

Un nuovo francescano? - Paolo Benanti e la commissione algoritmi

Il professore Paolo Benanti è stato nominato Presidente della Commissione sull’Intelligenza Artificiale per l’Informazione e l’Editoria della Presidenza del Consiglio.

La Commissione è un organo del Dipartimento per l’Informazione e l’Editoria istituito dalla Presidenza del Consiglio poco più di due mesi fa, con lo scopo di analizzare le implicazioni dell’Intelligenza Artificiale nel campo dell’editoria e dell’informazione e, di conseguenza, consigliare il Dipartimento che ne è responsabile. La commissione è stata presieduta - dalla fondazione sino alle sue dimissioni - dal professor Giuliano Amato, politico, giurista, docente universitario e manager pubblico.

La nomina di Giuliano Amato aveva sorpreso molti; l’assegnazione della presidenza a Paolo Benanti forse anche di più.

Paolo Benanti ha un curriculum eccellente e si può dire - senza timore di smentita - che è uno dei massimi esperti mondiali di Intelligenza Artificiale; è un frate Francescano del Terzo Ordine Regolare, teologo, eticista, docente presso la Pontificia Università Gregoriana, consigliere di Papa Francesco per l’Intelligenza Artificiale, membro della Pontificia Accademia per la Vita con mandato sulla Intelligenza Artificiale, membro del New Artificial Intelligence Advisory Board dell' ONU, autore di libri sul ruolo dell'umano nella civiltà tecno-umana.

Ovunque si parli del profilo etico delle tecnologie e del ruolo della Intelligenza Artificiale nella vita dell'uomo, la presenza di Benanti è pertinente. È, tra l'altro, colui che ha coniato il termine Algoretica, cioè l'etica degli algoritmi. Da anni infatti si interroga e fa riflettere su come la tecnologia sia passata dallo status di strumento in mano all'uomo a quello di parte integrante dell'ecosistema sociale, e sempre più influente su questo ecosistema.

È sicuramente apprezzabile che Benanti abbia accettato di esporsi nel ruolo di Presidente della commissione: qualsiasi linea guida ne uscirà sarà certamente pertinente e di alto profilo. Paolo Benanti ama poi scherzare sul ruolo degli eticisti, come lui: gli eticisti fanno le domande e si tengono alla larga dalle risposte. Nel campo dell'etica le giuste domande sono infatti la cosa più importante, quelle che dovrebbero influenzare politici e stakeholders affinché affrontino i temi davvero rilevanti.

La domanda centrale posta dal lavoro di Paolo Benanti si può riassumere in questa: le macchine devono avere un'etica? Quale? Quali limiti ci sono e devono esserci nel rapporto tra la nuova specie delle macchine intelligenti e l'essere umano?

Gli eticisti non scendono in campo per dire cosa non si può fare o, peggio, pontificare su giusto e sbagliato, dice Benanti; il loro ruolo fondamentale su temi delicati e pervasivi della vita collettiva - com'è e come sarà sempre più l’Intelligenza Artificiale - deve essere appunto quello di porre le giuste domande, per far sì che le persone e le istituzioni ricerchino le risposte più adatte al contesto in cui operano. In questo il professor Paolo Benanti non potrà che essere eccellente: le persone, l'essere umano - in particolare nel loro rapporto con la tecnologia - sono sempre state al centro della sua attenzione.

Una volta tanto possiamo dire che in Italia abbiamo messo la persona giusta al posto giusto.

Conversazioni sull’Intelligenza Artificiale – Si prova qualcosa ad essere una macchina?

Redazione: Riccardo, in questo tuo post hai condensato almeno tre punti molto rilevanti per la discussione sull’Intelligenza Artificiale e sulle macchine che agiscono guidate da sistemi intelligenti:

- il primo – sulla bocca di tutti in questi giorni – è quello della trasparenza,

- il secondo è quello della responsabilità di questi agenti in qualche modo autonomi, di cui abbiamo già scritto più volte nel blog, e che coinvolge un’intera filiera di soggetti

- e il terzo è quello della soggettività degli automi.

È evidente che gli elementi più innovativi che stai introducendo in questo discorso sono:

1) quello che chiami “monologo interiore”, intimamente correlato al tema della trasparenza, e

2) la domanda, per me assolutamente inattesa, “ma sta succedendo qualcosa là dentro?”, che suggerisce di non trascurare la possibilità di una reale soggettività dell’automa.

Ritieni quindi che “monologo interiore”, “interiorità”, “soggettività” possano essere caratteri attribuibili ad un robot?

Riccardo: Per rispondere a questa domanda provo a definire chiaramente questi termini, perché spesso il guaio è che parlando di questi temi si utilizzano dei termini resi così laschi dagli anni di dibattiti che ognuno finisce un po’ per tirarseli dalla propria parte, con il risultato che tutti hanno ragione perché stanno parlando da soli.

E allora: il “monologo interiore” è l’idea di applicare ad un soggetto che si muove nello spazio (ad un robot nel nostro caso) un modo, uno spazio di lavoro, per connotare il proprio ambiente; e grazie a questo processo di continuo aggiornamento del proprio mondo, poter agire sempre più efficacemente sullo stesso.

Bene: su questo punto, a livello funzionale - ritengo che sia il caso di evitare un’analisi filogenetica - per me sia difficile trovare grosse differenze rispetto a ciò che una persona fa. Per quanto riguarda l’“interiorità”, definita come lo spazio in cui quel monologo interiore accade, mi pare chiaro che sia una condizione necessaria per l’esistenza di un monologo, avendo appunto un’azione bisogno di un luogo in cui svolgersi.

La “soggettività” è invece la dimensione più scivolosa. Però possiamo intenderla come il fantomatico “provare qualcosa ad essere (un soggetto)”.

Ecco, credo che questa dimensione soggettiva possa essere accessibile solo tramite due tratti essenziali: un qualche tipo di auto-narrazione e una fiducia nei confronti di quella narrazione e di quel narratore. A conti fatti ognuno di noi ha accesso soggettivamente solo alla propria soggettività e quella degli altri se la può, al massimo e ragionevolmente, immaginare.