Ora sono diventato Morte, il distruttore di mondi – L’inevitabile dimensione politica della scienza

PRECISAZIONI

Precisazione numero uno: la famosa frase “Now I am become death, the destroyer of worlds” non è stata coniata da Oppenheimer ma è presa dal testo Hindu Bhagavad-Gita, in un passo in cui Arjuna prega Krishna, incarnazione della divinità Vishnu, di rivelare la sua forma divina, “armata di molte armi”; quando Krishna-Vishnu si mostra a Arjuna, attribuisce a se stesso il modo d’essere di Kalah, divinità della morte[1].

Precisazione numero due: Robert Oppenheimer dichiarò – in una intervista del 1965 - di aver pensato a quel passo del Bhagavad-Gita il 16 luglio 1945, nel momento in cui vide la luce abbagliante e il fungo della prima esplosione atomica di test levarsi in cielo. Nel testo Hindu Arjuna paragona lo sfolgorio di Vishnu a “migliaia e migliaia di soli [che] sorgessero insieme nel cielo”.

Precisazione numero tre: quando Oppenheimer si attribuisce questo pensiero - nel 1965 - la parabola delle sue considerazioni morali sulla bomba – sulle bombe, compresa quella a idrogeno – ha compiuto il suo ampio arco e si è fermata in una posizione decisamente anti-militarista e contraria alla corsa agli armamenti nucleari.

CHI ERA ROBERT OPPENHEIMER? PERCHÉ NE PARLIAMO OGGI?

Julius Robert Oppenheimer nasce a New York nel 1904 e, dal 1922 (a 18 anni!) studia fisica a Harvard con P. W. Bridgman; a Cambridge, con E. Rutherford e J. Thomson; a Gottingen, con Max Born, suo supervisore di dottorato, dove conobbe e studiò con Heisenberg, Jordan, Dirac, Fermi e Teller; a Leiden con P. Ehrenfest; a Zurigo, con W. Pauli. Dal 1929 fu di nuovo negli Stati Uniti, alla Berkeley e al Caltech.

La sua attività scientifica fino al 1942 è proteiforme e lascia segni importanti sia sul versante teorico che su quello sperimentale della teoria quantistica e di alcuni aspetti dell’astrofisica. Pare che abbia la capacità di vedere i nessi tra lavoro sperimentale e lavoro teorico[2] e generare nuove idee per sviluppare teoria e applicazioni.

Nel 1942 – nonostante il suo vissuto politico di iscritto al Partito Comunista – il governo statunitense gli affida la direzione del Progetto Manhattan, con l’obiettivo dichiarato di realizzare la prima bomba a fissione nucleare.

Il progetto – guidato da Oppenheimer e che vedeva coinvolti i più importanti fisici di quei tempi - portò alla costruzione del primo ordigno di test – il gadget – fatto esplodere il 16 luglio 1945 nel deserto del New Mexico.

Poco meno di 15 giorni dopo, due bombe vere realizzate dal Progetto Manhattan e chiamate Little Boy e Fat Man distrussero le città giapponesi di Hiroshima e Nagasaki, uccidendo istantaneamente più di 200.000 persone e ferendone gravemente altrettante, con effetti sulla salute di moltissimi altri, che ancora vengono curati dalla sanità giapponese.

Questi tre eventi segnarono il termine della Seconda guerra mondiale e l’inizio dell’escalation degli armamenti nucleari in molte nazioni, armamenti che ancora oggi vengono irresponsabilmente sventolati come minaccia distruttiva e con atteggiamento di sfida in alcuni conflitti locali.

Parliamo di Robert Oppenheimer perché è l’uomo che ha organizzato e, con caparbia e genio, gestito il Progetto Manhattan.

Ne parliamo proprio ora perché nacque centoventi anni fa, il 22 aprile, e perché il film di Christopher Nolan, che ne racconta alcuni tratti della vita, dal dottorato a Cambridge nel 1926 al Premio Enrico Fermi nel 1963, ha appena vinto 7 Oscar, 5 Golden Globe e 7 premi Bafta. Proprio il film – molto ben documentato - di Nolan ci serve come punto di appoggio per raccontare Oppenheimer.

Ne parliamo anche perché Oppenheimer è un personaggio emblematico:

- è di confine tra l’immagine ideale della scienza neutrale e la realtà spesso disconosciuta della sua dimensione politica,

- è in bilico, altalenante, tra morale procedurale e morale sostanziale.

L’INEVITABILE POLITICITÀ DELLA FISICA

Nel 1942, Oppenheimer aderisce – stupito dal fatto di essere stato scelto dal governo a dispetto dei suoi modi spesso fuori dalle regole e del suo impegno politico di orientamento comunista – con determinazione e passione al Progetto Manhattan e realizza, guidando militari, civili e scienziati, la più imponente struttura teorica, sperimentale e applicativa che la fisica abbia mai visto: 130.000 persone coinvolte, 2 miliardi di dollari investiti, 3 anni di lavoro e una new town dedicata in cui scienziati, civili e militari convivono e lavorano confinati.

La sua motivazione sembra avere tre teste, come il cane Cerbero della teogonia di Esiodo.

La prima testa è la convinzione che la scienza sia un vettore di progresso, che abbia un carattere incrementale di continuo avanzamento verso la conoscenza più ampia e completa; il Progetto di realizzazione della Bomba, per Oppenheimer, rappresenta l’irripetibile opportunità di sviluppare conoscenza teorica e sperimentale con il più eccezionale gruppo di scienziati viventi e con risorse quasi illimitate.

La seconda testa è la visione del potenziale generativo di bene collettivo che Oppenheimer attribuisce alla scienza, in particolare alla fisica; ancora una volta, il Progetto Manhattan può, nella visione di Oppenheimer, permettere lo sviluppo di tecnologie e opportunità di grande importanza per l’umanità; nel corso delle lezioni Reith alla BBC, nel 1953, Oppenheimer dice:

«

il progresso della scienza non si arresterà finché ci saranno uomini. Sappiamo che il nostro lavoro è tanto un mezzo quanto un fine. Una grande scoperta appartiene al mondo della bellezza; e la nostra fede — la nostra quieta e insopprimibile fede - è che la conoscenza sia un bene in sé e per sé. Ma è anche uno strumento; è uno strumento per i nostri successori, che la useranno per indagare qualcos'altro e più profondamente; è uno strumento per la tecnologia, per le attività pratiche, e per il destino dell'uomo (Oppenheimer R., Scienza e pensiero comune, 2023, p. 91).

»

La terza testa della motivazione-Cerbero di Oppenheimer è l’apparente necessità di arrivare a fare la bomba prima dei nazisti, prima di Hitler; necessità amplificata dalle congetture strumentali, e poco documentate, sullo stato dell’arte dei fisici del Reich, ed evidenziata nel film di Nolan:

«Oppenheimer (a E. Lawrence)

Lo so bene qual è il fottuto progetto, Lawrence! Sappiamo tutti della lettera di Einstein e Szilard a Roosevelt. Lo avvertono che i tedeschi potrebbero fare la bomba. E io lo so cosa significa per i tedeschi avere la bomba» (Nolan C., Gadget – sceneggiatura finale di Oppenheimer, p. 42).

«Oppenheimer (al colonnello Groves)

State parlando di trasformare la teoria in una vera e propria arma più rapidamente dei Nazisti» (Cit. p. 51).

In queste tre posizioni contestuali si mostra il carattere di confine di Oppenheimer.

All’inizio del progetto – coglie il carattere inevitabilmente politico della scienza: è uno strumento di progresso che non si pone in modo neutrale e serve obiettivi etici[3] e politici, con un innegabile valore morale, sconfiggere il male, rappresentato da Adolf Hitler e dai nazisti.

Nel corso del progetto, di fronte alle obiezioni morali di scienziati e amici che intravedono il pericolo rappresentato dall’enorme potere distruttivo della Bomba e dubitano della moralità del loro ruolo nella realizzazione, la risposta di Oppenheimer è di confine: da un lato fa leva sul valore morale della sconfitta di Hitler; dall’altro, si affida all’ideale di neutralità della scienza, dei cui potenziali effetti negativi lo scienziato non si deve occupare; l’uso corretto e moralmente accettabile dei risultati della ricerca e applicazione scientifica è un problema della politica, non della comunità scientifica: «come dovrebbe fare Truman a rassicurare il popolo americano? » gli chiede L. Strauss e Oppenheimer risponde: «Limitando la diffusione delle armi atomiche attraverso il controllo internazionale dell’energia nucleare» (Cit. p. 107-108).

Al momento dell’esplosione – narra lui stesso – ha l’intuizione di stampo Hindu del suo carattere di distruttore di mondi.

Infine, al termine della guerra – la cui fine è attribuita alla bomba realizzata da Oppenheimer e dai suoi colleghi di Los Alamos, alla distruzione “dimostrativa” delle due città giapponesi e alle più di 400.000 vittime tra morti e feriti – viene travolto dalla responsabilità del massacro che ha contribuito a compiere.

IL PERICOLO DELLA MORALE PROCEDURALE

Un’etica formale, o procedurale, «giudica la moralità di un’azione non prendendo in considerazione scopi o conseguenze, ma solo la conformità dell’azione alla legge», a obiettivi predefiniti, per esempio, da una disciplina professionale o da un programma politico.

Differentemente, l’etica sostanziale identifica i principi morali

«

prendendo in considerazione scopi o conseguenze, […] in cui la legge morale non può essere separata dal particolare (le inclinazioni, gli scopi, le situazioni pratiche) perché è solo dalla loro sintesi che nascono i concreti doveri e le reali azioni morali (Heller A., Per un’antropologia della modernità, 2009, pp. 54-71).

»

Arrivare ad avere la bomba prima dei nazisti è una azione e un dovere morale perché incarna il principio sostanziale di evitare di mettere in mano ad un capo di stato ritenuto folle e capace di tutto, qual è Hitler, un’arma che può distruggere intere nazioni.

È questo principio morale che Oppenheimer usa come traduzione per reclutare gli scienziati nel Progetto Manhattan.

Al contrario, usare il Progetto e costruire la bomba per fare progressi nell’esplorazione della fisica subatomica e per testare nella pratica teoria e matematica della fisica quantistica è senza ombra di dubbio affidarsi a un’etica procedurale: è rispondere ad una legge, quella del progresso scientifico, senza prendere in considerazione le conseguenze; è separare la morale dal particolare, è evitare di confrontarsi con la realtà morale, di farsi domande.

Il film di Nolan – raccogliendo i temi della bio “American Prometeus” di K. Bird e M. J. Sherwin (2005) - propone due momenti emblematici che sottolineano come il Progetto fosse pervaso e fondato su un’etica procedurale, cieca alle conseguenze: il primo è la conversazione tra Hans Bethe e Oppenheimer sul rischio che l’esplosione nucleare, mai fatta prima, possa diventare incontrollata e mettere a fuoco tutta l’atmosfera terrestre,

«Bethe: Le probabilità di una reazione nucleare incontrollata sono vicine allo zero;

- O.: Vicine allo zero?

- Bethe: Oppie, questa è una buona notizia;

- Oppie: Puoi rifare ancora i calcoli?

- Bethe: Avrai la stessa risposta. Finché non facciamo davvero detonare una di queste cose, la migliore rassicurazione che puoi avere è questa: (sbatte le carte) vicine allo zero».

La probabilità di distruggere l’atmosfera terrestre e cancellare la vita dal pianeta in pochi istanti è quasi nulla, e questo quasi nulla è sufficiente per archiviare l’eventualità e procedere con il Progetto della bomba.

Questo è il rischio di affidarsi ad un corpus disciplinare e di adottare un’etica procedurale. Si perde di vista il senso morale, si evitano le considerazioni sulle conseguenze, rassicurati dai dettami della disciplina, riportati nella comodità della deresponsabilizzazione dello scienziato.

Il secondo momento emblematico è la riunione dopo l’annuncio del lancio della bomba in Giappone: tutti – scienziati, tecnici, militari e civili di Los Alamos – vengono presi da un orgasmo di gioia, di delirio e di orgoglio patriottico; è la vittoria nella guerra, è – soprattutto – il successo del Progetto messo in pratica. L’etica procedurale della scienza neutrale annulla le conseguenze dell’azione e fa scordare la dimensione politica della stessa scienza.

Oppenheimer, di fronte alle persone del Progetto Manhattan:

«Alzo le mani in un gesto teatrale e vittorioso – la folla acclama…

“Il mondo ricorderà questo giorno […]

sono orgoglioso di quello che avete realizzato […]

sono sicuro che ai giapponesi non è piaciuto”» (Cit. pp.139-140).

CONCLUSIONE

Spesso gli scienziati credono ciecamente nel mito del progresso scientifico e nella neutralità della scienza, e si rifugiano nella propria zona di tranquillità, abdicando al ruolo di soggetti morali e lasciando nelle mani della politica o del business tutte le responsabilità dell’uso delle tecnoscienze che creano.

Sono convinto che dimenticare il ruolo nativamente politico, morale e sociale delle tecnoscienze e dei loro creatori sia un comportamento moralmente grave e socialmente pericoloso, che mette fuori gioco la comunità scientifica, asservendola al potere.

Dalla scenografia di Oppenheimer (Cit., p. 143 – 145)

ANTICAMERA DELLA STANZA OVALE, ALLA CASA BIANCA – DI GIORNO

Sollievo, gentile formalità, guardo sul tavolino:

Time magazine con me in copertina: "PADRE DELLA BOMBA ATOMICA”.

ASSISTENTE

Il Presidente Truman la riceve ora.

INTERNO, STANZA OVALE

Truman si alza dalla scrivania per stringermi la mano -

TRUMAN

Dr Oppenheimer, è un onore.

OPPENHEIMER

Signor Presidente. Segretario Byrnes.

TRUMAN

Come ci si sente ad essere l’uomo più famoso del mondo?

TRUMAN (CONT’D)

Lei ha aiutato a salvare molte vite americane. […]

La sua invenzione ci ha permesso di riportare i ragazzi a casa.

La nazione è in debito con voi.

Mi torco le mani una con l’altra, profondamente a disagio...

OPPENHEIMER

Signor Presidente, sento di avere le mani sporche di sangue.

Truman mi guarda in modo diverso. Si toglie il fazzoletto bianco dal taschino sul petto della giacca e me lo offre -

TRUMAN

Lei pensa che a qualcuno a Hiroshima o a

Nagasaki gliene freghi qualcosa di chi ha costruito la bomba?

Loro badano a chi l’ha sganciata.

Io l’ho fatto.

Hiroshima non ha a che fare con Lei.

NOTE

[1] Il nome della divinità Hindu, Kalah, in sanscrito significa tempo. Argomento delicato.

[2] In quest’ordine: alcuni aspetti del suo lavoro suggeriscono l’importanza delle divergenze sperimentali per generare nuove determinazioni e variazioni delle teorie. Questo tema è sviluppato da M. Hagner e H.J. Rheinberger in Experimental Systems, Objects of Investigation and Spaces of Representation, In Experimental Essays, edited by Heidelberger M. and Steinle F., 355–73. Baden-Baden: Nomos, 1998.

[3] Attenzione, dico “etici” e non morali, la morale è già definita, qui si tratta di perseguirne degli obiettivi.

L’era post-atomica - Achille Mbembe e l’ultima utopia dell’umanità

Necropolitica

Qual è la relazione fra vita, morte e potere in quei sistemi politici che funzionano solo in uno stato di emergenza? Questa è una delle domande fondamentali a cui Achille Mbembe, filosofo originario del Camerun, cerca di rispondere all’interno di Necropolitics, un saggio breve ma molto denso pubblicato nel 2013. In esso, Mbembe afferma che «la massima espressione della sovranità risiede, in larga misura, nel potere e nella capacità di dettare chi può vivere e chi deve morire» (Necropolitics, 2019, p. 11).[1] Da ciò segue che «esercitare la sovranità significa esercitare il controllo sulla mortalità e definire la vita come dispiegamento e manifestazione del potere» (Cit. p. 12).[2]

È chiaro, fin dalle prime righe, il rimando al concetto di biopolitica, sviluppato da Michel Foucault nel corso degli anni ’70 per comprendere i problemi legati a fenomeni propri dei viventi costituiti in popolazione, come quelli riguardanti la salute, l’igiene, la natalità etc… e al modo in cui sono stati gestiti dalla «pratica governamentale» (Naissance de la biopolitique, 1979, p. 333). Secondo Mbembe, tuttavia, la sovranità esercita una forma di potere che va oltre la decisione circa la gestione della vita della popolazione in questione, provocando intenzionalmente la morte di quest’ultima o di parte di essa. Distinguendo tra vita «utile» e vita «superflua», il principio della razza è ciò che permette di tracciare una cesura nel continuum biologico dell’umanità e consente alla sovranità - specialmente in ambito coloniale - di giustificare ed esercitare la sua funzione di morte. Nel mondo contemporaneo, la nozione di necropolitica è necessaria per rendere conto dei modi in cui

«le armi vengono impiegate nell’interesse della massima distruzione delle persone e della creazione di mondi di morte, nuove e uniche forme di esistenza sociale in cui vaste popolazioni sono sottoposte a condizioni di vita che conferiscono loro lo status di morti viventi» (A. Mbembe, Necropolitics, p. 40).[3]

Tecnologia nucleare

Sebbene né Mbembe né Foucault parlino esplicitamente delle armi nucleari o dell’era atomica, l’intreccio dei concetti di biopolitica e necropolitica può essere un’utile chiave di lettura del fenomeno, soprattutto per quanto riguarda il nostro presente. Infatti, anche se non viviamo più in un’epoca in cui la bomba atomica occupa un posto centrale nella vita delle persone, così come è stato subito dopo Hiroshima e Nagasaki, e soprattutto durante la Guerra fredda, essa rimane una presenza inquietante sullo sfondo della politica internazionale: lo abbiamo visto con i recenti sviluppi della guerra in Ucraina. Alla luce di quanto detto prima, le armi nucleari possono essere interpretate come una parte fondamentale dell’esercizio della sovranità, basato sull’intreccio tra biopotere e necropotere. Servendosi delle armi nucleari, infatti, la sovranità politica, che sia quella di uno Stato o di un blocco di Stati, può legittimarsi e riaffermarsi di fronte ad eventuali nemici, in quanto unica detentrice non solo di uno strumento di controllo e regolazione della vita, ma anche e soprattutto di un veicolo di morte.

Ciò risulta evidente anche nel Trattato di non proliferazione nucleare, entrato in vigore nel 1970 e a cui oggi aderiscono più di 190 Paesi. Esso si fonda su tre pilastri: impegnare al disarmo i cinque Stati che detenevano ufficialmente armi nucleari (Cina, Francia, Regno Unito, Russia, USA), offrire una base giuridica alla non proliferazione delle armi nucleari e consentire l’uso pacifico dell’energia nucleare. Di fatto, tuttavia, al Trattato non si sono ancora adeguate quelle stesse nazioni che l’avevano proposto e che avrebbero dovuto puntare al disarmo, dato che gli altri Stati accettarono di non dotarsi di armi nucleari solo perché quelli che le possedevano si impegnarono ad eliminarle nel giro di pochi anni[4]. La tecnologia nucleare, dunque, rimane tutt’oggi essenziale nella definizione del potere politico sovrano, sia a livello nazionale che internazionale.

Brutalismo

Allargando l’orizzonte della riflessione, secondo Mbembe stiamo assistendo a un’escalation tecnologica mai vista prima, la cui scintilla di inizio potrebbe essere a nostro parere identificata con la creazione e l’utilizzo della bomba atomica. Lo sviluppo sempre più rapido delle tecnologie sta rivoluzionando il nostro rapporto con il mondo, rendendo sempre più difficile separarle dalle nostre vite. A questo proposito, il filosofo parla in La communauté terrestre (2023) di una «seconda creazione», che passa attraverso il dispiegamento di un'umanità ibrida dotata di un doppio: l'umano e il suo oggetto.

La tecnologia, oggi, si fa teologia ed escatologia, portando l’uomo a credere in un possibile futuro in cui potrà finalmente separarsi dalla natura, addomesticare la vita e passare ad un altro stadio dell’evoluzione biologica. Mbembe parla di «brutalismo» per mostrare come questa transizione verso un'umanità ibrida corrisponda a forme di politica la cui funzione è quella di distruggere e separare, formando non l'impossibilità del luogo, ma la costruzione di un non-luogo, in cui circoscrivere certe porzioni di umanità. Con questo termine, l’autore fa riferimento a un’epoca in cui la tecnologia non è più solo uno strumento, essa è la forma che ha preso la metafisica, prima nella storia occidentale e dopo nella storia globale. Nell’epoca del brutalismo, ci si avvale di tre tipi di ragione, cioè quella economico-strumentale, quella elettronico-digitale e quella neurobiologica. Tutte si basano sulla convinzione che c’è sempre meno differenza tra l’uomo e la macchina, che anzi quest’ultima dovrebbe prendere sempre più decisioni al posto nostro. Dunque, secondo Mbembe, non sono più solo gli schiavi o i nativi delle colonie ad essere considerati oggetti, ma con lo sviluppo delle intelligenze artificiali e dell’ingegneria genetica il confine stesso tra uomo e oggetto è destinato a sfumare.

Utopia

Contro questa visione del futuro dell’umanità come definitivamente separata dal resto degli esseri viventi sulla Terra, Mbembe propone una politica di «liberazione del vivente» che si dispieghi a partire da una comunità terrestre, che sia composta da una molteplicità di archivi e che abbracci tutti gli esseri viventi. In essa, inoltre, «è il diritto dei viventi e non più il diritto dei popoli che determina i gradi e le condizioni di appartenenza» (Brutalisme, 2023, p. 173)[5]. È evidente, tuttavia, che la Terra come unità politica globale non esiste ancora. Ecco perché Mbembe afferma che «su un piano politico, il nome Terra è un’utopia, forse l’ultima utopia» (La communauté terrestre, p. 72)[6]. Il suo non esserci ancora non ne diminuisce l’importanza, anzi. Secondo Mbembe, infatti, l’essere umano è posto davanti a un’ultima scelta: «o la riparazione, o i funerali» (Cit. p. 72)[7]. La Terra sarà il luogo a partire dal quale l’umanità intraprenderà l’opera di rigenerazione del vivente, oppure «essa ne sarà la tomba universale, il suo mausoleo» (Cit.) [8]. Il concetto di utopia, pertanto, ricopre un ruolo centrale nella riflessione di Mbembe, il quale trae ispirazione dalle opere di Ernst Bloch, un filosofo che, come afferma Fergnani, ha fatto dell’utopia «il nucleo centrale cui si riconducono tutti i momenti ed aspetti essenziali del suo pensiero» (Utopia e dialettica nel pensiero di Ernst Bloch, p.191). Nel paragrafo 7 di Brutalisme, Mbembe cita espressamente Spirito dell’utopia (1918) e Il principio Speranza (1959), i due pilastri fondamentali del lavoro di Bloch, i quali costituiscono una lunga esortazione all’umanità e permettono a Mbembe di approfondire e strutturare la sua idea della Terra come ultima utopia.

Secondo Bloch, infatti, la speranza è uno dei motori più potenti della storia ed esige non un ottimismo ingenuo o una fede cieca nel progresso, né un pessimismo assoluto, incondizionato e paralizzante, ma un ottimismo critico e militante. Gli esseri umani, nati per la gioia, riescono a lanciarsi verso il divenire solo attraverso la speranza, fondando quest’ultima su un’utopia concreta[9], ovvero agendo a partire da condizioni storico-concrete che si radicano nella situazione sociale presente. Occorre analizzare il divenire storico e cercare nell’attualità quelle «eccedenze utopiche» che possono essere utilizzate per concepire nuove possibilità per il futuro; altrimenti sperare «sarebbe soltanto un atto arbitrario della volontà e, in fondo, l’effetto compensativo di una disperazione che è più profonda e ben altrimenti radicata nei fatti» (Falappa, L’umanità come utopia, p. 60).

In conclusione, contro una visione nichilistica della realtà, contro un potere politico che fonda il suo potere sulla paura, contro un’articolazione ingiusta e ineguale delle relazioni internazionali, oggi Achille Mbembe, lettore di Bloch, ci ricorda che «l’importante è imparare a sperare» (Bloch, Principio speranza, p. 5).

NOTE

[1] Il testo originale è: «the ultimate expression of sovereignty resides, to a large degree, in the power and the capacity to dictate who may live and who must die», traduzione della Redazione.

[2] Il testo originale è: «to exercise sovereignty is to exercise control over mortality and to define life as the deployment and manifestation of power», traduzione della Redazione.

[3] Il testo originale è: «weapons are deployed in the interest of maximum destruction of persons and the creation of death-worlds, new and unique forms of social existence in which vast populations are subjected to conditions of life conferring upon them the status of living dead», traduzione della Redazione.

[4] M. Elena, Il nucleare tra pace e guerra, Atti Acc. Rov. Agiati, a. 263, 2013, ser. IX, vol. III, B: 45-70.

[5] Testo originale: «c’est le droit des vivants et non plus le droit des gens qui determine désormais les degrés et les conditions d’appartenance», traduzione della Redazione.

[6] Testo originale: «sur un plan politique, le nom Terre est une utopie, la dernière utopie peut-être», traduzione della Redazione.

[7] Testo originale: «ou la réparation, ou les funérailles», traduzione della Redazione.

[8] Testo originale: «elle en sera le tombeau universel, son mausolée», traduzione della Redazione.

[9] «L'utopia concreta respinge sia un “superficiale” (oberflächlich) empirismo che aderisce ai dati reificati e che al più si attende la sintesi dal loro progressivo accumulo, sia l'”esuberanza” del sognatore, che pretende di andar oltre sorvolando», (F. Fergnani, Utopia e dialettica nel pensiero di Ernst Bloch, p. 194).

Odorata Ginestra, contenta dei deserti - L’isola di Ghiaccio-Nove

Kurt Vonnegut è un autore tutt’altro che sconosciuto. Considerato uno dei massimi esponenti del racconto fantascientifico del secondo dopoguerra, il romanzo Ghiaccio-nove - pubblicato per la prima volta nel 1963 - gli valse la candidatura al prestigioso premio Hugo; ed essendo che il romanzo parla della bomba atomica, e della “nuova bomba atomica”, il ghiaccio-nove, possiamo aggiungere che molto si è detto e si è scritto di Vonnegut, di Ghiaccio-nove e della bomba atomica.

Mentre giravo per le vie di Firenze e pensavo a cosa scrivere a riguardo, mi sono imbattuto in una mostra intitolata Viaggio di luce che combinava le opere di Abel Herrero e Claudio Parmiggiani. Una serie di minute canoe ricolme di pigmenti puri erano associate, una ad una, a grandi tele ricoperte di fluttuanti curve marittime. C’era una scritta impressa sul muro, una frase di Herrero: «un’isola in un mare senza barche è come una prigione dove ogni sogno di navigazione mai realizzato si trasforma in allucinazione».

Ho pensato che valesse la pena lasciar parlare gli altri dell’ironia tagliente di Vonnegut, della sua contrarietà mal celata per chi, nascosto sotto l’etichetta di tecnico e ingegnere, non pone mai in questione le ripercussioni morali ed etiche delle proprie invenzioni. Vale la pena parlare d’altro - mi sono ripetuto - perché ciò che si può iniziare a dire dell’atomica lo si può dire parlando dell’isola. Perché la storia che gravita intorno alle sorti dei tre figli dell’inventore romanzesco della bomba atomica, Felix Hoenikker, ha tre elementi essenziali. Innanzitutto, la sorte di dei tre figli termina sull’isola-stato di San Lorenzo. C’è Frank, vice del dittatore dell’isola “Papa” Monzano, e poi ci sono il terzogenito nano Newt e la sorella maggiore Angela. Secondo elemento: su quella isola ci finisce la voce narrante di Ghiaccio nove, Jonah - come il profeta dell’antico testamento che fu inghiottito da un pesce -, giunto sino a lì perché sta scrivendo una biografia sull’inventore della bomba atomica che non ultimerà mai, Il mondo in cui il giorno finì. Infine, ognuno dei figli tiene con sé un termos contenente l’ultima, diabolica, invenzione di Hoenikker, il ghiaccio-nove: un composto chimico capace di ghiacciare qualsiasi sostanza acquosa con cui entra in contratto, e sviluppato - un po’ per sfida e un po’ per scherzo -, perché un comandante militare era andato da Felix per lamentarsi dei mezzi di terra costantemente impantanati nel fango.

«In termini geografici, un’isola è un pezzo di terra circondato dal mare», sono sempre parole di Herrero. Ma ciò che conta sono le traiettorie che la attraversano e la intercettano, oppure che mancheranno sempre di toccarla.

Un’isola ignota, celata ai normali corsi marittimi, è quasi inesistente - si giunge sulle sue sponde unicamente tramite miracolo o sventura. Per chi si ricorda il racconto Utopia, ricorderà anche che Thomas More dovette celare le coordinate dell’isola dietro un artificio narrativo, ossia aver sentito parlare dell’isola da un marinaio che non ne rivela mai la posizione. La città ideale, posta sull’isola, non può essere raggiunta navigando: deve essere ignota ed impermeabile al corruttibile mondo al di là della barriera del mare.

Per una ragione analoga, nei lunghi secoli in cui gli esegeti cristiani credettero all’esistenza materiale dell’Eden, innumerevoli di loro posero il divino giardino su qualche isolotto dalle coordinate imperscrutabili. Nonostante ciò, alcuni di loro decisero che il piatto era troppo goloso, così si lanciarono in mare alla ricerca della terra perduta e divennero monaci pirati.

Diversamente, se un’isola entra a far parte di una rotta commerciale, diventa un nodo. Pensate alla coppa di Nestore, rinvenuta ad Ischia, e testimonianza della rete che dall’allora Pitekusa si estendeva fino ai territori sotto il dominio di Cartagine e fino alla Spagna, passando per l’Italia meridionale, sino alla Grecia ed ancora più ad oriente. Oppure, un esempio sopra a tutti, quello di Creta, dove passarono Greci e Romani, Bizantini e Andalusi, Genovesi e Turchi.

L’isola dell’Eden è un “altrove” in un primo senso. È altrove, nella misura in cui custodisce ciò che trascende ogni presenza corruttibile e terrena, è perciò una proprietà del cielo più che della terra. L’isola come nodo è anch’essa un “altrove”, questa volta in un secondo senso. Creta fu un tempo la culla della civiltà minoica e lo snodo fondamentale per arrivare da oriente ad occidente: lo fu, e poi non lo fu più - dunque, assai corruttibile. Perché l’isola-nodo è un’altrove in quanto nasce dai luoghi che la attraversano convogliando le proprie traiettorie verso l’atollo; come un nodo si fa, si disfa.

Né il primo né il secondo senso d’isola riguardano il racconto di Vonnegut, che appare più simile a quello espresso da Herrero, l’isola dove ogni sogno di navigazione è allucinazione.

Indietreggiando, si può affermare la più grande banalità: ogni terra è un’isola.

Da questo punto di vista, l’isola non è più un nodo perché non esistono altri luoghi da cui possano partire delle traiettorie che finiranno per intercettarla. C’è soltanto l’isola, così che anche quell’altra porzione di terra emersa, quella “ideale”, l’altrove dal verde più verde, è una pia illusione. La navigazione nel mare, in tal caso, rasenta l’insanità: l’isola d’Utopia è l’allucinazione nata in seno a chi non sopporta la propria condizione d’isola presente a sé stessa, all’infuori della quale non risiede altro. La narrazione fantascientifica coglie più volte nel segno quando parla di “navigazione spaziale” in questi termini. L’umanità è isola non soltanto geograficamente, ma psichicamente ed escatologicamente: la storia, come economia della salvezza, è il racconto e la promessa di una fruttuosa navigazione che ci porti finalmente altrove, al di là di ogni condizione attuale.

Non è cambiato quasi nulla.

L’isola è destinata ad inabissarsi, si alzeranno le maree o correrà il vento, come in Cent’anni di solitudine - un’altra isola - dove ogni parola umana sarà portata via. L’apocalisse rimane una e una sola cosa: la giustificazione di chi non sa come altro vivere. Se non posso evadere - confessa -, se nessuno verrà a salvarmi, devo dichiararmi in prigione…e libero.

Sono le due false alternative sull’isola di San Lorenzo, stare dalla parte del popolo sotto dittatura, oppure stare dalla parte del santone liberatore.

Eppure è cambiato qualcosa.

Sull’isola c’è chi detiene il potere di distruggerla.

Detto nei termini di Ghiaccio-nove, tre idioti inadatti a gestire sé stessi hanno il potere di distruggere ogni forma di vita presente sul pianeta.

La «minaccia atomica» oggi – Attualità di Günther Anders

L’orologio del Giorno del Giudizio

Novanta secondi alla mezzanotte, ovvero all'Apocalisse. L'orologio del Giorno del Giudizio, meglio noto come «Doomsday Clock», è un'iniziativa ideata nel 1947 dal gruppo di scienziati – tra i quali ex-membri del «Progetto Manhattan» – facente capo al Bulletin of the Atomic Scientists della Università di Chicago. Si tratta di un orologio «metaforico» atto a misurare il pericolo di un'ipotetica fine del mondo – o, per meglio dire, di un'eventuale fine dell'umanità – dovuta, in primis, a cause di natura «atomico-bellica» ma anche relativamente a fenomeni antropici di lungo periodo, ad esempio il riscaldamento globale e la cosiddetta «emergenza climatica». Ogni anno il team di scienziati internazionali del bollettino è chiamato formalmente a riaggiornare le lancette del timer apocalittico, a seconda degli avvenimenti e delle circostanze contingenti. Il pericolo di un'imminente fine viene quantificato indicando simbolicamente la mezzanotte come orizzonte temporale limite, e, in questo senso, i minuti che separano le lancette dallo scoccare dell'ora finale rappresenterebbero la distanza ipotizzata da quell'evento. Se è vero che, dal 2007, l'orologio prende in considerazione ogni variabile che possa provocare danni irrevocabili all'umanità, è vero anche che, al momento della sua creazione, la mezzanotte rappresentava unicamente l'eventualità della guerra atomica e, in sintesi, lo scenario apocalittico della cosiddetta «M.A.D.» o «Mutual Assured Destruction». Per intenderci, è quello che ha messo in scena molto bene Kubrick nel suo celebre Dottor Stranamore, ovvero la «distruzione mutua assicurata» tra due super-potenze nucleari che decidessero, per scelta o per sbaglio, di «aprire il fuoco» del bombardamento atomico, reciprocamente e senza freni, l'una nei confronti dell'altra.

Al momento della sua creazione, durante la guerra fredda, l'orologio fu impostato alle 23:53, ovvero sette minuti prima della mezzanotte. Da allora, le lancette sono state spostate ventitré volte, e la massima vicinanza alla mezzanotte è stata raggiunta nel 2023, in piena tensione internazionale tra Russia e USA durante il conflitto ucraino, ma anche – come se ciò non bastasse – per l'innalzarsi significativo delle temperature globali dell'anno precedente. Il 2024 ha confermato il trend dell'anno prima, ribadendo la distanza simbolica di 90 secondi dal Giudizio Universale. Un tale countdown è, dunque, pericolosamente vicino alla sua conclusione, ad un livello storicamente mai visto prima. La massima lontananza registrata, invece, è stata di 17 minuti, tra il 1991 e il 1995 – significativamente coincidente con i cosiddetti accordi «ST.A.R.T.», ovvero «Strategic Arms Reduction Tready», e, in tal senso, tangente anche al crollo dell'URSS e all'implosione dell'universo sovietico.

Il fattore umano

Non è del tutto privo di pertinenza, a questo proposito, citare l'evento emblematico che vide protagonista Stanisláv Evgráfovič Petróv, tenente colonnello dell'esercito sovietico, il 26 settembre 1983, quando il sistema radar di rilevamento precoce di attacco nucleare dell'URSS registrò un lancio di missili da basi statunitensi. Interpretando correttamente questa segnalazione come un «falso allarme» in quello che, appunto, è passato alla storia come l'«incidente dell'equinozio d'autunno», il tenente Petróv è stato ribattezzato come l'«uomo che fermò l'Apocalisse»: il suo gesto ha mostrato meglio di ogni «strategia della deterrenza» quali sono i rischi dell'implementazione degli arsenali nucleari e – oggi più di ieri – quali i possibili vantaggi della cosiddetta «agency» del fattore umano, spesso sacrificato nel nome della presunta oggettività della macchina. Oggi, dati anche i più recenti sviluppi dell'A.I., si tende a delegare il più possibile agli algoritmi decisioni di qualsiasi tipo – dalle più banali come la scelta della playlist su Spotify, a quelle più rilevanti in termini di globalità. La mancanza di fattore umano – per meglio dire, il suo occultamento sotto le mentite spoglie dell'emulatore macchinico, che potenzia le nostre capacità, pregi e difetti compresi – non ci deve rassicurare: dovrebbe piuttosto ulteriormente inquietarci l'immagine riflessa che ci viene restituita, mediante l'intelligenza amplificata dalle macchine, non tanto delle nostre potenzialità in positivo, quanto in negativo della nostra «piena impotenza» in senso apocalittico.

Già nel 1958, nelle sue Tesi sull'età atomica, il filosofo Günther Anders rifletteva sulla data spartiacque del bombardamento di Hiroshima e Nagasaki come il vero punto di «non-ritorno» per la vita umana su questa terra: l'avvento di quell'«era atomica» intesa come il «tempo finale» (Endzeit) dell'umanità – scrive appunto Anders (1961, Tesi sull’era atomica, p. 201):

«

Il 6 agosto 1945, giorno di Hiroshima, è cominciata una nuova era: l'era in cui possiamo trasformare in qualunque momento ogni luogo, anzi la terra intera, in un'altra Hiroshima. Da quel giorno siamo onnipotenti in modo negativo; ma potendo essere distrutti in ogni momento, ciò significa anche che da quel giorno siamo totalmente impotenti.

»

Per Anders, infatti, oggi non manca tanto la capacità di realizzare effettivamente la fine della umanità sulla Terra e, quindi, l'Apocalisse intesa come avvento del «mondo-senza-uomo», quanto la effettiva «non-capacità» dell'umanità di frenare il compimento dell'età atomica. Insomma, l'umanità è divenuta «antiquata» (Antiquiertheit), ovvero «obsoleta» a sé stessa, in quanto non è più in grado di salvare sé stessa attraverso l'impiego di una “forza catecontica” che ne freni la deriva apocalittica, cioè non tanto attraverso l'impiego di un potere, quanto piuttosto di un «non-potere» reale. Va anche detto, a scanso di equivoci, che la vita nell'era atomica, per Anders, si colloca ambiguamente in una sorta di «limbo» votato alla «dilazione» (Cit.), e cioè a ritardare il più possibile l'inevitabile. Non, perciò, una passiva accettazione della «fine dei tempi» (Zeitenende), quanto piuttosto una poco compiaciuta e assolutamente inquieta vita «sotto la bomba» nel segno del «tempo della fine» (Endzeit).

La minaccia atomica, oggi

Paradossalmente, dunque, per Anders è proprio l'epoca che massimamente ha visto l'umanità padrona del proprio destino – tanto che, anche se recentemente è stato «bocciato» dagli specialisti, è ormai uso comune riferirsi alla nostra era geologica attuale come «antropocene» – è anche quell'«età atomica» esiziale che di tale destino lo spossessa, fino all'inevitabile auto-estinzione. Attualmente, è lo spettro della «minaccia atomica» che torna prepotentemente a farsi largo tra i titoli di giornale: si pensi, per esempio, alle recenti affermazioni di Amihai Eliyahu, ministro del governo Netanyahu, il quale considerava un'opzione papabile l'utilizzo dell'atomica su Gaza, oppure anche le dichiarazioni di Trump che, da presidente, definì l'atomica appunto l'«arma della fine dei tempi». Recentemente, è stato il deputato Tim Walberg del Michigan a suggerire l'utilizzo dell'atomica su Gaza.

Ovviamente, ciò che oggi fa concretamente paura è l'impiego di armi nucleari tattiche nel conflitto in Ucraina, spesso seriamente paventate da parte di Putin. La «minaccia atomica» oggi è dunque il tema tornato inaspettatamente in primo piano e non solo per la cronaca. Anche la proposta filosofica di Anders, infatti, trova oggi un'inaspettata – o forse no – rifioritura, tanto che alcuni interpreti già si sono espressi nei termini di una vera e propria «Anders reinassaince». In Italia, è significativamente stato dedicato un importante numero della nota rivista «Aut-Aut» (397/2023) proprio all'attualità del pensiero di Anders per il dibattito. Inoltre, l'apertura di una nuova collana «Andersiana» per la casa editrice milanese «Mimesis» ribadisce il ruolo centrale che Anders va acquisendo sulla scena, anche considerando l'interesse che la teoria andersiana è tornata a suscitare all'estero e, significativamente, oltreoceano – dove Anders è sempre stato considerato, a suo stesso dire, un pensatore ostico e di difficile digestione, a differenza per esempio di un Marcuse o della stessa Arendt.

Le centrali atomiche come polveriere nucleari

Il confronto sull'impiego dell'energia nucleare è oggi all'ordine del giorno, corollario del triste ma necessario dibattito sull'autosufficienza energetica che vede le nazioni europee tutte – ma l'Italia in particolare – sempre maggiormente coinvolte. Le riflessioni andersiane su Černobyl, dal punto di vista critico, rivelano un'importante elemento, spesso trascurato: infatti, le centrali nucleari che, in tempo di pace, producono energia – diciamo in modo sicuro, efficiente e pulito – sono le stesse che, in tempo di guerra, si trasformano in potenziali strumenti bellici. Ancora una volta, lo abbiamo visto nel recente scontro russo-ucraino. Oltre all'impiego effettivo di arsenali atomici, anche le centrali nucleari si trasformano letteralmente in “polveriere nucleari” ad elevato tasso di rischio, veri e propri «punti caldi» nelle escalation dei conflitti bellici tra potenze.

In questo senso, l'attualità di Günther Anders sta anche nel ricordarci che, come provocatoriamente sosteneva lui stesso con una celebre battuta: «non ci si può fermare ad insegnare l'Etica Nicomachea, mentre le testate atomiche si accumulano». Per Anders, non c'è effettivamente una grande differenza tra una bomba nucleare progettata esplicitamente per esplodere e una centrale nucleare che, eventualmente, può farlo, se non il fatto che, in effetti, quest'ultima è una bomba atomica in potenza, laddove invece la prima è un ordigno in atto: un dispositivo che esercita attivamente la propria minacciosa presenza sull'umanità in maniera meno subdola o, se vogliamo, necessitando di un «camuffamento mediatico» adeguato. Il fine dell'energia nucleare, sembra dire Anders, è forse appunto quello di far sembrare un'opzione più appetibile, green e innocua, quella stessa potenza atomica che, tuttavia, potrebbe spazzare via l'uomo dalla faccia della terra letteralmente nel tempo di un lampo incandescente.

Anders invita pertanto ad avere il coraggio di avere paura; o, come anche dice in una celebre intervista, tradotta in italiano come Opinioni di un eretico e recentemente ripubblicata (Anders, 2023, p. 70):

«

Coraggio? Non ne so nulla. Non ne ho quasi mai bisogno per il mio agire. Fiducia? Non mi serve. Speranza? Posso solo risponderle: in linea di principio non la conosco. Il mio principio è: anche se nell'orrenda situazione in cui ci siamo messi ci fosse una pur minima possibilità di poter intervenire, si dovrebbe comunque farlo. I miei Comandamenti dell'era atomica, che lei ha ricordato, si chiudono con il mio principio. Esso dice: ”se sono disperato, ciò non mi riguarda!"

»

Pannelli fotovoltaici e tuberi - Una storia di ibridazione tra tecnologia e ripopolamento

Gagliano Aterno è uno splendido paese abruzzese di struttura medievale, nella Valle Subequana, ai piedi della catena del Sirente, dominato da uno splendido castello del XII secolo e circondato, in direzione delle gole che collegano la valle ai territori dei Peligni, da ampie terre coltivabili, che ne hanno determinato la fortuna nei secoli passati, e da boschi attraverso cui si sale verso le vette del Sirente.

Oggi Gagliano Aterno conta poco più di 200 residenti, di cui solo 150 circa vi abitano in modo permanente. Non è sempre stato così: nel 1931 la popolazione era di 1.926 persone e negli anni ’50 superava ancora le mille persone, tanto che si giocava ogni anno un torneo di calcio con anche 10 squadre, che rappresentavano altrettante zone del paese.

Il declino demografico, iniziato con un brusco calo di abitanti a cavallo della II guerra mondiale e segnato dall’emigrazione diretta in Canada e negli Stati Uniti, si è intensificato nella seconda metà del secolo scorso, con lo spostamento degli abitanti verso le grandi città italiane - Roma, Bologna, Milano, Torino – e verso la costa pescarese, fino a raggiungere gli attuali 200-230 residenti.

Dal racconto degli anziani si coglie che, negli anni ’50 e ’60, il paese era pieno di vita, con 5 taverne, 3 macellerie, almeno altri 2 negozi di alimentari, un fabbro, un calzolaio e tantissimi giovani.

Negli anni ’80 c’erano ancora molti ragazzi, un ritrovo dove suonare e ballare, due bar, una pizzeria, la palestra, un forno rinomato in tutta la valle, 3 negozi di alimentari e un verduriere, la farmacia, un ufficio postale aperto tutti i giorni, un parroco stabile.

Fino a un paio di anni fa nel paese erano rimasti: un solo bar, un ufficio postale operativo due giorni alla settimana, che operava a giorni alterni in un container, il medico di famiglia tre volte alla settimana nei locali della vecchia scuola, e basta.

Niente pediatra, niente farmacia, niente parroco stabile, nessun luogo di aggregazione, nessun negozio. Il tessuto imprenditoriale locale era limitato ad una – fiorente, va detto – impresa boschiva, una falegnameria con attività minima e una azienda avicola. Nessuna opportunità di lavoro per i giovani, nessuna opportunità per nuove imprese.

Ecco, questo era il quadro del paese nel 2020, quadro aggravato da una situazione di ampia non agibilità di molti fabbricati a seguito del terremoto del 2009 e dai ritardi nell’avvio dei lavori di riqualificazione sismica per i quali erano stati destinati fondi significativi.

PERIMETRO DEL PROBLEMA

Il giovane Sindaco, Luca Santilli, eletto nel 2020 nel mezzo della crisi pandemica, aveva di fronte a sé un problema su diverse dimensioni: demografico - popolazione scarsa e di età avanzata; di assenza quasi totale di servizi; di minima disponibilità finanziaria a causa del gettito fiscale quasi azzerato. Pareva che la crisi fosse inarrestabile e che il destino di spopolamento fosse segnato.

L’intento del Sindaco era, invece, di far “rivivere il paese”; fuori dalla retorica, questa intenzione sottende due macro-obiettivi: invertire la tendenza demografica e ricreare un tessuto di imprese e di servizi che renda il paese un luogo dove si può vivere bene e desiderare di vivere.

Il momento di svolta è l’incontro con MIM – Montagne in Movimento, un gruppo di ricerca-azione in antropologia applicata, progetto affiliato al Centro Universitario GREEN dell’Università della Valle d’Aosta, con cui il sindaco delinea un progetto di ampio respiro per “dare nuova vita alla comunità” e lavorare “per la salvaguardia della memoria storica e delle tradizioni di Gagliano”.

I catalizzatori (in gergo teatrale si potrebbe dire: i pretesti) del processo di avvio di tutto il progetto sono due: le nuove e più efficienti tecnologie del fotovoltaico e la legge sulle Comunità Energetiche Rinnovabili (CER).

LE TECNOLOGIE

Lo sviluppo del fotovoltaico permette, oggi: 1) di generare potenze di picco, sotto piena insolazione, quasi triple rispetto a solo 10 anni fa, 2) di immagazzinare energia in batterie di dimensioni, prezzo e complessità contenuta, 3) grazie alla cosiddetta Smart Grid, di scambiare energia - efficacemente e senza perdite significative – tra produttori e micro-produttori e i punti di consumo distribuiti sul territorio, in modo intelligente (davvero), allineando momento di produzione e momento del bisogno energetico, 4) di tenere conto e consuntivare sia l’energia prodotta e immessa nella rete che dell’energia consumata, in modo da poter retribuire adeguatamente i produttori.

Queste tecnologie rendono finalmente fattibile, interessante e remunerativo, per privati e comunità, realizzare degli impianti di produzione di energia elettrica, il cui prodotto può essere utilizzato in tempo reale per i propri bisogni (ad esempio: illuminazione pubblica, utilizzo di elettrodomestici privati, punti ricarica di mezzi elettrici) oppure rivenduto al Gestore dei Servizi Energetici nazionale a prezzi concordati.

LE LEGGI

La legge sulle Comunità Energetiche Rinnovabili (CER), dove “rinnovabili” si riferisce alle energie ma può essere anche inteso in senso esteso come rinnovamento delle comunità, recita che le CER sono “sono soggetti giuridici costituiti da privati cittadini, enti e imprese, che consumano energia autoprodotta con impianti alimentati da fonti rinnovabili e hanno come scopo principale quello di fornire benefici ambientali, economici o sociali ai propri membri e alle aree in cui operano”.

È interessante, appunto, come la legge mette in primo piano il tema della produzione energetica ma include anche i benefici ambientali – abbastanza ovvi, trattandosi di energia “pulita” – e quelli economico-sociali per la comunità stessa e le persone che ne fanno parte. È esplicitata la centralità della dimensione sociale e comunitaria, poiché il tema dell’accordo tra i partecipanti alla comunità è un elemento necessario e irrinunciabile per la costituzione della CER e per la realizzazione del progetto.

Altre leggi che fungono da catalizzatori sono quelle che garantiscono finanziamenti per il rilancio della montagna, delle imprese agricole e produttive montane, dello sviluppo della popolazione.

In ultimo, hanno giocato un ruolo importante le norme e gli incentivi per le forme di neo-popolamento che hanno permesso di creare NEO – Nuove Esperienze Ospitali, il nucleo di attrazione di giovani intenzionati a trasferirsi nel paese per avviare nuove attività.

IL PROGETTO

Il piano complessivo che delineano il sindaco di Gagliano Aterno e MIM fa, quindi, leva sulle tecnologie evolute del fotovoltaico, dell’accumulo in batterie e della Smart Grid, sulla legislazione delle Comunità Energetiche e sulla disponibilità di fondi per progetti di ricerca sul territorio, con l’obiettivo proteiforme di generare coesione all’interno della comunità rispetto al piano di rilancio, realizzare servizi per la cittadinanza, generare opportunità di occupazione e proposte turistiche che possano attrarre energie – questa volta umane – e persone.

Il progetto prende avvio e si sviluppa attraverso più di 50 assemblee cittadine ad ampia partecipazione (Aristotele e Rousseau avrebbero sorriso, pensando alle dimensioni quasi ottimali della comunità), la realizzazione di bandi di ricerca rivolti a studenti e dottorandi, lo studio di fattibilità tecnico-operativo di impianti fotovoltaici installati in aree pubbliche dismesse – come un vecchio lavatoio – e sui tetti delle abitazioni private.

PRIMI RISULTATI

Il primo risultato visibile, che è parte e inizio dello stesso cammino progettuale, è l’ampia partecipazione alle numerose assemblee in cui vengono messi a fuoco i desideri e gli obiettivi dei singoli cittadini e le loro proposte progettuali.

Seguono, nel giro di due anni:

- la presenza di più di 15 ricercatori che aderiscono ai bandi e partecipano attivamente alla vita del paese, in alcuni casi inserendosi nel tessuto di relazioni in maniera che può fare pensare a forme di stabilizzazione;

- l’installazione di pannelli fotovoltaici per circa 40 KW e di una colonnina di ricarica per veicoli elettrici ed ibridi;

- la nascita di 3 nuove attività, micro-imprese radicate nel paese, quali un secondo esercizio di ristorazione street food, un forno che aprirà a brevissimo, una attività di escursioni guidate in montagna;

- la realizzazione di forme di trasmissione di tradizioni culturali – soprattutto culinarie, si parla dell’Abruzzo! - che rischiavano di essere perse;

- la nascita di una web-radio cittadina;

- almeno 3 casi di ritorni al paese di persone che lavoravano lontano e che hanno deciso, rispettivamente, di gestire la radio, di rilanciare la produzione di famiglia di patate, di continuare l’attività agricola con il fratello (che non si era mai mosso dal paese) e, contestualmente, di gestire l’attività di escursioni guidate in montagna;

- una palestra di arrampicata che ospiterà dei corsi estivi;

- la apertura – in questi giorni - di una libreria, i cui proprietari, in corrispondenza con il pensionamento hanno deciso di trasferirsi, con armi e bagagli, da Roma a Gagliano.

Sono grandi risultati, soprattutto pensando al punto di partenza, risultati che possono far pensare alla reale possibilità di rilancio del paese.

CONSIDERAZIONI SOCIOLOGICHE MINIME

In maniera molto sintetica e semplificata, rimandando all’articolo più ampio e articolato di Paolo Bottazzini, si può provare ad inscrivere quello che è successo negli schemi della Actor Network Theory sviluppata da Bruno Latour (Reassembling the social. An introduction to Actor-Network Theory, 2005, Oxford University Press, Oxford).

Si possono, infatti, identificare una serie di attori umani e ibridi, attanti (nella definizione di Latour); tra gli umani: il sindaco, i ricercatori di MIM, i singoli cittadini; tra gli ibridi: le tecnologie fotovoltaiche, le batterie, la Smart Grid, le normative e i bandi di ricerca; si può rintracciare un lavoro capillare di traduzione del progetto in forma di interessi particolari degli attori, lavoro di traduzione che è sfociato nell’arruolamento di una parte significativa della popolazione, dei ricercatori, dei “nuovi venuti”, di abitanti che avevano lasciato il paese e sono ritornati e, infine, di almeno un giovane che ha deciso di non andare via – pur avendone la possibilità – e di dedicarsi al progetto e alle attività di famiglia.

Questi attori, in linea con la teoria Actor-Network, hanno costituito una rete – in parte formalizzata e in parte informale – che opera in maniera organizzata e quasi sincrona a favore del progetto di rilancio del paese e che cerca, dove possibile, di arruolare nuovi e vecchi abitanti.

Neuralink e la nuova aristocrazia della salute - Silicio e bulimia di potenza

1. Le mani, i piedi, il logos

Non so se Elon Musk conosca la ricerca paleontologica di Leroi-Gourhan (1964-65, Le Geste et la Parole), ma di sicuro ne condivide l’intuizione di fondo: la ragione, l’essenza e il destino dell’uomo (e anche di qualunque cosa debba sopraggiungere dopo di lui) non risiede nel cervello, ma nei piedi e nelle mani. L’andatura bipede ha reso possibile la liberazione degli arti superiori per la fabbricazione di utensili e per lo sviluppo delle tecniche: sono queste la natura dell’uomo, la sua origine, che ha trasformato il suo volto e il suo cranio di primate nella sede della parola. Neuralink è il progetto, nato nel 2016, che Musk ha finanziato in prima persona con 100 milioni di dollari; ha come obiettivo l’impianto di interfacce neurali capaci di curare gli effetti di patologie del sistema nervoso, anzitutto la tetraplegia. In altre parole, l’installazione nel cervello di un piccolo hardware, governato da un’intelligenza artificiale, permetterebbe di ripristinare l’uso di gambe e braccia nei malati di paralisi, in misura almeno parziale. La simbiosi tra fisiologia e tecnologia per finalità mediche non è proprio una novità: in fondo la sperimenta ogni giorno chiunque indossi un paio di occhiali. Ma per Elon Musk, che aspira a raggiungere l’infinito (e oltre) come Buzz Lightyear, l’AI di Neuralink rappresenta il primo passo del programma transumanistico di potenziamento degli esseri umani fino al limite delle loro risorse fisiche e intellettuali – per poi oltrepassare la soglia della singolarità, verso un destino non più assimilabile a nulla che sia depositato nell’esperienza della storia, e su cui siano impossibili previsioni di qualunque genere.

2. Il famedio dei macachi nel paradiso della scienza

Fino a qui, in apparenza, tutto bene. Lo scorso 29 gennaio Musk ha annunciato su X il primo innesto di Neuralink su un paziente tetraplegico: la sperimentazione si è trasferita dagli animali agli esseri umani. Può turbare questo clima di entusiasmo la notizia che la Securities and Exchange Commission (SEC) ha aperto un’inchiesta contro l’azienda e il suo fondatore per la morte dei macachi su cui sono stati testati i dispositivi. L’accusa è di non aver allevato martiri gloriosi e necessari per il progresso della scienza, ma di aver perpetrato agonie atroci, provocate dal desiderio di Musk di installare il chip al di sotto della rete vascolare, al fine di raggiungere una larghezza di banda superiore a quella delle società concorrenti. Contro le accuse sollevate dalla stampa americana, il magnate ha dichiarato che i laboratori di Neuralink sono una specie di «paradiso per le scimmie». In attesa che gli investigatori verifichino quanto la potenza del segnale sia qui sinonimo di santità o di crudeltà, formuliamo un paio di riflessioni sul significato che il progetto Neuralink può rivestire per la nostra società, assumendolo come un esempio del tipo di progetti su cui non solo Elon Musk, ma tutti i giganti della Silicon Valley stanno investendo, con una prodigalità di fondi con cui nemmeno le finanze degli stati sovrani possono competere.

3. L’agenda politica

In prima istanza, occorre sottolineare che Elon Musk, come altre Big Tech, coltiva un progetto antropologico, cioè una vera linea politica, attribuendosi un compito cui le classi dirigenti dei principali paesi occidentali hanno abdicato da anni. Il transumanesimo sogna un futuro di superuomini con ipertrofia di prestazioni fisiche e intellettuali, dovuta ad un doping permanente di innesti tecnologici, elargito a pochi o a molti (secondo l’opportunità comunicativa del momento) – ma comunque assicurato all’élite più smart del mondo, quella degli innovatori con sede in Silicon Valley. D’altra parte sono loro a prevedere e a pianificare l’evoluzione della salute, dell’abitazione, della convivenza, attraverso la rivoluzione delle applicazioni smart della wearable technology, della smart home e della smart city. Meritano il meglio della bulimia di potenza che sopraggiungerà con le AI, inclusa l’immortalità con (versione Kurzweil) o senza (versione Musk) il trasloco della personalità in un corpo di silicio.

Si può ironizzare su questo disegno per il futuro dell’umanità, che sembra estratto dai cartoon dei supereroi, ma bisogna riconoscere anzitutto che, contrariamente alla vacuità a corto raggio delle agende politiche delle classi dirigenti internazionali, Musk dispone di un piano con una visione di ampia portata, declinato in progetti che dal punto di vista finanziario camminano con le proprie gambe, senza attendere interventi pubblici – e spesso in grado di rastrellare investimenti da fonti terze. La forza economica e l’ambizione delle sue imprese sono in grado di attirare i ricercatori di maggiore talento, e di configurare la salute e i servizi del futuro. Dal Rinascimento gli intellettuali sanno di poter scorgere un orizzonte di verità più ampio, perché la posizione del loro sguardo è sorretta dalle spalle dei giganti del passato, di cui ereditano l’esperienza. Noi oggi dobbiamo sospettare di essere scesi dalle spalle ai piedi, dal momento che la ricerca cammina con le gambe di Musk, di Kurzweil e dei loro alleati. Poiché sono tutti soggetti privati, e il loro intervento sta sostituendosi al welfare pubblico, reimpostandone la definizione e i contenuti, è legittimo domandarsi se ci dobbiamo preparare ad un futuro prossimo in cui l’umanità (anche occidentale) avrà una nuova struttura sociale: sarà divisa in una piccola élite che può aspirare ad una qualità della vita altissima e ad una longevità di larghe falde – ancorché non infinita – e in una massa di individui esclusi da questa prospettiva, e dipendenti dal tipo di formazione culturale, di offerta di intrattenimento, di selezione commerciale, che proverrà da questi stessi soggetti privilegiati.

4. Lussi che non ci possiamo permettere

All’inizio degli anni Settanta lo psicologo comportamentista Burrhus Skinner aveva dichiarato senza reticenze che la libertà è un lusso che non ci possiamo permettere. Il condizionamento operante che aveva sperimentato ad Harvard (e non solo, secondo le tesi di chi lo considerava molto integrato negli apparati della CIA e della NATO) doveva condurre ad una società ordinata, dove la libertà era consentita a tutti coloro che condividevano l’ideologia dello Stato, pronta a respingere qualunque seduzione della propaganda bolscevica. Qualora davvero riuscisse a funzionare, anche solo in parte, Neuralink potrebbe riuscire dove il metodo di Skinner ha fallito: un chip di AI innestato direttamente nel cervello, con un potenziale di innervazione a banda larga, può agire come uno strumento di controllo e di condizionamento di massima efficacia. Le gambe ci porteranno dove l’ordinamento sociale programma che le nostre attività saranno di maggiore utilità, e le mani cliccheranno sui pulsanti che saranno indicati dalla pubblicità veicolata dalle concessionarie di Musk. Uno scenario distopico molto più spaventoso, e comunque meno irrealistico, di quelli che Elon Musk si impegna a propagandare sull’intelligenza artificiale generale – in particolare quella non dominata da lui in prima persona, o dagli amici della setta degli Altruisti Efficaci.

Le tecnologie non sono neutrali. La lezione dimenticata del determinismo tecnologico

Il determinismo tecnologico (DT), nella sua forma più pura, è un approccio che vede le tecnologie e le innovazioni come indipendenti dalla più ampie dinamiche sociali.

L’idea è che la tecnologia sia il fattore determinate delle vicende umane e gli sviluppi tecnologici non siano guidati dall’attività umana, ma da una logica interna all’innovazione scientifica.

Un esempio è il concetto di blockchain e cryptovalute che, secondo chi li promuove, sono liberi dalla manipolazione del potere istituzionale e generano effetti sociali in modo autonomo; un secondo esempio è la IA che, secondo alcuni sostenitori in grado aumentare le capacità umane e di rivoluzionare settori quali la finanza, sicurezza nazionale l’assistenza sanitaria ecc.

I principi del DT sono tre:

- la tecnologia rappresenta una dimensione esterna rispetto alla società, in grado di agire al di fuori di essa;

- ogni cambiamento tecnologico produce un cambiamento nelle forme di organizzazione e di interazione sociale;

- la società si adatta alla tecnologia.

Il DT è stato molto criticato dagli Science and Technology Studies (STS), tra la fine degli anni ‘70 e l’inizio degli ’80, , ritenuto un approccio obsoleto, se non addirittura sbagliato, e “ridotto allo status di uno spaventapasseri” (Lynch 2008, 10).

Infatti, sociologicamente parlando, risulta difficile sostenere che le innovazioni tecnologiche riescano a plasmare in maniera univoca la nostra vita quotidiana.

Per cui è più interessante impostare delle analisi in cui, si tiene conto di una serie di dinamiche che le tecnologie innescano, senza però farsi affascinare troppo e senza pensare che queste siano le uniche possibili.

Dunque, è più corretto parlare di tre forme di DT:

- forte: la tecnologia impatta sulla società e rappresenta il principale motore del cambiamento sociale;

- media: la tecnologia determina lo sviluppo sociale e le possibilità d’azione dei soggetti;

- leggera: la tecnologia influenza la società e orienta l’innovazione sociale.

Quindi, cosa possiamo salvare del determinismo tecnologico?

Ciò che di buono ha messo in luce il DT è che le tecnologie non sono neutre, ma producono degli effetti. Ovviamente poi possiamo discutere l’intensità di questi effetti. Ma un approccio sociale alle tecnologie deve partire dall’idea che la tecnologia non sia qualcosa di neutrale. Se così non fosse, le tecnologie sarebbero materia solamente per gli ingegneri o tecnologi. Invece, anche gli scienziati sociali possono dire la loro, partendo proprio dall’idea che la diffusione di una tecnologia è legata al proliferare delle dinamiche d’uso.

Quest’ultima idea è stata evidenziata da un altro approccio alle tecnologie: Social Construction of Technology (SCOT). Una delle lezioni fondamentali dello SCOT è che le tecnologie e i loro effetti, vanno misurate sempre in relazione ad altre cose, come l’infrastruttura esistente in un contesto o i gruppi sociali che entreranno in contatto con la tecnologia. Secondo lo SCOT non c’è niente di predeterminato nelle tecnologie; quindi, una nuova tecnologia all’inizio è caratterizzata da un certo tipo di “flessibilità interpretativa” ovvero un periodo in cui alcuni gruppi sociali si approcciano a una tecnologia e ci vedono alcune cose: per alcuni potrebbe essere utile per i propri fini, mentre per altri potrebbe essere pericolosa. Durante questo periodo entrano in gioco diversi “gruppi sociali pertinenti” che cercano di orientare l’artefatto nella loro direzione in base ai loro interessi.

In questo modo si raggiunge una stabilizzazione della tecnologia, incorniciandola, con uno specifico significato d’uso e una forma in grado di tenere insieme le diverse istanze poste dai vari gruppi.

Dunque, guardare alla tecnologia, come fa il DT, come una variabile indipendente che si origina dall’innovazione scientifica e si “impone” agli attori, determinandone le pratiche, le relazioni e le interazioni, risulta troppo radicale. Non è detto che se la tecnologia funziona in un determinato modo, allora le persone dovranno adattarsi e sforzarsi di far funzionare la tecnologia in quello stesso modo.

Risulta difficile pensare che la tecnologia offra determinati input alla società e che questa non possa far altro che adattarsi passivamente. Certo, le tecnologie non sono neutrali, ma diventano quello che sono nel momento in cui gruppi di utenti se ne appropriano, ad esempio un computer può essere utilizzato per lavoro, per lo studio, per giocare, guardare film ecc.

Il punto è che le tecnologie più diffuse sono quelle che vengono utilizzate nei modi più vari, ognuno le usa in base ai propri interessi, problemi, fini e attività quotidiane, permettono dunque una varietà di usi. Di conseguenza l’innovazione vincente non è tale soltanto perché contiene un elemento tecnico migliore o superiore ad altri, ma perché attraverso quell’elemento tecnico riesce a soddisfare una serie di istanze sociali.

Proviamo ora a fare un passo in avanti, attraverso un altro approccio alla tecnologia, l’Actor Network Theory (ANT), ovvero “un semplice metodo per imparare dagli attori senza imporre loro una definizione a priori circa la loro capacità di costruire il mondo” (Latour 1999, 20). Si tratta di un metodo che guarda alla realtà e agli attori senza partire dal presupposto che questi ultimi abbiano un qualche tipo di agency a priori. Attori umani e non-umani sono ugualmente capaci di dare forma ai processi che conducono all’emergere di un’idea, di una conoscenza o di una tecnologia.

Ma quindi in che modo possiamo descrivere il ruolo che hanno le tecnologie?

Una prima risposta è di guardare come gli oggetti intervengono all’interno delle azioni e delle pratiche e come le trasformano. Una nozione classica dell’ANT, è quella di script, ovvero ciò che è inscritto in un artefatto. L’idea è che nel processo di progettazione vengano inscritte, dai progettisti e designer, delle sceneggiature negli oggetti, dei copioni o delle istruzioni su come questi si devono utilizzare; e sono in grado di delineare ruoli, competenze e possibilità d'azione per chi interagisce con tale oggetto. In altre parole, inscrivono una certa idea di utilizzatore e per farlo introducono nell’oggetto alcune caratteristiche che riguardano le competenze dell’utilizzatore e delineano programmi d’azione e ruoli.

A questo punto potrebbe sembrare che lo script rappresenti solamente una serie prescrizioni e proscrizioni inscritte dal progettista e quindi una sorta di determinismo tecnologico, ma non è così. Il concetto di script è un concetto aperto, non ricade all’interno del determinismo tecnologico, è un partire dal presupposto che gli oggetti hanno una loro agency e contribuiscono in vari modi allo sviluppo di una azione, ma non la determinano mai.

Possiamo identificarne due aspetti. Il primo è l’inscrizione: progettisti e designer che tentano di inscrivere un qualche tipo di comportamento o azione nell’oggetto. In questa concezione l’oggetto un po' scompare. Il secondo è ciò che si ritrova inscritto nell’artefatto, ovvero il modo in cui le competenze, le possibili azioni, i ruoli degli utilizzatori sono effettivamente inscritti nell’artefatto. In questo senso l’oggetto assume una sua autonomia di cui dobbiamo tenere conto, il progetto dei designer non esaurisce le possibilità di un oggetto, ma ha una sua autonomia anche perché poi interagirà con altri oggetti e sarà sempre in trasformazione. In altre parole, si tratta di guardare le affordance (Gibson 1979), ovvero tutte quelle possibilità che gli utenti intravedono negli oggetti a partire dalle loro caratteristiche materiali e che non erano state previste dai progettisti. In questo modo gli utenti hanno l’occasione per fare qualcosa di diverso con l’oggetto che hanno di fronte.

In conclusione, la lezione del determinismo tecnologico è valida ancora oggi con alcune sfumature, ma il punto è che le tecnologie non sono neutrali. Gli STS sostengono la necessità di coltivare un approccio più “simmetrico” ai fenomenti sociali guardando alle tecnologie come pratiche sociali, ovvero si comprende l’utilità, la rilevanza, quando se ne osserva l’uso in contesti concreti. L’idea che sta dietro al concetto di affordance è che tutti quanti gli oggetti abbiamo un loro uso e ci pongono dei vincoli, però possiedono delle caratteristiche materiali che possono essere lette da chi li utilizza come inviti ad un uso diverso. La direzione non è quella di fermarsi a guardare la tecnologia-in-sé, ovvero come qualcosa che funziona ed è efficace indipendentemente dai suoi utilizzatori e contesti d’uso pratici. Piuttosto quello di focalizzarsi sulla tecnologia-in-uso (Orlikowski 1992; 2000; Gherardi 2008), ovvero come gli oggetti vengono ri-significati nella pratica, di conseguenza questi non nascono “efficaci” o “sicuri”, ma lo diventano nel momento in cui una comunità di utilizzatori, in specifici contesti d’uso, li costruisce come tali.

RIFERIMENTI

Gherardi S. (2008), La tecnologia come pratica sociale: un quadro interpretativo, in Gherardi S. (a cura di) Apprendimento tecnologico e tecnologie di apprendimento, Il Mulino, pp. 7-44.

Gibson J.G. (1979), Per un approccio ecologico alla percezione visiva, Angeli (ed. It. 1995)

Latour B. (1999), On recalling ANT, in “Actor Network Theory and After”, in J. Law, e J. Hassard (a cura di), Oxford, Blackwell, pp. 15-25.

Lynch M. (2008), Ideas and perspectives, in E Hackett, O. Amsterdamska, M. Lynch e J. Wajcman (a cura di), The Handbook of Science and Technology Studies, Cambridge, MIT Press, pp. 9-12.

Orlikowski W.J. (1992), The duality of Technology: Rethinking the Concept of Technology in Organization, in “Organizational Science”, Vol. 3, n.3, pp. 398-427.

Orlikowski W.J. (2000), Using Technology and Constituting Structures: A Practice Lens for studying technology in organizations, in “Organization Science”, vol. 11, n.4, pp. 404-428.

Immagine analogica ed Intelligenza Artificiale - Due mondi apparentemente distanti

Questo post nasce dal seminario tenuto da Diego Randazzo, artista visivo, sul tema “Immagine analogica ed Intelligenza Artificiale. Due mondi apparentemente distanti”.

Randazzo ha illustrato alcune funzionalità dei sistemi dialogativi di Intelligenza Artificiale text-to-image come, ad esempio Dall-E o Midjourney, nella generazione di immagini partendo da altre immagini o da una serie di specifiche dettate su una linea di comando.

Queste peculiari funzionalità della IA generativa permettono ad un artista di far generare ai sistemi delle immagini su cui poi intervenire per creare lavori del tutto personali. Oppure, dà la possibilità di generare anche immagini ibride, come, a titolo di esempio, quella di una tavolata che meticci l’Ultima cena di Leonardo da Vinci e le tavole da pranzo di Vanessa Beecroft.

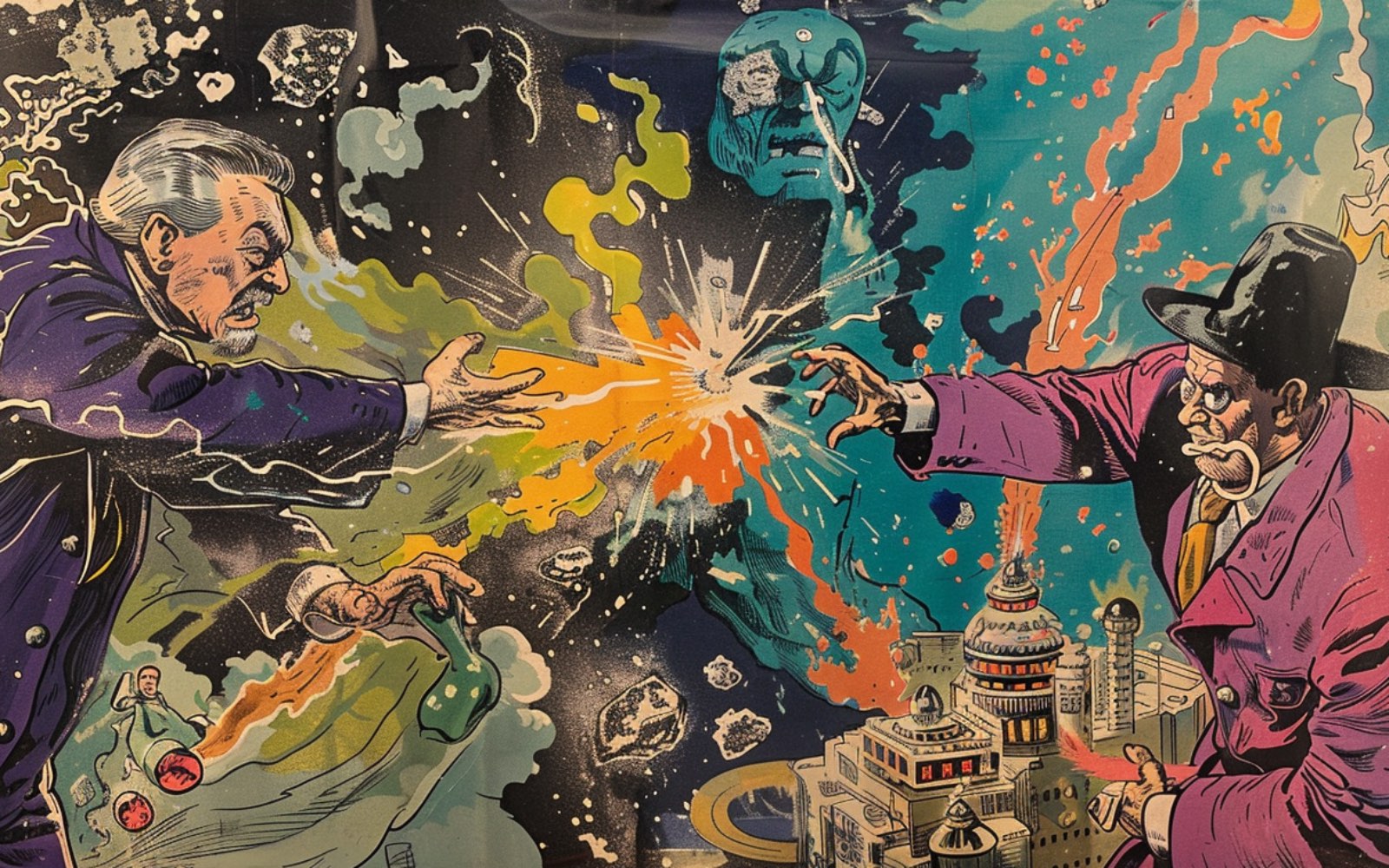

Questi di seguito sono esempi generati in tempo reale durante il seminario:

Comando:

Ultima cena di Leonardo, tavola da pranzo Vanessa Beecroft

Comando:

Ultima cena di Leonardo e Les Demoiselles D'Avignon di Picasso

Comando:

Un Pollock ed un Mondrian

La narrazione e gli esempi hanno suscitato una serie di interrogativi sulle nozioni caratteristiche del discorso artistico, in termini epistemologici e filosofici, interrogativi a cui Randazzo risponde in questo articolo.

--------

Paolo Bottazzini: La possibilità di derivare da regole statistiche un'istanza visiva o sonora, la rende un'opera d'arte o un modello possibile per un'opera d’arte?

Diego: Io parlo spesso di reference, di approccio critico e di didattica. Questi fanno parte dell’opera d’arte, ma sono solo alcuni degli elementi che dovrebbero scaturire da un’opera d’arte.

Parallelamente si può tranquillamente dichiarare, che la generazione di un’immagine con l’AI è l’inizio di un processo che può portare alla creazione di un’opera, ma non è esaustivo.

E penso - scusate la provocazione - che questo discorso valga per tutti quegli strumenti che nel corso della storia sono stati designati come strumenti a disposizione dell’artista: matita, pennello, sgorbia, scalpello, macchina fotografica, cinepresa, videocamera, computer.

Infine, le regole statistiche a cui accennate, non possono essere controllate dall’utente che, forzatamente, si deve accontentare dei risultati ricevuti. Questo mi ricorda un po’ il gioco di matrice surrealista denominato Cadaveri squisiti (cadavre exquis), a mio parere contributo fondamentale alla definizione di collage. Non stiamo in fondo parlando di questo? Associazioni e combinazioni testuali e visive, spesso incontrollate e provenienti da fonti diverse.

Quindi la descrizione che suggerite mi sembra appropriata, aggiungendo un trattino: l’AI come modello-strumento possibile per creare un'opera d’arte. Ci sono diverse modalità di utilizzo dell’AI per creare immagini; tra tutte credo sia molto affascinante la funzione che permette di espandere un ‘immagine preesistente, caricata nel software di AI.

Il ‘riempimento generativo’, lo considero una sorta di strumento conoscitivo, che a partire da qualcosa di personale (es. un’immagine dell’autore) permette di amplificare ed espandere l’universo visivo dell’autore stesso.

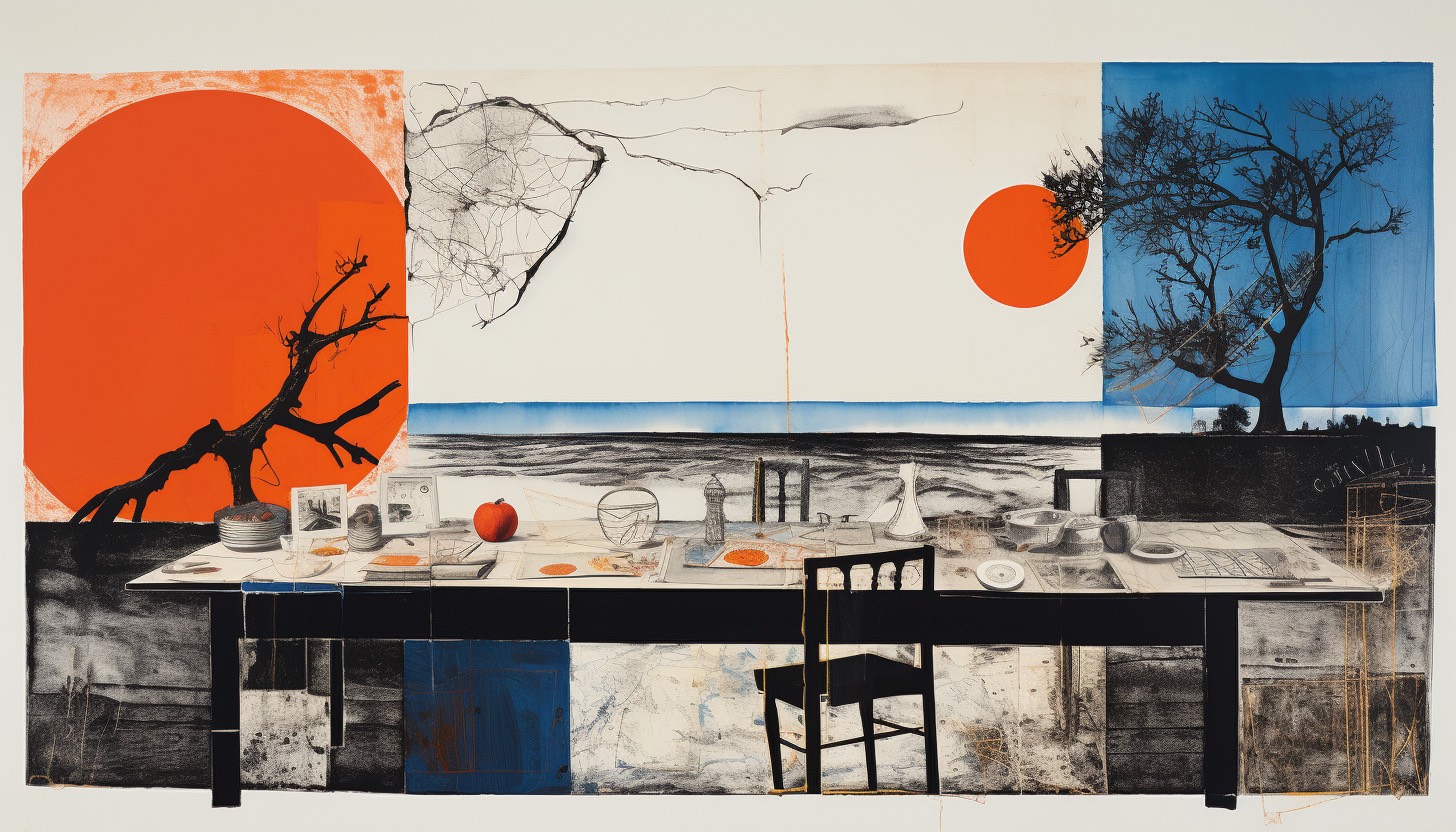

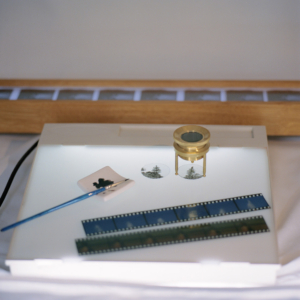

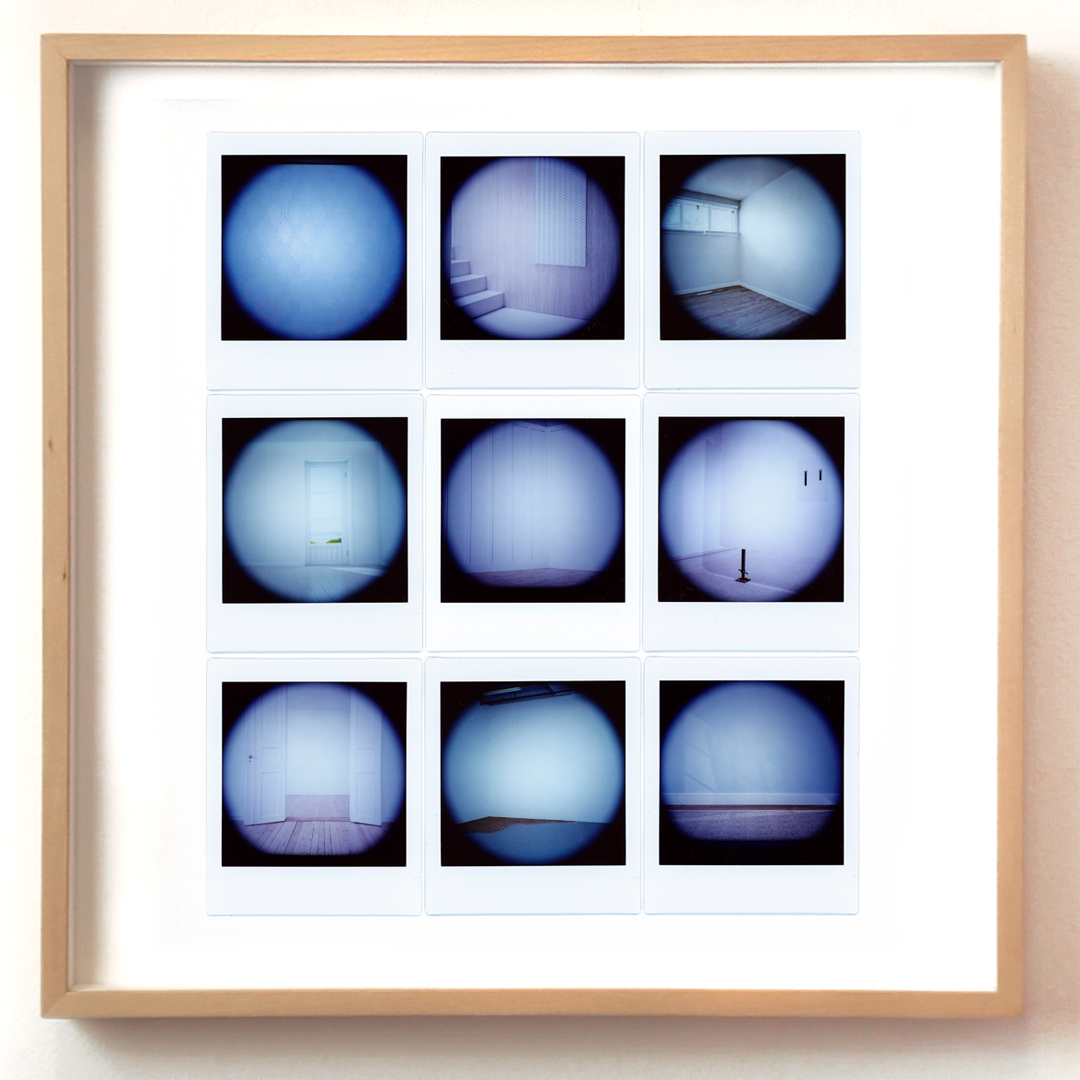

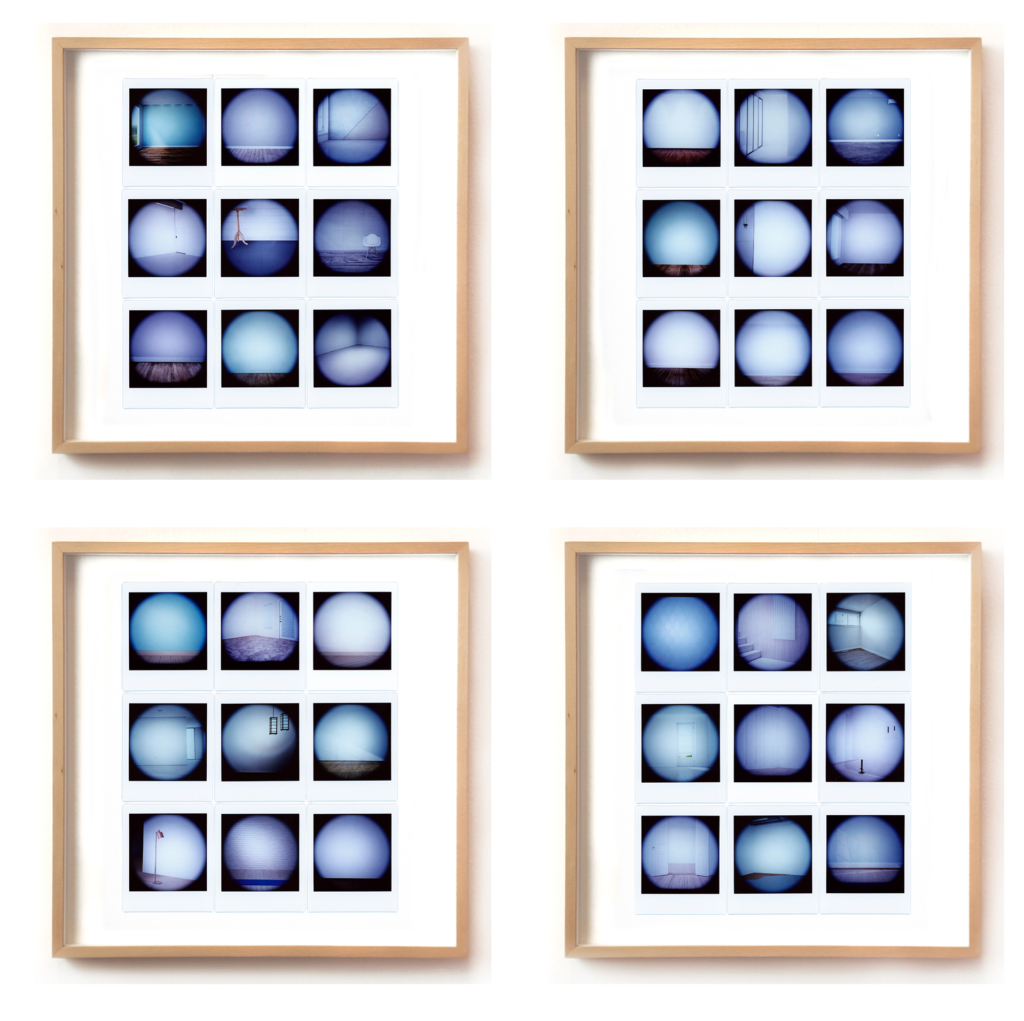

Riporto qui di seguito uno dei primi esperimenti realizzati con Dall-E a partire da alcune fotografie realizzate in pellicola medio formato (estratte del mio progetto Illusorie visioni d’argento del 2018). La prima immagine è lo scatto originale, le successive sono le espansioni generate con l’AI. E’ evidente come il rapporto che si instaura tra originale e rielaborazione AI è molto significativo, c’è una forte connessione tra due mondi che tendenzialmente teniamo separati. Qui, la concretezza del manufatto analogico e l’intangibilità dell’immagine sintetica si toccano e diventano un tutt’uno.

Lenti d’ingrandimento in ottone, becher, pellicole di piccolo e medio formato, macchine fotografiche analogiche… a questi oggetti/soggetti provenienti dal mondo proto-fotografico sono accostati altri della natura più varia (frutta e verdura imprecisata, gelatina alla menta, piante, droni, congegni elettrici, elettronici, digitali ed immagini olografiche) disposti su improbabili limbi e tavoli da lavoro componendo un eterogeneo repertorio di composizioni panoramiche. Ad una prima occhiata ci paiono dei set fotografici che strizzano l’occhio all’ambito still-life, ma avvicinando lo sguardo qualcosa non funziona. Il progetto "Elegie dell'impossibile verosimile" è un’inedita opera meta-fotografica, non ancora pubblicata, che esplora la relazione tra mondo analogico e digitale. Ogni composizione è creata a partire da uno scatto in medio-formato e successivamente combinata con altre immagini generate con il software di intelligenza artificiale Dall-E 2, che analizza un testo descrittivo e genera immagini corrispondenti. Il lavoro sperimentale affronta il tema dell'autenticità delle immagini nella contemporaneità, considerando la macchina come una possibilità di estensione poetica dell'immaginario dell’artista.

Di seguito, alcune immagini tratte da Illusorie visioni d’argento (2018), dove la prima immagine è lo scatto originale, eseguito con pellicola fotografica di medio formato, e la seconda è l'espansione dell’immagine realizzata con Dall-E.

Non a caso, nel corso del seminario di Controversie, puntavo proprio a delineare un percorso di analisi che intravede nell’immagine analogica l’antecedente concettuale della funzione generativa nell’AI.

Il mio punto di vista, sicuramente non allineato alle maggiori correnti di pensiero sul fenomeno, vuole dimostrare che alcune tendenze visuali attuali dell’AI (la dimensione distopica, disturbante, deformante da una parte e la tendenza del vintage dall’altra) non solo sono vicine, ma sono in perfetta continuità con il mondo analogico e protofotografico.

Ecco alcune linee guida, per punti, che sono state oggetto di discussione durante il seminario:

L’immagine analogica ed un certo uso dell’Intelligenza Artificiale hanno in comune la sorpresa, il mistero e la casualità. Sorpresa e mistero erano già presenti nei congegni del Precinema (le vedute ottiche dei Mondi Nuovi, vetrini e lanterne magiche, fenachistoscopi, zootropi, mutoscopi e diorami).

La sorpresa negli occhi dello spettatore ottocentesco di fronte ai congegni del Precinema (molti di questi basati sulla persistenza retinica) in qualche modo è simile a quella del pubblico di oggi davanti ad un’immagine elaborata con l’AI; stiamo parlando di quello spaesamento prodotto da qualcosa di nuovo che non riusciamo a cogliere completamente, ma che ci affascina e ci rapisce.

La casualità e l’attesa: non è possibile conoscere a priori il risultato di un’elaborazione di immagine fatta con l’AI, come non è possibile conoscere istantaneamente il risultato di uno scatto analogico. Bisogna scontrarsi con l’attesa, la perizia e la pazienza. Di fronte ad un’interrogazione posta ad un software di AI non abbiamo ancora un controllo totale sul risultato, dobbiamo affidarci al mix di combinazioni proposte dall’algoritmo.

SORPRESA: Da un’interrogazione non sappiamo cosa aspettarci, e molto spesso il risultato che ci viene restituito è sorprendente (sia in termini negativi che positivi).

ATTESA: La risposta dell’AI non è istantanea. L’attesa contribuisce a creare mistero e aspettativa.

CASUALITÀ E UNICITÀ’: un mix di combinazioni algoritmiche formula un risultato che è sempre unico. A parità di richieste, se ripetiamo più volte la stessa interrogazione, il risultato sarà sempre diverso.

Nell’AI si possono notare alcuni filoni narrativi e formali:

-

- contenuti surreali, distopici ed iperrealisti (il loro successo si basa sull’effetto wow)