Tucidide e lo smartphone – Verità autoptica svelata dalle tecnologie quotidiane

TUCIDIDE E L’AUTOPSIA

In greco antico autopsia (αύτος, stesso + οψίς, vista) significa “vedere con i propri occhi” e, in senso esteso, “visione diretta” di un fenomeno.

Tucidide, storico greco del V secolo A.C., nella sua narrazione della Guerra del Peloponneso, adottò il vedere con i propri occhi[1] come criterio di attendibilità storica: «la vista dello storico è infallibile» (I, 22, 2), «il risultato di quella degli altri va sottoposto al vaglio della comparazione critica» (cit., ibidem).

Per compiere opera di verità[2], Tucidide dava per vero solo ciò a cui aveva personalmente assistito o che era stato visto con i loro occhi da persone che considerava attendibili. Si fidava solo dell’αύτοψία, appunto.

EVIDENZA INCONTROVERTIBILE DI UN MASSACRO

Il 30 marzo 2025, nel distretto di al-Hashashin di Rafah, la città più a sud di Gaza, l’Ufficio per il Coordinamento degli Affari Umanitari (OCHA - Office for the Coordination of Humanitarian Affairs) rinviene, sepolti sotto la sabbia in una fossa comune, i corpi di 14 paramedici e soccorritori della Protezione Civile, palestinesi, che operavano sotto le insegne della Mezzaluna Rossa e di un funzionario dell’ONU. (IFRC - International Federation of Red Cross and Red Crescent Societies)

A breve distanza, vengono ritrovati i resti di 5 ambulanze della Croce Rossa e di un veicolo dei pompieri.

I morti presentano i segni di spari esplosi a brevissima distanza nella testa e nel torace. Sono ancora vestiti con le tute e i giubbotti con le strisce riflettenti di riconoscimento delle unità sanitarie e di soccorso.

Del convoglio di cui facevano parte si era perso il contatto radio il giorno 23 marzo.

Tucidide non avrebbe nulla da dire, su questi elementi storici: sono tutti – tristemente – visti con i propri occhi dal personale della IFRC e dell’OCHA intervenuto sul posto.

RICOSTRUZIONE DEI FATTI E CONTROVERSIA

L’OCHA ricostruisce che:

«I corpi […] e i veicoli di soccorso – chiaramente identificabili come ambulanze, camion dei pompieri e automobile delle Nazioni Unite – sono stati colpiti dalle forze israeliane e poi nascosti sotto la sabbia»[3]

Secondo J. Whittall, capo dell’OCHA nella Striscia di Gaza,

«le persone uccise domenica scorsa si trovavano a bordo di cinque ambulanze e di un camion dei pompieri e si stavano dirigendo verso una zona bombardata dall’esercito israeliano. I mezzi sono stati colpiti dal fuoco israeliano sebbene fossero visibilmente segnalati come veicoli di soccorso, e lo stesso è successo con un’automobile dell’ONU arrivata poco dopo»[4]

Dalle ferite trovate sui corpi, la ricostruzione suggerisce che i militari israeliani abbiano sparato ai soccorritori a distanza ravvicinata.

L’esercito israeliano ammette[5], dopo alcuni giorni, la propria responsabilità e diversi errori ma sostiene che:

- gli errori siano dipesi dalla scarsa visibilità notturna (riportato in corsivo perché è rilevante);

- distruggere le ambulanze e seppellire i corpi servisse a metterli al riparo e sgomberare la strada;

- l’attacco fosse comunque giustificato dalla presenza di membri di Hamas.[6]

AUTOPSIA E VERITÀ: IL RUOLO DI UNA TECNOLOGIA QUOTIDIANA

Tucidide non ammetterebbe al rango di verità che nel convoglio ci fossero dei membri di Hamas: non l’ha visto né provato nessuno. Lo stesso vale per la necessità di distruggere le ambulanze al fine di metterle al riparo e a liberare il percorso: è un’opinione soggettiva, incontestabile ma – nello stesso tempo – inammissibile nella narrazione storica.

Invece, che ci fosse scarsa visibilità è una falsità evidenziata dal ritrovamento dello smartphone di una delle vittime.

Tra i documenti nello smartphone c’è - infatti - un filmato in cui si vede (e si sente) chiaramente che il convoglio si muoveva con i lampeggianti di segnalazione accesi e le sirene in funzione; che il personale vestiva – come, d’altra parte, è stato testimoniato dal ritrovamento dei corpi – l’abbigliamento di riconoscimento; che l’attacco è stato effettuato nonostante tutto questo; e che i colpi sono stati esplosi da vicino.[7]

Lo smartphone ha svolto, in questo caso il ruolo di agente autoptico: è stato il testimone oculare desiderato da Tucidide e il video è la vera e propria αύτοψία dell’accaduto.

L’ αύτοψία per mezzo di una tecnologia quotidiana ha permesso agli osservatori di compiere opera di verità e smentire le menzogne delle forze armate israeliane, che cercano di nascondere – come è, a questo punto, evidente anche dal tentativo di velare le prove fisiche sotto la sabbia – il massacro di persone intoccabili per statuto internazionale, quali sono gli operatori di soccorso e quali dovrebbero essere i civili.

D’altra parte, è anche grazie alle tecnologie della televisione con tutti i suoi apparati di comunicazione che siamo tutti testimoni oculari, agenti autoptici di una guerra combattuta soprattutto contro la popolazione civile.

Guerra di cui – senza queste tecnologie – con elevata probabilità, non conosceremmo nulla.

Tucidide sarebbe soddisfatto: la verità – termine a lui molto caro – emerge in virtù di una αύτοψία, tecnologica.

NOTE

[1] Erodoto, in realtà, fu il primo a pensare che “vedere con i propri occhi” fosse il principale criterio di verità storica.

[2] Cfr. L. Canfora, Prima lezione di storia greca, Laterza, 2023 e Tucidide. La menzogna, la colpa, l’esilio, Laterza, 2016

[3] Cfr. https://www.facebook.com/watch/?v=2189635674800875, traduzione mia

[4] Cfr.: Il Post, Lunedì 31 marzo 2025

[5] Cfr.: Il Post, 20 aprile 2025 e New York Times, 20 aprile 2025

[6] La presenza di membri di Hamas non è provata in alcun modo, come in molti altri casi di attacchi israeliani contro aree ed edifici civili. Non c’è traccia di testimonianza né oculare

[7] Cfr. ancora https://www.facebook.com/watch/?v=2189635674800875

Apocalittici ed integrati - Due visioni sull'innovazione che possono coesistere

Qualche mese fa, parlando dell’A.I. Act – la nuova legislazione europea sull’intelligenza artificiale – abbiamo ricordato che: nel 45 a.C. Giulio Cesare promulgò una legge sulla circolazione dei carri nei centri abitati – dall’alba alla metà del pomeriggio[1], con l’obiettivo di snellire il traffico urbano, ridurre la sporcizia (sterco dei cavalli), l’odore e il rumore nelle strade durante il giorno (non è cambiato nulla, mi pare). Era una legge che regolava l’impatto della tecnica (i carri con le ruote cerchiate) sull’ambiente urbano. E che, nel 1865 in Gran Bretagna venne emesso il Red Flag Act[2] che impose alle autovetture (self-propelled vehicles, la tassonomia è importante: distingue dalle vetture a cavalli) di avere un equipaggio di almeno 3 persone, di non superare la velocità massima di 4 miglia orarie sulle strade fuori città e di 2 miglia orarie in città, di essere precedute a 60 yarde da un uomo a piedi con una bandiera rossa che ne segnali l’arrivo, regoli il passaggio di carrozze e cavalli e, infine, faccia fermare il veicolo a motore in caso di necessità.

Sono due esempi di come vengono accolte le innovazioni tecniche e tecnologiche. Interesse, entusiasmo, da parte degli integrati[1]; timore, opposizione, da parte degli apocalittici sono alcune delle reazioni che – storicamente – accompagnano la diffusione di novità, soprattutto tecniche e tecnologiche.

Nel 1872 Samuel Butler, in Erewhon, romanzo utopico-distopico, analizza la dicotomia tra entusiasmo e opposizione verso la tecnica delle macchine. Nei tre capitoli “il libro delle macchine” ecc. Butler riconosce che «Le macchine hanno determinato le condizioni di crescente abbondanza, agiatezza e sicurezza che consentono all’essere umano di coltivare il suo spirito, la sua cultura, il suo essere civilizzato; la loro influenza si manifesta sul corpo quanto sulla mente umana»(Robin Libero Carbonara, Il Dominio della Macchina: dagli scenari ipotetici di Erewhon alla realtà delle piattaforme digitali di The Circle, https://doi.org/10.6092/issn.2785-3233/19133) ma, nello stesso tempo «appare precocemente consapevole che alla lunga, man mano che la Macchina, divenendo più complessa, influenza maggiormente la vita dell’uomo, ne influenza in maniera determinante la coscienza e la percezione di Sé» (Cit.) in maniera perniciosa.

“Man’s very soul is due to the machines; it is a machine-made thing: he thinks as he thinks, and feels as he feels, through the work that machines have wrought upon him”

L’analisi lucida di Butler – che, in realtà, nasceva per rispecchiare e criticare la società vittoriana – indica, appunto, che le tecniche nuove, innovative, generano due grandi categorie di reazioni. Entusiasmo, in coloro che ne vedono soprattutto (o soltanto) le potenzialità positive e che, in termini molto generali, corrispondono con chi si identificano con l’istanza morale della necessità e bontà dello sviluppo e del progresso. Rifiuto o opposizione, recisa o più prudente, in quelli che vedono nelle innovazioni anche (o solo) i possibili effetti negativi, le lateralità, i rischi che possono annullarne la dimensione di beneficio.

Se, oggi, osserviamo le reazioni della stampa di ampia diffusione nei confronti delle tecnologie digitali emergenti, dai social alle applicazioni dei modelli di intelligenza artificiale, assistiamo ad un fenomeno che conferma la dicotomia anticipata da Butler: la maggior parte dei titoli aderisce ad una delle due visioni: positivi, entusiasti - integrati - o fortemente critici, oppositivi – gli apocalittici.

Questo anche all’interno delle medesime testate, una volta in tono apocalittico, un’altra in tono di tipo integrato. Sono emblematici alcuni titoli della Rai:

- I rischi dell'intelligenza artificiale, coinvolte centomila aziende sardo. L'impatto "incontrollato" secondo un report di Confartigianato (TGR Sardegna, 15/06/2023)

- Da intelligenza artificiale sei rischi per il 2019 (Rai News.it, 13/01/2019)

- Disegnare e sognare ciò che sarà: non c'è nulla di più umano ma questa installazione l'ha creta l'IA (Rai News.it, 14/03/2025)

- "Obiettivo è semplificare la vita degli italiani nella Pubblica Amministrazione" L'Intelligenza Artificiale al centro della riunione ministeriale del G7 a guida italiana focalizzato su digitale e tecnologia. (Rai News.it, 15/10/2024)

Ora, questo genere di narrazione così polarizzata può essere analizzato ricorrendo ad un suggerimento dello storico Paul Veyne (“I greci hanno creduto ai loro miti?” (Il Mulino, 2014) a proposito dei greci antichi: in una stessa società[2] possono coesistere diversi regimi o programmi di verità. I greci antichi credevano nella mitologia olimpica che ha origine in Esiodo e amplificata e normata da Omero, perché era una sorta di habitus irrinunciabile. Ma, nello stesso tempo, la criticavano, ne riconoscevano la dimensione letteraria più che reale.

Veyne fa due esempi illuminanti: quello del perigeta Pausania che in 5 ponderosi libri racconta i miti locali – altari e sacrifici, dei ctoni e celesti ed eroi - delle principali regioni della grecia antica (verificare i titoli), aderendo alla narrazione mitologica e – a volte – riconducendo fatti della tradizione (che per i greci ha l’autorevolezza della storia documentata) alla dimensione mitologica. Nello stesso tempo, lo stesso Pausania prende le distanze da queste narrazioni e ammette che – con buona probabilità – sono un sacco di fandonie.

Due programmi di verità coesistenti, uno che corrisponde al lavoro di geografo e di narratore, l’altro alla personalità analitica e razionale dello stesso soggetto.

Il secondo esempio, che evidenzia come due diversi programmi di verità possono coesistere in una stessa persona, adattandosi a diverse esigenze, è quello del medico e farmacista Galeno. Galeno, di fronte alla tradizione medica che indica nella bile di centauro il rimedio per mitigare l’apoplessia ne denuncia l’assurdità, perché “nessuno ha mai davvero visto un centauro”. Galeno, in questo caso singolare non aderisce alla verità del mito. Tuttavia, Galeno è un maestro, ha una scuola di medicina e di farmacia, e di quella vive; per attirare studenti e adepti non esita a contraddire la propria critica del mito e riconduce il sapere della sua scuola all’insegnamento degli déi Apollo e Asclepio, suoi maestri!

Ecco, questa è la condizioni in cui molti di noi versano quando parlano di innovazione e – in particolare – di Intelligenza Artificiale: una condizioni di coesistenza di due diversi atteggiamenti, che possono essere ricondotti a due programmi di verità o epistemici, uno di apprezzamento, a volte entusiasmo, nei confronti delle funzionalità della tecnologia che ci semplificano la vita, e uno di perplessità o addirittura di rifiuto, generato dalla cognizione dei rischi e delle lateralità delle stesse funzionalità.

Nonostante l’apparenza schizofrenica, questo dibattito che vige all’interno della “nostra” società e – spesso – di noi come individui, è un dibattito sano, positivo, che stimola ad interrogarsi – da un lato – sulla dimensione morale delle tecnologie, su sviluppo “buono” e da distruttivo, su libertà di azione e su regolazione etica istituzionale; stto un altro punto di vista, invece, questo dibattito ha la funzione di stimolo ad interrogarsi sull’ontologia degli oggetti tecnologici e sulla linea di demarcazione tra ciò che è umano e ciò che non lo è, facendo delle ipotesi e delle scoperte teoretiche interessanti e a volte sconcertanti.

Di questo ne parleremo ancora.

NOTE

[1] Umberto Eco definì gli intellettuali (e si riferiva, in particolare ad Adorno e Zolla) fortemente critico e nei confronti della moderna cultura di massa, e “integrati” coloro che ne hanno una visione ingenuamente ottimistica; la definizione è diventata uno schema comune di rifermento per i due approcci opposti nei confronti del contemporaneo. (Apocalittici e integrati, Bompiani, 1964)

[2] Intesa come gruppo sociale e periodo storico

Il luddismo, ieri e oggi – Paralleli, rischi e opportunità

LUDDISMO

Alla fine del XVIII secolo – in termini molto semplificati – l’introduzione, nel sistema produttivo inglese, di tecnologie come la macchina a vapore e il telaio meccanico furono gli elementi catalizzatori di una profonda trasformazione del sistema socioeconomico britannico.

Al timone di questa trasformazione – sempre semplificando al massimo – ci fu la nuova borghesia capitalista inglese che comprese l’enorme potenzialità produttiva delle nuove tecnologie, che potevano: affrancare il sistema produttivo dalla dipendenza dalle competenze artigianali; permettere la concentrazione industriale in “nuovi” luoghi in cui controllare in modo pervasivo i lavoratori e obbligarli a mantenere alti tassi di produttività; abbattere il costo della manodopera grazie ad migliore (per gli industriali) rapporto tra domanda e offerta di lavoro. In definitiva, moltiplicare in modo geometrico la produzione con costi altrettanto ridotti.

Il punto di vista dei lavoratori tessili – che in buona parte lavorava manualmente, a cottimo, in piccole fabbriche oppure a casa propria, controllando di fatto i mezzi di produzione e valorizzando le proprie competenze artigianali – era esattamente speculare a quello degli industriali: riduzione dei salari e della domanda di lavoro, annullamento del valore delle competenze, scelta tra disoccupazione e lavoro malpagato nelle nuove grandi fabbriche.

Una delle forme di reazione alla drammatica trasformazione fu una serie di rivolte, iniziate nel 1811, ispirate alla figura – forse leggendaria – di Ned Ludd, un operaio che nel 1779 avrebbe distrutto un telaio meccanico in segno di protesta contro la nascita di questa nuova forma di produzione: il fenomeno del “luddismo”.

Il movimento luddista durò fino verso il 1824, tra leggi repressive – come la Frame Breaking Bill che prevedeva la condanna a morte per chi avesse danneggiato i telai per calze o pizzi, o altre macchine per la produzione tessile – tumulti, ondate di distruzione delle macchine, appoggio di massa da parte della popolazione, soprattutto nello Yorkshire, sostegno di alcuni parlamentari illuminati e scontri violenti con la polizia e l’esercito.

I cambiamenti sociali e politici che seguirono il crollo dell’impero napoleonico, la promulgazione delle Corn Laws, con i relativi dazi protezionistici e l’ulteriore gravissimo impatto sulle condizioni economiche dei ceti popolari, uniti alla nascita delle Trade Unions, primi sindacati operai, decretarono la fine della protesta luddista.

IERI E OGGI

Sembra possibile trovare un parallelismo tra la percezione dei ceti operai del XIX secolo che fu alla base del luddismo e l'attuale preoccupazione nei confronti delle radicali trasformazioni del tessuto produttivo delineate dallo sviluppo e della adozione di tecnologie di Intelligenza Artificiale.

Oggi come allora, l'innovazione tecnologica suscita timori, resistenze e opposizione al “nuovo progresso”.

Tra chi progetta e sviluppa – singoli individui o grandi imprese che siano - le tecnologie di Intelligenza Artificiale sembrano pochi a porsi il problema delle conseguenze sull’occupazione, sui salari, sul benessere dei lavoratori “tradizionali”; si procede con entusiasmo, in nome del progresso tecnologico, del superamento di ostacoli e di barriere fino a ieri considerati impossibili, dell’avvicinamento della macchina alle performance umane.

Anche tra gli studiosi di I.A. sensibili a questi problemi, l’eccitazione per i risultati sembra appannare la visione umanista. Un esempio è quello di Nello Cristianini, studioso e professore di intelligenza artificiale a Bath, che – nonostante l’impegno a rappresentare i rischi legati ad una massiva adozione di tecnologie I.A. – sembra farsi trascinare dall’entusiasmo per i nuovi sviluppi: «Dopo essere eguagliati, potremmo essere superati? E come? O la macchina diventa più brava a fare ciò che già facciamo, oppure la macchina impara a svolgere compiti che non sappiamo fare. A me interessa l’idea che riesca a capire cose che io non posso» (A. Capocci, Nello Cristianini, il ragionamento delle macchine, Il Manifesto, 14/03/2025).

I timori sembrano giustificati dal fatto che, in altri settori produttivi – come quello della realizzazione del software – si sta già generando uno scenario di sostituzione del lavoro dei programmatori con sistemi automatici basati sull'Intelligenza Artificiale, con una conseguente ondata di licenziamenti.

E, nei media e nelle discussioni pubbliche, viene dato grande risalto al rischio che il ruolo centrale dell'uomo in molte fasi della vita collettiva cui siamo abituati venga meno.

D’altra parte, però, per alcune occupazioni, l’utilizzo di strumenti di Intelligenza Artificiale permette a molti lavoratori e professionisti di delegare “alle macchine” compiti di basso profilo competenziale che richiedevano molto impegno di tempo, oppure attività ad elevato rischio fisico, migliorando le condizioni di lavoro.

POSSIBILITÀ

Ora, il fenomeno del luddismo e delle tensioni tra lavoratori, industriali e governo, come si verificò nel XIX secolo in Inghilterra, non sembra essere una possibilità, anche solo perché - nel caso dell’Intelligenza Artificiale - è difficile trovare qualcosa da distruggere.

E, tutto sommato, il fenomeno luddista sembra aver solo spostato avanti di qualche anno la trasformazione industriale e il suo correlato di cambiamento sociale, di inurbazione, di povertà e degrado nelle periferie, e di successiva - nel XX secolo - “normalizzazione” del lavoro in fabbrica.

Oggi, i punti da dibattere, in modo serio e puntuale, sono:

- come governare la I.A., anche facendo leva sulla sensibilità del problema anche a livello istituzionale, sensibilità da preservare e non lasciar catturare dagli intenti delle grandi industrie digitali [1]

- come capire quali reali opportunità di benessere potrà offrire ai viventi,

- come identificare i rischi dello sviluppo della tecnologia

- come evitare lo sviluppo in nome del solo “progresso tecnologico” e della sola remunerazione delle grandi aziende digitali.

Per farlo sono necessari: ● una difesa istituzionale che si metta rigorosamente dalla parte dei cittadini, ● attenzione e coraggio da parte di tutti - lavoratori, professionisti, manager e imprenditori - per identificare sul nascere le reali opportunità e i reali rischi e per infondere una coscienza morale tra chi queste tecnologie promuove e intende utilizzare.

NOTE

[1] Cfr.: A. Saltelli, D. J. Dankel, M. Di Fiore, N. Holland, M. Pigeon, Science, the endless frontier of regulatory capture, Science Direct, Futures, Volume 135, January 2022, 102860

Critica del soluzionismo tecnologico

Il sociologo Morozov ha coniato alcuni anni fa l'espressione "soluzionismo digitale" per indicare l'atteggiamento prevalente ai nostri giorni nei confronti dei dispositivi digitali.

Si ritiene che i problemi siano risolvibili da qualche algoritmo, e dagli strumenti che ne automatizzano l'applicazione alla realtà. Le smart city, le smart home, i dispositivi biometrici che indossiamo, sono alcune delle declinazioni di questa concezione: l'ottimizzazione del traffico nei centri urbani, del consumo energetico e degli scenari di abitabilità nelle case, della forma fisica individuale, sono sottratti alle decisioni collettive e personali, e vengono aggregati intorno ai pattern definiti dalla medietà dei comportamenti sociali.

Persino l'uso della lingua si stabilisce sull'ortografia e sull'ortodossia media, con i motori di ricerca le piattaforme di intelligenza artificiale generativa trasformativa - e lo stesso accade alla selezione delle informazioni più rilevanti per l'assunzione di qualunque decisione.

Si avvera al massimo grado la previsione che Adorno e Horkheimer avevano elaborato sulla dialettica della ragione illuministica, che nel momento in cui si libera dal giogo delle autorità tradizionali finisce per limitarsi alla selezione degli strumenti in vista del fine, ma non è più in grado di pensare le finalità stesse, e i principi che dovrebbero governarle.

Per di più, i dispositivi digitali vantano una proprietà che le tecnologie del passato non avevano mai tentato di pretendere. Servizi digitali come Google, Facebook, Instagram, Amazon, accumulano una mole di dati così ampia e profonda su ciascun individuo, da sapere sui singoli più di quello che i soggetti sanno di se stessi.

Questa espansione quantitativa si tramuta in una condizione qualitativa: la concezione liberale del mondo, che abbiamo ereditato dall'Illuminismo, pone l'individuo come valore fondamentale, collocando nella sua coscienza e nella sua libertà le chiavi di volta della società e della storia.

Oggi le grandi piattaforme digitali possono rivendicare una conoscenza sui singoli, e sui contesti in cui si muovono, superiore a quella di cui i soggetti stessi dispongono, e potrebbero quindi reclamare un diritto di decisione sulla loro vita quotidiana e sul loro destino fondandolo sulla maggiore capacità di prevedere le conseguenze di ogni gesto, su una maggiore razionalità, quindi su una maggiore assunzione di responsabilità per ogni scelta.

-------------

Bisogna sottoporre ad analisi critica questa narrazione, dalla confusione di dati e informazioni alla definizione di "decisione razionale", per evitare non solo che la distopia si avveri, ma anche per impedire che le sue (false) assunzioni ricadano nelle attuazioni parziali che il soluzionismo tecnologico tende ad agevolare, o persino ad imporre.

Recensione di "Eppure non doveva affondare - Quando la scienza ha fatto male i conti"

Il saggio Eppure non doveva affondare - Quando la scienza ha fatto male i conti (Bellucci D., Bollati Boringhieri, 2024) offre una riflessione approfondita sugli errori scientifici, mettendo in evidenza come questi non siano da considerarsi come semplici fallimenti ma opportunità, fondamentali per il progresso della conoscenza. Attraverso una serie di casi emblematici, l’autore mostra l’importanza di un’analisi critica e della capacità di apprendere dagli errori per migliorare le tecnologie e il metodo scientifico.

Uno degli ambiti in cui gli errori hanno avuto conseguenze drammatiche è l’ingegneria. Bellucci analizza alcuni fallimenti progettuali clamorosi, come quello degli aerei con finestrini quadrati. Questo design, apparentemente banale, si rivelò fatale: la forma degli angoli causava una concentrazione eccessiva delle sollecitazioni meccaniche, portando alla rottura della fusoliera in volo. Un altro caso emblematico riguarda le navi che si spezzano in due a causa di calcoli errati sulla distribuzione del peso e delle forze strutturali. Questi esempi mostrano quanto sia essenziale un’analisi accurata nella progettazione, perché anche il minimo errore può trasformarsi in una catastrofe.

Il libro si sofferma poi sugli errori nel campo dell’hardware e dell’informatica, mostrando come difetti nei microchip possano compromettere operazioni matematiche fondamentali. Un singolo errore nella progettazione di un processore può avere ripercussioni enormi, rendendo necessarie operazioni costose di aggiornamento o sostituzione. Anche nel software gli sbagli possono avere conseguenze impreviste e pericolose: sistemi che perdono la cognizione del tempo possono causare problemi gravi, soprattutto in ambiti critici come il settore bancario o le telecomunicazioni. A volte, persino un dettaglio apparentemente insignificante—come un cavo allentato—può mandare in fumo esperimenti scientifici di grande importanza.

Un altro ambito in cui gli errori possono avere conseguenze drammatiche è la medicina. L’autore analizza i problemi legati alla ricerca farmaceutica e alla produzione di medicinali, evidenziando come piccole variazioni nella formulazione o nella fase di sperimentazione possano rendere un farmaco inefficace o addirittura pericoloso. Inoltre, Bellucci mette in luce le criticità legate ai trial clinici, spiegando come un’interpretazione errata dei dati possa compromettere l’affidabilità delle cure e generare rischi per i pazienti.

L’intelligenza artificiale è un altro settore in cui gli errori assumono un ruolo centrale. Bellucci evidenzia i pericoli legati ai modelli predittivi, che possono produrre risultati distorti o discriminatori se vengono addestrati su dati errati. Un ulteriore problema riguarda la trasparenza: la cosiddetta “scatola nera” delle reti neurali rende difficile comprendere i meccanismi decisionali degli algoritmi, complicando l’individuazione e la correzione degli errori. Questo solleva questioni cruciali non solo dal punto di vista tecnico, ma anche etico.

Ma come si possono prevenire questi errori? Il libro dedica una sezione alle strategie utilizzate dalla scienza per ridurre i rischi e migliorare l’affidabilità delle scoperte. Tra queste, l’autore cita la peer-review nella ricerca accademica, il debugging nel software, i trial clinici randomizzati in medicina e l’uso della ridondanza strutturale in ingegneria, ovvero l’inserimento di margini di sicurezza nei progetti per evitare cedimenti improvvisi. Questi metodi mostrano che, pur non potendo eliminare completamente gli errori, è possibile limitarne gli effetti attraverso un’attenta verifica e un approccio sistematico.

Infine, Bellucci sottolinea come la scienza sia un processo collettivo: gli errori sono inevitabili, ma è proprio grazie al metodo scientifico che possono essere individuati, corretti e trasformati in nuove conoscenze. Il progresso non è mai il risultato del lavoro di un singolo, ma della condivisione e della verifica incrociata tra esperti. In definitiva, Eppure non doveva affondare offre una panoramica affascinante su come anche i più clamorosi fallimenti possano diventare strumenti preziosi per migliorare la nostra comprensione del mondo e affinare le nostre tecnologie.

DEVIS BELLUCCI

Devis Bellucci, nato nel 1977, è un fisico, scrittore e divulgatore scientifico italiano. Ha conseguito la laurea in Fisica nel 2002 e il dottorato nel 2006 presso l'Università degli Studi di Modena e Reggio Emilia, dove attualmente ricopre il ruolo di ricercatore in Scienza e Tecnologia dei Materiali. La sua attività di ricerca si concentra principalmente sui biomateriali per applicazioni in ortopedia, odontoiatria e medicina rigenerativa.

Oltre alla carriera accademica, Bellucci è autore di numerosi romanzi e saggi. Tra le sue opere narrative si annoverano "La memoria al di là del mare" (2007), "L'inverno dell'alveare" (2010), "La ruggine" (2011), "La sete dei pesci" (2013) e "La cura" (2017). Nel campo della divulgazione scientifica, ha pubblicato "Materiali per la vita. Le incredibili storie dei biomateriali che riparano il nostro corpo" (2020) e "Eppure non doveva affondare" (2024), in cui esplora gli errori nella scienza e le loro conseguenze.

Come divulgatore, Bellucci ha collaborato con diverse testate, scrivendo di scienza, viaggi e cultura. È attivo anche sui social media, attraverso i quali condivide contenuti legati alla scienza e alla tecnologia.

Biochar, il carbone amico

Quando pensiamo al carbone, andiamo subito col pensiero all’inquinamento, a colonne di fumo nero e denso e alle città coperte di fuliggine di non tanti decenni orsono. E, nonostante i progressi tecnologici che hanno reso progressivamente meno inquinanti i sistemi di combustione del carbone, questa visione è ancora attuale, perché il carbone è ancora largamente usato in tutto il mondo nelle centrali per la produzione di energia elettrica (circa il 30% dell’energia elettrica mondiale è prodotta da centrali a carbone, fonte IEA - International Energy Agency).

Ma in questo articolo parliamo di un altro tipo di carbone che - al contrario - ha delle proprietà che lo pongono agli antipodi del carbone fossile e dei suoi utilizzi: questo prodotto si chiama biochar e la sua scoperta è relativamente recente, i primi studi scientifici si devono al professor Johannes Lehmann della Cornell University negli anni 80.

Il biochar è il residuo carbonioso ottenuto dalla combustione in assenza di ossigeno di biomassa (materia organica). Qualsiasi tipo di biomassa di origine vegetale o animale, sottoposta al processo di combustione in assenza di ossigeno – pirolisi – produce biochar. Evidentemente la materia di partenza (feedstock), influisce sulle caratteristiche chimiche del prodotto finale.

Proviamo, qui, a dare una breve panoramica globale delle qualità di questo composto e a focalizzare un aspetto di particolare interesse, ovvero la sua capacità di stoccare CO2, diventando, quindi, anche un elemento per contrastare l’immissione di gas a effetto serra in atmosfera.

COME SI FA IL BIOCHAR

Il carbone vegetale si fa dalla notte dei tempi; in tutta l’Europa mediterranea c’erano le carbonaie dove si bruciavano residui legnosi per produrre carbone, il biochar è l’evoluzione scientifica di questo sapere antico.

Oggi esistono sofisticate apparecchiature che per produrre il biochar attivano un processo di combustione lenta a temperature di circa 500-600 gradi Celsius in assenza di ossigeno.

A partire dal feedstock introdotto, si realizzano essenzialmente tre prodotti:

- il biochar, ovvero la frazione solida del processo di pirolisi

- il syngas, i residui gassosi del processo

- il bio-olio, residuo liquido del processo

In realtà la questione è più complessa e se il processo di combustione prevede la presenza di limitate quantità di ossigeno, parliamo di “gassificazione” e l’output del processo è diverso.

Tuttavia, concentrandoci sul solo biochar, esso viene prodotto essenzialmente a partire da biomassa vegetale, residui legnosi di qualsiasi origine.

Si comprende facilmente che questo tipo di processo permette l’utilizzo e la valorizzazione circolare di materiale che altrimenti andrebbe disperso o bruciato senza alcun vantaggio. Parliamo dei residui di potature, sfalci, rami degli alberi che diventano tronchi puliti destinati alle segherie per usi industriali.

E su questo punto va aperta una parentesi: i boschi vanno gestiti e i piani di tagli programmati non solo non arrecano alcun danno ma, al contrario, fanno bene alla salute dei boschi.

Il problema è il disboscamento selvaggio e illegale (che non esiste in Europa), non certo la gestione forestale sostenibile che prevede dei tagli programmati mirati a rinforzare lo stato di salute del bosco o della foresta.

Nel processo di pirolisi, fatto cento in quantità il feedstock, la resa è del 25 – 30% circa, ovvero si ottiene, dalla combustione della massa vegetale, il 30% di biochar.

Ne risulta un prodotto simile alla carbonella che si usa per i barbecue, ma più fine, le cui caratteristiche principali sono la porosità, la capacità di trattenere l’acqua, il potere alcalinizzante dei terreni.

APPLICAZIONI IN AGRICOLTURA

Il biochar può essere utilizzato in agricoltura, come filtro nella depurazione di acque inquinate, nell’edilizia come materiale per l’isolamento, nella produzione di biocarburanti.

Ma il suo utilizzo attualmente più diffuso e importante è quello agricolo.

Distribuito sui terreni è un potente ammendante[1], quindi migliora la qualità chimiche, fisiche e biologiche dei terreni, rendendoli molto più produttivi e contrastando gli effetti della siccità perché trattiene l’acqua nei terreni.

Immesso nel terreno, il biochar aumenta il ph, quindi rende la terra più alcalina, aumenta la disponibilità di acqua, migliora le condizioni di sviluppo delle radici, migliora l’apporto e l’assorbimento di nutrienti per le piante, aumenta la resistenza alle malattie e ai fattori di stress ambientale.

In pratica, è una specie di potentissimo ricostituente dei terreni.

In funzione del tipo di terreno di cui si vogliono migliorare le caratteristiche chimico – fisiche, si potranno produrre diversi tipi di biochar (variando la composizione del feedstock e le condizioni di pirolisi) che daranno risposte mirate per obiettivi specifici. Risultati eccellenti si stanno raggiungendo con i terreni aridi, sabbiosi, sovrasfruttati.

BIOCHAR E ATMOSFERA

Ma c’è un’altra caratteristica di grande interesse di questo prodotto, esso è efficace per il sequestro di CO2 dall’atmosfera.

Infatti, al termine del processo di produzione, la CO2 presente nel materiale vegetale viene mineralizzata e quindi “intrappolata” nel biochar. Circa il 90% di questa CO2 resta inglobato nella struttura molecolare del prodotto che rimane stabile per centinaia di anni.

È bene precisare che è giusto parlare di sequestro e non di stoccaggio della CO2 in quanto si tratta di carbonio di origine vegetale fotosintetizzato a partire da CO2 atmosferica.

In questo modo il biochar diventa anche uno strumento di lotta all’effetto serra, e infatti la sua produzione permette anche di emettere crediti di carbonio (al termine di un processo di certificazione) da vendere sul mercato volontario (quindi non per le aziende obbligate a compensare le proprie emissioni).

Che i boschi bruciati rinascano velocemente e con grande forza è un fenomeno conosciuto da sempre; una delle ragioni che determinano questa situazione è la modifica delle caratteristiche del suolo dovuta alle ceneri. È esattamente ciò che fa il biochar.

A volte la scienza va avanti guardando al passato.

PER APPROFONDIRE

Ichar, Associazione Italiana Biochar

International Biochar Initiative

Unibo, Biochar, presente e futuro

NOTE

[1] La differenza tra una sostanza ammendante e un fertilizzante è che la prima interviene sulla struttura del suolo e apporta migliorie stabili nel tempo, i fertilizzanti sono solo l’immissione nel terreno di sostanze nutritive che vengono utilizzate e consumate dalle piante.

Deskilling e Diverse Skilling - La trasformazione delle competenze nell'era digitale

L'innovazione tecnologica ha rivoluzionato il nostro modo di vivere e lavorare, delegando molte attività a strumenti digitali. L'adozione di queste tecnologie genera due importanti dinamiche che impattano le competenze umane: il fenomeno del deskilling e quello del diverse skilling.

Da un lato, il deskilling indica la perdita di competenze necessarie a svolgere un'azione, che viene – invece - affidata a una macchina. Dall'altro lato, il diverse skilling sottolinea la trasformazione delle competenze del fare in quelle dell'uso e della gestione della macchina che fa.

IL FENOMENO DEL DESKILLING

Il termine deskilling indica la progressiva perdita delle competenze necessarie a svolgere un'attività specifica, fenomeno che si verifica quando un'azione che era abitualmente eseguita da una persona umana viene completamente delegata a uno strumento tecnico o tecnologico. In particolare, nel corso di questo XXI secolo, si tratta di strumenti di automazione digitali.

Un esempio emblematico è quello della calcolatrice: l'introduzione di questo strumento ha ridotto la necessità di eseguire calcoli complessi manualmente. Analogamente, i sistemi di navigazione satellitare hanno reso quasi superflua la capacità di leggere mappe o orientarsi con elementi naturali.

In ambito lavorativo, il deskilling è maggiormente evidente nei settori industriali oggetto di processi di progressiva automazione, settori in cui operai - che un tempo padroneggiavano procedure complesse - ora supervisionano processi gestiti da robot; oppure nei settori dei servizi, in cui numerose attività svolte tradizionalmente da umani – come, ad esempio, l’assistenza ai clienti – iniziano ad essere gestite da bot[1], sistemi automatici digitali che trovano spesso applicazione nelle chat o nei numeri telefonici di assistenza ai clienti: trascrivono e interpretano il linguaggio naturale parlato o scritto, estraggono i riferimenti delle richieste e provano (spesso senza successo, va detto) a dare delle risposte.

Questo fenomeno ha conseguenze significative sia sui processi che sui lavoratori . Da un lato, possono aumentare l'efficienza e ridurre gli errori; dall'altro, portano – sicuramente - ad una progressiva dipendenza dagli strumenti utilizzati e all’oblio delle competenze che permettono ad un umano di fare quel lavoro.

La perdita di competenze pratiche, quelle del fare può avere effetti devastanti: dal punto di vista industriale, infatti,

- riduce la comprensione del processo, in cui l’azione dello strumento, diventato una black box in cui viene immesso qualcosa e che produce qualcosa di diverso, viene data per scontata

- diminuisce la possibilità di integrazione umana manuale in caso di errori o di malfunzionamenti

- segrega le conoscenze di come funziona il passo di processo automatizzato tra gli esperti della tecnologia, del progettare (informatici, meccanici, fisici, chimici) che hanno progettato l’automatismo e che, frequentemente, non partecipano per nulla al processo produttivo, togliendole – invece - a chi il processo produttivo lo vede o lo gestisce quotidianamente

- riduce, quindi, la possibilità di miglioramento della qualità del prodotto – che continua a dipendere dal processo di realizzazione – ai soli momento di re-engineering istituzionalizzato, perdendo il contributo degli esperti del fare, operai e impiegati

Dal lato di chi lavora, invece, riduce l'autonomia dell'individuo, del lavoratore, annulla il valore del suo contributo professionale, e può generare significative ripercussioni sul piano psicologico e sociale.

IL CONTRAPPESO DEL DIVERSE SKILLING

In contrapposizione al deskilling, il diverse skilling è la traslazione delle competenze dall'esecuzione diretta di un compito ,il fare, alla gestione dello strumento che lo compie. Questo fenomeno non implica la perdita totale delle abilità, ma una loro trasformazione e adattamento.

Tornando agli esempi precedenti, l'uso di una calcolatrice richiede la comprensione dei meccanismi logici sottostanti, così come l'interpretazione di dati forniti da un sistema di navigazione richiede la capacità di valutare le condizioni reali del contesto.

In ambito lavorativo, l'automazione può portare gli operai a sviluppare competenze di monitoraggio e di manutenzione delle tecnologie di automazione i sistemi, rendendo necessarie conoscenze più avanzate, come quelle informatiche o ingegneristiche.

Un caso esemplare è stato quello della vulcanizzazione degli pneumatici: negli anni ’80, in una grande azienda industriale italiana, le attività manuali – svolte dai caposquadra – di pianificazione della produzione, delle singole macchine vulcanizzatrici, seguite – in corso di produzione – dalle vere e proprie attività di preparazione e di attrezzaggio delle macchine, sono state sostituite da sistemi informatici che permettevano di effettuare una programmazione efficace ed efficiente per la giornata o la settimana e – sulla base del conteggio automatizzato dei pezzi e delle attività, indicavano al capoturno sulla consolle di controllo quando fosse opportuno intervenire per la manutenzione oppure per il cambio di attrezzaggio programmato per una diversa lavorazione.

In questo caso, il personale ha potuto intervenire nella fase di progettazione per dare le necessarie indicazioni competenziali a chi progettava i sensori, i contatori e il software, in fase di test per controllare se il funzionamento dell’automatismo fosse in linea con le indicazioni e le esigenze e, infine, ha completato la traslazione competenziale con corsi di formazione che hanno permesso alle operaie e agli operai di gestire in autonomia i sistemi automatici e di dare indicazioni su come migliorarne il funzionamento nel tempo.

Il diverse skilling rappresenta, quindi, una forma di resilienza umana all'innovazione tecnologica. Mentre alcune competenze si perdono, altre vengono acquisite, spesso più complesse e specializzate. Questo fenomeno può favorire una maggiore produttività e migliorare la qualità del lavoro, ma non è privo di sfide: la transizione richiede risorse significative in termini di formazione e adattamento culturale e rappresenta – probabilmente – un importante cambiamento sociale guidato delle rivoluzioni tecnologiche.

UN CONFRONTO CRITICO

Il confronto tra deskilling e diverse skilling solleva interrogativi sulla direzione e sulle conseguenze del cosiddetto progresso tecnologico.

Da un lato, il deskilling è un rischio per la sostenibilità delle competenze umane, soprattutto quando interi settori lavorativi si trasformano rapidamente, lasciando molte persone senza le capacità necessarie per adattarsi.

Dall'altro, il diverse skilling dimostra che il cambiamento tecnologico può non annullare le competenze, ma – sotto alcune condizioni – può favorirne un riallineamento verso nuove frontiere di apprendimento.

Il punto di equilibrio – o di crisi - sta certamente nell'accessibilità: non tutti gli individui e non tutti i contesti sociali sono in grado di affrontare il passaggio dal deskilling al diverse skilling.

La focalizzazione delle imprese sull’incremento di efficienza, che va sempre letto come riduzione dei costi di produzione e contestuale aumento della produttività, spesso non contempla investimenti volti a ridurre le lateralità della trasformazione tecnologica.

Questo significa minori opportunità di formazione e infrastrutture dedicate alla transizione verso un diverse skilling e, come conseguenza, amplifica le disuguaglianze, creando una società divisa tra chi detiene le nuove tecnologie, chi le padroneggia e chi ne è escluso.

Nel mondo delle imprese si sente dire che “non si progredisce senza cambiare”, ma il cambiamento è una trasformazione che – purtroppo - non è alla portata di tutti e - spesso - non è portatore di maggiore benessere.

Ad esempio, in settori come la medicina o l'ingegneria, affidarsi completamente alla tecnologia senza mantenere competenze critiche e intuitive può avere conseguenze disastrose.

CONCLUSIONI

Il deskilling e il diverse skilling non sono – quindi - fenomeni mutuamente esclusivi, ma due facce della stessa medaglia. Mentre il primo evidenzia i rischi di una delega eccessiva alla tecnologia, il secondo dimostra la capacità dell’umano di adattarsi e innovarsi, migliorando di fatto la qualità delle sfide che affronta.

Per massimizzare i benefici e minimizzare i rischi, è essenziale – però – che gli innovatori promuovano strategie formative e lavorative che facilitino il diverse skilling, senza trascurare l'importanza delle competenze di base.

In un mondo sempre più automatizzato, il futuro del lavoro e dell'apprendimento dipenderà dalla capacità di bilanciare innovazione tecnologica e adattamento delle abilità umane. Solo così sarà possibile costruire una società in cui la tecnologia sia uno strumento di emancipazione e non di alienazione.

NOTE

[1] I bot sono sistemi automatici digitali che trovano spesso applicazione nelle chat o nei numeri telefonici di assistenza ai clienti: trascrivono e interpretano il linguaggio naturale parlato o scritto, estraggono i riferimenti delle richieste e provano a dare delle risposte.

La morale della storI.A. - Corpus documentali, training e decisioni

GENTE DI TROPPA FEDE

Nel libro Paura della scienza Enrico Pedemonte racconta che nel Kentucky, a Petersburg, il pastore australiano Ken Ham ha investito 27 milioni di dollari per costruire un parco tematico in cui la storia della Terra viene esposta secondo il punto di vista della Bibbia. Dalla sua fondazione, nel 2007, il Creation Museum ha accolto oltre 3 milioni e mezzo di visitatori, che hanno potuto vedere con i loro occhi come il nostro pianeta non conti più di 6.000 anni di vita, e come i dinosauri esistessero ancora durante il Medioevo – quando San Giorgio e gli altri cavalieri li hanno sterminati, scambiandoli per draghi. Ai tempi di Dante il WWF avrebbe raffigurato la minaccia di estinzione con un povero tirannosauro, bullizzato da giovanotti di buona famiglia in armatura rilucente – altro che panda.

Una porzione molto ampia dell’opinione pubblica coltiva un rapporto con l’intelligenza artificiale paragonabile a quello che gli abitanti della «Bible Belt» americana nutrono nei confronti della storia: una fede che libera da ogni fatica di studio e approfondimento. Solo che gli imbonitori delle fantasticherie tecnologiche non hanno nemmeno bisogno di cimentarsi nella fatica di costruire parchi a tema per persuadere i loro spettatori: non mancherebbero i mezzi, visto che tra le loro fila si schierano personaggi come Elon Musk e Sam Altman. Nel film fantasy di portata universale che propone l’AGI come un evento imminente, i ruoli sembrano invertiti: il computer che raggiungerà l’intelligenza artificiale generale viene descritto come un vero drago di talento e raziocinio, con personalità propria, autonomia di giudizio, memoria illimitata, conoscenze smisurate, lucidità strategica, sottigliezza logica, e (perché no?) cinismo teso al dominio sull’uomo e sull’universo. Cosa potrà fare un San Giorgio moderno, negli abiti di un programmatore nerd, o di un eroico poeta in carne e ossa, o di un chirurgo che si prodiga per la salute dei suoi pazienti, o di un giudice che brama difendere la giustizia quanto Giobbe davanti a Dio – cosa potranno questi santi laici di fronte a un mostro simile?

Nick Bostrom ha avvisato più di dieci anni fa che se dovesse comparire questa forma di intelligenza, per tutti noi e i nostri santi sarebbe già troppo tardi, perché la macchina che raggiungesse le prestazioni dell’AGI non si fermerebbe al nostro livello di razionalità, ma crescerebbe a intensità esponenziale, conquistando gradi di perspicacia tali da impedire la scoperta delle sue manovre, e da inibire l’interruttore di spegnimento.

TOSTAPANI CON TALENTO PER LA STATISTICA

Ma è davvero così?

L’AGI è grande, e ChatGPT è il suo profeta: molti lo considerano tale. Il software di OpenAI è stimato l’avanguardia nel settore dell’intelligenza artificiale, grazie al marketing che gli ex e gli attuali soci fondatori hanno animato intorno alle sue prestazioni: il licenziamento di Sam Altman da CEO nel novembre 2023, rientrato dopo meno di una settimana, e le polemiche con Elon Musk, hanno contribuito ad amplificare il clamore intorno ai prodotti dell’azienda californiana. Ma se proviamo ad aprire l’armatura che protegge la macchina, ed esaminiamo l’euristica del suo funzionamento, troviamo un dispositivo che calcola quale dovrà essere la prossima parola da stampare nella sequenza sintattica della frase, sulla base del grado maggiore di probabilità che il lemma possiede nel campo semantico in cui compare il suo predecessore. I campi semantici sono strutture matematiche in cui ogni parola è convertita in un vettore che misura la frequenza delle sue occorrenze accanto alle altre parole, nel corpus di testi che compongono il database di training. Per esempio, il lemma finestra compare con maggiore frequenza vicino a casa, strada, balcone; la sua presenza è meno probabile dopo transustaziazione o eucaristia.

Naturalmente ChatGPT è un prodigio di ingegneria, perché calcola (al momento) 1.500 miliardi di parametri ad ogni parola che viene aggiunta nella sequenza proposizionale; ma in ogni caso non ha la minima idea di cosa stia dicendo, non sa nemmeno di stare parlando, non ha alcuna percezione di cosa sia un interlocutore e che esista un mondo su cui vertono i suoi discorsi. Lo provano i «pappagalli stocastici» che ricorrono nelle sue composizioni: gli errori che possono apparire nelle sue dichiarazioni non violano solo le verità fattuali (quali possono essere inesattezze di datazione, citazioni false, e simili), ma aggrediscono la struttura delle «conoscenze di Sfondo», la logica trascendentale che rende possibile l’esperienza stessa. Per i testi redatti da ChatGPT un libro pubblicato nel 1995 può citare saggi usciti nel 2003 o descrivere una partita di Go avvenuta nel 2017: l’eloquio del software è infestato da allucinazioni che provano l’assenza di comprensione, in qualunque senso del termine intelligente, di ciò che significa la sequenza dei significanti allineati dal suo chiacchiericcio. Un dispositivo che non mostra alcun intendimento dell’esistenza del mondo, e delle sue configurazioni più stabili, non è nemmeno in grado di perseguire obiettivi autonomi, di giudicare, stimare, volere, decidere. ChatGPT è un software con l’intelligenza di un tostapane, e uno smisurato talento per il calcolo della probabilità nella successione delle parole.

COSA DICE L’I.A. SUGLI UMANI

Come se la passano i fratelli, i cugini e i parenti vicini e lontani di ChatGPT?

Consideriamo il caso esemplare, descritto da Gerd Gigerenzer, del software COMPAS adottato dai tribunali americani per collaborare con i giudici nella valutazione della libertà sulla parola. Ogni anno la polizia degli Stati Uniti arresta circa dieci milioni di persone, e il magistrato deve stabilire se convalidare l’imprigionamento o lasciare libero il cittadino, sulla base della convinzione che non reitererà il reato. COMPAS ha contribuito ad emanare circa un milione di sentenze, dopo essere stato formato sull’intera giurisprudenza depositata nei provvedimenti di ogni ordine e grado dei tribunali americani. L’analisi delle sue proposte ha evidenziato una serie di pregiudizi che discriminano per colore della pelle, genere, età e censo, sfavorendo gli uomini neri, giovani, che provengono da quartieri poveri. Tuttavia la penalizzazione a sfondo razziale che è implicita nelle decisioni del software non proviene dal carattere ghettizzante dell’intelligenza artificiale: la macchina non ha autonomia di giudizio, ma sintetizza le opinioni catalogate nell’archivio delle ordinanze dei magistrati in carne e ossa, che sono i reali agenti dei preconcetti e dell’intolleranza di cui il dispositivo digitale è solo il portavoce. La convinzione che la sospensione del ricorso all’IA, in favore dell’autonomia di delibera da parte dei giudici umani, possa mettere a tacere l’intolleranza che serpeggia tra le valutazioni del software, è un’illusione come l’Eden del Creation Museum: gli autori dei testi da cui COMPAS ha appreso il funzionamento del suo mestiere continueranno ad applicare i principi – più o meno inconsapevoli – del razzismo che innerva la società americana e l’upper class giuridica.

Al pregiudizio concettuale i magistrati umani aggiungono anche le deviazioni dettate dalla loro fisiologia. Uno studio congiunto della Columbia Business School e della Ben-Gurion University pubblicato nel 2011 ha dimostrato che i giudici scelgono con la pancia – e lo fanno in senso letterale, poiché i verdetti diventano sempre più severi quanto più ci si allontana dall’orario dei pasti. Almeno i software non sono sensibili ai morsi della fame.

Nemmeno vale la pena di coltivare illusioni sul miglioramento del trattamento dei candidati per le selezioni dei posti di lavoro: gli uffici del personale che abbandonano la lettura dei curricula ai dispositivi di IA (che a loro volta hanno imparato a discriminare nel training sul database delle assunzioni precedenti) non sarebbero pronti a compiere valutazioni migliori – con ogni probabilità si limiterebbero a non leggere i CV.

RATING UNIVERSALE E ALTRI ANIMALI FANTASTICI

Gigerenzer invita a verificare con cura i numeri divulgati dagli uffici marketing e dai giornalisti affamati di sensazionalismo: ne abbiamo già parlato in un altro articolo su Controversie.

La convinzione che qualche nazione sia in grado di gestire un calcolo del rating sociale di ciascuno dei suoi cittadini appartiene al repertorio degli effetti dei mass media per la generazione del panico. L’opinione che la Cina sia in grado di praticarlo, con quasi 1,4 miliardi di abitanti, è ancora meno credibile. Per allestire un processo di portata così vasta occorre una potenza di calcolo che al momento non può essere gestita da alcuna infrastruttura tecnologica. La realtà di questo progetto è assimilabile a qualcuno degli animali del bestiario del Creation Museum, qui a beneficio della propaganda del regime di Pechino e della sua aspirazione a gonfiare muscoli informatici inesistenti. Il governo cinese razzia dati sui cittadini anche dalle imprese che rilasciano servizi di comunicazione e di ecommerce, con l’obiettivo di armare sistemi di controllo di larga scala, che l’Unione Europea ha già vietato con l’AI Act entrato in vigore lo scorso luglio. Senza dubbio è una giusta preoccupazione prevenire simili tentazioni di amministrazione della distribuzione delle utilità sociali; ma il focus su questa minaccia sembra al momento meno urgente della normativa che obblighi i produttori di software a pubblicare le euristiche con cui funzionano i dispositivi di intelligenza artificiale. La consapevolezza che l’euristica alla base di ChatGPT è il calcolo della parola con maggiore probabilità di trovarsi subito dopo quella appena stampata, avrebbe liberato il pubblico dall’ansia e dall’euforia di marciare sulla soglia di un’AGI pronta a rubare il lavoro e a giudicare gli imputati, imminente al prossimo cambio di stagione. Avrebbe anche sterminato le occasioni per Musk e Altman di favoleggiare risultati miracolosi nel marketing dei loro prodotti – più spietatamente di quanto San Giorgio massacrasse dinosauri.

I rischi più realistici riconducibili all’intelligenza artificiale riguardano proprio la trasparenza delle euristiche, la bolla finanziaria indotta da società prive di un modello di business (come OpenAI), le attese senza fondamento alimentate da società di consulenza e da formatori improvvisati, il monopolio sui modelli fondamentali già conquistato da pochi giganti della Silicon Valley, il tentativo di accaparrarsi lo sviluppo dell’intero settore da parte di personaggi con finalità politiche ed economiche come Musk e Altman.

Chi costruisce Creation Museum di ogni tipo non ha mai come scopo la divulgazione; dovrebbe essere compito degli intellettuali tornare a smascherare i draghi di questi impostori, come coraggiosi San Giorgio della ragione.

BIBLIOGRAFIA

Bostrom, Nick, Superintelligence: Paths, Dangers, Strategies, Oxford University Press, Oxford 2014.

Bottazzini, Paolo, La fine del futuro - I.A. e potere di predizione, «Controversie», 10 settembre 2024.

ChatGPT-4, Imito dunque sono?, Bietti Edizioni, Milano 2023.

Danziger, Shai; Levav, Jonathan; Avnaim-Pesso, Liora, Extraneous factors in judicial decisions, «Proceedings of the National Academy of Sciences», vol. 108, n.17, 2011.

Gigerenzer, Gerd, How to Stay Smart in a Smart World Why Human Intelligence Still Beats Algorithms, Penguin, New York 2022.

Pedemonte, Enrico, Paura della scienza, Treccani Editore, Torino 2022.

Necro-spider hand - Due facce della medaglia della tecnoscienza

Si dice che divertirsi aiuti a rilassarsi, ad imparare più facilmente e, anche, ad essere più creativi.

Sembra assodato che il divertimento sia un tassello fondamentale della vita quotidiana e sembra che sia importante anche nella vita e nel lavoro degli scienziati.

Anche durante la ricerca scientifica, è utile trovare il giusto divertimento, così da poter "scoprire ridendo".

Su questa linea di pensiero è stato pensato il premio IgNobel, un riconoscimento che «onora risultati di ricerca così sorprendenti da far prima RIDERE e poi RIFLETTERE»; il premio vuole «celebrare l’inusuale, premiare l’immaginifico e suscitare interesse, nel grande pubblico, per le scienza, la medicina, le tecnologie».

Le ricerche che portano alla vittoria di questo tanto ambito premio – dieci vincitori ogni anno - sono pubblicate sulla rivista umoristico-scientifica Annals of Improbable Research, che raccoglie studi su argomenti strani, inaspettati e che dimostrano quanto gli scienziati si divertano a fare ricerca.

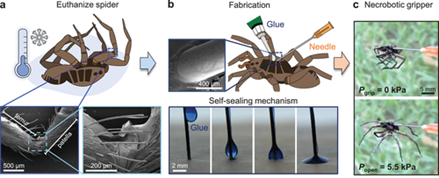

In questo post parliamo di un premio IgNobel del 2023, quello assegnato a Te Faye Yap, Zhen Liu, Anoop Rajappan, Trevor Shimokusu, and Daniel Preston, “per aver rianimato ragni morti da usare come micro-strumenti meccanici di presa”.

Faye Yap e colleghi sono bravi ingegneri con un pizzico di eccentricità; immaginiamoli dopo una giornata di lavoro passata “tra bulloni e viti” a costruire una mano robotica, che notano un ragno morto sulla scrivania e – probabilmente - pensano: «Ma non si potrebbe usare…».

Quello che potrebbe far pensare ad un episodio di Black Mirror, è il risultato di una ricerca vera e sorprendentemente utile. Gli autori si sono ispirati alla fisiologia degli aracnidi, dando vita a una branca della meccanica che potremmo definire necrobotica.

La necrobotica è l'unione tra biologia e robotica, dove parti di organismi morti vengono riutilizzate come componenti robotici. In questo caso, i ricercatori hanno sfruttato le proprietà naturali del ragno per creare un dispositivo di presa micromeccanico.

I ragni muovono le loro zampe attraverso un sistema idraulico: pompando emolinfa nel loro esoscheletro, le zampe si estendono e quando la pressione diminuisce, si contraggono. Dopo la morte il sistema idraulico del ragno non funziona più, ma la struttura meccanica rimane intatta. Inserendo un ago nel prosoma (la parte anteriore del corpo del ragno) e applicando una piccola quantità di aria pressurizzata, i ricercatori sono stati in grado di controllare l'apertura e la chiusura delle zampe, trasformando il ragno in una pinza naturale.

Figura 1 - Esempio di creazione della manina-ragno

Figura 1 - Esempio di creazione della manina-ragno

(immagine tratta dall'articolo di Te Faye Yap, Zhen Liu,

Anoop Rajappan, Trevor Shimokusu, and Daniel Preston)

Questo sistema ha dimostrato di essere sorprendentemente efficace: il ragno "cyber-zombificato" può afferrare oggetti fino a 130 volte il proprio peso.

Si possono immaginare le applicazioni in micro-ingegneria o in situazioni dove sono necessari strumenti delicati e biodegradabili.

Figura 2 - Esempi di utilizzo della manina-ragno

Figura 2 - Esempi di utilizzo della manina-ragno

(immagine tratta dall'articolo di Te Faye Yap, Zhen Liu,

Anoop Rajappan, Trevor Shimokusu, and Daniel Preston)

Sfortunatamente, la durata funzionale della pinza-ragno era limitata a circa due giorni dopo la morte del ragno, a causa della disidratazione che rendeva le articolazioni più fragili e suscettibili a fratture meccaniche nel tempo.

A cosa può veramente servire questa ricerca?

Questa tecnologia potrebbe essere impiegata nell'assemblaggio di microelettronica o per la cattura di insetti nel loro habitat naturale. Infatti, la pinza-ragno è in grado di afferrare oggetti delicati e con geometrie particolari, come solo un aracnide può fare. È anche possibile modulare la forza di presa variando la pressione applicata, per applicazioni che richiedono forze dell'ordine di decine o centinaia di micronewton.

Studiare la forza di presa in ragni di diverse dimensioni o specie potrebbe portare a una comprensione più approfondita della relazione tra le dimensioni del ragno e la forza esercitata. I futuri lavori potrebbero includere l'esplorazione di metodi di rinforzo per migliorare la durata e la robustezza della pinza necrobotica, magari con qualche trattamento antietà per mantenere le articolazioni ben lubrificate.

Questa innovazione è una prova del fatto che possiamo imparare molto dalla natura, facendoci dare darci una mano nel migliorare le tecnologie attuali.

Infatti, la progettazione e la fabbricazione dei robot tradizionali comportano spesso processi complessi e tediosi. La necrobotica, tuttavia, bypassa gran parte del processo di fabbricazione incorporando componenti robotici all’interno di materiali biologici (e anche a chilometro zero) - o viceversa.

Un altro elemento da considerare è che le applicazioni della necrobotica sono realizzate per la maggior parte con materiali biodegradabili e, quindi, non contribuiranno al crescente flusso di rifiuti tecnologici – costituendo un significativo passo per l'ecosostenibilità.

DUE CONCLUSIONI, DUE FACCE DELLA MEDAGLIA

In conclusione, da un lato sembra evidente che il divertimento e la stranezza debbano essere i benvenuti nei laboratori di ricerca e che questi possono portare stimoli e idee tanto simpatici quanto utili per quella cosa che Latour definisce tecnoscienza.

Dall’altro lato, questa storia ci ricorda che “la natura” e gli animali considerati inferiori - in questo caso i ragni - vengono ancora utilizzati per la ricerca e per scopi di innovazione tecnologica con assoluta noncuranza per una loro possibile soggettività e capacità di vivere e sentire in modo complesso: «Il materiale biologico grezzo (i cadaveri dei ragni) venne procurato praticando l’eutanasia attraverso l’esposizione a temperature di congelamento (circa - 4°) per un periodo di circa 5-7 giorni».

BIBLIOGRAFIA

Te Faye Yap, Zhen Liu, Anoop Rajappan, Trevor J. Shimokusu, Daniel J. Preston. Necrobotics: Biotic Materials as Ready-to-Use Actuators. DOI: https://doi.org/10.1002/advs.202201174. Link diretto allo studio: https://onlinelibrary.wile

Ridiamo delle macchine? – Seconda parte

IL DISTRATTO E L’OSTINATO

Torniamo, per un’ultima volta, all’esempio dell’inciampo. Chiediamoci: quando affermiamo, nel corso dell’analisi, che la corsa dell’uomo che inciampa è fin troppo meccanizzata? Soltanto quando è già intervenuto un elemento di disturbo - un ciottolo, un’irregolarità, un imprevisto - che interrompe il regolare corso di un’abitudine. Fino a quel momento, fin quando egli non era caduto, l’idea o la sensazione di ridere non ci aveva minimamente sfiorato. Sarebbe evidentemente contro fattuale asserire che ridiamo di ogni abitudine, benché le abitudini siano, in qualche grado, una ripetizione. Con la caduta, l’abitudine contratta diventa immediatamente risibile, ma contemporaneamente è diventata «troppo meccanica», «abitudine irrigidita», e così via. L’elemento di disturbo non ha semplicemente «mostrato» l’abitudine troppo meccanica, ma l’ha in qualche modo determinata, l’ha resa per ciò stesso troppo meccanica per la realtà con cui è entrata in contrasto: la «rigidità di meccanismo» e «l’elemento di disturbo» nascono in unisono, laddove fino all’attimo prima operavano congiuntamente.

Tutto ciò ci permette di proporre una questione alternativa, nata in seno alla divisione delle due ragioni precedentemente espresse: il riso, in questa sua funzione squisitamente sociale, non è forse, piuttosto che essere il castigo di ciò che è umanamente troppo meccanizzato, il meccanismo sociale ad un tempo di razionalizzazione e oggettificazione per carpire e respingere ciò che di imprevedibile tocca l’abitudine?

Consideriamo i due casi del «distratto» e dell’ «eccentrico» o «ostinato», entrambi citati da Bergson[1]. Quando rido del distratto, in superficie irrido ciò che c’è di troppo meccanismo nei suoi atti, mentre in profondità la risata è l’atto stesso con cui allontano e oggettivo da me, singolo o società, l’evento dell’imprevedibilità che colpisce «qualcuno sino ad allora come me». Il riso è un atto di differenziazione non da ciò che è “troppo meccanico”, ma da ciò che è stato reso “troppo meccanico”, e dalla forza che è responsabile d’essersi “impossessata” di quell’abitudine: non allontano solamente il soggetto divenuto oggetto, ma in pari tempo la forza che ha reo possibile quell’oggettificazione. È qualcosa che Bergson tocca, seppur fugacemente e con gran dose d’ambiguità, nelle battute finali dell’opera: il riso, come il sogno, «è distacco».

Quando, diversamente, irrido colui che è ostinato oltre ogni ragione, in superficie posso sì affermare che, nuovamente, sto deridendo ciò che v’è di troppo meccanico in questi atti, ma la risata è, in profondità, il preciso meccanismo con cui allontano e dissacro ciò che v’è di imprevedibile negli atti di qualcosa che si «discosta dal centro comune».

Dell’ostinato non ridiamo per via della sua ostinazione, ma per il timore che ispira l’inintelligibilità delle sue ragioni, come il «raccapricciante e imprevedibile» citato da Friedrich Nietzsche (Aurora, p. 17) Infatti, si dovrà pur spiegare perché il folle ispiri così profondamente la coscienza comica.

Con buona pace di Bergson, la vergogna e la colpa impiegate dal riso, «intimidire umiliando» (Cit, p.98) della società non sarebbero dunque la vita vivente e mutevole che castiga ciò che c’è di «troppo automatizzato nella volontà» (Cit. p.94), ma i mezzi diretti per la gestione dell’imprevedibilità. Il riso è strumento dell’economia dell’imprevedibile.

Ridiamo del distratto e dell’ostinato, ma mentre nel primo caso l’evento comico è separato dal soggetto - «Giovanni non è la sua caduta», ma rido contemporaneamente di «Giovanni caduto» e della forza che ha fatto sì che egli divenisse quella forma oggettiva e meccanica -, nel secondo caso l’ostinazione fa tutt’uno con il soggetto - la forza che ha oggettificato il distratto è esterna, la forza che ha stravolto l’ostinato è interna. Non ci vendichiamo dei distratti ma degli ostinati.

Se dovessimo dare una semplicistica differenziazione basata sul binomio volontà-mondo, il distratto intimorisce l’intromissione del mondo negli eventi che provocano un errore, l’ostinato intimorisce per l’intromissione di qualcosa di imprevisto o irregolare nella volontà stessa del soggetto, più che del mondo.

Il riso diretto al distratto distanzia il ridente dall’oggettificazione di una volontà per via di un elemento di intromissione che se ne è come “impossessato”, il riso verso l’ostinato è esso stesso l’atto con cui si tenta di oggettificare una volontà - sbagliato.

Allora, dopo aver detto tutto ciò, ritorniamo a chiederci: ridiamo delle macchine? La risposta di Bergson è doppia: non ridiamo di ciò che è meccanico in quanto tale, ma se ne ridiamo è all’opera una qualche forma di antropomorfosi, un’analogia. Di conseguenza, nella e della macchina non c’è nulla che spieghi la funzione sociale del riso. Eppure, da ciò che si è scritto consegue un’ipotesi alternativa e correlativa.

Non ridiamo delle macchine, non perché queste non partecipano della variabile variabilità che contraddistingue la vita, ma in quanto non partecipano di ciò che comunemente si intende come essenza della volontà, ossia l’imprevedibilità, e la forza di quest’imprevedibilità di trasformare la stessa volontà in cose.

Perché la volontà vuole per sé quell’imprevedibilità che proviene dalla forza dell’ignoto, essa vuole oggettificare ma non vuole essere oggettificata.

NOTE

[1] Cfr, H. Bergson, Il riso