Recensione di "Eppure non doveva affondare - Quando la scienza ha fatto male i conti"

Il saggio Eppure non doveva affondare - Quando la scienza ha fatto male i conti (Bellucci D., Bollati Boringhieri, 2024) offre una riflessione approfondita sugli errori scientifici, mettendo in evidenza come questi non siano da considerarsi come semplici fallimenti ma opportunità, fondamentali per il progresso della conoscenza. Attraverso una serie di casi emblematici, l’autore mostra l’importanza di un’analisi critica e della capacità di apprendere dagli errori per migliorare le tecnologie e il metodo scientifico.

Uno degli ambiti in cui gli errori hanno avuto conseguenze drammatiche è l’ingegneria. Bellucci analizza alcuni fallimenti progettuali clamorosi, come quello degli aerei con finestrini quadrati. Questo design, apparentemente banale, si rivelò fatale: la forma degli angoli causava una concentrazione eccessiva delle sollecitazioni meccaniche, portando alla rottura della fusoliera in volo. Un altro caso emblematico riguarda le navi che si spezzano in due a causa di calcoli errati sulla distribuzione del peso e delle forze strutturali. Questi esempi mostrano quanto sia essenziale un’analisi accurata nella progettazione, perché anche il minimo errore può trasformarsi in una catastrofe.

Il libro si sofferma poi sugli errori nel campo dell’hardware e dell’informatica, mostrando come difetti nei microchip possano compromettere operazioni matematiche fondamentali. Un singolo errore nella progettazione di un processore può avere ripercussioni enormi, rendendo necessarie operazioni costose di aggiornamento o sostituzione. Anche nel software gli sbagli possono avere conseguenze impreviste e pericolose: sistemi che perdono la cognizione del tempo possono causare problemi gravi, soprattutto in ambiti critici come il settore bancario o le telecomunicazioni. A volte, persino un dettaglio apparentemente insignificante—come un cavo allentato—può mandare in fumo esperimenti scientifici di grande importanza.

Un altro ambito in cui gli errori possono avere conseguenze drammatiche è la medicina. L’autore analizza i problemi legati alla ricerca farmaceutica e alla produzione di medicinali, evidenziando come piccole variazioni nella formulazione o nella fase di sperimentazione possano rendere un farmaco inefficace o addirittura pericoloso. Inoltre, Bellucci mette in luce le criticità legate ai trial clinici, spiegando come un’interpretazione errata dei dati possa compromettere l’affidabilità delle cure e generare rischi per i pazienti.

L’intelligenza artificiale è un altro settore in cui gli errori assumono un ruolo centrale. Bellucci evidenzia i pericoli legati ai modelli predittivi, che possono produrre risultati distorti o discriminatori se vengono addestrati su dati errati. Un ulteriore problema riguarda la trasparenza: la cosiddetta “scatola nera” delle reti neurali rende difficile comprendere i meccanismi decisionali degli algoritmi, complicando l’individuazione e la correzione degli errori. Questo solleva questioni cruciali non solo dal punto di vista tecnico, ma anche etico.

Ma come si possono prevenire questi errori? Il libro dedica una sezione alle strategie utilizzate dalla scienza per ridurre i rischi e migliorare l’affidabilità delle scoperte. Tra queste, l’autore cita la peer-review nella ricerca accademica, il debugging nel software, i trial clinici randomizzati in medicina e l’uso della ridondanza strutturale in ingegneria, ovvero l’inserimento di margini di sicurezza nei progetti per evitare cedimenti improvvisi. Questi metodi mostrano che, pur non potendo eliminare completamente gli errori, è possibile limitarne gli effetti attraverso un’attenta verifica e un approccio sistematico.

Infine, Bellucci sottolinea come la scienza sia un processo collettivo: gli errori sono inevitabili, ma è proprio grazie al metodo scientifico che possono essere individuati, corretti e trasformati in nuove conoscenze. Il progresso non è mai il risultato del lavoro di un singolo, ma della condivisione e della verifica incrociata tra esperti. In definitiva, Eppure non doveva affondare offre una panoramica affascinante su come anche i più clamorosi fallimenti possano diventare strumenti preziosi per migliorare la nostra comprensione del mondo e affinare le nostre tecnologie.

DEVIS BELLUCCI

Devis Bellucci, nato nel 1977, è un fisico, scrittore e divulgatore scientifico italiano. Ha conseguito la laurea in Fisica nel 2002 e il dottorato nel 2006 presso l'Università degli Studi di Modena e Reggio Emilia, dove attualmente ricopre il ruolo di ricercatore in Scienza e Tecnologia dei Materiali. La sua attività di ricerca si concentra principalmente sui biomateriali per applicazioni in ortopedia, odontoiatria e medicina rigenerativa.

Oltre alla carriera accademica, Bellucci è autore di numerosi romanzi e saggi. Tra le sue opere narrative si annoverano "La memoria al di là del mare" (2007), "L'inverno dell'alveare" (2010), "La ruggine" (2011), "La sete dei pesci" (2013) e "La cura" (2017). Nel campo della divulgazione scientifica, ha pubblicato "Materiali per la vita. Le incredibili storie dei biomateriali che riparano il nostro corpo" (2020) e "Eppure non doveva affondare" (2024), in cui esplora gli errori nella scienza e le loro conseguenze.

Come divulgatore, Bellucci ha collaborato con diverse testate, scrivendo di scienza, viaggi e cultura. È attivo anche sui social media, attraverso i quali condivide contenuti legati alla scienza e alla tecnologia.

Le teorie del complotto, prima parte - Tra populismo, scientizzazione della politica e disincanto del mondo

Quella che segue è la prima di cinque puntate di un testo sul complottismo, indagato al crocevia tra populismo, scientizzazione della politica e disincanto del mondo. Il testo originale è stato pubblicato come prefazione al volume di Matthieu Amiech, "L'industria del complottismo. Social network, menzogne di stato e distruzione del vivente" (Edizioni Malamente, 2024). Elisa Lello

--------

Scrivo queste pagine durante un soggiorno a Coimbra come pesquisadora (ricercatrice) visitante presso un Centro universitario che deve molto del suo prestigio a una importante tradizione di studi che ha avuto il merito di fare luce sul ruolo cruciale della dimensione epistemologica nei rapporti di dominio. In particolare, nel mettere sotto esame critico il ruolo che la scienza occidentale ha avuto nel legittimare e implementare le forme della dominazione coloniale storica – e che continua a esercitare attraverso la colonialità (Quijano 2005) – alla luce del fatto che il modo in cui vediamo e descriviamo il mondo determina anche i modi in cui pensiamo sia possibile, o non possibile, agire su di esso per trasformarlo. Una tradizione che si è dunque concentrata sull’epistemologia come strumento di potere, che spoglia la scienza della sua pretesa neutralità mostrando come questa risponda ai rapporti di forza in campo e questi contribuisca a consolidare, marginalizzando, invisibilizzando o ridicolizzando modi altri di stare al mondo, di conoscerlo e rappresentarlo (Chalmers 2017; Nunes e Louvison 2020; Santos et al. 2022).

Eppure, anche in un contesto come questo, quando mi capita di raccontare a colleghe/i i temi intorno cui gravitano i miei studi durante questi ultimi anni – essenzialmente: movimenti sociali e tecnoscienze, i rapporti tra politica e scienza, tra critica sociale e complottismo, tra epistemologia e populismo – quasi sempre mi imbatto in reazioni a cui sono fin troppo abituata. Dopo sorrisi e attestazioni di quanto tutto questo sia interessante, quella che mi si cerca (senza successo) di proporre è una complicità fondata sull’indignazione, e sullo scherno, a partire da qualche aneddoto che invariabilmente vorrebbe dimostrare quanto ci sia gente, là fuori – e, ça va sans dire, soprattutto tra chi ha orientamenti conservatori – così irrimediabilmente ignorante e anti-scientifica che ha completamente perso il lume della ragione, che crede in teorie strampalate, risibili e complottiste, e come è possibile che costoro abbiano diritto di parola e, quel che è peggio, pure di voto.

La mia perplessità, ma a volte è quasi scoramento, nasce non solo dal constatare la mancanza di qualunque cautela nel trattare del rapporto tra scienza, “ignoranza” e politica – ancor di più qui, appunto. Ma anche dal vedere come si tratti quasi sempre di ricercatrici/tori che si autodefiniscono militanti, di sinistra, che rivendicano un’attenzione estrema all’inclusività nelle pratiche e nel linguaggio quando si parla di identità di genere, orientamenti sessuali o body-shaming, eppure tutta questa inclusività, sensibilità e attenzione letteralmente svaniscono quando si è di fronte a opinioni non del tutto allineate, per esempio, sulla crisi eco-climatica o, a maggior ragione, quando si tratta di scelte sanitarie. Non solo svaniscono: peggio, troppo spesso si trasformano in un disprezzo profondo, antropologico, che apre la porta a battute feroci, che rivolte ad altre categorie desterebbero, giustamente, scandalo e reazioni ben sicure di sé. Il tutto senza poi indugiare troppo sulla eterogeneità delle critiche né sulle ragioni che vengono mosse, appunto, dai non allineati; senza interrogarsi sulla complessità delle questioni che pongono e che tutti ci dovremmo porre. Ci si accontenta invece, troppo spesso, di alzare steccati identitari per frapporre una distanza netta tra sé e gli “altri”: anti-vax, antiscientifici, trumpiani, complottisti, negazionisti, terrapiattisti. Un po’ tutti in odore di estrema destra e fascismo.

Sollevando, con ciò, contraddizioni che gridano giustizia, ma che raramente vengono affrontate. Per iniziare col piede giusto, prendiamo la sineddoche per eccellenza del vasto panorama del complottismo: gli odiatissimi “anti-vax”, categoria che finisce per catalizzare indignazioni, ironie e disprezzo, nonché solitamente inclusiva di chiunque per qualunque ragione abbia dubbi sulle politiche pandemiche. Bene, l’avere (più di) qualcosa da ridire sul fatto che le linee politiche essenziali che hanno guidato la gestione globale del Covid-19 siano state scritte da CEPI (Coalition for Epidemic Preparedness) – Fondazione B. & M. Gates, DARPA (NATO) e Wellcome Trust – è una posizione in perfetta continuità con ciò che denunciava il “movimento dei movimenti” tra Seattle e Genova al volgere del millennio e con ciò che qualunque movimento di sinistra variamente intesa dovrebbe ancora combattere oggi: com’è possibile che questa posizione non solo non sia più (percepita come) coerente con ideali di sinistra ed emancipativi, ma sia addirittura diventata patologica e pure fascista?

Poi, però, in questi stessi ambienti accademici (come in molti della militanza di sinistra) ci si straccia le vesti di fronte all’“onda nera” che travolge Europa e Stati Uniti, spesso, ancora una volta, con studi che, se finalmente prendono in considerazione il ruolo delle “emozioni”, il più delle volte lo fanno per dare una spiegazione tendenzialmente psico-patologica del voto a destra, che lascia a intendere quanto sia invece “razionale” quello progressista.

Sono convinta che ci sia un nodo da affrontare, qui. E che questo nodo abbia a che fare con ciò che impedisce un dialogo tra sinistra e classi popolari, dove la prima non fa nulla per dissimulare il suo disprezzo verso i valori e i modi di vita delle seconde proprio mentre si dispera perché queste non le tributano più i loro consensi e preferiscono cercare e inseguire altre narrative.

Ma è un nodo che riguarda anche l’accademia. La quale, muovendosi lungo percorsi in fondo molto simili, denuncia con tanta veemenza quanta superficialità i pericoli delle fake news e del complottismo, malattie che ovviamente contagerebbero di preferenza il “popolino”, e nel contempo si allarma di fronte alla perdita di credibilità delle “autorità epistemiche consolidate”, cioè università e istituzioni scientifiche, agli occhi (di parti rilevanti) del popolo stesso. Tendendo però a liquidare ogni problema, come vedremo, attraverso le interpretazioni auto-assolutorie del populismo, politico ed epistemologico, e della post-verità.

Per questi motivi credo sia importante affrontare in modo serio, finalmente, un tema come quello del complottismo, di ciò che lo produce, delle dinamiche storiche in cui si inserisce, e di ciò che esso stesso alimenta. E, in questo senso, il libro di Matthieu Amiech, come cercherò di evidenziare nelle prossime pagine, fornisce parecchi elementi preziosi, illuminanti. Quello che invece farò io, in queste pagine, sarà provare a introdurre il tema partendo dall’individuare aporie e contraddizioni nelle sue interpretazioni oggi largamente prevalenti (da parte del giornalismo, ma anche della sinistra e del sapere accademico), per poi contestualizzarlo all’interno del più ampio problema del rapporto tra scienza e politica, rintracciandone alcune connessioni con la scientizzazione della politica e con il disincanto del mondo.

In questo percorso, seguirò principalmente il filo argomentativo del libro; cercherò però anche di intessere un dialogo tra questo e alcune ricerche e pubblicazioni che ho portato avanti negli ultimi anni, con amici/he e colleghi/e, su temi affini o contigui; e con varie altre letture recenti. Tra queste, in particolare, si potranno riconoscere le impronte significative del Manifeste conspirationniste (Seuil 2022), di The divide: how fanatical certitude is destroying democracy (di Taylor Dotson, MIT Press 2021) e di Favole del reincanto: molteplicità, immaginario, rivoluzione (di Stefania Consigliere, Derive Approdi 2020).

INIZIAMO A SFATARE QUALCHE LUOGO COMUNE

Cosa c’è dunque che non va in quelle reazioni così frequenti e automatiche? Cosa non funziona in quelle diagnosi che in modo così lineare, e semplice, individuano quasi tutti i problemi dell’oggi nell’ignoranza e nell’“analfabetismo funzionale” che rende il popolo (o comunque sempre “gli altri”) facile preda di fake news e complottismo?

Proviamo a sollevare qualche velo. Un primo problema è dato dal focalizzarsi su una fotografia istantanea senza tenere in considerazione come siamo arrivati a questo punto. Quando invece occorrerebbe partire dalla presa di consapevolezza, suggerita da Frédérique Lordon e ripresa da M. Amiech, della colpevole confisca del dibattito pubblico che ha sistematicamente privato la cittadinanza della possibilità e dei mezzi per capire le forze storiche che la dominano e per partecipare ai processi decisionali che disegnano gli scenari in cui dovrà vivere. Il complottismo, in questa prospettiva, appare piuttosto come sintomo di un’espropriazione, e come rifiuto, al tempo stesso e nonostante tutto, ad abdicare alla volontà di capire, di darsi una spiegazione.

Ci imbattiamo, continuando a sollevare qualche velo, nell’inadeguatezza e nella parzialità dell’informazione offerta dalle testate del mainstream, che in maniera crescente e accelerata negli ultimi anni si è intrecciata con dinamiche di militarizzazione del confronto, conformismo, censura e autocensura, dove su troppi temi i punti di vista dissonanti vengono immediatamente respinti come fake news, in un dibattito chiuso prima ancora di averlo aperto. Il complottismo, dunque – o meglio, l’etichettamento di posizioni critiche come complottiste – usato come arma politica per screditare il dissenso. Ma questa stigmatizzazione di posizioni minoritarie non si limita al piano verbale: come nel caso dei vaccini (per ora), ha legittimato soluzioni autoritarie nel segno dell’esclusione, della privazione di diritti essenziali, della separazione della cittadinanza tra meritevoli e non, sulla base dell’adesione e dell’obbedienza. È chiaro, e pure un’abbondante letteratura scientifica lo dimostra, che questo tipo di scelte – sia comunicative che politiche e legislative – determina un effetto boomerang (Attwell e Smith 2017; Goldenberg 2021), provocando la rottura della sfera pubblica come luogo di confronto di habermasiana memoria e, quindi, radicalizzazione delle posizioni (da entrambe le parti però, anche se si tende a dimenticarlo). Ma, tra chi viene escluso, si tratta di molto di più: di un senso di crescente estraniazione dal sistema di valori dominante e dalle sue categorie di lettura della realtà, di vissuti di lacerazione profonda e sofferta di legami e appartenenze, di «continenti percettivi che si allontanano, di forme di vita che diventano inconciliabili» (Manifeste, p. 31). Da qui occorre partire per capire come mai, a volte, si possa anche passare da una salutare diffidenza verso le narrazioni del potere alla convinzione, più problematica, che “tutto ciò che ci è stato insegnato è falso”.

Se solleviamo un altro velo, ci imbattiamo questa volta nella superficialità che conduce a un classismo evidentemente ignaro di sé. Quando parliamo di persone, e magari studiose/i, di sinistra, colpisce lo sbrigativo appiattimento sulle categorie ipersemplificanti e stigmatizzanti introdotte dal giornalismo mainstream (anti-vax, complottista e tutte le altre richiamate sopra). Soprattutto perché sono diversi gli studi che hanno invitato a uno sguardo più attento e cauto quando si parla di “complottismo”. Sottolineando, innanzitutto, come questo tenda a proliferare dove lo scostamento tra la realtà esperita dalle persone e la sua rappresentazione da parte di media e istituzioni supera una soglia critica. Il complottismo – o quello che molti definiscono con questa categoria, comunque problematica – prospera, insomma, sulle bugie delle élite. E ancor prima, sul non detto: prospera, cioè, laddove questioni che hanno un peso cruciale sulle nostre vite non diventano oggetto di un dibattito pubblico, aperto e capace di dare cittadinanza e legittimità ai diversi punti di vista.[1] Che è come dire, rovesciando la prospettiva, che sempre più spesso i presunti “complottisti” sono (lasciati) i soli a trattare, con mezzi e risorse eterogenei, questioni assolutamente vitali: dalle tecnologie 5(6)G all’impatto della più generale digitalizzazione della società, dal transumanesimo alle politiche sanitarie emergenziali.

E poi, soprattutto: chi decide quali teorie sono complottiste? Cosa distingue una teoria sociale critica da una conspiracy theory? Puntando l’attenzione sulle traiettorie seguite delle teorie sociali, Pelkmans e Machold (2011) mostrano come siano quelle promosse e sostenute dalle classi subalterne quelle che, con maggiore probabilità, finiranno per essere etichettate come complottiste. Non è insomma questione di fondatezza o razionalità, poiché non è agevole né forse possibile individuare criteri di distinzione su un mero piano epistemologico. Alla fine, la differenza la fanno i rapporti di potere. Tanto che una teoria del complotto, se sostenuta da attori in posizioni di potere, difficilmente sarà riconosciuta e ricordata come tale, anche qualora ne venga chiaramente dimostrata l’infondatezza, la strumentalità, talvolta la portata nefasta dei risultati (classico l’esempio delle “armi di distruzione di massa” suppostamente detenute da Saddam Hussein).

Del resto, a proposito di classismo, non ha destato le reazioni che avrebbe meritato la presa fortissima che ha recentemente acquisito, sugli scambi comunicativi di tutti i giorni, l’idea per cui solo chi ha un titolo di studio specifico sia titolato a parlare. Frutto avvelenato (uno dei tanti) del burionismo. Eppure, una tale idea è stata accolta e fatta propria, anche, o forse soprattutto, a sinistra. Senza la minima preoccupazione di quanto ciò significasse legittimare il silenziamento di quanti non hanno un titolo di studio elevato, il che poi sottende evidenti implicazioni di classe e giustizia sociale; né di quanto, in questo modo, si alimenti acriticamente la logica pericolosa per cui tanto si riserva il potere di decidere agli “esperti”, quanto inevitabilmente si spinge verso la depoliticizzazione delle questioni, restringendo lo spazio del dissenso e del confronto (ci tornerò più avanti).

Ma continuiamo a scavare. Siamo sicuri che sia (solo) il complottismo il problema? Non sarebbe urgente problematizzare anche, o forse soprattutto, quello che alcuni hanno battezzato il “dispositivo anti-complottista” e le sue implicazioni politiche?[2] Un’operazione, questa, che svolge il Manifeste conspirationniste, mostrando le vicende storiche che legano strettamente le origini della retorica anti-complottista – quindi fin da Karl Popper – con la genesi del neoliberalismo e del suo There Is No Alternative. Se tentare di produrre una intelligibilità storica del corso degli eventi è una presunzione fatale; se chiunque tenti di dire qualcosa su questo mondo che questo non dica già da sé oltrepassa i suoi diritti epistemologici: allora, non resta che adattarvisi. La funzione del dispositivo anti-complottista è fin dalle sue origini, questa la tesi degli autori, quella di legittimare l’ordine sociale esistente, ambendo a riservare per sé la facoltà di cospirare.

NOTE

[1] Cfr. Pelkmans e Machold (2011), Lagalisse (2020); sul tema del prosperare del complottismo sulle bugie dei potenti si può vedere anche la mia intervista a Erica Lagalisse, Teorie della cospirazione e critica sociale. Come il complottismo prospera, non sempre a torto, sulle bugie delle élite, “Malamente”, n. 20, gennaio 2021, p. 47-62, <https://rivista.edizionimalamente.it>.

[2] In Italia se ne è occupato per es. Lolli (2023)

RIFERIMENTI BIBLIOGRAFICI

Anonimo (2022), Manifeste conspirationniste, Parigi, Seuil.

Attwell K., Smith D.T. (2017), Parenting as politics: social identity theory and vaccine hesitant communities, “International Journal of Health Governance”, 22(3): 183-98.

Bazzoli, N., Lello, E. (2022), The neo-populist surge in Italy between territorial and traditional cleavages, “Rural Sociology”, 87(1): 662-691.

Bordignon, F. (2023), Alternative science, alternative experts, alternative politics. The roots of pseudoscientific beliefs in Western Europe, “Journal of Contemporary European Studies”, 31(4): 1469-1488.

Bucchi, M., Neresini, F. (2002), Biotech remains unloved by the more informed, “Nature”, 416: 261.

Chalmers J. (2017), The transformation of academic knowledges: understanding the relationship between decolonizing and indigenous research methodologies, “Socialist Studies”, 12(1): 97-116.

Coniglione, F., eds. (2010), Through the mirrors of science. New challenges for knowledge-based societies, Heusenstamm, Ontos Verlag.

Consigliere, S. (2020), Favole del reincanto: molteplicità, immaginario, rivoluzione, Roma, DeriveApprodi.

de Sousa Santos, B., Nunes, J. A., Meneses, M.P. (2022), Opening up the canon of knowledge and recognizing difference, “Participations”, 32(1): 51-91.

Dentico, N., Missoni, E. (2021), Geopolitica della salute: Covid-19, OMS e la sfida pandemica, Soveria Mannelli, Rubbettino.

Dotson, T. (2021). The divide: how fanatical certitude is destroying democracy, Cambridge, MIT Press.

Foucart, S., Horel, S., Laurens, S. (2020), Les gardiens de la raison: enquête sur la désinformation scientifique, Parigi, La Découverte.

Gigerenzer, G. (2015), Imparare a rischiare: come prendere decisioni giuste, Milano, Cortina.

Goldenberg, M. (2016), Public misunderstanding of science? Reframing the problem of vaccine hesitancy, “Perspectives on Science”, 24(5): 552-81.

Goldenberg, M.J. (2021), Vaccine hesitancy: public trust, expertise, and the war on science, Pittsburgh, University of Pittsburgh Press.

Grignolio, A. (2016), Chi ha paura dei vaccini?, Torino, Codice.

Harambam, J. (2021), Against modernist illusions: why we need more democratic and constructivist alternatives to debunking conspiracy theories, “Journal for Cultural Research”, 25(1): 104-122.

Harambam, J., Aupers, S. (2015), Contesting epistemic authority: conspiracy theories on the boundaries of science, “Public Understanding of Science”, 24(4): 466-480.

Jasanoff, S. (2021), Knowledge for a just climate, “Climatic Change”, 169(3): 1-8.

Kahneman, D. (2012), Pensieri lenti e veloci, Milano, Mondadori.

Keren, A. (2018), The public understanding of what? Laypersons’ epistemic needs, the division of cognitive labor, and the demarcation of science, “Philosophy of Science”, 85(5): 781-792.

Lello, E. (2020), Populismo anti-scientifico o nodi irrisolti della biomedicina? Prospettive a confronto intorno al movimento free vax, “Rassegna Italiana di Sociologia”, 3: 479-507.

Lello, E., Raffini, L. (2023), Science, pseudo-science, and populism in the context of post-truth. The deep roots of an emerging dimension of political conflict, “Rassegna Italiana di Sociologia”, 4: 705-732.

Lello, E., Saltelli, A. (2022), Lobbismo scientifico e dirottamento dello spazio pubblico, in E. Lello, N. Bertuzzi (eds.), Dissenso informato. Pandemia: il dibattito mancato e le alternative possibili, Roma, Castelvecchi, 187-203.

Lolli, A. (2023), Il complottismo non esiste o Miseria dell’anticomplottismo, in M.A. Polesana, E. Risi (eds.), (S)comunicazioni e pandemia. Ricategorizzazioni e contrapposizioni di un’emergenza infinita, Milano-Udine, Mimesis, 239-271.

Nunes, J. A., Louvison, M. (2020), Epistemologies of the South and decolonization of health: for an ecology of care in collective health, “Saude e Sociedade”, 29(3): e200563.

Osimani, B., Ilardo, M.L. (2022), “Nessuna correlazione”. Gli strumenti per la valutazione del nesso causale tra vaccinazione ed evento avverso, in E. Lello, N. Bertuzzi (eds.), Dissenso Informato. Pandemia: il dibattito mancato e le alternative possibili, Roma, Castelvecchi, 167-186.

Pielke, R.A.J. (2005), Scienza e politica, Roma-Bari, Laterza.

Quijano, A. (2005), Colonialidade do poder, eurocentrismo e América Latina, in A colonialidade do saber: etnocentrismo e ciências sociais. Perspectivas latino-americanas, Buenos Aires, Clacso, 117-142.

Reich, J.A. (2014), Neoliberal mothering and vaccine refusal: imagined gated communities and the privilege of choice, in “Gender and Society”, 28(5): 679-704.

Sarewitz, D. (1996), Frontiers of illusion: science, technology, and the politics of progress, Philadelphia, Temple University Press.

Saurette, P., Gunster S. (2011), Ears wide shut: epistemological populism, argutainment and Canadian conservative talk radio, “Canadian Journal of Political Science”, 44(1): 195-218.

Schadee, H.M.A., Segatti, P., Vezzoni C. (2019), L’apocalisse della democrazia italiana: alle origini di due terremoti elettorali, Bologna, Il Mulino.

Smith, P.J., Chu, S.Y., Barker, L.E. (2004), Children who have received no vaccines: who are they and where do they live?, “Pediatrics”, 114(1): 187-95.

Steinberg, T. (2006), Acts of God: the unnatural history of natural disaster in America, Oxford, Oxford University Press.

Taussig, M.T. (1986), Shamanism, colonialism, and the wild man: a study in terror and healing, Chicago, University of Chicago Press.

Wei, F., Mullooly, J.P., Goodman, M., McCarty, M.C., Hanson, A.M., Crane, B., Nordin, J.D. (2009), Identification and characteristics of vaccine refusers, “BMC Pediatrics”, 9(18): 1-9.

Wu Ming 1 (2021), La Q di Qomplotto. QAnon e dintorni. Come le fantasie di complotto difendono il sistema, Roma, Alegre.

Ylä-Anttila, T. (2018), Populist knowledge: post-truth repertoires contesting epistemic authorities, “European Journal of Cultural and Political Sociology”, 5(4): 356-388.

Zagzebski, L.T. (2012), Epistemic authority: a theory of trust, authority, and autonomy in belief, Oxford, Oxford University Press.

Zografos, C., Robbins, P. (2020), Green sacrifice zones, or why a green new deal cannot ignore the cost shifts of just transitions, “One Earth”, 3(5): 543-546.

Il puzzle del sesso biologico - Il proposito di Trump e un possibile diverso atteggiamento

Il 20 gennaio 2025, Donald J. Trump ha pronunciato il suo discorso presidenziale durante la cerimonia di insediamento come 47esimo presidente degli Stati Uniti. Fra i tanti propositi espressi, c’è quello di mettere fine alla «alla politica governativa di manipolare socialmente genere e razza. Da oggi, la politica ufficiale del governo degli Stati Uniti sarà che ci sono solo due generi: maschi e femmine» . Si è dimenticato che esistono gli intersex e che la materia è molto più complessa. Ma si sa, politici e giornalisti sono noti per banalizzare questioni serie e stravolgere la realtà.

In alcuni post precedenti (La costruzione di una identità, prima parte - Sesso (biologico), genere (sociale) e orientamento sessuale: 3 concetti non sovrapponibili, Seconda parte – Il sesso nell’antichità, Individuare il sesso, una storia infinita, e Cosa succede quando si nasce intersessual*?), abbiamo analizzato come nel campo biomedico si è costruito (nel tempo) il sesso biologico e diversi casi controversi nell’attribuzione dell’identità sessuale. L’antropologia, poi, è un campo privilegiato per conoscere come (in molte culture) l’identità sessuale sia uno “spettro” (nel senso di un fascio policromatico, un raggio d'azione, un range) più che un’ontologia dicotomica o binaria. Siamo quindi giunti alla conclusione che il sesso biologico è un puzzle costituito da molteplici tessere: cromosomi, marcatori genetici molecolari, dotti riproduttivi, gonadi, ormoni, organi riproduttivi per la loro funzione, genitali per la forma e funzione, pubertà (intesa come flusso ormonale secondario) e funzioni riproduttive incluse (ma non unicamente), produzione del seme, inseminazione, gestazione e caratteristiche sessuali secondarie quali sporgenza della cartilagine tiroidea che circonda la laringe (o pomo d’Adamo), crescita dei capelli, rapporto tra massa grassa e muscolare, crescita mammaria, voce, sesso psicologico, educazione ecc. L’intersessualità, nella larga maggioranza dei casi, non incide in modo significativo sulla salute della persona. E i genitali sono, quindi, soltanto una parte del corpo, che varia da persona a persona, come i nasi o le orecchie o altre parti del corpo. L’aspetto e loro dimensioni non sono determinanti per l’attribuzione sessuale.

LA MANIA DELLE CLASSIFICAZIONI

Al di là delle varie (controversie) metodiche per attribuire il sesso a una persona, forse vale la pena chiedersi: ma perché è così importante stabile se quello davanti a me è un maschio o una femmina (ammesso che lo si possa determinarlo così facilmente)? Qual è lo scopo di una classificazione?

Il sociologo Harold Garfinkel, il padre dell’etnometodologia , sosteneva che qualsiasi categorizzazione (o il collocamento di un oggetto/pianta/animale/persona in un tipo) è una costrizione, sempre relativa perché stabilita in relazione agli scopi pratici (“for all practical purposes”) di coloro che classificano[1]. In altre parole, non c’è nulla nella referente osservata che indichi a quale categoria essa debba necessariamente appartenere. Una posizione anti-essenzialista, che condivide con la filosofia taoista dove non esistono valori assoluti, enti fissi o immobili, esseri o cose a sé stanti, come invece le categorie vorrebbero.

Per cui, ogni volontà di classificazione risponde a una necessità pratica. Nello sport, dove in tempi recenti sono stati sollevati i casi dell’ostacolista spagnola Maria José Martínez-Patiño, della mezzo-fondista sudafricana Caster Semenya, della calciatrice zambiana Barbra Banda e (pochi mesi fa) della pugile algerina Imane Khelif (vedi Individuare il sesso, una storia infinita), lo scopo sarebbe di porre tutte e tutti nelle medesime condizioni di partenza. Che è un’assurdità, perché non siamo tutti e tutte uguali, neanche… alla partenza. Giancarlo Antonioni (grande n. 10 della Fiorentina) non era uguale a Pelè (n. 10 del Santos). Lo scontro, se fosse stato un duello individuale, sarebbe stato impari. Come lo fu, nel 1970 e 1971, tra Carlos Monzon e Nino Benvenuti. Eppure stavano nella stessa categoria (pesi medi).

Inoltre, se la differenza tra uomini e donne fosse così netta, come mai certe tenniste (ma l’esempio lo si può fare per tutti gli sport) possono benissimo battere certi tennisti? Non ci sono solo il testosterone o 1 coppia cromosomica a fare la differenza, ma una molteplicità di altre variabili. Che sfuggono alle categorizzazioni, che le categorie non riescono a gestire. Il pugile Primo Carnera combatteva con quelli del suo peso, eppure forse aveva un vantaggio datogli da una presunta malattia genetica (l’acromegalia), in cui l'eccessiva produzione di ormone della crescita (Growth Hormone, GH) indotto spesso da un adenoma dell'ipofisi produce una serie di modificazioni degli arti e dei tratti facciali (anche il campione statunitense di wrestling André The Giant sembra esserne affetto). Attorno alle atlete sopra ricordate nacquero molte polemiche (che produssero anche squalifiche). Eppure loro erano nate così. Invece il velocista sudafricano Oscar Pistorius non era nato con le protesi in fibra di carbonio; eppure dal 2008 fu ammesso a gareggiare con i (cosiddetti) normodotati.

Ma non perdiamo la domanda di partenza: qual è la necessità pratica che presiede questa particolare necessità di classificazione binaria (maschi e femmine) nello sport? La competizione. Stabilire chi è il migliore, chi è il primo, chi è il più bravo. Lo scopo (eminentemente pratico) è solo questo. Non ci sono altre ragioni. Togliamo questa ragione (eminentemente pratica) e tutto crolla. Infatti, sono certo che se le pugili Imane Khelif (accusata di essere un uomo) e Angela Carini lavorassero nella stessa azienda, nessun politico chiederebbe (perché contrattualmente, purtroppo, le cose stanno ancora così in molte professioni) per Khelif uno stipendio maggiore perché ha una coppia di cromosomi XY. Perché se lo facesse, arriveremmo al paradosso che, lei sarebbe un maschio per lo sport e una femmina per il lavoro.

Ma non perdiamo la domanda di partenza: qual è la necessità pratica che presiede questa particolare necessità di classificazione binaria (maschi e femmine) nello sport? La competizione. Stabilire chi è il migliore, chi è il primo, chi è il più bravo. Lo scopo (eminentemente pratico) è solo questo. Non ci sono altre ragioni. Togliamo questa ragione (eminentemente pratica) e tutto crolla. Infatti, sono certo che se le pugili Imane Khelif (accusata di essere un uomo) e Angela Carini lavorassero nella stessa azienda, nessun politico chiederebbe (perché contrattualmente, purtroppo, le cose stanno ancora così in molte professioni) per Khelif uno stipendio maggiore perché ha una coppia di cromosomi XY. Perché se lo facesse, arriveremmo al paradosso che, lei sarebbe un maschio per lo sport e una femmina per il lavoro.

UNA PROPOSTA DI SOLUZIONE PER GLI SPORT DI SQUADRA

In attesa di trovare delle soluzioni per gli sport individuali, qualcosa invece si potrebbe già fare, almeno per quelli collettivi. Unico settore dove ancora esiste una rigida divisione tra maschi e femmine (con tutti i controlli necessari per incasellare le persone in una delle due categorie) ormai scomparsa a scuola, nei collegi, nella polizia e perfino nell’esercito, un tempo autentica palestra machista. Perché mantenere questo apartheid sportivo, anziché dissolverlo in squadre miste e intersex?

NOTE

[1] Ad esempio i censimenti e le classificazioni anagrafiche sono nate per scopi pratici: il controllo sociale della popolazione, la quantificazione dei beni, il reclutamento di militari ecc. Infatti, le prime informazioni riguardo a indagini sulla popolazione risalgono addirittura al 3800 a.C. dove i Sumeri affrontavano vere e proprie indagini per misurare la quantità di uomini e beni di cui si poteva disporre. Le informazioni acquisite erano utili soprattutto in caso di guerra o di carestie. Nella Bibbia si fa riferimento al censimento effettuato da Mosè nel Sinai: il Signore parlò a Mosè, (…), e disse: ‹‹Fate il censimento di tutta la comunità degli Israeliti, secondo le loro famiglie, secondo il casato dei loro padri, contando i nomi di tutti i maschi, testa per testa, dall'età di venti anni in su, quanti in Israele possono andare in guerra (…)››. (Numeri 1, 1-3. Vedi anche Esodo 30,11-16): https://it.wikipedia.org/wiki/Censimento. Il controllo sociale è anche il principale motivo per cui è nata la statistica sociale.

Internet ci rende transumani - La fattoria degli umani di Enrico Pedemonte

1. QUELLO CHE L’UTOPIA NON SA

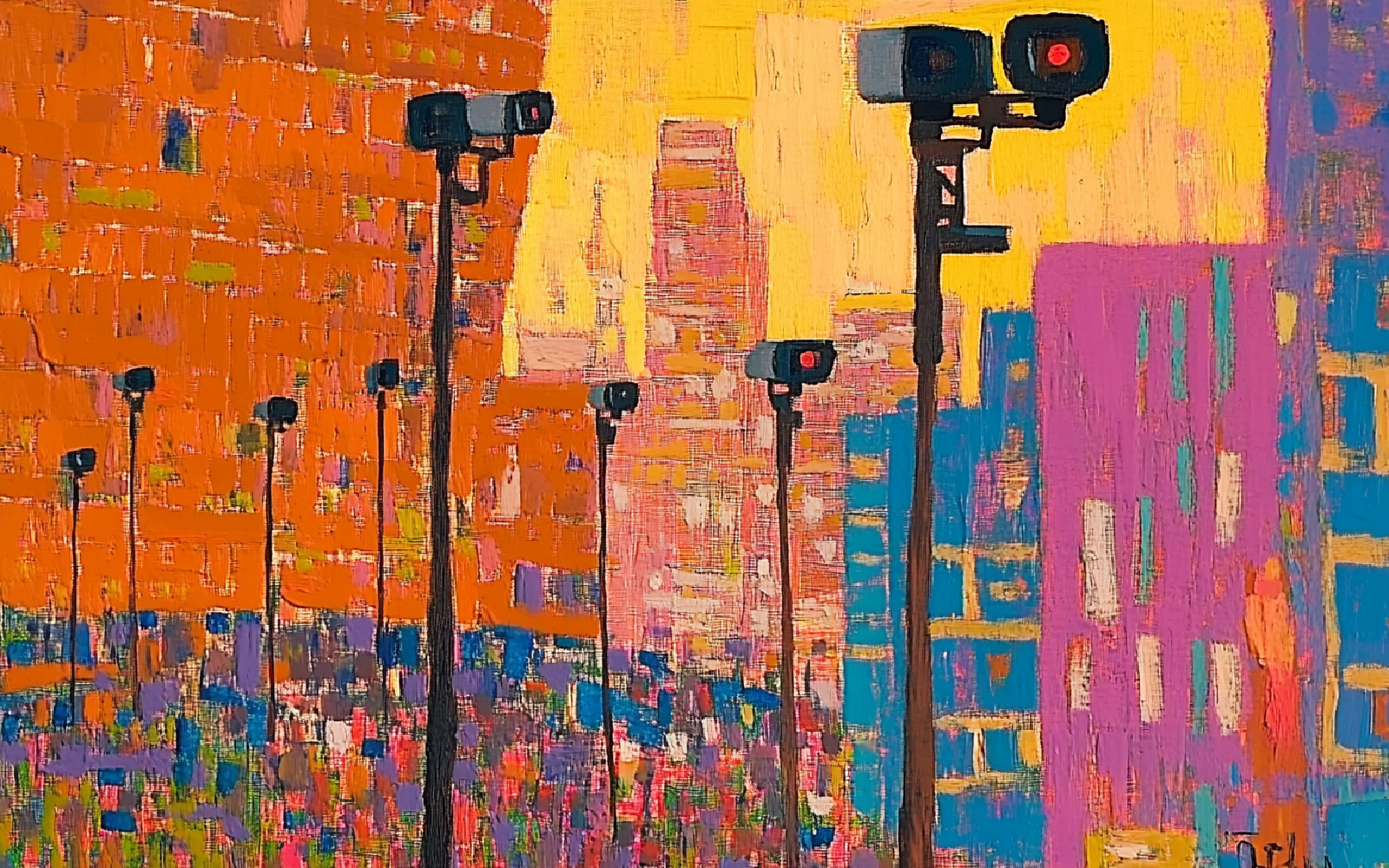

«Il male che gli uomini fanno sopravvive loro; il bene è spesso sepolto con le loro ossa». Il rammarico dell’Antonio di Shakespeare potrebbe essere rivolto alle utopie che hanno accompagnato la nascita di Internet e dei dispositivi digitali, e i nomi di di Vannevar Bush o di Douglas Engelbart potrebbero sostituirsi a quello di Cesare. Nel 2008 Nicholas Carr si domandava se Google ci rende stupidi, e di sicuro oggi molti analisti concordano sul fatto che non siamo qui a lodare la convinzione che le macchine possano contribuire ad aumentare l’intelletto umano – ma a seppellirla. Dalla presentazione del 9 dicembre 1968, con cui Engelbart ha mostrato per la prima volta l’interazione con un computer tramite mouse e interfaccia grafica, siamo passati attraverso la commercializzazione massiva della Rete, la formazione dei monopoli delle Big Tech, il saccheggio dei dati personali, lo sviluppo della società del controllo, la dipendenza patologica dalle piattaforme, la filter bubble, la polarizzazione delle opinioni e il dibattito sulla disinformazione. Di sicuro si è persa l’innocenza delle origini, la promessa di un nuovo mondo della comunicazione, la speranza di una libertà che il principio di realtà aveva negato nel mondo offline, la fiducia in comunità virtuali, senza confini, dove raggiungere una piena espressione del sé di ognuno.

Enrico Pedemonte ripercorre la storia che porta da Vannevar Bush fino ai nostri giorni in La fattoria degli umani, cercando di capire cos’è successo all’utopia degli spazi digitali, cosa si è inoculato nel sogno di un’umanità più perspicace e più emancipata precipitandolo in un incubo, nel terrore che tutto possa concludersi con lo sterminio della nostra specie da parte di un’AI superintelligente. L’ipotesi che un giorno o l’altro una macchina assuma l’aspetto di Terminator e compia una strage, come in un film di fantascienza, non è una preoccupazione realistica; ma è significativo che la retorica da cui viene accompagnato lo sviluppo delle nuove tecnologie abbia dismesso l’entusiasmo per l’intelligenza connettiva di Pierre Lévy, e abbia abbracciato il timore di scenari catastrofici. Pedemonte sospetta che un vizio sia presente fin dall’origine, e che i suoi effetti si siano amplificati con l’espansione della forza economica e del potere politico dei giganti della Silicon Valley.

2. IMMUNITÀ LEGALE

Anzi, i difetti sono almeno due, e si sono rafforzati l’un l’altro, o sono forse due sintomi di una stessa crisi, ancora più profonda. Il primo ha origine fuori dall’ambiente culturale della Silicon Valley, e si sviluppa nel cammino tormentato con cui il parlamento americando ha raggiunto la versione definitiva del Communications Decenct Act. La legge stabilisce che le piattaforme online non devono essere equiparate agli editori tradizionali, e le tutela da ogni intervento del governo nei loro confronti: in questo modo attori del nascente mercato digitale, come Google, Facebook, Twitter, sono stati messi al riparo da qualunque regolamentazione sia sul controllo dei contenuti, sia sulla ripartizione della distribuzione pubblicitaria – e più in generale sulla valutazione delle loro posizioni monopolistiche nei settori della ricerca, dei social media, dell’intelligenza artificiale. La supervisione che viene applicata ai giornali, alle radio e alle reti televisive, non agisce sugli algoritmi che gestiscono il ranking dei listati di risposte, la selezione dei post e la composizione delle bacheche personali, la profilazione dell’advertising: eppure tra il 2004 e il 2021 il numero di giornali nel mondo è quasi dimezzato (-47%), mentre l’accesso alle notizie tramite i social media è diventato una consuetudine tra gli utenti del Web.

Ma l’obiettivo delle piattaforme tecnologiche non è quello di consolidare la fiducia dei lettori nella verità dei contenuti divulgati, bensì quello di trattenerli il più possibile nella compulsione delle bacheche, e nell’incentivare il più possibile l’interazione con like, commenti, condivisioni. Mentre la verità si sta ancora allacciando le scarpe, una bugia ha già fatto il giro del mondo: così chiosava Mark Twain. Il controllo delle informazioni richiede tempo, e il più delle volte una storia esposta in buona fede è affetta da lacune, passaggi critici, contraddizioni; l’artefazione, o (quando serve) l’invenzione completa dei fatti, possono invece adattarsi all’ecosistema ideologico degli interlocutori, e sfrecciare da una mente all’altra senza ostacoli. La fatica che è richiesta all’utente nella ricognizione della complessità del reale, gli viene del tutto risparmiata quando la notizia è costruita attorno all’effetto emotivo, che suscita scandalo, orrore, sdegno o pietà. Le notizie a tinte forti attraggono i clic, coinvolgono i lettori, accendono il dibattito – spingono verso la radicalizzazione dei pregiudizi, a detrimento della riflessione e della mediazione. Gli esiti sono tossici per lo stato di salute delle democrazie e per la coesione sociale; per i bilanci delle società che amministrano le piattaforme sono invece un toccasana, perché assicurano il buon funzionamento della loro attività produttiva principale, l’estrazione dei dati.

3. DATI

Shoshana Zuboff ha sottolineato l’affinità tra il modello di business di imprese come Google e Facebook da un lato, e l’industria mineraria o petrolifera dall’altro lato. Le informazioni che le Big Tech estraggono dal comportamento degli utenti permettono loro di conoscere le caratteristiche sociodemografiche, gli interessi, le opinioni, le abitudini, le relazioni personali, le disponibilità di spesa, le paure di ognuno e di tutti – e naturalmente anche di controllarli, manipolarli, sfruttarli. Nessun settore imprenditoriale si è mai rivelato tanto promettente dal punto di vista dei profitti, e nessuno è stato così agevolato nella crescita, e messo al riparo dalle difficoltà minacciate dalle istituzioni a tutela della privacy e della libera concorrenza, nonché dalle interferenze di attivisti e giornalisti troppo curiosi. Motori di ricerca e social media serbano una biografia di ciascuno di noi più ampia, più ricca e obiettiva, di quella che noi stessi sapremmo confessare nel segreto del nostro foro interiore: nella registrazione di tutte le nostre domande, dei nostri like e dei nostri post, protratta per anni, si deposita una traccia delle aspirazioni, degli interessi e delle paure di cui spesso non conserviamo una memoria cosciente, ma che i database di Google e di Facebook mettono a disposizione degli inserzionisti. Inconscio, abitudini e passioni, individuate nel momento in cui emergono da pulsioni interne o da opportunità sociali, diventano la leva ideale per vendere prodotti e servizi – ma anche candidati elettorali, ideologie, priorità e strategie politiche.

Le piattaformi digitali tendono al monopolio: le persone frequentano i posti dove si trovano già tutti i loro amici, o cercano le informazioni che sono condivise dai loro clienti e dagli interlocutori in generale. In questo modo chi ha accumulato più dati è in grado di offrire esperienze più divertenti e informazioni più personalizzate, intercettando quindi nuovi utenti e appropriandosi ancora di più dati. Chi vince piglia tutto, come accade a Google che detiene circa il 90% delle quote del mercato della ricerca online mondiale. La tensione che ha alimentato questa forma di capitalismo trova la sua ispirazione e giustificazione ideologica nella letteratura di Ayn Rand e della fantascienza che ha nutrito imprenditori, tecnici, guru, profeti e visionari nerd della Silicon Valley: è questo il secondo vizio – questa volta del tutto interno alla cultura tech – che ha segnato dalle origini il percorso delle utopie della Rete. L’umanità deve essere salvata da se stessa, dalla sua imperfezione e dalla sua mortalità, e questo compito può essere assunto solo da un eroe che trascende qualunque limite gli venga opposto dalla società, dalla legge, dalle tradizioni e persino dal buon senso (anzi, da questo prima di tutto). L’individualismo senza rimorsi, la tensione a diventare l’eletto che porterà gli altri uomini oltre se stessi, anche a costo della loro libertà – sono il codice in cui è scritto il programma utopistico della Rete, come sede della vita che vale la pena di essere vissuta. Chi non ce la fa, o chi cerca di resistere – o addirittura chi tenta di non essere d’accordo – è destinato a soccombere e a scivolare nell’oblio della storia. La violazione della privacy, il prelievo dei dati, la manipolazione delle intenzioni, non sono quindi attività illegali, ma sono i doni che l’eroe riversa sull’umanità, per liberarla dalle sue limitazioni, dalle sue paure irrazionali, dalla sua mortalità.

4. L’UOMO (?) CHE VERRÀ

Pedemonte elenca sette movimenti in cui si possono classificare le mitologie principali da cui è guidato il capitalismo della Silicon Valley: Transumanesimo, Estropianesimo, Singolarismo, Cosmismo, Razionalismo, Altruismo Efficace, Lungotermismo. Le categorie non sono esclusive, si può aderire a più parrocchie nello stesso tempo, o transitare nel corso del tempo da una all’altra. In comune queste prospettive coltivano il culto dell’accelerazione nello sviluppo di nuove tecnologie, l’ambizione di realizzare simbionti tra uomo e macchina, dilatando le capacità cognitive degli individui, riprogrammando la vita e la natura, eliminando imprevisti, patologie e – ove possibile – anche la morte.

Le aspirazioni appartengono alla fantascienza, le intenzioni utopistiche sono sepolte e dimenticate, ma lo sviluppo di metodi di controllo, l’accentramento monopolistico, la violazione della proprietà intellettuale, l’abbattimento progressivo dello stato sociale e la privatizzazione dei suoi servizi, sono ormai la realtà del capitalismo dei nostri giorni – che ha trovato nelle tecnologie digitali, e nell’etica hacker che ne sostiene la progettazione, la piattaforma su cui reinventarsi dopo la crisi degli ultimi decenni del XX secolo. La realtà che è sopravvissuta alle utopie novecentesche è un mercato che ha assorbito la politica e la cultura, dove l’unico individuo che può esprimersi liberamente è quello transumanistico, che pone la macchina come obiettivo, e l’autismo del nerd come modello di vita.

BIBLIOGRAFIA

Carr, Nicholas, Is Google Making Us Stupid?, «The Atlantic», vol. 301, n.6, luglio 2008.

Engelbart, Douglas, Augmenting human intellect: A conceptual framework, SRI Project 3578 Stanford Research Institute, Menlo Park California October 1962.

Lévy, Pierre, L'Intelligence collective. Pour une anthropologie du cyberespace, La Découverte, Parigi 1994.

Pedemonte, Enrico, La fattoria degli umani, Treccani, Milano 2024.

Zuboff, Shoshana, The Age of Surveillance Capitalism: The Fight for a Human Future at the New Frontier of Power, Profile Books, Londra 2019.

Biochar, il carbone amico

Quando pensiamo al carbone, andiamo subito col pensiero all’inquinamento, a colonne di fumo nero e denso e alle città coperte di fuliggine di non tanti decenni orsono. E, nonostante i progressi tecnologici che hanno reso progressivamente meno inquinanti i sistemi di combustione del carbone, questa visione è ancora attuale, perché il carbone è ancora largamente usato in tutto il mondo nelle centrali per la produzione di energia elettrica (circa il 30% dell’energia elettrica mondiale è prodotta da centrali a carbone, fonte IEA - International Energy Agency).

Ma in questo articolo parliamo di un altro tipo di carbone che - al contrario - ha delle proprietà che lo pongono agli antipodi del carbone fossile e dei suoi utilizzi: questo prodotto si chiama biochar e la sua scoperta è relativamente recente, i primi studi scientifici si devono al professor Johannes Lehmann della Cornell University negli anni 80.

Il biochar è il residuo carbonioso ottenuto dalla combustione in assenza di ossigeno di biomassa (materia organica). Qualsiasi tipo di biomassa di origine vegetale o animale, sottoposta al processo di combustione in assenza di ossigeno – pirolisi – produce biochar. Evidentemente la materia di partenza (feedstock), influisce sulle caratteristiche chimiche del prodotto finale.

Proviamo, qui, a dare una breve panoramica globale delle qualità di questo composto e a focalizzare un aspetto di particolare interesse, ovvero la sua capacità di stoccare CO2, diventando, quindi, anche un elemento per contrastare l’immissione di gas a effetto serra in atmosfera.

COME SI FA IL BIOCHAR

Il carbone vegetale si fa dalla notte dei tempi; in tutta l’Europa mediterranea c’erano le carbonaie dove si bruciavano residui legnosi per produrre carbone, il biochar è l’evoluzione scientifica di questo sapere antico.

Oggi esistono sofisticate apparecchiature che per produrre il biochar attivano un processo di combustione lenta a temperature di circa 500-600 gradi Celsius in assenza di ossigeno.

A partire dal feedstock introdotto, si realizzano essenzialmente tre prodotti:

- il biochar, ovvero la frazione solida del processo di pirolisi

- il syngas, i residui gassosi del processo

- il bio-olio, residuo liquido del processo

In realtà la questione è più complessa e se il processo di combustione prevede la presenza di limitate quantità di ossigeno, parliamo di “gassificazione” e l’output del processo è diverso.

Tuttavia, concentrandoci sul solo biochar, esso viene prodotto essenzialmente a partire da biomassa vegetale, residui legnosi di qualsiasi origine.

Si comprende facilmente che questo tipo di processo permette l’utilizzo e la valorizzazione circolare di materiale che altrimenti andrebbe disperso o bruciato senza alcun vantaggio. Parliamo dei residui di potature, sfalci, rami degli alberi che diventano tronchi puliti destinati alle segherie per usi industriali.

E su questo punto va aperta una parentesi: i boschi vanno gestiti e i piani di tagli programmati non solo non arrecano alcun danno ma, al contrario, fanno bene alla salute dei boschi.

Il problema è il disboscamento selvaggio e illegale (che non esiste in Europa), non certo la gestione forestale sostenibile che prevede dei tagli programmati mirati a rinforzare lo stato di salute del bosco o della foresta.

Nel processo di pirolisi, fatto cento in quantità il feedstock, la resa è del 25 – 30% circa, ovvero si ottiene, dalla combustione della massa vegetale, il 30% di biochar.

Ne risulta un prodotto simile alla carbonella che si usa per i barbecue, ma più fine, le cui caratteristiche principali sono la porosità, la capacità di trattenere l’acqua, il potere alcalinizzante dei terreni.

APPLICAZIONI IN AGRICOLTURA

Il biochar può essere utilizzato in agricoltura, come filtro nella depurazione di acque inquinate, nell’edilizia come materiale per l’isolamento, nella produzione di biocarburanti.

Ma il suo utilizzo attualmente più diffuso e importante è quello agricolo.

Distribuito sui terreni è un potente ammendante[1], quindi migliora la qualità chimiche, fisiche e biologiche dei terreni, rendendoli molto più produttivi e contrastando gli effetti della siccità perché trattiene l’acqua nei terreni.

Immesso nel terreno, il biochar aumenta il ph, quindi rende la terra più alcalina, aumenta la disponibilità di acqua, migliora le condizioni di sviluppo delle radici, migliora l’apporto e l’assorbimento di nutrienti per le piante, aumenta la resistenza alle malattie e ai fattori di stress ambientale.

In pratica, è una specie di potentissimo ricostituente dei terreni.

In funzione del tipo di terreno di cui si vogliono migliorare le caratteristiche chimico – fisiche, si potranno produrre diversi tipi di biochar (variando la composizione del feedstock e le condizioni di pirolisi) che daranno risposte mirate per obiettivi specifici. Risultati eccellenti si stanno raggiungendo con i terreni aridi, sabbiosi, sovrasfruttati.

BIOCHAR E ATMOSFERA

Ma c’è un’altra caratteristica di grande interesse di questo prodotto, esso è efficace per il sequestro di CO2 dall’atmosfera.

Infatti, al termine del processo di produzione, la CO2 presente nel materiale vegetale viene mineralizzata e quindi “intrappolata” nel biochar. Circa il 90% di questa CO2 resta inglobato nella struttura molecolare del prodotto che rimane stabile per centinaia di anni.

È bene precisare che è giusto parlare di sequestro e non di stoccaggio della CO2 in quanto si tratta di carbonio di origine vegetale fotosintetizzato a partire da CO2 atmosferica.

In questo modo il biochar diventa anche uno strumento di lotta all’effetto serra, e infatti la sua produzione permette anche di emettere crediti di carbonio (al termine di un processo di certificazione) da vendere sul mercato volontario (quindi non per le aziende obbligate a compensare le proprie emissioni).

Che i boschi bruciati rinascano velocemente e con grande forza è un fenomeno conosciuto da sempre; una delle ragioni che determinano questa situazione è la modifica delle caratteristiche del suolo dovuta alle ceneri. È esattamente ciò che fa il biochar.

A volte la scienza va avanti guardando al passato.

PER APPROFONDIRE

Ichar, Associazione Italiana Biochar

International Biochar Initiative

Unibo, Biochar, presente e futuro

NOTE

[1] La differenza tra una sostanza ammendante e un fertilizzante è che la prima interviene sulla struttura del suolo e apporta migliorie stabili nel tempo, i fertilizzanti sono solo l’immissione nel terreno di sostanze nutritive che vengono utilizzate e consumate dalle piante.

Covid, tecnocrazia e "vera" politica - Due progetti paralleli

Dalle prime due parti (qui, la prima parte e qui, la seconda parte) dell’analisi degli algoritmi di valutazione dell'andamento della pandemia, ad aprile 2020, è emerso che questi algoritmi sono un caso solo apparente di tecnocrazia.

In realtà, abbiamo visto che:

- il tentativo di rendere gli algoritmi completi ha generato un eccesso di complessità che ha reso questi strumenti praticamente inservibili ai fini della decisione sulla Fase 2

- la decisione di passare alla Fase 2 è stata principalmente politica, seppur basata su un set minimale di dati scientifici, limitato ai trend di contagi, decessi e di saturazione delle terapie intensive.

Ora, questo non toglie che la relazione tra scienziati e governo abbia effettivamente avuto un carattere tecnocratico già nel primo periodo della pandemia[1], tra febbraio e maggio 2020.

Per comprendere la reale portata ed estensione di questo carattere tecnocratico faremo alcune brevi considerazioni su:

- il CTS e la rilevanza del valore della salute nella gestione della crisi

- il ruolo che ha giocato il CTS nei processi di decisione del governo

Vedremo che il governo ha preso le sue decisioni in modo principalmente politico ma, invece, ha lasciato ampio spazio a scienziati e tecnici sul come metterle in atto.

COS’ERA E COME FUNZIONAVA IL COMITATO MEDICO SCIENTIFICO

La presenza del CTS nel processo di decisione del Governo ha, certamente, amplificato il ruolo dei valori di salute e di sopravvivenza come condizioni di possibilità del bene comune e, quindi, ha condizionato le azioni del governo nella direzione di “prima la salute”.

Infatti:

- il ruolo del CTS era di dare consulenza al Capo del Dipartimento della Protezione Civile – e più tardi direttamente al Governo – su come fronteggiare la diffusione del contagio;

- i componenti del CTS erano “esperti e qualificati rappresentati degli Enti e Amministrazioni dello Stato”, di fatto 8 componenti su 12 erano medici: i tre presidenti del Consiglio superiore di sanità, dell'Istituto superiore di sanità e dell’AIFA, un professore di patologia clinica e di comunità, un esperto di medicina delle catastrofi, un infettivologo e un epidemiologico.

- Il CTS era sempre – ogni giorno, al mattino molto presto – l’iniziatore del processo di decisione. Era il CTS a effettuare la sintesi e il vaglio delle informazioni raccolte dal fronte del contagio e a prepararsi, sulla base dei dati, a dare consiglio al Capo della Protezione civile e ai rappresentanti del Governo, in primis al Ministro della Salute;

- spesso, il CTS agiva in coda al processo, assumendo la funzione di supporto e di legittimazione delle decisioni prese: i membri del CTS partecipavano e parlavano alle conferenze stampa e ai talk show fornendo elementi di spiegazione e di sostegno alle misure restrittive o meno del Governo.

Ora, per disciplina, per etica procedurale, la salute è il faro guida del medico, soprattutto in termini di assenza di malattia, di normale funzionamento del corpo, «Dovere del medico è la tutela della vita, della salute fisica e psichica dell'Uomo e il sollievo dalla sofferenza» (Codice di Deontologia Medica, all’Art. 3 – Doveri del Medico).

Ne risulta abbastanza ovvio che il CTS - un consesso di medici - si sia concentrato sui pilastri deontologici, guarire chi si è ammalato, garantire il funzionamento delle strutture di cura e, in caso di infettività, prevenire e controllare la diffusione della malattia.

Altrettanto ovvio appare il fatto che il Governo, consigliato e sostenuto dal CTS abbia posto i valori della salute e della sopravvivenza biologica al primo posto della propria scala assiologica nell’affrontare la crisi.

È interessante, peraltro, vedere che paesi iper-liberisti come Inghilterra e Brasile, in cui non c’era nulla di simile al nostro CTS, si siano, invece, orientati più nettamente sui valori della sussistenza economica delle imprese, del paese in generale e di conseguenza dei cittadini, mettendo in conto «un numero evitabile di persone contagiate e di morti» (Habermas J., Proteggere la vita, tr. It. D’Aniello F., Società editrice Il Mulino, 2022, p. 51); è famosa l’infelice frase di Boris Johnson: «many more families are going to lose loved ones before their time».

TECNOCRAZIA O NO?

Si ripropone quindi la domanda: Il Governo ha davvero preso delle decisioni, ha fatto delle scelte morali[2], oppure chi le ha fatte è stato il CTS?

Prima di provare a dare una risposta va ricordato che la più grande partita di decisioni si è giocata sul campo dell’economia, quello degli aiuti e dei sostegni economici.

Su questo campo il governo ha preso delle posizioni, ha compiuto delle vere e proprie scelte morali, basate su dei criteri e su una assiologia chiari; una assiologia che ha determinato la destinazione e i tempi dei sostegni economici, a chi prima e a chi dopo, a chi di più e a chi di meno. La scala di priorità è stata inizialmente concentrata sui lavoratori dipendenti delle imprese medio-grandi, quelle in grado di accedere alla cassa integrazione guadagni, per intenderci ed è poi cambiata, per rispettare le istanze di giustizia sociale portate avanti dalle opposizioni: occhio ai dimenticati dei primi momenti – tra cui liberi professionisti, lavoratori autonomi e microimprese.

Fatta questa premessa, proviamo a focalizzare quale sia stato il rapporto tra CTS e Governo nei primi mesi; l’analisi[3] di documenti video, di verbali e di decreti mostra che:

- è fuori di dubbio che il Governo abbia fatto delle scelte morali sul tema della salvaguardia della salute e della sopravvivenza. Il Governo ha delineato una scala di valori e questi valori li ha contestualizzati nel particolare della situazione che andava affrontando.

- È altrettanto fuori di dubbio che, nel costruire questa priorità di valori che vede salute e sopravvivenza in alto, il governo sia stato influenzato dal CTS – soprattutto dalla componente medica. Però, è emerso anche che la storia personale dei leader di governo, la tradizione di partito, le esperienze fatte, abbiano avuto un ruolo determinante

- Dove, invece, il Governo è stato molto più influenzato dal CTS sembra essere stato nel COME realizzare la tutela della salute e della vita. In questo, la vera scelta del governo è stata di affidarsi a tecnici, ai medici, agli epidemiologi. Lo dice Conte in passaggio chiarissimo il 25 di febbraio.[4]

- È evidente che la scelta di affidarsi a scienziati e tecnici è stata fatta sulla base del criterio delle competenze mediche e tecniche del CTS.

Quindi, sul come gestire la crisi, come salvaguardare la salute, il governo ha scelto di affidarsi, consapevolmente, a quelli che riteneva competenti e questo delinea palesemente una forma di tecnocrazia indiretta. Il processo analisi – sintesi – decisione – legittimazione in cui il CTS è dominante in tre passaggi su quattro ne è conferma.

Ma, ricordiamolo, all’inizio nessuno sapeva cosa stesse accadendo, né capiva cosa potesse accadere e, in quel momento di emergenza, il fattore tempo sembrava essere determinante[5].

Così come – in un momento successivo - ha fatto affidando a un militare la logistica della distribuzione dei vaccini. In Italia solo i militari hanno competenze logistico-operative e piani già pronti di quel tipo. Nessun altro. Non avrebbe potuto farlo un tecnico degli acquisti come Arcuri (bravo a reperire materiali con contratti emergenziali a prova di bomba).

Che poi il CTS abbia seguito delle linee super consolidate e tradizionali come l’ospedalizzazione sempre e comunque, la rinuncia alle cure domiciliari, linee che trovano una impressionante analogia nel Diario della Peste di Defoe – parliamo del 1665 – è altra cosa, su cui non credo di poter dare giudizi. Mi tengo dei sospetti.

Quindi, in conclusione, siamo stati di fronte ad una forma di solo parziale tecnocrazia, in cui il governo ha mantenuto per sé la prerogativa delle decisioni politiche sul cosa fare per gestire la crisi sanitaria ed economica, in termini di priorità, quantità, destinazioni, inclusioni ed esclusioni, ma ha ceduto sovranità alla scienza e alla tecnica sul come perseguire a questi obiettivi.

NOTE

[1] Non considero quello che è successo nei mesi successivi, con le due seconde ondate, quella di riaperture e quella di contagi dell’autunno 2020, del secondo lockdown, dei vaccini, del green pass e delle varie misure interdittive.

[2] Scelta morale: decisione su come orientare la propria condotta pratica basata su una scala di priorità tra principi o valori, appunto, morali.

[3] Le fonti sono i discorsi pubblici del Presidente de Consiglio e dei diversi Ministri – reperibili facilmente su YouTube o sul sito della Presidenza del Consiglio, i testi dei Decreti del presidente del Consiglio, i Decreti Ministeriali, le circolari della Protezione Civile, ecc.. Chi volesse avere un’ampia bibliografia e sitografia può chiederla alla Redazione di Controversie.

[4] Le parole di G. Conte: «io non ho competenza scientifica in questo campo, non ho alcuna competenza, e sarebbe presuntuoso […] sopravanzare e sovrapporsi a […] quelle che sono le valutazioni tecnico-scientifiche […] loro hanno articolato quelli che sono tutti i comportamenti e sono raccomandazioni indicazioni rivolte al personale sanitario e ovviamente a tutti i cittadini» (Conferenza stampa del Presidente Conte dalla Protezione civile, YouTube - Palazzo Chigi, Canale ufficiale del Governo italiano, 25 febbraio 2020 (https://www.youtube.com/watch?v=gWJoo8O6mZ8))

[5] Il problema del confronto con una situazione in cui «i fatti sono incerti, la posta in gioco alta, i valori in conflitto, e le decisioni urgenti» è affrontato dalle raccomandazioni della Scienza Post Normale; rimandiamo a Saltelli, A., 2024, SCIENZA POST-NORMALE, XI Appendice dell’Enciclopedia Italiana di Scienze, Lettere ed Arti, Istituto della Enciclopedia Italiana, Roma - https://www.researchgate.net/publication/387296164

L’arte di fare attenzione nel tempo delle catastrofi - Il pensiero di Isabelle Stengers

Nel suo libro Nel tempo delle catastrofi (2021, Rosemberg & Sellier), Isabelle Stengers, una delle più importanti filosofe della scienza contemporanee, propone in maniera divulgativa una serie di riflessioni che tentano di delineare una connessione tra il pensiero ecologista e quello femminista. Ciò che emerge dalla lettura, è che entrambi gli approcci non sono solo intimamente connessi, fino a rappresentare due facce della stessa medaglia, riguardo ai problemi che sollevano e agli scopi che si prefiggono, ma nella loro più profonda essenza sono accomunati perché esprimono anche una radicale rivalutazione – e archiviazione – della narrazione del progresso, nella sua duplice veste di obbiettivo delle scienze (incluse quelle sociali, e sì, anche delle humanities) e indiscusso fine economico.

Più precisamente quindi, è attraverso la mobilitazione di diverse prospettive – epistemologica, di genere e di ecologia politica – e mostrando esplicitamente l’impossibilità di scindere l’una dalle altre, che l’autrice elabora la propria proposta per riformare le scienze secondo una concezione del sapere fortemente democratica e anticlassista. Questo allo scopo precipuo di «imparare l’arte di fare attenzione», come lei dice, nel nuovo regime climatico in cui Gaia ha fatto irruzione, costringendoci a pensare e a convivere con le minacce ecologiche che mettono in crisi il nostro modello di civiltà[1].

Stengers, infatti, argomenta che per potersi dire davvero «obiettori della crescita», occorre mettere in discussione proprio «quali idee usiamo per pensare altre idee», come direbbe l’antropologa Marilyn Strathern, perché queste inficiano la possibilità di affermare una forma di organizzazione sociale veramente plurale e sostenibile, oltre che un controllo orizzontale e diffuso del sapere e della tecnica.

Per farlo quindi, la storica della scienza esamina la genealogia del pensiero moderno, a partire dalla scoperta dei «fatti sperimentali», come delle entità che acquisiscono la capacità di prefigurare il modo in cui essi stessi devono essere interpretati. Acquisendo dunque una certa autonomia nel far pensare e dirigere gli esseri umani che li hanno fabbricati. Un’autonomia che però, come illustra appunto l’autrice, è andata sempre più trasformandosi in indipendenza:

«Tuttavia, chi ha scoperto che una simile riuscita era possibile, Galileo, si è affrettato a generalizzarla, vale a dire a trasformare la riuscita (riuscire a produrre un tipo di fatto che “provi”) in metodo (inchinarsi davanti ai fatti). Gli diventava così possibile contrapporre la nuova ragione scientifica, che riconosce autorità ai soli fatti, all’attitudine di chiunque prenda posizione riguardo questioni indecidibili, che conferiscono potere alle sue convinzioni o ai suoi pregiudizi. Questa messa in scena è senza dubbio una delle operazioni di propaganda meglio riuscite nella storia umana, se è vero che essa è stata ripresa e ratificata anche da parte dei filosofi – sebbene essi stessi ne risultassero spogliati della loro pretesa all’autorità. Certi vanno ancora oggi ripetendo il giudizio lapidario di Gaston Bachelard: ‘In linea di principio, l’opinione ha sempre torto. L’opinione pensa male; anzi, non pensa; traduce dei bisogni in conoscenze’. Che questo giudizio sia stato emesso in un libro intitolato La formazione dello spirito scientifico è una circostanza capace di testimoniare di una logica profonda. Un tale “spirito scientifico” è definibile solo in contrapposizione a qualcosa che sarebbe “non scientifico” – e ciò vale anche quando qualcuno si crede intelligente a invertire specularmente il significato di questa opposizione, attribuendo alla “gente” una ricchezza soggettiva o emozionale di cui sarebbe invece privo lo spirito scientifico, freddo, calcolatore e razionale» (Cit. p. 88).

Si sviluppa così una prima contrapposizione fra i gruppi di esperti (conoscitori di prima mano dei fatti naturali) e i profani, cioè tutti gli altri che vivrebbero nell’ignoranza rispetto a questi fatti, o peggio ancora nel disorientamento in base a bias culturali da correggere – che quindi corrisponde a una distinzione di ceto, stabilito in base alla scolarizzazione e professionalizzazione del sapere. A questa antitesi si aggiunge la naturalizzazione di questi fatti, che porta anche a oscurare le domande (cioè l’opportunità o meno di una scoperta o un’invenzione, in base al gruppo che la richiede e le sue esigenze), gli strumenti, il lavoro, le numerose prove ed errori, e il finanziamento che li hanno generati e le conseguenze che ne derivano. E si perviene quindi alla etero-direzione della società da parte di «fatti che parlano da soli», capaci di imporre valori e fini alla collettività senza che la formazione del loro determinismo possa essere messa in discussione.

L’invenzione della natura e dei fatti come entità esterne alla società e al regno della cultura, o più precisamente dell’oggettività, in quanto referenza indipendente dalla sua opinabile realizzazione a partire da soggetti incarnati che la generano, si propone come termine ultimo e insindacabile per la risoluzione di tutte le controversie, scientifiche, economiche e politiche; da essa discende la predisposizione di acritiche “parole d’ordine” che favoriscono e allo stesso tempo deresponsabilizzano coloro che le pronunciano.

Dal determinismo scientifico e tecnologico a quello economico il passo è breve; dove la realizzazione del valore di un bene e la sua commercializzazione è conseguentemente effettuata prescindendo – o circoscrivendo – da tutta la sfera di elementi possibili che contribuiscono a realizzarlo. Come l’estrazione e trasformazione di “risorse” non-umane da un lato, ma anche e soprattutto dal lavoro negletto di cura e riproduzione della vita necessaria alla creazione dei beni, che è stato storicamente svolto dalle donne.

Prendiamo ad esempio la diffusione dell’etichetta «l’era dell’Intelligenza Artificiale», che sentiamo ripetere costantemente come un mantra da entusiasti tecnofili, per forzarci ad accettare come un fatto compiuto un programma simil-totalitario di politiche sociali e culturali, basato sul preteso successo di un prodotto che in realtà è ancora indefinito e limitato proprio perché basato su un software chiuso, quale appannaggio esclusivo delle poche imprese che lo sviluppano: si tratta di un piano che parte dal bisogno di giustificare la gestione accentrata delle enormi quantità di dati che queste raccolgono, mentre rimane sottaciuto l’importante impatto ecologico dei loro servizi e prodotti[2]. Tuttavia, il successo del software è notevolmente ridimensionato – e ridicolizzato – non solo perché non rappresenta un fatto compiuto dalle vesti immateriali, ma anche da quanto riportato da Oxfam, cioè che il lavoro di cura non retribuito svolto dalle donne di tutto il mondo, varrebbe almeno tre volte il valore dell’industria delle stesse big tech, così da aver provocatoriamente nominato il suo rapporto “l’era della cura”[3].

In questo senso, si vede come la natura come entità disponibile e appropriabile – perché considerata esterna ai condizionamenti della società, che infatti dovrebbe semplicemente limitarsi ad “allocare al meglio le risorse scarse” – si rifletta nell’oggettivazione della donna come “risorsa” gratuita, remissiva e liberamente sfruttabile. Così, la figura dello scienziato ricalca quella del capitalista nella loro estrazione di ricchezza che rimane irresponsabile nei confronti delle loro sorgenti di valore. Ovvero, gli attaccamenti ecologici generativi necessari per la vita.

La scienza maschile si basa così su una soggettività virtuale del ricercatore che, quasi non avesse avuto bisogno di nascere ed essere nutrito, esprime uno «sguardo da nessun luogo» su un universo concepito come res extensa da conquistare progressivamente e da cui estrarre profitto[4]. In maniera profondamente differente, i saperi situati femminili non hanno invece direzione prestabilita, ma sentono il bisogno di radicarsi nel rizoma dei legami terrestri da cui dipendono, e di favorire la loro prosperità.

In effetti, al contrario dei quei barbari che tentano di lasciare il pianeta, per andare a conquistarne altri, o degli altri che con atteggiamento disfattista si sentono inermi rispetto all’apocalisse, questi tipi di conoscenze tentano precisamente di «avere luogo» e di «riferirsi a qualcuno», coltivando l’arte di fare attenzione alle entità neglette che compartecipano alla nostra sfera di esistenza particolare e di cui ignoriamo l’importanza favorendo le condizioni per l’abitabilità. Basti pensare alle catastrofi ambientali che si fanno sempre più tragiche e impellenti, mostrando tutta la nostra incomprensione e incuranza delle connessioni ecologiche da cui dipendiamo che ne sono all’origine.

Riprendendo quindi per concludere un altro passaggio dell’autrice, che si tratti di saperi «altri» o non-umani, che definisce «pratici», a partire dal riferimento pragmatico a ciò che li rende tali, ovvero il lavoro attorno ad una causa che impegna a pensare e ad agire in comune,

«ciò che ho tentato di fare nel caso particolare della ricerca scientifica e della valutazione dei ricercatori, è di pensare a partire da ciò che manca, da ciò di cui la mancanza ci rende malati, così critici e lucidi quanto vogliamo, ma crucialmente incapaci di resistere a ciò che ci distrugge. Sapersi malati, è creare un senso del possibile – non sappiamo ciò che avrebbe potuto essere, ciò che potrà essere la strana avventura delle scienze moderne, ma sappiamo che «fare di più» di quello che abbiamo l’abitudine di fare non sarà sufficiente a permetterci di comprenderla. Si tratta di disimparare la rassegnazione più o meno cinica (realista) e di ridivenire sensibili a ciò che forse sappiamo, ma in modo anestetizzato. È qui che la parola lentezza, così come è utilizzata dai movimenti slow, risulta adeguata: la rapidità domanda e crea l’insensibilità a tutto ciò che potrebbe rallentare, alle frizioni, ai contrasti, alle esitazioni che fanno sentire che non siamo soli al mondo; rallentare è ridivenire capaci di apprendere, di fare conoscenza con, di riconoscere ciò che ci sostiene e ci fa prosperare, di pensare e di immaginare, e, nello stesso processo, di creare insieme ad altri dei rapporti che non siano di cattura; si tratta quindi di creare fra noi e insieme ad altri il tipo di rapporto che si conviene fra malati, che hanno bisogno gli uni degli altri al fine di riapprendere gli uni con gli altri, tramite gli altri, grazie agli altri, che domandano una vita degna di essere vissuta, dei saperi degni di essere coltivati» (Stengers I. (2013), Une autre science est possible! Manifeste pour un ralentissement des sciences, La Découverte, Paris, p. 82).

NOTE

[1] Cfr. La politica dopo l’emergere di Gaia, il migliore dei mondi possibili, Controversie, 12/03/2024

[2] Scrive così Francesco Cara su Altreconomia in un articolo del 28 maggio 2024: «esiste una percezione diffusa secondo la quale il digitale è virtuale e immateriale e quindi non produce impatti ambientali significativi in termini di sfruttamento delle risorse, inquinamento, emissioni climalteranti e rifiuti. Nel libro “Ecologia digitale” abbiamo mostrato come il digitale, inteso come sistema costituito da centri di calcolo, reti di trasmissione e dispositivi, sia in realtà altamente energivoro, emissivo e idrovoro; grande consumatore di metalli rari e allo stesso tempo grande produttore di rifiuti. Immersi nel mondo delle rappresentazioni digitali, si tende infatti a dimenticare che il livello simbolico del settore, dove qualunque testo, immagine, video, brano musicale viene tradotto in sequenze di stati binari: Off (0) e On (1), poggi su segnali elettrici che scorrono su circuiti elettronici. Per ricevere l’informazione, archiviarla, trattarla e trasmetterla, il sistema digitale necessita quindi di materiali con caratteristiche conduttive ed elettromagnetiche particolari, di microprocessori molto impattanti, e di una fornitura ininterrotta di elettricità. Inoltre, il flusso elettrico disperde calore che, nei centri di calcolo, viene gestito con l’ausilio di sistemi di raffreddamento che, a loro volta, richiedono materiali, lavorazioni, elettricità e acqua. E lo stesso discorso vale per le reti di trasmissione dati». Disponibile al link: https://altreconomia.it/lecologia-digitale-alla-prova-dellintelligenza-artificiale-generativa/

[3] Cfr. Oxfam (2020), Time to Care: Unpaid and underpaid care work and the global inequality crisis. Disponibile al link: https://oxfam.dk/documents/analyser/davos/rapport_time-to-care-inequality-200120-embargo-en.pdf

[4] Cfr. Clarke A., Haraway D. (2022), Making Kin. Fare parentele, non popolazioni, DeriveApprodi, Roma

Deskilling e Diverse Skilling - La trasformazione delle competenze nell'era digitale

L'innovazione tecnologica ha rivoluzionato il nostro modo di vivere e lavorare, delegando molte attività a strumenti digitali. L'adozione di queste tecnologie genera due importanti dinamiche che impattano le competenze umane: il fenomeno del deskilling e quello del diverse skilling.

Da un lato, il deskilling indica la perdita di competenze necessarie a svolgere un'azione, che viene – invece - affidata a una macchina. Dall'altro lato, il diverse skilling sottolinea la trasformazione delle competenze del fare in quelle dell'uso e della gestione della macchina che fa.

IL FENOMENO DEL DESKILLING

Il termine deskilling indica la progressiva perdita delle competenze necessarie a svolgere un'attività specifica, fenomeno che si verifica quando un'azione che era abitualmente eseguita da una persona umana viene completamente delegata a uno strumento tecnico o tecnologico. In particolare, nel corso di questo XXI secolo, si tratta di strumenti di automazione digitali.

Un esempio emblematico è quello della calcolatrice: l'introduzione di questo strumento ha ridotto la necessità di eseguire calcoli complessi manualmente. Analogamente, i sistemi di navigazione satellitare hanno reso quasi superflua la capacità di leggere mappe o orientarsi con elementi naturali.

In ambito lavorativo, il deskilling è maggiormente evidente nei settori industriali oggetto di processi di progressiva automazione, settori in cui operai - che un tempo padroneggiavano procedure complesse - ora supervisionano processi gestiti da robot; oppure nei settori dei servizi, in cui numerose attività svolte tradizionalmente da umani – come, ad esempio, l’assistenza ai clienti – iniziano ad essere gestite da bot[1], sistemi automatici digitali che trovano spesso applicazione nelle chat o nei numeri telefonici di assistenza ai clienti: trascrivono e interpretano il linguaggio naturale parlato o scritto, estraggono i riferimenti delle richieste e provano (spesso senza successo, va detto) a dare delle risposte.

Questo fenomeno ha conseguenze significative sia sui processi che sui lavoratori . Da un lato, possono aumentare l'efficienza e ridurre gli errori; dall'altro, portano – sicuramente - ad una progressiva dipendenza dagli strumenti utilizzati e all’oblio delle competenze che permettono ad un umano di fare quel lavoro.

La perdita di competenze pratiche, quelle del fare può avere effetti devastanti: dal punto di vista industriale, infatti,