Ripensare le Scienze - Perché "Controversie"?

L'intento alla base di Controversie è di ripensare le Scienze e le Tecnologie. Infatti, questa rivista è nata appunto per riesaminare – o rinegoziare – l’idea che considera le scienze come portatrici di verità assolute e oggettive, nonché distanti dalle influenze umane, come se abitassero dunque in una sorta di moderno pantheon laico. Questa visione, di stampo positivista e scientista, vuole esaltare l’impresa scientifica ma spesso non comprende che la banalizza e, in aggiunta, la mette su una sorta di piedistallo epistemologico; così facendo, le scienze vengono isolate da altre – fondamentali – attività umane con le quali devono necessariamente dialogare come, per esempio, arte, filosofia, linguistica, sociologia o storia. Tale isolamento può quindi portare a gravi errori di valutazione, su più livelli.

Inoltre, il termine scienza (al singolare) allontana da una presa di posizione consapevole della disciplina stessa. Infatti, scienza, se espressa al singolare, rappresenta un termine ombrello che raccoglie al suo interno elementi molto diversi [1], i quali trattano oggetti di studio differenti come, per esempio, l'astronomia e la zoologia, oppure l'ingegneria e la microbiologia. Se mettiamo tutte queste discipline "sotto lo stesso tetto", quindi, ne annulliamo le differenze e relative specificità.

Scopo di Controversie è dunque di ripensare concezioni limitanti e banalizzanti delle scienze e delle tecnologie, far riflettere sul fatto che esse possono dialogare in modo proficuo con altre importanti imprese umane e, di conseguenza, far capire che tutte queste discipline sono immerse in una bellissima rete e non, invece, in categorie separate le une dalle altre. Mostrare le controversie, gli errori, i non sequitur nello sviluppo delle scienze può aiutare in questo intento. Così facendo, si possono anche percepire le peculiarità e le bellezze insite nell'impresa scientifica stessa.

In conclusione, quando parliamo di scienze è necessario considerare più elementi possibili – una pluralità di voci – perché tutte queste componenti possono (e devono) lavorare insieme, in quanto nessuna di esse vive isolata e in un mondo a parte.

Ciò che si ottiene è una visione delle scienze (e delle tecnologie) più aperta, ampia e completa.

NOTE

[1] Possiamo fare un ragionamento simile anche con i termini animale o femminismo.

Scienza ed arte - Per una rinnovata sinergia

Oggi, il rapporto tra arte e scienza è oscurato e perduto. L’han detto e scritto in molti: Feyerabend e Thomas (1989), Greco (2013), Odifreddi (2023), solo per citare che pochi autori. Un tema enorme, su cui un post può solo abbozzare alcune considerazioni.

Nel 1929, Norbert Wiener, il matematico che sarebbe poi diventato noto come il padre della cibernetica, affermava che la scienza dei numeri è, in senso stretto, un'arte. Secondo Wiener, la matematica poteva (e doveva) essere considerata parte integrante della storia dell'arte (Odifreddi 2023).

Sul rapporto benefico tra arte e scienza ci sono moltissimi esempi, dalla storiografia alla musica, dall'architettura e alla fisica e alle neuroscienze. Eppure, l’età scientista in cui stiamo vivendo tende a trascurarlo o a nasconderlo. Questa visione scientista è stata contrastata dalla controversia scatenata dallo scrittore e fisico inglese Charles Percy Snow, con il suo libro Le Due Culture e la rivoluzione scientifica (1959). Con esso Snow denunciava la crescente frattura tra la cultura scientifica e quella umanistica. La sua accusa risuonò con forza tra molti intellettuali, poiché questa separazione era estranea a figure come Dante, Galileo, Empedocle, Leonardo, Cartesio, Goethe, Einstein, gli anonimi architetti delle cattedrali gotiche e Michelangelo. Ancora oggi, questa divisione è sconosciuta ad artigiani esperti e fisici che affrontano i misteri dell'ignoto (cfr. Greco 2013).

Per mostrare concretamente l’utilità di questa sinergia, farò tre esempi.

SINERGIE TRA ARTE E MEDICINA

Non è sempre facile stabilire quando alcune malattie sono sorte per la prima volta. A tal fine i romanzi ci ha fornito informazioni importanti relativamente alla peste, il colera, il vaiolo etc. che si sono manifestati nel corso dei secoli. La pittura è un’altra fonte inesauribile. Infatti, nei personaggi ritratti nei quadri si possono ritrovare i segni di una malattia: la sindrome di Mondor nella Betsabea di Rembrandt (1654); l’esadattilismo nell’Uomo vitruviano di Leonardo (1490), nella Madonna di Casa Santi (1498) e nella Madonna Sistina (1513-14) di Raffaello; la neurofibromatosi di tipo I ne La Camera degli Sposi di Mantegna (1465-1474); l’ipertricosi nel Petrus Gonsalvus di un anonimo pittore tedesco (1580 circa); il tumore al seno nella scultura La notte di Michelangelo (1534). E così via per molte altre malattie come la tubercolosi, l’herpes zoster, la depigmentazione cutanea, il rinofima, l’artrite etc.

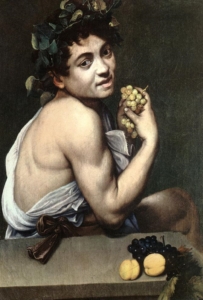

Un caso esemplare è il Bacchino malato di Caravaggio (1593), affetto dal morbo di Addison, dal nome del medico britannico che per primo lo descrisse. Ma solo nel 1855, ben 250 anni più tardi!

Bacchino malato, Caravaggio (1593)

Bacchino malato, Caravaggio (1593)

Come ha scritto il chirurgo vascolare italiano Paolo Zamboni, nelle pagine del Journal of Thrombosis and Haemostasis (28 April 2020), il modello è pallido, con riflessi scuri in alcune aree della cute; forse ha anche dolori addominali, come fa pensare la posizione curva in avanti; si sta cibando di uva come se avesse bisogno di zuccheri a causa di una possibile ipoglicemia. Inoltre, l’angolo interno dell’occhio, poco irrorato, depone per un’anemia. Il pollice scuro e l’unghia nerastra e opaca (anziché entrambi rosei) rivelano una acantosi nigricans (una condizione in cui la pelle si presenta iperpigmentata, ispessita, vellutata e di colore più scuro rispetto alle zone circostanti).

LETTERATURA E TECNOLOGIA: QUANDO FANTASIA E SCIENZA SI FONDONO

Jules Verne (1828-1905) è considerato, uno dei padri nobili della fantascienza moderna o, come veniva definita all’epoca, “narrativa d’anticipazione”. Guidato da una forte passione per la tecnologia, con i suoi racconti ambientati nell’aria, nello spazio, nel sottosuolo e nel fondo dei mari ha ispirato molti scienziati delle epoche successive.

Nel romanzo Dalla Terra alla Luna (1865), Verne descrive un viaggio a bordo di un proiettile sparato da un gigantesco cannone e uno sbarco sulla Luna. All’epoca questa idea fu contestata da molti scienziati ma, dopo tutto, si trattava di un romanzo d’avventura e di fantascienza. Un po' più tardi fu pubblicato Intorno alla Luna (1869); questo romanzo va oltre il viaggio e segue le avventure degli eroi sulla Luna.

In Ventimila leghe sotto i mari (1869-1870), Verne immagina un grande sottomarino elettrico, il Nautilus. E il Nautilus non vi ricorda forse il DSV Alvin varato nel 1964? Il Nautilus, come il DSV Alvin, era una propulsione esclusivamente elettrica. Infatti, Verne rifiutò il carbone come combustibile, proponendo invece batterie elettriche (di una composizione chimica sconosciuta) per azionare il congegno. Ciò rende Verne un precursore dei carburanti alternativi. Nello stesso libro scrive di una pistola che dà una forte scossa elettrica, molto simile all'attuale taser.

Gli studi per creare macchine volanti risalgono agli schizzi di Leonardo da Vinci, ma fu verso la fine dell'Ottocento che l'elicottero, come lo conosciamo, cominciò a prendere forma. Nello stesso periodo, Jules Verne pubblicò Robur il conquistatore (1886), un romanzo in cui il personaggio principale costruiva un velivolo di truciolato (quindi aveva grande resistenza e leggerezza allo stesso tempo) che volava tramite rotori, proprio come fanno gli elicotteri moderni. Rotori aggiuntivi a prua e a poppa servivano a spingere il velivolo verso il cielo. Verne prese i prototipi di elicottero esistenti e immaginato come si sarebbero sviluppati.

In un breve racconto scritto nel 1889, La giornata di un giornalista americano nel 2889, Verne descrive un'alternativa ai giornali: “ogni mattina, invece di essere stampato come nell'antichità, l'Earth Herald viene 'parlato'. È attraverso una vivace conversazione con un giornalista, un personaggio politico o uno scienziato che gli abbonati possono apprendere tutto ciò che capita di interessarli”. Ci vollero molto meno dei mille anni previsti da Verne per avere i primi giornali radio (negli anni Venti) e poi i primi telegiornali (negli anni Quaranta).

Jules Verne era ben lungi dall’essere uno scienziato, ma le sue opere e i progressi che si stavano realizzando all’epoca servirono a introdurre molte delle invenzioni che sarebbero arrivate successivamente e che, nel tempo, sono finite per diventare elementi ordinari della nostra vita quotidiana. Si può quindi sostenere che la letteratura ha fornito la vision alla scienza e tecnologia.

ARTE, SCIENZA E AMBIENTE

La nefologia è una branca della meteorologia che studia le nuvole (dal greco nephos che significa appunto nube, nuvola). Gli cloudspotters (osservatori di nuvole) classificano accuratamente le nuvole una a una, dando loro un’identità (con tanto di descrizione) e seguendo uno schema simile a quello degli organismi viventi, basato su aspetto e altitudine. Si contano 10 gruppi principali o generi (stratus, cumulus, stracumulus, nimbostratus, cumulonimbus, altocumulus, altostratus, cirrostratus, cirrocumulus e cirrus), che a loro volta si suddividono in specie e varietà.

Moltissimi pittori come John Constable, Joseph Mallord, Caspar David Friedrich, Gustave Courbet si sono cimentati all'interno delle loro opere nella raffigurazione delle nuvole. Il primo fra tutti fu Andrea Mantegna.

Il greco Christos Zerefos, specialista in scienze atmosferiche, sostiene che attraverso l'analisi dei colori (soprattutto le quantità di rosso e di verde) dei cieli delle pitture dei paesaggisti si può calcolare lo spessore ottico dell'atmosfera, cioè la quantità di aerosol presente nell'atmosfera al momento in cui la tela è stata dipinta. Conoscere la qualità dell'aria prima della rivoluzione industriale permette di comprendere l'impatto delle attività umane sull'inquinamento. Zeferos si è concentrato, in particolare, sul pittore e incisore inglese William Turner. I pigmenti rossi e verdi che hanno colorato i cieli dei suoi dipinti sono la prima testimonianza dei livelli di inquinamento dell'aria di un paio di secoli fa. All'epoca si sapeva poco e niente circa l'inquinamento e, anzi, nessuno scienziato fino al 1829 si preoccupò di tracciare le polveri nocive che fluttuavano nel cielo. Ai tempi di Turner le fabbriche (con i loro fumi) si moltiplicavano, le locomotive a vapore si diffondevano velocemente, i vulcani continuavano ad esplodere ― come nel caso dell'indonesiano Tambora, che nel 1815 scagliò 36 miglia cubiche di roccia frantumata nell'atmosfera ed ebbe ripercussioni sull'intero pianeta poiché le ceneri fecero più volte il giro della terra trasformando l’anno successivo (il 1816) “nell'anno senza estate”. I ricercatori hanno infatti osservato che i cieli dipinti negli anni successivi alle eruzioni vulcaniche contenevano una maggiore dose di rosso. Dura doverlo ammettere, ma, spesso, i tramonti dai colori bellissimi quanto curiosi che vediamo nei dipinti di Turner - un po' rossi, un po' arancioni - sono il frutto dell’inquinamento…

RIFERIMENTI BIBLIOGRAFICI

Feyerabend, Paul K. e Christian Thomas (1989), Arte e scienza, Roma: Armando.

Greco Pietro (2013) (a cura di) Armonicamente. Arte e scienza a confronto, Milano: Mimesis

Odifreddi, Piergiorgio (2023), Arte e matematica, due visioni complementari per descrivere la realtà, in “Le Scienze”, 18 agosto,

Snow, Charles P. (1959), trad. it. Le due culture, Milano: Feltrinelli, 2017.

Scienza maggioritaria e scienza minoritaria

La maggior parte degli scienziati delinea un confine tra scienza e pseudo-scienza, tra teorie ufficiali e teorie eterodosse, senza esaminare approfonditamente ciò che le teorie marginali hanno da dire e senza valutare se possono essere un elemento di arricchimento per la ricerca. Vi è quindi, spesso, un rifiuto “a prescindere”, come diceva Totò. Al contrario, noi proponiamo di oltrepassare questo confine a favore di un modello di classificazione più aperto e permeabile.

Nelle scorse settimane, a proposito dei premi Nobel, un nostro Autore – parlando del “principio di autorità” nella comunicazione scientifica - ha scritto che «alcuni eccellenti scienziati, dopo aver ricevuto il premio, abbiano iniziato a sostenere posizioni discutibili dal punto di vista della fondatezza e – spesso – poco attinenti con il loro campo di studi». A tal fine ha citato alcuni casi – Kary Mullis, Luc Montagnier e Linus Pauling – in cui i premiati hanno abbracciato posizioni considerate poco ortodosse e – sicuramente – ancor meno condivise dalla comunità scientifica, fino a diventare emblemi dello pseudo-scientifico e dell’anti-scientifico.

È effettivamente difficile negare che, sull’onda della celebrità conferita dal premio Nobel, i media di massa e divulgativi chiedono ai premiati di commentare e di esprimere opinioni su qualunque evento e problema, e che i premiati difficilmente si negano: Carlo Rubbia, che abbiamo ascoltato alla radio, visto in televisione e letto su tutti i giornali su argomenti di tipo diverso, dice di essere trattato come un oracolo; Kary Mullis scrive che il premio ha messo lui e la sua tavola da surf sulle copertine di tutto il mondo[1].

È, invece, opportuno fare qualche breve e semplice considerazione sul tema delle cosiddette teorie pseudo o anti-scientifiche e di come queste sono viste dalla comunità scientifica e dal pubblico di massa. Con le relative ambiguità, dubbi interpretativi e influenze sociali.

Contrariamente a quanto ci possiamo aspettare, si possono spesso trovare delle specularità e affinità tra

- le posizioni di chi crede in teorie considerate - dalla scienza ufficiale e dalla narrazione mediatica - pseudo-scientifiche, scientificamente confutate o non verificate,

- e quelle di alcuni scienziati autorevoli che osteggiano le teorie marginali ed emergenti.

PRIMA POSIZIONE: CREDENTI NELLE TEORIE ETERODOSSE

Seguendo il senso comune, sembra accettabile pensare che alcune persone continuino a credere in teorie scientifiche di cui si dice che sono state confutate o che non sono state verificate per almeno una di queste ragioni: la mancanza di alfabetizzazione scientifica o la scarsa capacità di pensiero critico che fanno percepire come familiari teorie ormai superate; la ricerca di conferma delle proprie posizioni che porta a ignorare le evoluzioni scientifiche più recenti e teorie diverse dalla proprie; l’attaccamento emotivo, per ragioni religiosi, politici o di vissuto personale, che fanno rifiutare e contrastare le prove che sfidano la loro visione del mondo; la diffidenza verso l’establishment scientifico, considerato corrotto, di parte o conservatore; la disinformazione diffusa – ad esempio attraverso i social media – che mette in dubbio le teorie valide ed accreditate; in ultimo, la malafede: la volontà di sostenere una teoria difficilmente sostenibile per interesse, o per non dover affrontare il confronto con la realtà.

SECONDA POSIZIONE: SCIENZIATI AUTOREVOLI E TEORIE MARGINALI

Tuttavia, ci sono casi in cui anche scienziati quotati, accreditati e considerati affidabili si comportano esattamente come chi crede nelle teorie chiamate pseudo-scientifiche: con attaccamento emotivo; per non mettere in dubbio la teoria mainstream; per interesse, legato alla propria posizione all’interno della comunità scientifica, se le teorie offstream la possono scalfire; per eccesso di familiarità delle teorie dominanti la cui forma paradigmatica è particolarmente rassicurante; raramente, ma non mancano i casi, per malafede, se le teorie altre possono evidenziare errori nelle proprie posizioni.

Tra le vittime di questi casi possiamo ricordare:

- il dottor Semelweiss, nel XIX secolo, i cui colleghi che rifiutarono la teoria della sepsi come causa della morte puerperale per ragioni emotive, che riguardavano il presunto decoro dei medici – perché lavarsi le mani? non siamo puliti? – e per ragioni di interesse, cambiare spesso le lenzuola comportava spese onerose

- Kary Mullis, premio Nobel per la Chimica nel 1993, che ha messo in dubbio il nesso causale tra il virus HIV e la Sindrome da immunodeficienza acquisita, l’AIDS: l’ipotesi offstream di Mullis oggi è rifiutata.

- Peter Duesberg, citologo e biologo molecolare statunitense, che propone una combinazione di concause come fattori scatenanti la malattia, ipotesi anch’essa marginalizzata.

citare Robert Gallo, che nel 1984 non dice nulla sul nesso causale tra HIV e AIDS, nel 1993 sostiene – sulla base degli stessi esperimenti e studi – che «questa specie di virus [il HIV] è la causa dell'Aids» e attribuisce la prova inconfutabile di questo nesso a sé e al proprio Team; e più avanti nel tempo, quando gli chiedono quale sia la prova definitiva che l’HIV è LA causa dell’AIDS si rifiuta di rispondere (L. Rossi, Sex virus, Milano, Feltrinelli, 1999, p. 319) ed è uno degli autori della marginalizzazione delle teorie alternative di Mullis e di Duesberg.

È possibile che la posizione della comunità scientifica e, ad esempio, di Gallo che marginalizzano il punto di vista di Mullis e di Duesberg – oltre che tutte le altre ipotesi alternative sulle cause dell’AIDS – siano influenzate da attaccamento emotivo o da questioni di interesse legate alle montagne di finanziamenti che sostengono quel ramo della ricerca sull’AIDS? O, forse, anche dalla consapevolezza, come sostengono alcuni autori come V. Turner e Zolla Pazner, che i test di isolamento del virus potrebbero essere stati sbagliati o interpretati convenientemente per confermare la teoria? E che nei lavori di Gallo e del suo team c'erano «differenze tra quanto venne descritto e quanto venne fatto»? Che Gallo «come capo di laboratorio creò e favorì condizioni che diedero origine a dati falsi/inventati e a relazioni falsificate»[2]?

D’altra parte, è significativo che il nesso tra HIV e AIDS sia ancora oggi oggetto di una controversia tra teorie mainstream e teorie alternative – per forza di cose offstream – di cui si trova una traccia ampia e diffusa in un articolo pubblicato nel 2014 dal PMC – Pub Med Central del U.S. National Institute of Health - Questioning the HIV-AIDS Hypothesis: 30 Years of Dissent, di Patricia Goodson. Articolo che appare equidistante e con approccio storiografico, poi fatto ritirare perché considerato «di parte» e «a supporto delle fringe theories on HIV-AIDS».[3]

CONCLUSIONE E PROPOSTA DI UNA CLASSIFICAZIONE ALTERNATIVA

Sembra evidente che ci siano scienziati e comunità scientifiche che non hanno desiderio di mettersi in discussione e di dialogare con scienziati latori di teorie alternative, non allineate con il flusso della scienza mainstream.

Scienziati e comunità che cadono nel “riflesso di Semmelweis”[4] e che impoveriscono la ricerca con un atteggiamento poco aperto e tollerante verso ipotesi o teorie alternative.

Forse, per contribuire a questo dialogo sarebbe opportuno rinunciare a disegnare un confine – che ormai sappiamo essere labile, illusorio, socialmente determinato, storicamente variabile – tra scienza e pseudo-scienza, tra scienza ufficiale e anti-scienza, adottando una classificazione più permeabile di teorie maggioritarie – che godono del seguito di una parte più rilevante della comunità scientifica – e teorie minoritarie, che – seguite da meno o da pochi - si occupano di minare le certezze a volte non così solide delle teorie maggioritarie.

NOTE

[1] Cfr, ad esempio, lo studio di Lorenzo Beltrame Ipse dixit: i premi Nobel come argomento di autorità nella comunicazione pubblica della scienza, in Studi di Sociologia, 45:1 (Gennaio-Marzo 2007).

[2] Cfr.: Franchi F., Marrone P., Sex virus? Implicazioni etiche e politiche della ricerca sull’Aids, https://www.openstarts.units.it/handle/10077/5546, che citano i risultati della commissione governativa statunitense nominata dall'OSI, Office of Scientific Integrity dell'NIH sulle presunte irregolarità negli studi del laboratorio di R. Gallo

[3] Cfr.: https://pmc.ncbi.nlm.nih.gov/articles/PMC4172096/ e https://pmc.ncbi.nlm.nih.gov/articles/PMC6830318/

[4] Riluttanza o resistenza ad accettare una scoperta in campo scientifico o medico che contraddica norme, credenze o paradigmi stabiliti. Un fenomeno a cui, dagli anni Cinquanta in poi, molti filosofi, storici e sociologi della scienza hanno dedicato molta attenzione. Cfr. Gobo G., Quando lavarsi le mani era considerato anti-scientifico, Controversie 31/10/2023

Individuare il sesso, una storia infinita

Dopo aver notato che nella cosiddetta “natura” l’ermafroditismo e la transizione sessuale all’interno di un medesimo attante sono delle possibilità e che nell’antichità l’ermafroditismo non era considerato un errore di natura, vediamo ora come i criteri di individuazione sessuale (contrariamente a ciò che comunemente si pensa) siano cambiati nel corso del tempo, e più volte (almeno 5 – cfr. Montanari 2018).

1. IL FENOTIPO

Per secoli la determinazione del sesso (riconoscimento e assegnazione), e poi del genere, fu basata sul fenotipo, ovvero sui caratteri morfologici/fisici empiricamente accertabili come la barba, la distribuzione del grasso corporeo, il pomo d’Adamo, le ghiandole mammarie, ecc. Tuttavia, a parte (forse) il pomo d’Adamo, questi caratteri non sono sempre presenti in un uomo. Infatti, esistono persone glabre, con massa corporea che può essere simile a una donna ecc. Lo si nota sui mezzi pubblici o per strada, quando a volte (osservando alcune persone) non siamo certi delle nostre classificazioni.

2. I GENITALI

Successivamente si passò a inserire nel fenotipo anche caratteristiche fisiche meno visibili, come ad esempio i genitali. Tuttavia, siccome nella vita quotidiana i genitali sono quasi sempre coperti e nascosti, l’attribuzione del sesso diviene un ragionamento probabilistico, perché la prova mediante ispezione quasi sempre (e per fortuna) non ci è permessa. Inoltre, spesso non sappiamo qual è lo standard di un genitale per essere considerato tale. E nemmeno che forma hanno i genitali de* altr*, neanche de* nostr* più car* amic* se non abbiamo avuto con loro una relazione intima oppure non abbiamo praticato qualche sport collettivo che prevedeva il rituale delle docce (di adolescenziale memoria, per chi scrive).

Perciò si può anche parlare di genitali sociali, ovvero la forma di genitali che presumiamo che una persona abbia in base alla sua apparenza, ossia al suo genere sociale.

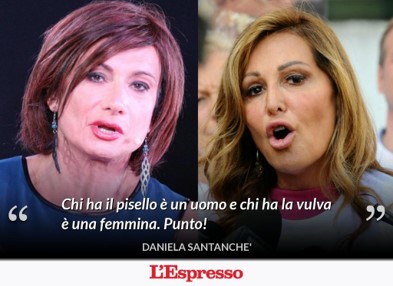

Ma anche con i genitali le cose non sono così semplici come invece pensava l’onorevole Daniela Santanché, che in almeno un paio di occasioni (27 gennaio e 11 marzo 2019) ebbe a dire:

Con la replica di un’altra onorevole, Vladimir Luxuria, che prontamente rispose: «Non mi parli di natura proprio lei, che ha fatto molti più interventi chirurgici di me per motivi estetici. Sei più trans di me, Dany». Invocare la natura - l’abbiamo già visto in La costruzione di un’identità (Prima parte) - è sempre una pericolosa arma a doppio taglio…

Con la replica di un’altra onorevole, Vladimir Luxuria, che prontamente rispose: «Non mi parli di natura proprio lei, che ha fatto molti più interventi chirurgici di me per motivi estetici. Sei più trans di me, Dany». Invocare la natura - l’abbiamo già visto in La costruzione di un’identità (Prima parte) - è sempre una pericolosa arma a doppio taglio…

Peraltro, l’apparato genitale è costituito sia da organi esterni (o visibili), ma anche organi interni (non visibili). Nel fenotipo maschile più comune, il pene e lo scroto formano gli organi esterni. La prostata, l’uretra, i testicoli, le vescicole seminali, le vie spermatiche (dotti eiaculatori) e il dotto deferente sono invece interne/non visibili. Nel fenotipo femminile più comune gli organi esterni/visibili sono il monte di Venere, il clitoride, le grandi labbra e le piccole labbra. Quelli interni/non visibili sono la vagina, l’utero, le tube o trombe di Falloppio, l’endometrio, la cervice e le ovaie.

Per dare un’idea di quante fusioni ci possano essere tra gli organi, ora sappiamo che il clitoride e il pene si sviluppano della stessa materia, anche se hanno diversi ruoli nella riproduzione e la vita sessuale. Oppure che nell’antichità si credeva che la vagina fosse un pene introflesso (ripiegato verso l'interno), un po’ simile a un capezzolo introflesso.

Purtroppo, la forma e grandezza del genitale esterno è ancora tra i fattori primari nell’assegnazione del sesso… alla nascita.

Purtroppo, la forma e grandezza del genitale esterno è ancora tra i fattori primari nell’assegnazione del sesso… alla nascita.

Tuttavia, ci chiediamo: in un neonato, quanti cm deve avere una protuberanza per essere considerata un pene oppure una clitoride?

Quando parliamo di genitali cosiddetti “ambigui” intendiamo una variazione di grandezza e forma proprio tra quello che consideriamo la clitoride e il pene. Anche perché essi sono (esternamente) molto simili:

3. LE GONADI

Tuttavia i due precedenti criteri risultarono ancora non sufficienti e si passò a un terzo criterio: le gonadi.

Infatti, nel 1876, il patologo tedesco E. Klebs inventò un nuovo sistema di classificazione basato sulla struttura delle gonadi (dal greco gone seme e aden ghiandola) organi anatomici che producono i gameti, ovvero le cellule riproduttive). Le gonadi femminili sono le ovaie (organi interni, situate nella pelvi) e producono gli ovociti. Quelle maschili sono i testicoli (organi interni, nello scroto) e producono gli spermatozoi. Come si può vedere, si procede sempre più verso l’interno e quindi sempre più verso il meno visibile.

Secondo questa classificazione, un individuo (uomo o donna che fosse) con i testicoli era indubitabilmente un uomo, non importa quali mascheramenti potessero avvenire a livello fenotipico; specularmente un individuo con le ovaie era indubitabilmente una donna.

Dregen (1998) sostiene che la scoperta delle gonadi sessuali soppiantò il criterio di valutazione in base ai genitali esterni per la determinazione sessuale, fino a diventare l’unico attributo/metro per dirci a quale sesso si appartiene. Le cose piccole e nascoste (come le ghiandole) soppiantarono, quindi, le cose grandi e visibili. Il pene e la vagina non contavano più (qualcuno lo dica all’onorevole)…

Tuttavia, nell’embrione (che per molte persone è già un essere umano) le gonadi si sviluppano partendo da una gonade indifferente, cioè un organo che ha la potenzialità di diventare sia testicolo che ovaio. La differenziazione avviene solo… al 2º mese di gravidanza.

Infine, le gonadi sono anche il maggiore produttore di 3 ormoni sessuali nel corpo: estrogeni, progestinici e androgeni.

Ma perché concentrarsi sulle gonadi (l’apparato genitale interno)?

Probabilmente perché sono organi riproduttivi e l’ideologia del tempo assegnava alla riproduzione il valore più alto. Tuttavia, anche questa classificazione scricchiolava. Infatti, una persona può: avere gli organi riproduttivi e decidere di non utilizzarli; non averli; o averli di un genere diverso rispetto al proprio corredo cromosomico… senza che questo impatti sulla propria identità di genere. Ad es. uno potrebbe dire “gli uomini non hanno l’endometrio: ecco la differenza tra maschi e femmine”!

Risposta: certo. Ma questa è solo in una prospettiva riproduttiva. Se a una donna tolgono l’endometrio, oppure subisce un’isterectomia totale (asportazione dell’utero intero e le strutture circostanti cervice, ovaie, tube di Falloppio ecc.) o parziale non è più una donna?

4. I CROMOSOMI: IL GENOTIPO (O DNA)

Per ovviare la debolezza della classificazione gonadica, si passò allora (la faccio breve) ai cromosomi, che sono strutture all'interno del nucleo delle cellule. Essi contengono i geni di una persona.

Il cromosoma contiene da centinaia a migliaia di geni. Ogni cellula umana normale contiene 23 coppie di cromosomi, per un totale di 46 cromosomi (23 del padre e 23 della madre), ovvero 22 coppie di autosomi (presenti in entrambi i sessi) e una (!!!) di eterosomi cosiddetti sessuali: XX per il sesso femminile e XY per il sesso maschile.

Dall’epoca della “scoperta” scientifica dei cromosomi sessuali (prima metà del ‘900), le coppie cromosomiche XY e XX sono state rapidamente adottate come indicatori canonici del sesso biologico, mediante il cariotipo (o patrimonio o mappa cromosomica): se un individuo ha 1 cariotipo XY + i testicoli è un uomo; se possiede 1 cariotipo XX + le ovaie è una donna.

Cioè l’UNICO cariotipo diverso tra uomini e donne… sarà dirimente, e andrà a fare la differenza!!! E si chiamerà cariotipo femminile 46 XX e il cariotipo maschile 46XY.

In altre parole, la minoranza (1 sola delle 23 coppie di cromosomi) ha vinto sulla maggioranza!

In politica questo creerebbe qualche problema…

4.1. PROBLEMI CON I CROMOSOMI

Questa distinzione però non regge il confronto con la fenomenicità del reale. Se la concezione ordinaria dell’anatomia e fisiologia umana immagina una concordanza tra i marcatori di genere chiaramente dimorfici (cromosomi, genitali, gonadi, ormoni), i biologi sanno che tale concordanza a volte non si manifesta. Come nel caso degli/lle intersessuali. E’ stato infatti riconosciuto che la differenziazione sessuale a livello biologico non agisce secondo una logica dicotomica e non produce solo due tipologie di corpi uniformi.

All’incirca una persona su 1000 sviluppa un corpo in cui NON tutti i componenti corrispondono al genere dei cromosomi di sesso e questo senza particolare complicazione in termini di salute fisica. Inoltre, la maggioranza degli/lle ermafrodit* con corredo cromosomico XX, ha materiale Y presente sui cromosomi X

in quantità sufficiente a produrre i tessuti di entrambi i sessi (cioè testicoli e ovaie). E ancora, ci sono anche ermafrodit* con presenza di cromosomi sessuali in parte maschili e in parte femminili nelle diverse cellule del corpo: 46,XX/46,XY oppure 46,XX/47,XXY. Alla base si trova uno “sbilanciamento” tra i geni che regolano lo sviluppo dell’ovaio piuttosto che del testicolo, molti dei quali sono stati identificati, mentre ne esistono altri probabilmente ancora non noti.

4.2. MARIA JOSÉ MARTÍNEZ-PATIÑO

In previsione delle Olimpiadi del 1988, all’atleta spagnola Maria José Martínez-Patiño il comitato olimpico aveva richiesto un test genetico, una procedura standard per verificare che non si presentassero in gara atleti uomini. Pur avendo un aspetto femminile convincente e una chiara identità di genere femminile, risultò tuttavia che Maria presentava un cariotipo XY maschile. In più non aveva né le ovaie né l’utero. Per i commissari lei era un uomo! La diagnosi fu di sindrome da insensibilità agli androgeni (AIS). Per cui fu esclusa dalla competizione e radiata dalla squadra olimpica spagnola. I commissari fecero prevalere l’autorità dei cromosomi sugli altri marcatori di genere. La sua, una vita completamente rovinata.

Oggi, però, il comitato Olimpico non utilizza più come criterio di controllo il test genetico (cfr. Fausto-Sterling 2000: 1-3). Magra consolazione per lei…

5. GLI ORMONI

Si passò così (la faccio nuovamente breve e lineare) agli ormoni. L’ormone (dal greco όρμάω “mettere in movimento”) è un messaggero chimico che trasmette segnali da una cellula o un tessuto a un’altra cellula o altro tessuto. Gli ormoni sono stati concepiti e poi scoperti a inizio ‘900.

Gli ormoni sessuali sono divisi in tre macro categorie:

- Androgeni, come il testosterone, prodotto in maggior parte dal gonadi e dalle ghiandole surrenali;

- Estrogeni, tra i più importanti c’è l’estradiolo;

- Progestìnici, tra i più noto il progesterone prodotto dalle gonadi.

Gli estrogeni ed androgeni sono ormoni presenti in tutt*, ma in quantità diverse nei maschi o nelle femmine. Gli estrogeni sono presenti in quantità superiori nelle donne, gli androgeni sono presenti maggiormente negli uomini. I progestinici (pro-gestazione), invece, sono ormoni sessuali femminili che stimolano la secrezione dell’endometrio, favorendo così le condizioni adatte alla fecondazione dell’uovo e al suo annidamento nella mucosa uterina.

Per cui, a parte i progestinici, non abbiamo ormoni specificatamente femminili o maschili…

E qui nascono ancora problemi classificatori…

5.1. CASTER SEMENYA

Caster Semenya è una mezzo-fondista. Nel 2009 a soli 18 anni fece molto parlare di sé, fino a diventare un caso internazionale, dopo aver vinto la medaglia d’oro negli 800 metri femminili ai Mondiali di atletica leggera di Berlino, distanziando la seconda classificata di oltre 2 secondi.

La vittoria però è stata subito messa in discussione a causa dei suoi tratti mascolini, uniti all’impressionante potenza con la quale ha demolito le sue rivali. Caster Semenya fu così accusata di essere un uomo. Dopo aver effettuato dei test di DNA (mai rivelati al pubblico per rispetto della sua privacy) è stata poi riammessa alle competizioni e, nel 2012, ha vinto la medaglia l’oro alle Olimpiadi di Londra (800 metri femminili).

Lei è affetta da iperandrogenismo: il suo corpo produce naturalmente una eccessiva quantità di ormoni androgeni, come il testosterone, rispetto alla media. La IAAF – l’Associazione Internazionale delle Federazioni di Atletica Leggera, oggi World Athletics – per tutelare ogni atleta e rendere le competizioni sportive il più possibile “ad armi pari”, nel 2011 ha imposto una regola che obbliga le donne con iperandrogenismo a sottoporsi a una terapia ormonale per abbassare la produzione di ormoni androgeni, che ritengono possano falsificare le competizioni sportive.

Con la Federazione sudafricana, Caster Semenya ha però fatto ricorso al TAS – il Tribunale arbitrale internazionale dello sport di Losanna. Il TAS ha respinto il ricorso dell’atleta sudafricana. Per cui l’atleta sudafricana non poté difendere il titolo mondiale ai Mondiali di Doha nel settembre 2019. L’atleta era stata esclusa da alcune competizioni sportive per essersi rifiutata di assumere farmaci che riducessero il suo alto livello di testosterone. Lei dice: "Alla fine, so di essere diversa. Non mi interessano i termini medici e quello che mi dicono. Essere nata senza utero o con testicoli interni. Non sono meno una donna. Queste sono le differenze con cui sono nata e le accetto. Non mi vergognerò perché sono diversa”.

L’11 luglio 2023, la Corte europea dei diritti dell’uomo (CEDU) di Strasburgo ha sentenziato che il TAS e la World Athletics hanno violato i diritti dell’atleta sudafricana Caster Semenya.

Tuttavia, la decisione di Strasburgo non invalida le regole dettate dalla IAAF e, quindi, non ha permesso a Semenya di poter gareggiare gli 800m (senza alcun trattamento sanitario) alle olimpiadi di Parigi 2024.

5.2. BARBRA BANDA

Barbra Banda è una calciatrice zambiana, a cui sono stati rilevati livelli di testosterone più alti del consentito dopo il suo exploit alle Olimpiadi 2020 (tenutesi nel 2021). Il testosterone porta un vantaggio in termini di prestazioni, rendendo gli atleti più veloci e più forti. Banda ha rifiutato una cura ormonale poiché temeva i potenziali effetti indesiderati. Alle Olimpiadi ha avuto ottime prestazioni ed è stata la prima donna a segnare due triplette in un torneo olimpico. L’attaccante dello Zambia è stata ritenuta da più parti un uomo. La Confederazione Africana di Calcio (CAF) non le ha permesso di giocare alla Coppa d’Africa del 2022. Il CAF ha regole molto più stringenti rispetto a quelle delle Olimpiadi. Invece, la massima istanza calcistica (la FIFA), si è pronunciata sul “caso Barbra Banda”, permettendo la sua partecipare ai Mondiali in Australia e Nuova Zelanda del 2023. E alle Olimpiadi di Parigi 2024 ha segnato un’altra tripletta (4 goal in totale). Insomma, nemmeno ricorrendo agli ormoni si riesce a risolvere la questione…

Comunque, non sarebbe il caso che CIO, FIFA, CAF, World Athletics e tutte le altre federazioni sportive utilizzassero gli stessi parametri per giudicare se un’atleta possa o meno gareggiare o giocare con le donne?

Ma soprattutto, è possibile trovare questi parametri?

Ne parliamo la prossima volta, trattando anche di Imane Khelif, la pugile algerina il cui caso tanto ha fatto discutere la scorsa estate.

RIFERIMENTI BIBLIOGRAFICI

Dreger, Alive (1998), Hermaphrodites and the medical invention of sex, Harvard University Press, Cambridge, Mass.

Fausto-Sterling, Anne (2000), Sexing the body: Gender politics and the construction of sexuality, New York: Basic Books.

Montanari, Enrico (2018), La permeazione felice. Stati intersessuali e nuove prospettive, Tesi di laura in Scienze Filosofiche, Università degli Studi di Milano.

Il mito della specie e della sua evoluzione

1. PARLARE DI SPECIE E DI EVOLUZIONE

I concetti di selezione, di evoluzione e di conservazione delle specie sono entrati, dalla formulazione che ne fece C. Darwin nel 1872[1], nel linguaggio corrente e scientifico ma, a volte, vengono usati in modo improprio, distorcendone il senso originale.

Una distorsione frequente dell’idea darwiniana è quella secondo selezione e evoluzione sono soggetti che agiscono con l’obiettivo di migliorare la specie per renderla più resistente ed adeguata al contesto in cui vive.

Ad esempio, Donald Hoffmann[2], stimato cognitivista americano, nel suo libro sulla percezione e sulla conoscenza della realtà, L’illusione della realtà – come l’evoluzione ci inganna sul mondo che vediamo (Bollati Boringhieri, 2020) sostiene noi e gli altri animali percepiamo la realtà in modo distorto, che vediamo[3] quello che ci conviene vedere per avere maggiori possibilità di sopravvivere e di riprodurci – di perpetuare la nostra specie.

È un punto di vista interessante dal lato filosofico e cognitivo e ripropone – in termini e linguaggio scientifici attuali – il concetto cartesiano di “grande illusione”[4], affinandolo e arricchendolo di esempi anche divertenti e appassionanti. È verosimile pensare che in alcune occasioni percepiamo[5] le cose in modo tale da metterci in guardia contro i pericoli, che ci orientiamo in modo immediato, senza ragionare, verso comportamenti che aumentano la nostra possibilità di sopravvivere, che ci nutriamo con alimenti che ci danno maggiore energia se dobbiamo fare sforzi o fatiche, e così via, che la nostra cognizione sia modulata in modo tale da garantire il massimo risultato.

Tuttavia, Hoffman suggerisce che - al centro di questa distorsione percettiva - sia proprio l’evoluzione[6] ad agire come soggetto, ad ingannarci per garantire la sopravvivenza del singolo individuo e la conservazione, la perpetuazione e il progressivo miglioramento della sua specie attraverso la riproduzione.

In questa visione la specie è un oggetto coerente, con confini ben definiti, in cui si ascrivono categorie di animali con caratteri omogenei, in cui questi animali si potrebbero riconoscere; e, l’evoluzione ha il carattere di soggetto, agisce con un fine, riconosce la specie, i suoi punti di forza e di debolezza, e ne orienta i meccanismi adattativi.

Questa concezione, ancora, si trova in alcuni schemi ecologisti e ambientalisti, in cui la specie è oggettivizzata ed elevata a valore da preservare, la natura è un soggetto che agisce, l’evoluzione, di nuovo, è un soggetto e ha un fine, quello di affinare e preservare le specie.[7]

2. DARWIN NON SAREBBE D’ACCORDO

Una prima sorpresa, per chi legge il trattato di C. Darwin sulla origine e selezione delle specie, è che - effettivamente - utilizza il termine specie e lo fa “come se” la specie fosse un unicum coerente e ben definito ma – nello stesso tempo – mette in guardia esplicitamente sul fatto che usa

«il termine di specie come applicato arbitrariamente, per ragioni di convenienza, a gruppi di individui molto somiglianti fra loro, e che esso non differisce sostanzialmente dal termine varietà, il quale è riferito a forme meno distinte e più variabili. Anche il termine di varietà, per quanto riguarda le semplici differenze individuali, è applicato arbitrariamente, per ragioni di convenienza.» (Darwin C., L’origine delle specie, 2019, Bollati Boringhieri)

Ancora più sorprendente può risultare che Darwin non intendesse affatto la “selezione naturale”, la “lotta per l’esistenza”, l’”evoluzione”, la “natura” come soggetti che agiscono ma – al contrario – come «azione combinata e risultato di numerose leggi[8]» (Cit., p. 154), e scrivesse che «nel senso letterale della parola, il termine selezione naturale è erroneo» (Cit., p. 154), lo ritenesse una espressione metaforica (cfr. ibidem):

«Si può dire, metaforicamente, che la selezione naturale sottoponga a scrutinio, giorno per giorno e ora per ora, le più lievi variazioni in tutto il mondo, scartando ciò che è cattivo, conservando e sommando tutto ciò che è buono» (Cit. p. 157).

Allo stesso modo, Darwin annota (cit. p. 154) che per alcuni «il termine selezione naturale implica una scelta cosciente da parte degli animali che vengono modificati», sottolinea il senso metaforico di questa espressione e – di fatto – anticipa una interpretazione che diventerà corrente, quella della personificazione delle forze selettive.

E quando (cit., p. 157), tratta metaforicamente la selezione come un soggetto,

«silenziosa e impercettibile essa lavora quando e ovunque se ne offra l'opportunità per perfezionare ogni essere vivente in relazione alle sue condizioni organiche e inorganiche di vita»,

evidenzia che il fenomeno selettivo riguarda il miglioramento delle capacità di sopravvivenza del singolo individuo nel contesto in cui vive.

In sintesi, appare chiaro che - nella accezione darwiniana originale – la specie non è né un soggetto né un oggetto coerente e ben delimitato, e che la selezione, l’evoluzione e la conservazione delle specie non sono soggetti che agiscono ma processi risultato di condizioni di vita e – in definitiva – di fenomeni guidati dal caso, dal contesto e senza finalismi

«si può dire che le condizioni di vita non soltanto causano la variabilità, o direttamente o indirettamente, ma altresì includono la selezione naturale, poiché le condizioni determinano se questa o quella varietà sopravviverà» (Cit., p. 203).

Il ruolo del caso nel processo evolutivo può essere reso in modo chiaro con questo esempio: tra due individui qualunque, quello più adatto all'ambiente in cui si trova – cioè, quello che ha sviluppato in modo maggiore, nel corso della sua breve vita, le competenze e capacità più efficaci per quell'ambiente - ha più probabilità dell’altro di vivere abbastanza a lungo; vivendo abbastanza a lungo ha anche più probabilità di avere rapporti sessuali con individui che hanno sviluppato altrettante caratteristiche adeguate all'ambiente, se, casualmente, ne incontra.

Come conseguenza di questa casualità di vita lunga e di occasioni di rapporti sessuali, questo individuo ha maggiore probabilità di riprodursi e i nuovi nati hanno (o, perlomeno, potrebbero avere) le stesse caratteristiche di adeguatezza all'ambiente dei genitori.

Allo stesso modo si può proporre una riflessione sulla presenza di organi sessuali complementari che, per chi pensa a meccanismi finalistici nella selezione, sono "dedicati" all'accoppiamento a fini riproduttivi: proviamo a fare un esperimento mentale collocato nella notte dei tempi, in cui ipotizziamo un gruppo di 40 individui della stessa varietà, di cui 10 senza organi sessuali, 10 con organi sessuali senza capacità riproduttiva, 10 con organi sessuali con capacità riproduttiva e forma complementare e 10 con organi sessuali con capacità riproduttiva ma con forma non complementare, dopo qualche anno che tipo di individui ritroviamo? Certamente quelli che – casualmente – sono nati con organi sessuali complementari e che – sempre casualmente – si sono incontrati.

In estrema sintesi: in un ampio gruppo di individui diversi, quelli che sono, casualmente, più adeguati al contesto hanno più opportunità di vivere a lungo e riprodursi. La generazione successiva vedrà più individui con quelle caratteristiche di adeguatezza e meno di quelli meno adeguati. E, dopo alcune generazioni, troveremo solo individui del tipo "più adeguato".[9]

3. LA SELEZIONE NON È TELEOLOGICA E LA SPECIE NON ESISTE

Quando parliamo di selezione, di evoluzione e di conservazione delle specie è opportuno ricordare che questi concetti sono esenti da personificazione e da suggestioni finalistiche, che essi sono metafore per rappresentare il risultato di occorrenze casuali per cui gli individui che si trovavano al posto giusto, nel momento giusto e con le caratteristiche giuste sono sopravvissuti più a lungo e hanno avuto l’occasione di generare discendenti.

Al contrario, indulgere nella personificazione di questi concetti comporta il rischio di distorsioni socialmente pericolose, come, ad esempio, la giustificazione della “legge del più forte” e l’uso della selezione naturale per legittimare il carattere naturale di discriminazioni sociali, sessuali e razziali.

Allo stesso modo, considerare le specie come oggetti internamente coerenti o – addirittura – come soggetti, può essere il fondamento di pericolosi ragionamenti specisti o di atteggiamenti ecologisti i cui risultati sono discutibili, come la reintroduzione[10] di una varietà di animali in un territorio, oppure – ne ho già scritto recentemente – uccidere un grosso carnivoro “problematico” sia moralmente accettabile poiché quella morte non incide sulla conservazione della specie nel territorio in cui essa vive.

NOTE

[1] L’edizione di On the origin of species by means of natural selection or the preservation of favoured races in the struggle for life che C. Darwin considerava definitiva è la sesta, pubblicata – appunto – nel 1872

[2] Cfr. Wikipedia - Donald Hoffman

[3] E sentiamo, e odoriamo, in sostanza percepiamo con i sensi

[4] Secondo Descartes l’immagine della realtà esterna che viene proposta dai sensi alla mente potrebbe essere del tutto illusoria, con poco o senza attinenza con la realtà com’è veramente; l’unica garanzia che abbiamo che questa percezione è veridica risiede in Dio, che non ci inganna, che è garante della veridicità della percezione.

[5] Uso qui il “noi” esteso a tutte le specie animali senzienti, dotate di sensi e di percezione.

[6] Uso evoluzione e specie in corsivo per sottolinearne la soggettivazione

[7] Di questo – e delle distorsioni morali sul tema delle specie - ne parlerò in un prossimo articolo

[8] Per C. Darwin, molto sull’onda humiana, le leggi sono «la sequenza di fatti da noi accertati» (Cit. p. 154)

[9] Se proprio vogliamo parlare di specie come oggetto coerente, è bene evitare di dire "la specie ha sviluppato quelle caratteristiche" e – invece –dire "la specie si è trovata con quelle caratteristiche" come risultato di singole storie di singoli individui che hanno, singolarmente, sviluppato quelle caratteristiche; dire: la specie "è " quelle caratteristiche. Questo perché la "specie" non esiste. Similmente la "selezione" non opera, "l'evoluzione" non seleziona; non fanno nulla perché non esistono, non sono soggetti che agiscono, sono solo fenomeni che sono accaduti. Così ci salviamo dall'equivoco finalista, teleologico, dell'evoluzione.

[10] Presto un articolo sulla discutibilità, sia scientifica che morale, della reintroduzione degli orsi bruni in Trentino

La costruzione di un’identità (Seconda parte) - Il sesso nell’antichità

Nell'articolo precedente, La costruzione di un’identità (Prima parte), abbiamo visto come l’ermafroditismo e la transizione sessuale (cioè cambiare sesso nel corso della vita) siano fenomeni naturali. Sia nel mondo vegetale (piante e fiori) che animale (vermi, molluschi, pesci).

E gli esseri umani? Come è stato considerato l’ermafroditismo in passato? Un errore di natura? Non sempre.

Nell’antichità l’ermafroditismo (l’ambi-sesso) fu considerato uno stato originario, un’essenza divina, completa, irraggiungibile, la perfezione perché nell’uno c’erano tutte le possibilità.

Chi era rimasto ermafrodita, anche dopo la scissione primordiale, era quindi un essere ritenuto semi-dio, un umano non umano, un umano che sfuggiva alla razionalità del dualismo imposto dalla cultura e dalla società (cfr. Fausto-Sterling, A., 2000: 32). L’ermafrodito era definibile in un genere altro rispetto a quello maschile e femminile, definito dagli Dei appunto neutrum.

Ermafrodito è il figlio di Hermes (messaggero degli Dei) e di Afrodite (dea dell’amore e della bellezza). Il suo nome è la crasi dei nomi dei suoi genitori. Secondo il mito, la ninfa Salmace – perdutamente innamorata del giovane – chiese a suo padre (Poseidone) di poter essere fusa per sempre con il ragazzo. Fu così che la ninfa-donna si fuse con il semidio-uomo: ne nacque l’ermafrodita/o.

Platone

Nel Simposio di Platone, il commediografo Aristofane sostiene che a uno stadio originario dell’umanità,

(precedente alla divisione dei sessi) esisteva solo un terzo genere, un po’ come il numero 1 (parimpari) che genera tutti gli altri numeri:

«Innanzitutto, i generi degli uomini erano tre e non due come ora, ossia maschio e femmina,

ma c’era anche un terzo che accomunava i due, e del quale ora è rimasto il nome, mentre esso è scomparso. L’androgino era, allora, una unità per figura e per nome, costituito dalla natura maschile e da quella femminile accomunate insieme, e nella forma e nel nome, mentre ora non ne resta che il nome, usato in senso spregiativo. […] Per questo i generi erano tre, perché il maschio aveva tratto la sua origine dal Sole, la femmina dalla Terra e il terzo sesso, che partecipava di entrambi, dalla Luna, la quale partecipa della natura del Sole e della Terra» (Platone, Simposio, 189 e/190 b, Mondadori, Milano 2001, pp. 55-57, trad. di Giovanni Reale).

Platone nel IV sec. a.C. sembra utilizzare (erroneamente) il termine androgino [composto da ἀνήρ «uomo» e γυνή «donna»] come sinonimo di ermafrodita.

Non solo nel mondo greco antico, ma anche in altre culture, l’ermafroditismo era visto positivamente. Ad esempio, secondo alcuni interpreti biblici, Adamo in origine nacque ermafrodita (Adamo-Eva) e venne successivamente scisso in maschio e femmina (cfr. Eliade 1989: 89). Inoltre, sono ermafroditi tutti gli Dei più importanti della mitologia scandinava (Odino, Loki, Tuisto, Nerthus), le divinità egizie Hapi, Atum e Neith di Sais, e quelle indiane Shiva e Vishnù, oltre ad Aditi. Pure l’azteco Ometeotl, la divinità doppia composta dai due aspetti Ometecuthli/Omecihuatl, è ermafrodita[1].

Aristotele

Come abbiamo visto nel Simposio, le cose cominciano a cambiare già ai tempi di Platone: l’ermafroditismo tra gli umani diviene una condizione molto controversa, spesso considerata un’aberrazione, un fenomeno infausto e turpe. Per Aristotele l’ermafrodita è un individuo sovrabbondante, in cui l’eccesso di materia sbilancia l’equilibrio tra maschile e femminile. Il pregiudizio aristotelico però si ferma al piano fisico: l’ermafroditismo è una condizione che interessa solo i genitali e non l’intera persona.

Questa visione ‘mostruosa’ dell’ermafrodita successivamente si accresce: neonat* che presentavano caratteristiche ambigue e difficilmente definibili venivano respint* come affratellat* al diavolo, emanazioni del peccato, messagger* di verità ingannatrici. Si profila in epoca medievale una lettura nuova dell’ermafroditismo, che non viene valutato soltanto nelle sue implicazioni fisiche, bensì inizia a essere giudicato come una devianza morale. Avviene cioè una transizione, storicamente fondamentale, dal pregiudizio fisico a quello morale: essere ermafrodit* non significava più possedere due attributi al posto di uno, ma significava essere individui ingannevoli a causa di una devianza fisica.

Per cui, fino agli inizi del ‘600 gli ermafroditi vengono considerati mostri, giustiziati e bruciati, e le loro ceneri sparse nel vento (cfr. Foucault 2004: 67).

Questo breve (e incompleto) excursus storico ci fa capire (al di là di ogni pretesa essenzialista) che i modi con cui indentifichiamo l’altro sono basati su categorizzazioni (culturali) che possono cambiare (e spesso lo fanno) nel tempo. E appellarsi alla “natura” non è sempre un buon modo di affrontare un tema. Anche perché la supposta “natura” (pensata come entità autonoma dall’agire umano), proprio in questo caso ci dice che esistono molteplici possibilità di identificazione sessuale e ridurle alle (o farle forzatamente rientrare nelle) nostre classificazioni non è sempre cosa saggia.

Ma allora, quali sono i criteri di individuazione sessuale? Lo vedremo la prossima volta.

NOTE

[1] Cfr. https://win.storiain.net/arret/num197/artic1.asp

BIBLIOGRAFIA

Eliade, Mircea (1989), Il mito della reintegrazione, Milano: Jaca Book.

Fausto-Sterling, Anne (2000), Sexing the Body: Gender Politics and the Construction of Sexuality, New York: Basic Books.

Foucault, M. (2004), Gli anormali. Corso al Collège de France (1974-1975), Milano: Feltrinelli.

La costruzione di un’identità (Prima parte) - Sesso (biologico), genere (sociale) e orientamento sessuale: 3 concetti non sovrapponibili

Si è molto parlato, lo scorso mese durante le Olimpiadi di Parigi, del caso della pugile algerina Imane Khelif, che poi ha vinto la medaglia d’oro: è una donna? Un uomo? Un ibrido? Una chimera?

Contrariamente alle opinioni e giudizi prêt-à-porter, che esperte di tutto inondano giornali, blog e social, la risposta a queste domande non è così semplice e richiede un’attenta riflessione.

Di una cosa, però, siamo sicuri: Khelif non è stato il primo caso e non sarà certamente l’ultimo.

Per cui vale la pena approfondirlo.

Anche perché la storia delle caratteristiche (o determinanti) della distinzione tra uomo e donna è molto lunga e complessa. E interseca i concetti di ‘natura’ e ‘cultura’, gli sviluppi della ‘tecnologia’, i cambiamenti nella ‘scienza’. Partiamo allora (se così si può impropriamente dire) dalla ‘natura’.

INTERSESSUAL*

Attualmente, almeno in Italia, il 2% de* nascitur* è intersessuale. Sono persone che “naturalmente” hanno organi genitali poco pronunciati, per cui non si sa se sono uomini o donne. Infatti, possiedono un misto di tratti biologici maschili e femminili, in un rapporto di permeazione (letteralmente l’atto di passare attraverso la dicotomia). Questo fenomeno “naturale” mette in crisi il dimorfismo sessuale (dal greco "due forme"), una visione dualistica, polarizzata, dicotomica che scricchiola.

Anziché lasciarl* crescere e sviluppare liberamente e, magari, differire a una età di maggior consapevolezza una LORO decisione se essere uomini, donne o restare così come sono (perché la loro biologia non glielo dice), invece a queste persone, solitamente, viene IMPOSTO chirurgicamente (appena nate o nell’infanzia) un sesso da parte del/la medico e/o dai genitori (che si devono confrontare con stereotipi e pregiudizi). Quindi nei confronti di neonat* e bambin* si opera un intervento artificiale sulla loro NATURALITÀ: infatti sono persone nate così, indeterminate. Attualmente in Italia sono circa 900.000 persone quelle nate intersessuali.

LE PIANTE

E non parliamo di “errore di natura”, perché l’ermafroditismo o monoicismo (dal greco antico mόνος unico e οἶκος casa) è ben presente in natura.

Ad esempio nelle piante, il termine ‘monoico’ si utilizza parlando di spermatofite (ovvero piante a seme). Le angiosperme e gimnosperme presentano delle strutture riproduttive (fiori e strobili) che possono contenere le parti fertili maschili e femminili, insieme o separatamente. Se le due parti coesistono

i fiori sono detti ermafroditi. I termini monoico e dioico non si utilizzano riferiti alla singola pianta (maschile o femminile) ma alla specie intesa come entità (es. l'ontano è una specie monoica). Il larice è una conifera monoica: i coni maschili (gialli) e quelli femminili (rosa), sono portati dallo stesso individuo.

LA FLUIDITÀ SESSUALE NELLE PIANTE

Recentemente, però, è stata identificata in Australia (il 19 giugno 2019, ricerca pubblicata sulla rivista PhytoKeys) una pianta (un pomodoro selvatico) esistente da migliaia di anni, appartenente alla famiglia delle Solanacee (un gruppo di angiosperme di cui fanno parte specie molto note come patate, pomodori, peperoni, peperoncini e melanzane) che presenta caratteristiche uniche nel suo fenotipo (cioè morfologia) riproduttivo, che le hanno fatto guadagnare il nome scientifico Solanum Plastisexum o "sesso fluido”.

In altre parole, questa specie fa qualcosa di più del solito ermafroditismo: può presentare contemporaneamente tutti i possibili fenotipi sessuali su un singolo esemplare. Per cui, la pianta possiede una caratteristica praticamente unica tra le solanacee: lo stesso esemplare può mostrare fiori maschili, fiori femminili, e anche fiori ermafroditi che presentano contemporaneamente le caratteristiche sessuali di ambo i sessi (stami e pistilli), in combinazioni variabili e mai osservate prima in questa famiglia di piante.

Una caratteristica del sistema riproduttivo che sfugge a qualunque classificazione; il primo, vero, vegetale "gender fluid" mai catalogato e che secondo le ricercatrici mostra quanto sia impossibile stabilire una norma nella sessualità del vegetale[1].

LA TRANSIZIONE SPONTANEA DA UN SESSO ALL’ALTRO NEL MONDO ANIMALE

Anche il mondo animale non è da meno. Infatti, in diverse specie animali avviene un cambio di sesso in modo spontaneo e naturale, in particolare nei pesci. Diversamente dall’ermafroditismo istantaneo (degli esseri umani), nei pesci abbiamo un ermafroditismo sequenziale, cioè un cambiamento nel tempo,

ma “soltanto a una certa età” (come canterebbe Lucio Dalla).

Nei pesci l’ermafroditismo sequenziale si suddivide in:

- proteràndrico (dal greco próterosanteriore e andròs uomo), in cui il pesce (es. il mollusco bivalvo, l’orata, molte specie di vermi) passa una prima fase della sua vita sessuale come maschio e la termina come femmina;

- quindi i gameti maschili maturano prima dei gameti femminili;

- proterogìnico (ghynḗfemmina), in cui il pesce (es. i pesci del genere Anthias, pesce pappagallo, pesce napoleone, cernia, ostriche) passa una prima fase della sua vita sessuale come femmina e la termina come maschio (es. i pesci del genere Anthias)

- quindi i gameti femminili maturano prima dei gameti maschili;

- alternante, in cui i pesci di una certa specie cambiano sesso più di una volta, durante il loro ciclo vitale.

Insomma, il mondo è molto più complesso e articolato di quanto stereotipi e pregiudizi vorrebbero farci credere.

E negli esseri umani cosa succede? Lo vediamo nella prossima puntata.

NOTE

[1] Cfr. https://www.repubblica.it/scienze/2019/06/19/news/ecco_il_solanum_plastisexum_il_pomodoro_gender_fluid_-229170346/

La valutazione oggettiva non esiste - È sempre guidata da una teoria (soggettiva) sottostante…

Si sente spesso pronunciare l’espressione “valutazione oggettiva”. Essa viene commissionata e richiesta a studiose, consulenti e valutatrici. In realtà tale espressione è un ossimoro. Perché la valutazione è sempre soggettiva. Forse, il vero pericolo è che diventi soltanto arbitraria. Ma a questo ci sono rimedi.

Le esperte e studiose serie di valutazione (non le praticone) lo sanno bene. E da molto tempo, ormai.

Cito solo tre approcci di importanti autori e autrici, che fin dagli anni ’80 hanno tematizzato questo aspetto, in polemica con la valutazione di impianto positivista e sperimentale:

- la valutazione realistica (Realistic Evaluation) di Ray Pawson e Nick Tilley

- la valutazione guidata dalla teoria (Theory-Driven Evaluation) di Chen e Rossi

- la valutazione basata sulla teoria (Theory Based Evaluation) di Carol Weiss

Il tratto comune a questi tre approcci è mostrare (e teorizzare) come la valutazione sia sempre guidata da una teoria sottostante, e quindi basata sia su assunti epistemologici ma anche di conoscenze di senso comune.

Vediamo un esempio illuminante che ci proviene dall’economia

Il valore di una professione

La New economics foundation (Nef) è un istituto di ricerca, consulenza e idee innovative (think tank) composto da una cinquantina di economiste, famose per aver portato nell'agenda del G7 e G8 (a fine anni duemila) temi quali il debito internazionale.

Nel 2009 si proposero di condurre una ricerca sul valore delle professioni, che adottasse però una prospettiva diversa (da quelle tradizionali). Tale prospettiva aveva lo scopo di “collegare gli stipendi al contributo di benessere che un lavoro porta alla comunità".

Come spiegarono nella stessa introduzione della ricerca, "abbiamo scelto un nuovo approccio per valutare il reale valore del lavoro. Siamo andati oltre la considerazione di quanto una professione viene valutata economicamente e abbiamo verificato quanto chi la esercita contribuisce al benessere della società. I principi di valutazione ai quali ci siamo ispirati quantificano il valore sociale, ambientale ed economico del lavoro svolto dalle diverse figure".

--------

In altre parole, se si modificano i criteri teorici, culturali, ideologici (ma questa è una scelta, una decisione, un atto soggettivo), avremmo risultati di ricerca molto diversi.

Il Nef calcolò così il valore economico di sei diversi lavori, tre pagati molto bene e tre molto poco, introducendo nuovi criteri e abbandonando i vecchi (soggettivi anche loro, ovviamente).

Il risultato fu sorprendente e rovesciava le gerarchie tradizionali.

Ad esempio, comparando un operatore ecologico e un fiscalista, il Nef concludeva che il primo contribuisce con il suo lavoro alla salute dell'ambiente grazie al riciclo delle immondizie, mentre il secondo danneggia la società perché studia in che modo far versare ai contribuenti meno tasse. Quindi il primo dovrebbe essere pagato molto di più e il secondo molto di meno (per usare un eufemismo).

Lo stesso vale, dicono al Nef, per i banchieri che prosciugano la società e causano danni all'economia globale.

In generale, esaminando “il contributo sociale del loro valore, abbiamo scoperto che i lavori pagati meno sono quelli più utili al benessere collettivo".

Conclusione che certamente approverebbero i due uomini in giallo, ma anche Wim Wenders, visto che con il suo ultimo film Perfect Days (2023) fa un biopic di un addetto alle pulizie dei bagni pubblici di Shibuya (uno dei 23 quartieri speciali di Tokyo), quasi un eroe dei nostri tempi.

Le economiste del Nef sono molto chiare: “il nostro studio vuole sottolineare un punto fondamentale e cioè che dovrebbe esserci una corrispondenza diretta tra quanto siamo pagati e il valore che il nostro lavoro genera per la società. Abbiamo trovato un modo per calcolarlo e questo strumento dovrebbe essere usato per determinare i compensi".

Per cui, la valutazione è primariamente un problema teorico.

Solo secondariamente diventa un problema tecnico.

Proprio l’opposto di quello che molte scienziate ci dicono, e continueranno a (men)dire…

RIFERIMENTI BIBLIOGRAFICI

Chen H. T. (1990), Theory driven Evaluation, Thousand Oaks: Sage.

Chen H. T. e Rossi P. H. (1981), The multi-goal, theory-driven approach to evaluation. A model linking basic and applied social science, in “Social Forces”, 59, pp. 106-22.

Pawson R. e Tilley N. (1997), Realistic evaluation, London: Sage.

Weiss C. H. (1995), Nothing as Practical as Good Theory: Exploring Theory-Based Evaluation for Comprehensive Community Initiatives for Children and Families, in Connell J. P., Kubisch A. C., Schorr L. B. e Weiss C. H. (a cura di), New Approaches to Evaluating Community Initiatives. Vol. 1 Concepts, Methods, and Contexts, The Aspen Institute, Washington (DC), pp. 65-92.

Weiss C. H. (1997a), How can Theory-Based Evaluation make greater headway? in “Evaluation Review”, 4, pp. 501-524.

Weiss C. H. (1997ab), Theory-based evaluation: past, present, and future, in “New Directions for Evaluation”, 76, pp. 41-55,

Weiss C. H. (1998), Evaluation. Methods for studying programs and policies, Upper Saddle River (NJ): Prentice Hall, 1998.

La fisiologia dualista di Cartesio si regge sull’uso improprio degli animali?

Quando si parla di Cartesio (1596 - 1650) non va dimenticato che è uno scienziato (si direbbe oggi), un filosofo naturale (si diceva ai suoi tempi) che lavora per anni in modo moderno basandosi sul dubbio, rifuggendo il dogmatismo, osservando e costruendo le teorie sull’osservazione e sulla confutazione, discutendo con i suoi pari e antagonisti sulla fisiologia dei viventi, e che da questa fisiologia prende forma la sua teoria dualista del corpo e della mente.

Fisiologia dei viventi, sì; ma con al centro di tutto l’uomo[1]. Infatti, nella prima parte della sua opera, Descartes non considera gli animali se non di sfuggita e in modo conformista: l’animale è quello della tradizione aristotelico-scolastica, con qualche facoltà psichica ma senza intelligenza.

“quanto alla ragione o buon senso, essendo questa la sola cosa che ci fa uomini e ci distingue dalle bestie” (Descartes, R, Discorso sul metodo e meditazioni filosofiche, Universale Laterza, 1978, p. 4)

Probabilmente a Descartes importava poco, degli animali, e non poteva essere collocato in modo netto su nessun versante della controversia naturalista e filosofica, tra teriofili e non-teriofili che si sviluppò in Francia nella modernità [2] – cioè tra filosofi naturali e pensatori che sostengono che tra umano e animale non ci sia una grande distanza, in termini di fisiologia di capacità morali, di sensibilità e di intelligenza e, al contrario che ritengono gli animali inferiori all’umano secondo tutti questi aspetti.

La fisiologia dell’umano è, invece, al centro de L’Homme, che Descartes inizia nel 1630 e continua a scrivere per un decennio ma che non pubblica in vita [3].

Ne L’Homme, Cartesio sviluppa una fisiologia ponderosa, ampia, dettagliata, in parte sostenuta da osservazioni naturaliste, in parte congetturale o basata su teorie della tradizione, in cui il corpo, la res estensa, ha un ruolo molto ampio, acquista mano a mano sempre più potere, invade le aree della sensibilità, dell’adattamento, del pensiero e del giudizio.

Per Descartes, però, si delinea un rischio: perseguire la strada intrapresa con L’Homme, in cui le facoltà dell’adattamento all’ambiente, il pensiero e il giudizio sono funzioni del corpo, significa puntare verso il materialismo e il determinismo.

E, come se non bastasse, questo mette a repentaglio anche una serie di punti importanti del suo stesso pensiero e vitali per il contesto in cui vive e lavora il fisiologo Cartesio: la preminenza della ragione, la mente, la libertà di scelta e, addirittura, l’esistenza e immortalità dell’anima.

Come può fare, Descartes a salvare capra e cavoli, a mantenere, cioè, la fisiologia potente del corpo e, nello stesso tempo non mettere in crisi il potere della ragione, la scelta, l’anima immortale, e – in definitiva – il giudizio come parte della componente spirituale dell’umano, della sua mente?

Un modo valido per coniugare queste due esigenze sembra essere la separazione di corpo e mente, il dualismo. Cioè, la divisione della fisiologia del vivente, con il corpo sede di funzioni della sensibilità, meccaniche, operative, di senso, e la mente che raccoglie, decodifica, decide e imposta valutazione, pensiero e azione.

Tuttavia, per non sminuire il lavoro fatto ne L’Homme, il “corpo-da-solo” deve poter essere autonomo, deve poter vivere senza pensiero, senza emozioni, senza anima, senza valutazione e giudizio.

Facile a dirsi ma difficile, però, a dimostrarsi; non sembrano esserci umani viventi che possono impersonare la mente senza corpo (certo, c’è l’anima immortale una volta separata dal corpo; ma questa è materia religiosa) né, tantomeno, un corpo ben funzionante senza la mente[4]

In soccorso di Descartes arrivano gli animali! Corpi e solo corpi, ottimamente funzionanti – in molti casi meglio degli umani: reattivi, efficaci e, nello stesso tempo, non senzienti, non pensanti, senza giudizio, senza scelta. Quindi, autonomi e automatici!

“molti animali, pur dimostrando maggiore abilità di noi in alcune loro azioni, non ne dimostrano affatto in molte altre: di modo che, quel ch'essi fanno meglio di noi, non prova affatto che abbiano ingegno, perché, se così fosse, ne avrebbero più di noi e anche nel resto farebbero meglio; ma prova piuttosto che non ne hanno punto, e ch'è la natura quella che opera in essi secondo la disposizione dei loro organi: a quel modo che un orologio, composto solo di ruote e di molle, conta le ore e misura il tempo più esattamente di noi con tutta la nostra intelligenza”. (Descartes, R, Discorso sul metodo e meditazioni filosofiche, Universale Laterza, 1978, p. 42)

Questa degli animali automatici è una soluzione, tutto sommato, molto a buon mercato; perché gli animali non possono lamentarsi e perché c’è già una ampia letteratura anti-teriofila, tra scienze naturali e fisiologia, che non attribuisce funzioni “superiori” ai non umani.

E non è una soluzione qualunque perché, se da un punto di vista epistemologico, Descartes mette al sicuro la veracità della conoscenza con il lumen naturale, con il cogito e – alla fine – con la garanzia della rappresentazione garantita da Dio, dal punto di vista ontologico, l’animale-macchina “salva” l’autonomia delle due res, cogitans e estensa, l’anima immortale, tutta la fisiologia.

E, da allora, gli animali non umani sono sempre più macchine, bruti, senza sentimenti, senza patimenti, oggetti. Fruibili a fini filosofici e “buoni da usare” (non solo da mangiare).

NOTE

[1] Inteso come essere umano. Cartesio non avrebbe, però, mai detto ‘essere umano’, e certamente non pensava alla parità di genere.

[2] A partire da Montaigne fino a Rousseau; per approfondimenti, cfr. Boas, The Happy Beast in French Thought of the Seventeenth Century, John Hopkins Press, 1933 e Singer P., La nuova rivoluzione animale, Il saggiatore, 2024, pagg. 61 e segg.

[3] Cfr.: Corpus Descartes, Édition en ligne des œuvres et de la correspondance de Descartes, https://www.unicaen.fr/puc/sources/prodescartes/accueil.html

[4] I tentativi di considerare corpo senza mente diverse forme di disabilità mentali non sembrano dare risultati validi: l’osservazione e la fisiologia mettono sempre in luce scampoli di mente sensibile

Nello specchio dell’Intelligenza Artificiale - The Eye of the Master

Specchi

Con consueta indiscrezione Oscar Wilde rivela che Dorian Gray si è immunizzato dai sintomi dell’invecchiamento e del degrado morale della sua condotta, proiettandone i sintomi su un ritratto che custodisce in soffitta. Solo puntando lo sguardo sul dipinto è possibile scorgere la verità che l’aspetto del personaggio sta mascherando. Cosa vediamo quando fissiamo gli occhi sull’intelligenza artificiale, che in qualche modo abbiamo costruito come un ritratto tecnologico della nostra umanità? Le scienze cognitive e gran parte delle pubblicazioni divulgative affermano che i dispositivi informatici riflettono la forma della nostra mente, anche se ancora in modo parziale e talvolta alterato. Nei computer riverbera la verità dello spirito, anche se ancora solo per speculum et in aenigmate, un po’ come secondo Agostino di Ippona e Paolo di Tarso la nostra esperienza ci permette di scorgere il volto di Dio in uno specchio, non ancora faccia a faccia – con tutte le contraffazioni che ai tempi dell’impero romano le superfici riflettenti praticavano sulle immagini.

Ma è possibile che nell’intelligenza artificiale si mostri quello che il lavoro collettivo della storia della tecnologia vi ha introdotto in fase di progetto e di sviluppo, più che la struttura o le funzioni della mente nella loro presunta universalità e immutabilità. La tesi che Matteo Pasquinelli dimostra in The Eye of the Master rende omaggio all’evidenza che nei dispositivi informatici troviamo quello che ci abbiamo messo più che quello che siamo, in una prospettiva che ha il pregio di muoversi in direzione opposta all’opinione comune, e con una strategia di argomentazione tutt’altro che triviale. I passaggi focali della sua ricostruzione sono due.

Ragazze che contano

Il primo si colloca all’origine della storia dell’informatica, o comunque in uno dei momenti considerati come essenziali per la nascita della disciplina: qui Pasquinelli sfida il presagio di noia dei lettori esperti, soffermandosi sugli studi condotti nella prima metà dell’Ottocento dal matematico Charles Babbage per la realizzazione della «Macchina Differenziale» (ed esponendo me ora allo stesso rischio). Il dispositivo non è mai stato portato a compimento, e si distingue dai computer progettati e costruiti nel Novecento per il fatto che non prevede una distinzione tra hardware e software: la macchina, anche nella sua veste definitiva, sarebbe stata in grado di processare un solo programma – quello del calcolo delle tavole logaritmiche. Babbage ha anche elaborato i piani per una «Macchina Analitica», che avrebbe potuto eseguire una pluralità di compiti diversi, ricorrendo a schede meccaniche paragonabili a quelle utilizzate nei telai Jacquard per l’esecuzione dei ricami. In questo caso però la pianificazione non ha condotto nemmeno al prototipo con azionamento manuale, che invece è stato messo a punto per la Macchina Differenziale.

Il primo progetto è stato sollecitato da esigenze commerciali e militari, ottenendo anche un finanziamento pubblico di 1.500 sterline: le tavole logaritmiche sono essenziali per il tracciamento delle rotte, e sono state quindi uno strumento fondamentale per la solidità dell’impero coloniale costruito dagli inglesi fino dal Settecento. Il procedimento seguito da Babbage, da cui discende la tecnica moderna della programmazione, si fonda sulla nozione di divisione del lavoro divulgata da Adam Smith cinquant’anni prima e approfondita in due direzioni.

La prima è quella della riduzione delle operazioni di calcolo ai passaggi meccanici di cui sono composte. Turing ripete lo stesso esercizio più di un secolo dopo, quando in piena Seconda Guerra Mondiale elabora il modello matematico per decrittare i messaggi in codice della marina tedesca. Computer ai tempi di Babbage, e ancora ai tempi di Turing, non è il nome di una macchina, ma l’etichetta di una professione esercitata per lo più da ragazze, che eseguono lunghe sequenze di calcoli meccanici in cui sono stati segmentati algoritmi predisposti da ingegneri e da matematici, per la misurazione di rotte, di distribuzioni statistiche, ecc. La riduzione di questa varietà di competenze a singoli passaggi automatici permette di organizzarli in una macchina, che quindi non è un oggetto ma la cristallizzazione di una configurazione di relazioni sociali e della divisione del lavoro che la governa.

La seconda direzione proviene dagli studi di Babbage in ambito di management aziendale, e dalla sua conapevolezza che la divisione del lavoro permette di calcolare il costo di ogni fase della produzione, e di abbatterlo attraverso l’assegnazione dei compiti più semplici a personale non qualificato, o a macchine che lo rimpiazzino. Babbage non coincide con l’immagine di apostolo dalla purezza della curiosità scientifica che l’agiografia dipinge da sempre, né è stato una figura isolata nella sua austerità accademica – né la sua invenzione è neutrale da un punto di vista morale e politico. Il computer cristallizza la piramide di competenze e le prestazioni dei matematici, degli ingegneri, delle signorine calcolatrici, riflettendo le gerarchie sociali e le strutture etiche che ne governano la divisione del lavoro: la macchina non è moralmente meno compromessa del ritratto di Dorian Gray.

Autonomia, parzialità e fallibilismo

L’ordinamento gerarchico piramidale della cultura industriale si rispecchia nella tecnica di programmazione inaugurata da Babbage, che implementa una struttura di comando verticale in cui l’ingegnere del software definisce tutte le fasi di elaborazione, e i processi le eseguono in modo automatico. La società contemporanea non può essere controllata nello stesso modo, a causa della complessità delle interazioni, e del livello di distribuzione e di autonomia degli agenti coinvolti. I freelance che lavorano con il coordinamento delle imprese della gig economy, come gli autisti di Uber o i rider di Glovo, i creatori di contenuti che pubblicano sui social media, i webmaster che producono le pagine digitali indicizzate da Google, gli attori e i prodotti del mercato finanziario globale, sono alcune espressioni della mereologia tra organicità e frammentazione locale del mondo contemporaneo. I soggetti che lo abitano dispongono sempre di una conoscenza parziale dell’ambiente in cui operano, e sviluppano una comprensione della realtà che è stimata per congettura, con rappresentazioni che devono essere aggiornate o rivoluzionate sulla base dell’esperienza.