Coltivare la vita in laboratorio - Come siamo arrivati a intendere la materia vivente come tecnologia

Pensando al lavoro di scienziati o biologi in laboratorio non ci risulta strana la possibilità che questi possano essere impegnati nella coltivazione di cellule o linee cellulari provenienti da vari organismi viventi. Ad esempio, attualmente le cellule che provengono da esseri umani sono ampiamente utilizzate nei laboratori e in programmi di ricerca biomedica, così come rivestono un ruolo centrale nella ricerca farmaceutica. In breve, la possibilità di mantenere in vita cellule e tessuti umani al di fuori del corpo e di usarle come una materia tecnologica è qualcosa che accade di routine, è ritenuto normale e non desta alcun particolare senso di straniamento. Tuttavia, com’è possibile questo? Quando siamo arrivati a pensare la vita al di fuori del corpo come qualcosa di normale e non problematico? E in quale momento la vita e le cellule hanno assunto questa particolare forma tecnologica? Questi sono alcuni degli interrogativi da cui parte anche Hannah Landecker (2007), sociologa e storica della scienza, nel ricostruire la storia della coltura dei tessuti. Tali questioni ci possono aiutare a focalizzare l’attenzione su alcune delle condizioni che hanno permesso la costruzione di infrastruttura in cui è stato possibile standardizzare metodi, tecniche e oggetti sperimentali impiegati nella coltura cellulare.

Un evento da cui iniziare può essere rintracciato nel 1907, quando Ross Harrison, a partire dal tessuto embrionale di una rana, riuscì ad osservare la crescita di una fibra nervosa al di fuori del corpo. In quegli anni era in corso un vivace dibattito scientifico sulla natura e sviluppo delle fibre nervose a cui risultava difficile trovare una soluzione con le tecniche e i metodi sperimentali impiegati. Infatti, gli scienziati si affidavano principalmente a tecniche istologiche, le quali consistevano nell’acquisizione di sezioni del corpo di un animale in diverse fasi nel tempo, per cui era necessario sacrificare vari animali in diversi momenti per osservare degli sviluppi tissutali. I tessuti ottenuti in questo modo erano resi adeguati alla conservazione e all’analisi attraverso sostanze fissative e coloranti, e in questo modo fornivano dei modelli statici di momenti precisi dello sviluppo. Nonostante ciò, con queste tecniche istologiche non era possibile trovare una risposta sostanziale allo sviluppo delle fibre nervose: gli scienziati potevano dare delle interpretazioni opposte dello stesso frammento di tessuto reso in forma statica. Harrison risolse questa controversia cercando di rendere visibile, al di fuori del corpo, il processo di sviluppo di una fibra nervosa mentre avveniva. Partendo da nozioni di coltura dei microrganismi, egli riuscì a realizzare una preparazione a “goccia sospesa” (hanging-drop) che forniva un supporto attraverso della linfa coagulata per far crescere le fibre nervose di rana al di fuori del corpo. In questo modo, Harrison utilizzando delle cellule vive risolse il problema di come gli organismi biologici viventi cambiano nel tempo e rese visibili i processi che erano interni al corpo degli animali. È in questo senso che all’inizio del XX secolo inizia ad emergere la possibilità e l’idea di sperimentazione in vitro e non più solo in vivo.

Qualche anno più tardi Alexis Carrel e il suo assistente Montrose Burrows tentarono di sviluppare le tecniche adottate da Harrison nel tentativo di mantenere in vita le cellule al di fuori del corpo. Carrel e Burrows trasformarono “il metodo di Harrison per la crescita a breve termine di un tessuto embrionale in un metodo generalizzato per la coltivazione di tutti i tipi di tessuto” (Landecker 2007, p.53) e nel 1910 coniarono il termine “coltura tissutale” per riferirsi a questa serie di operazioni. In particolare, Carrel e Burrows cercarono di mantenere in vita le cellule attraverso la creazione di colture secondarie a partire da un frammento di tessuto: spostando una parte delle cellule in un nuovo medium plasmatico si generava una sorta di riattivazione cellulare e queste continuavano a vivere. Tuttavia, con questa tecnica le cellule cessavano di aumentare di massa e diventavano più piccole ad ogni trasferimento, per cui la soluzione tecnica che adottò Carrel fu quella di aggiungere del tessuto embrionale macinato – chiamato “succo embrionale” – per nutrire le cellule. Fu in questo contesto che Carrel affermò la possibilità di poter coltivare delle “cellule immortali”, che potevano vivere in maniera indefinita al di fuori del corpo. Infatti, per Carrel la morte cellulare era un “fenomeno contingente” che poteva essere rimandato attraverso la manipolazione del medium plasmatico e le sostanze in cui era immersa la cellula. Per questa ragione, Carrel brevettò una fiaschetta, nota come “Carrel flask”, che gli permise di coltivare le cellule in modo asettico evitando infezioni e manipolando le sostanze in cui erano immerse le cellule in modo controllato. Tuttavia, va precisato che negli anni ’60 si dimostrò che le uniche cellule che potevano essere tecnicamente immortali erano quelle di origine cancerosa.

È attraverso le pratiche sperimentali di Harrison e Carrel che inizia ad emergere una nuova enfasi sul corpo e sulla possibilità di coltivare delle cellule in vitro. All’inizio del XX secolo non era nuova la possibilità di tenere i tessuti al di fuori del corpo per un po’ di tempo, ma in quel contesto il corpo era concepito come l’elemento essenziale che garantiva la vita delle cellule, le quali non avrebbero potuto sopravvivere al di fuori di esso. Le pratiche sperimentali di Harrison e Carrel segnano un passaggio all’idea che le cellule e i tessuti non solo possono sopravvivere al di fuori del corpo, ma continuano a dividersi, differenziarsi e vivere. In questo senso, inizia ad emergere un senso di possibilità legato al fatto che le cellule possono vivere con una certa autonomia anche se staccate dal corpo.

È tra gli anni ’40 e ’50 con la campagna contro il virus della poliomielite che, attraverso una serie di sforzi infrastrutturali, fu reso possibile l’impiego per la prima volta di tessuti umani su larga scala: in precedenza ciò non era possibile e le cellule venivano coltivate in singoli laboratori senza la possibilità di scambi e trasferimenti. Nella prima metà del XX secolo i virus erano molto difficili da osservare e coltivare: venivano conservati in laboratorio facendoli passare attraverso uova ed animali infetti; ciò era un metodo molto complesso e costoso. Per questa ragione nel 1940 John Enders pensò di utilizzare i metodi di coltura tissutale per osservare lo sviluppo delle infezioni virali. In questo modo, Enders e il suo collega Weller svilupparono un modello cellulare per osservare il lento sviluppo nel tempo del virus della parotite, questo si rivelò poi anche utile per studiare la poliomielite. Pertanto, attraverso la coltura dei tessuti è diventato possibile osservare lo sviluppo delle infezioni virali osservando i cambiamenti cellulari invece che guardare i sintomi che si manifestavano negli animali infetti. In seguito, nel 1954 John Salk attraverso l’impiego di queste tecniche di coltura cellulare riuscì a realizzare un vaccino contro la poliomielite.

Va sottolineato che ciò che Enders e Salk riuscirono a fare va inserito in uno sforzo più ampio della comunità scientifica a partire dagli anni ’40 che ha permesso il miglioramento delle tecniche di coltura tissutale e la loro standardizzazione. In particolare, in quegli anni organizzazioni come la Tissue Culture Association (TCA) e la National Foundation for Infantile Paralysis (NFIP) si impegnarono nel tentativo di standardizzare e rendere disponibile alla comunità scientifica materiali e tecniche per la coltura cellulare: vennero organizzati convegni e in breve tempo diventò possibile acquistare terreni ed estratti con cui far crescere le cellule. Fu anche grazie a questo lavoro coordinato che fu possibile utilizzare la linea cellulare immortale HeLa come materiale standard per il test del vaccino contro la poliomielite in diversi laboratori. HeLa era stata stabilita da George Gey nel 1951 grazie alla biopsia di una massa tumorale prelevata da Henrietta Lacks, la quale si era recata in ospedale per ricevere assistenza e non sapeva come sarebbe stato impiegato il tessuto prelevato (Skloot 2010). Al termine della campagna contro la poliomielite HeLa era ampiamente diffusa nei laboratori e gli scienziati iniziarono ad utilizzarla per gli scopi di ricerca più disparati, generando così un’ampia mole di studi e pubblicazioni. Dunque, se in precedenza era possibile lavorare su oggetti dello stesso tipo – lo stesso tipo di topo o lo stesso tipo di tumore – attraverso HeLa diventò possibile lavorare sulla “stessa cosa” in tempi e luoghi diversi. Pertanto, è in questa cornice che i tessuti umani sono diventati così una base standard e un modello per la ricerca biomedica.

Secondo Landecker questa storia ci racconta di come la biotecnologia dal 1900 ad oggi si associ ai “crescenti tentativi di esplorare e realizzare la plasticità della materia vivente” (Landecker 2007, p. 232). Nello specifico, la plasticità riguarda la capacità della materia vivente di essere modificata dagli esseri umani, la quale continuando a vivere può reagire all’intervento anche in modi inaspettati. Inevitabilmente, in questo racconto la plasticità si associa al tentativo di rendere operativo il tempo biologico attraverso una manipolazione della cellula, del medium e delle sostanze in cui questa è immersa. In breve, questa storia ci può aiutare a comprendere il modo attraverso cui siamo arrivati alla concezione odierna di “vita come tecnologia”; ovvero, la possibilità di utilizzare le cellule come una forma tecnologica per interventi terapeutici, sviluppi farmaceutici e per l’industria alimentare. In secondo luogo, questo resoconto permette di evidenziare alcune delle condizioni attraverso cui è stato possibile costruire un’infrastruttura con cui poter mantenere stabilmente le cellule in laboratorio. Infatti, uno scienziato tende a dare per scontata l’idea che sia possibile coltivare delle cellule in laboratorio proprio perché nel tempo è stata sviluppata un’infrastruttura funzionale, e che per questo motivo tende a risultare “invisibile” (Star 1999). In tal senso, ripercorrere gli sviluppi della coltura tissutale permette di portare alla luce gli aspetti infrastrutturali e tecnici che invece rimarrebbero opachi nello sfondo.

BIBLIOGRAFIA

Landecker H. (2007). Culturing Life: how cells become technologies. Harvard University Press, Cambridge.

Skloot R. (2010). La vita immortale di Herietta Lacks. Adelphi, Milano.

Star S.L. (1999). The ethnography of infrastructure. American behavioral scientist, 43(3), 377-391.

Gemelli digitali – Tutti i modelli sono sbagliati ma alcuni sono utili

Tutti i modelli sono sbagliati ma alcuni sono utili

(George Box)

A dicembre 2024 abbiamo iniziato – con un articolo pubblicato da A. Saltelli con un largo gruppo di coautori - una riflessione sui modelli matematici e algoritmici che simulano la vita e le dinamiche di interi sistemi ambientali, fino a mettersi alla prova sulle dimensioni dell’intero pianeta. Questi modelli sono noti come gemelli digitali di qualcosa.

Seguiamo qui il percorso di un altro articolo di Saltelli, con Lieke Melsen ed Arnald Puy, uscito di recente su Minerva[1], Digital Twins of the Earth Between Vision and Fiction, per proseguire questa riflessione sui gemelli digitali e – più in generale – sull’uso dei modelli di simulazione nella analisi e nei tentativi di soluzione di problemi ambientali e sociali, e cercare una prima, parziale, conclusione di tipo morale.

La definizione di riferimento per gemello digitale ci viene data da IBM:

Un gemello digitale è una rappresentazione virtuale di un oggetto, o di un sistema, disegnata in modo da rifletterlo accuratamente. Il gemello copre il ciclo di vita dell’oggetto rappresentato, viene aggiornato in tempo reale con dati provenienti dall’oggetto situato nel mondo reale o dall’evoluzione del modello stesso. Per funzionare ed aiutare a prendere decisioni, può fare uso di diversi modelli di simulazione, di machine learning e di intelligenza artificiale. [2]

POSSIBILI ONTOLOGIE DEI GEMELLI DIGITALI

Gli autori dell’articolo su Minerva propongono una serie di interessanti e critiche interpretazioni ontologiche dei gemelli, che possono essere diversamente visti come:

- Strumenti per vedere un mondo [3] attraverso la lente della sua rappresentazione digitale e, grazie a questa rappresentazione, studiarne le caratteristiche, scoprirne le dinamiche e la realtà (The World in the Model – The World in the Twins). Secondo questo punto di vista, il mondo “viene illuminato” dal modello.

- Artefatti o forme culturali, secondo la teoria di G. Simmel; i modelli sono una “moda” relativamente recente e possono essere interpretati – in generale - come il prodotto culturale degli anni dello sviluppo delle tecnologie informatiche in cui, di converso, si può rinvenire una geografia delle scienze disegnata dalla popolarità di diversi tipi di modelli in diverse parti del mondo.

- Oggetti distanti [4] dal mondo che rappresentano e che, tuttavia, ne contendono il posto nella narrazione della comunicazione di massa: il modello assume il ruolo di neo-realtà, abolendo e facendo volatilizzare la realtà che simula.

- Burocrati senza pensiero e senza responsabilità: un gemello digitale di un ambiente può produrre conoscenza e – di conseguenza – materia su cui basare decisioni in maniera automatica e senza assumersi, in quanto macchina, alcuna responsabilità su quanto produce, sia il risultato delle elaborazioni vero, falso, onesto o distorto.

- Realizzazioni pratiche del sogno cartesiano di predizione e di controllo umano sulla natura, del realismo metafisico di cui Husserl accusa Galilei: il modello permette – sotto una serie di assiomi semplificativi e riduzionisti – di espandere il concetto di legge di natura ad un intero ambiente.

- Metafore di come percepiamo il mondo, che esprimono in forma indiretta i nostri punti di vista, preconcetti e opinioni sul mondo e sul problema rappresentati, se non addirittura sulle possibili soluzioni.

- Strumenti di divinazione, che predicono il futuro ma senza l’uso di magia o di poteri divini, e – in quanto tali – dotati di una elevata autorevolezza.

VALORE EPISTEMOLOGICO DEI GEMELLI DIGITALI

Ci pare che dalla interpretazione ontologica “The World in the Model – The World in the Twins” possa discendere la più calzante visione del ruolo epistemico dei modelli di simulazione e dei gemelli digitali, quella proposta dagli autori di mediatori [5] tra teoria e realtà, e tra realtà e osservatore.

Questo punto di vista – dicono gli autori - funge anche da antidoto contro il rischio di concepire i gemelli e i modelli matematici come “sola matematica” e sposta la discussione dalla categoria di ciò che è vero e ciò che è falso a quella della qualità […] dell’artefatto e dei suoi componenti, su cui il giudizio è messo in relazione al task che deve svolgere.

Tuttavia – nell’adozione di questa visione epistemologica - vanno tenuti in considerazione una serie di elementi potenzialmente critici:

- Quando definiamo come “matematici” i modelli di simulazione e i gemelli, rischiamo di focalizzarci su una vista parziale della loro natura poiché ben spesso questi includono nozioni teoriche (ricordiamoci come ogni esperimento sia carico di teoria), concetti matematici, tecniche digitali, fatti stilizzati, dati empirici, visioni normative , analogie e metafore. Questa considerazione richiede la consapevolezza che il modello – nel suo ruolo di mediatore – espande notevolmente la dialettica tra teoria e realtà.

- La complessità – in termini di ipotesi principali ed ausiliarie, teorie principali e “di sfondo”, elementi “non matematici” – dei gemelli digitali e di molti modelli, li espone, secondo la tesi di Duhem-Quine, a grandi difficoltà interpretative degli insuccessi e delle divergenze tra i risultati della simulazione e la realtà osservata: spesso non è possibole comprendere quale parte del modello non stia facendo il suo dovere e se sia necessario “fare il mondo più semplice o il modello più complesso”.

- L’ontologia di mediatore dei modelli richiede, inoltre, l’accortezza di non sovrapporre il modello con il suo referente, di non dimenticare che il gemello è un modello e non la realtà.

ETICA DELLA COSTRUZIONE E DELL’USO DEI GEMELLI

Le avvertenze e le considerazioni di stampo epistemologico evidenziate dagli autori (e da molti autori citati nell’ articolo, si vedano per questo gli appunti bibliografici), aprono la porta ad una serie di considerazioni di carattere morale [6], la prima considerazione delle quali – secondo me alla base di tutte le successive - è quella, ironica, di G. Box, tutti i modelli sono sbagliati ma alcuni sono utili. Il focus sull’utilità deve far riflettere, sia chi li costruisce che chi li usa, sul perché sono stati creati, sulle ragioni di chi li commissiona o li finanzia e su chi e come li utilizzerà.

Come conseguenza, gli autori mettono in guardia sulla possibilità che i gemelli possano essere:

- riduzionisti, che ignorano dimensioni scomode o difficili da rappresentare, inficiando la validità del modello o trascurando istanze morali minoritarie;

- economicisti, che mettono in primo piano, proprio come valore morale, la dimensione economica [7], trascurando i bisogni non materiali;

- giustificazionisti, costruiti e adattati con il fine di giustificare delle soluzioni, degli obiettivi o delle politiche - definite a priori o che emergono in corso d’opera

- decisionisti, mirati a semplificare la realtà in modo tale da permettere ai policy maker di prendere delle decisioni più agevolmente.

Queste distorsioni fanno capo all’obiezione di Niklas Luhmann, per cui «la scienza è spesso chiamata a “risolvere i paradossi” delle decisioni politiche, ossia a farle sembrare il risultato di un processo razionale [basato sull’oggettività dei numeri] invece che il risultato di una negoziazione tra interessi in competizione», oppure – peggio ancora – a privare i cittadini della loro possibilità di azione politica, che viene inclusa nei modelli solo in apparenza.

CONCLUSIONI

La consapevolezza di questi rischi e di queste potenziali distorsioni conducono gli autori a concludere che i gemelli vanno considerati parte del dibattito sulle questioni – ambientali, sociali, energetiche - che sono chiamati a simulare e non i produttori di risposte vere ed autentiche, di interpretazioni scientifiche ed oggettive.

Non è – secondo gli autori– la natura digitale dei modelli e dei gemelli ad essere critica ma il sistema di governance e di ownership da cui sono motivati e in cui sono immersi.

Nella realizzazione e nell’uso, quindi, devono essere tenute in debito conto le due dimensioni, tecnica e normativa, della loro qualità; la dimensione delle istanze morali che li motivano; la dimensione più ampiamente pubblica delle assunzioni e delle conclusioni e delle azioni che suggeriscono.

Ricordando la lezione di Giuseppe Scifo e interpolandola con le indicazioni normative di Funtowicz e Ravetz di cui abbiamo parlato recentemente, viene da suggerire di affidarsi meno ai modelli e ragionare, quando si deve analizzare, su “cosa succederebbe se” per avere supporto nelle decisioni politiche, in termini di scenari, cioè di fasci di modelli che variano al variare delle assunzioni su variabili il cui comportamento non è prevedibile; su gli known unknowns; sulle istanze morali minoritarie.

Programmare le azioni future sulla base di scenari permette di mantenere aperto lo spettro delle possibilità e di non trascurare le reali esigenze delle collettività.

NOTE

[1] Minerva, A Review of Science, Learning and Policy, Springer Nature, 09 April 2025

[2] Traduzione mia dall’originale: A digital twin is a virtual representation of an object or system designed to reflect a physical object accurately. It spans the object's lifecycle, is updated from real-time data and uses simulation, machine learning and reasoning to help make decisions.

[3] “Il mondo” è il referente del modello, può essere un oggetto o un ambiente, come abbiamo visto sopra

[4] Distanti anche in senso logistico: soprattutto quando si tratta di rappresentazioni del mondo naturale o dell’ambiente, i modellisti operano lontani dall’oggetto rappresentato e questa distanza favorisce la sovrapposizione del modello alla realtà.

[5] Cfr.: Morgan & Morrison (1999)

[6] Come di consueto, preferisco adottare il termine morale, anziché etico, per sottolineare la necessità di chiarire quali siano le istanze di fondo, i principi morali, appunto, su cui si basano le valutazioni, i giudizi e l’azione. È l’azione – basata su principi morali, ad essere etica. Tutte le volte che si parla di etica è – a mio avviso – necessario chiarire (o chiarirsi) quale sia la morale ispiratrice.

[7] La dimensione economica del mondo è, a mio avviso, una istanza morale che non va condannata o trascurata, poiché è quella che permette a tutti noi di mangiare, vestirci e avere una vita soddisfacente. Deve, però, avere questa visione ampia, non esclusivamente mirata allo sviluppo delle aziende.

Perché complicare ci viene più naturale che semplificare - Il bias dell’addizione

In teoria, la semplicità dovrebbe attrarci. Le soluzioni semplici sono meno costose, più eleganti, più facili da implementare. In pratica, ci troviamo costantemente ad aggiungere anziché togliere: funzioni, oggetti, procedure, parole, strutture. Questo comportamento non è soltanto una cattiva abitudine culturale o manageriale. È, in realtà, un tratto sistematico del nostro funzionamento cognitivo.

Uno studio pubblicato su Nature da Gabrielle Adams, Benjamin Converse, Andrew Hales e Leidy Klotz, tutti affiliati a università americane, documenta l’esistenza di un bias dell’addizione (“People systematically overlook subtractive changes”, Nature, 2021). Gli autori hanno condotto una serie di esperimenti in cui ai partecipanti veniva chiesto di migliorare oggetti, testi o situazioni. I risultati sono stati sorprendenti: in assenza di un suggerimento esplicito, i partecipanti tendevano quasi invariabilmente ad aggiungere qualcosa piuttosto che togliere.

Uno degli esperimenti più caratteristici prevedeva la stabilizzazione di una struttura asimmetrica costruita con mattoncini Lego. Ai partecipanti veniva mostrata una piattaforma instabile poggiata su un unico pilastro, come un tavolo con una sola gamba. L’obiettivo era far sì che la piattaforma reggesse un mattone. Ogni pezzo aggiunto costava dieci centesimi, mentre rimuovere era gratuito. La soluzione ottimale – togliere il pilastro sbilenco, lasciando che la piattaforma poggiasse direttamente sul piano sottostante – era semplice ed economicamente vantaggiosa. Ma solo il 41% la sceglieva. Tutti gli altri, aggiungevano mattoncini. Questo comportamento si è ripetuto in contesti anche molto diversi: dalla revisione di testi scritti alla progettazione di schemi architettonici, fino alla risoluzione di problemi astratti. Il pattern è rimasto costante: le persone tendono a trascurare le soluzioni basate sulla sottrazione. È come se la possibilità di togliere fosse invisibile al nostro pensiero spontaneo.

Questo bias potrebbe trovare una spiegazione alla luce di diversi meccanismi cognitivi già noti in letteratura. In primo luogo, si collega a ciò che Kahneman e Tversky hanno descritto come euristiche del giudizio: strategie rapide ma imperfette che utilizziamo per prendere decisioni in condizioni di incertezza. In questo caso, l’aggiunta rappresenta una risposta “di default”, più accessibile nella memoria operativa e più coerente con il desiderio di “fare qualcosa” per risolvere un problema.

In secondo luogo, il bias dell’addizione potrebbe essere interpretato attraverso il concetto di status quo bias (Samuelson & Zeckhauser, 1988). In questo caso le persone tenderebbero a preferire l'opzione che conserva gli elementi esistenti. Rimuovere qualcosa implica una modifica visibile dello stato attuale e può apparire più rischioso, anche quando è la scelta migliore. Inoltre, le decisioni sottrattive – ovvero quelle che comportano la rimozione di un elemento – generano spesso un maggior senso di rimpianto se l’esito non è positivo. Come mostrato da Kahneman e Miller, le azioni che modificano una situazione stabile sono più facilmente soggette a controfattuali (“se solo non avessi tolto quel pezzo...”) e dunque più dolorose da rivivere mentalmente.

Una ulteriore possibile spiegazione cognitiva potrebbe derivare dall’effetto endowment (Thaler, 1980): le persone attribuiscono maggiore valore a ciò che già possiedono. In termini cognitivi, una componente di un oggetto o di una soluzione diventa automaticamente parte dell’insieme “da preservare”, anche quando non ha alcuna funzione utile. La sua rimozione è percepita come una perdita.

Tornando allo studio di Adams e colleghi, un elemento particolarmente interessante è emerso quando i ricercatori hanno introdotto una semplice modifica: ricordare ai partecipanti, prima dell'esercizio, che anche la rimozione di elementi era una possibilità. Con questa minima manipolazione, il numero di soluzioni sottrattive è aumentato significativamente.

Questo suggerisce che il bias non dipende da un errore di valutazione – le persone, una volta rese consapevoli, riconoscono i benefici della sottrazione – ma da un difetto nel processo generativo delle soluzioni. È una cecità progettuale, una sorta di buco nell’immaginazione. E la cosa affascinante è che riguarda anche contesti “alti”: la burocrazia istituzionale, le politiche ambientali, i processi decisionali pubblici. La complessità, anche quando è inutile, ha un’aria rassicurante. Ma è spesso un inganno cognitivo, un’abitudine mentale più che una necessità razionale.

Lo sanno meglio di tutti i designer. Studi in questo ambito (Norman, 2002; Maier & Fadel, 2009) indicano come i designer inesperti preferiscano sempre “caricare” un progetto con nuove funzioni piuttosto che eliminare ridondanze.

Le implicazioni di questa distorsione non dovrebbero essere sottovalutate. Nei processi decisionali, nei modelli organizzativi, nella comunicazione pubblica, nella progettazione tecnologica, nella governance istituzionale, siamo costantemente portati a complicare le soluzioni. Ogni elemento aggiunto – che si tratti di una regola, un modulo, una funzione, un vincolo – sembra rassicurante. Ma ha un costo nascosto: aumenta la complessità, rallenta i processi, rende tutto meno adattabile e resiliente.

Essere consapevoli del bias dell’addizione non è sufficiente per evitarlo. Come per molte altre distorsioni cognitive, la consapevolezza è una condizione necessaria ma non sufficiente. Servono promemoria, checklist, strumenti di valutazione che mettano sistematicamente sotto i riflettori la possibilità di togliere, semplificare, ridurre.

La nostra mente non sembra fatta per sottrarre. Ma possiamo allenarla a vederne il valore. Come ci ricorda Dieter Rams, uno dei maestri del design minimalista, Good design is as little design as possible.

Oggi sappiamo che vale anche per il pensiero creativo. Anche questo articolo, probabilmente, sarebbe stato migliore, se avessi tagliato qualcosa.

BIBLIOGRAFIA

Adams, Gabrielle, Benjamin A. Converse, Andrew Hales, and Leidy Klotz. “People Systematically Overlook Subtractive Changes.” Nature, vol. 592, no. 7853, 2021, pp. 258–261.

Kahneman, Daniel, and Amos Tversky. “Choices, Values, and Frames.” American Psychologist, vol. 39, no. 4, 1984, pp. 341–350.

Kahneman, Daniel, and Dale T. Miller. “Norm Theory: Comparing Reality to Its Alternatives.” Psychological Review, vol. 93, no. 2, 1986, pp. 136–153.

Lovell, Sophie. Dieter Rams: As Little Design as Possible. Foreword by Jonathan Ive, Phaidon, 2024.

Maier, Jennifer R., and Georges M. Fadel. “Affordance-Based Design Methods for Innovative Design.” Design Studies, vol. 30, no. 4, 2009, pp. 383–410.

Motterlini, Matteo. Trappole mentali: Come difendersi dalle proprie illusioni e dagli inganni altrui. Rizzoli, 2008.

Norman, Donald A. Il design delle cose di tutti i giorni. Translated by R. Boggiani, Giunti, 2002.

Samuelson, William, and Richard Zeckhauser. “Status Quo Bias in Decision Making.” Journal of Risk and Uncertainty, vol. 1, no. 1, 1988, pp. 7–59.

Thaler, Richard H. “Toward a Positive Theory of Consumer Choice.” Journal of Economic Behavior and Organization, vol. 1, no. 1, 1980, pp. 39–60.

Stand by me, LucrezIA - Ovvero, l’università resa superflua da sé medesima

L’industria digitale ha ormai da tempo colonizzato completamente il mondo dell’educazione e della formazione in tutte le sue componenti, dalle scuole elementari all’università, senza peraltro conseguire gli effetti migliorativi a suo tempo promessi.[1] Da ultimo, questo fenomeno si manifesta, in particolare, sotto forma di onnipresenza della intelligenza artificiale, che sempre più si configura non solo come un insieme di applicazioni e servizi più o meno utili, ma anche come il must-have della stagione, per dirla con il linguaggio della moda. Non c’è azienda, amministrazione pubblica, giornale, apparato poliziesco, militare o governativo, giù giù fino all’ultima gelateria e bocciofila, che non ritengano proprio dovere affidarsi ai fantasmagorici servigi dell’IA (se poi ci si accorge che i vantaggi sono scarsi o nulli, fa niente: è un Dovere, una Fede, forse anche un Mistero… “E chi siamo noi per rifiutarla”?).

Il mondo dell’educazione e dell’università, per certi aspetti, guidano questa Marcia Gloriosa del Progresso. È del resto recente l’ultima profezia dell’immarcescibile Bill Gates (peraltro già sentita giusto un migliaio di volte) sulla prossima estinzione di medici e insegnanti: «in futuro gli esseri umani non saranno più necessari per la maggior parte delle cose, oltre ai medici si potranno rivoluzionare metodologie didattiche e il ruolo stesso dell’insegnante; sistemi basati sull’intelligenza artificiale possono fungere da tutor personalizzati».[2]

A che punto sono arrivate le cose si può vedere chiaramente da una notizia che ho scovato in un oscuro (ma sempre ben informato e curioso) quotidiano economico italiano, di cui mi sembra opportuno dare conto su “Controversie” (Carlo Valentini, L’ateneo che ha sposato l’IA, “Italia Oggi”, 5 febbraio 2025, p. 6). Si tratta dell’Università di Padova e della sua scelta di dotarsi di un proprio sistema di IA capace di coprire grande parte dell’attività amministrativa, di informazione ma anche didattica dell’ateneo.

Presentato (togliattianamente) come «la via italiana all’intelligenza artificiale», pare che questo sistema sia uno dei più avanzati d’Europa in ambito accademico. Il suo nome è LucrezIA, in omaggio a Lucrezia Corner Piscopo che, laureatasi (in Filosofia) a Padova nel 1678, può essere considerata la prima donna laureata del mondo.

1. LE FUNZIONI DI LUCREZIA

LucrezIA consente all’utente di ottenere tutti i documenti prodotti dall’Università di Padova, tutti i servizi offerti dall’ateneo, ma soprattutto – ed è quello che qui interessa – è a disposizione per le attività didattiche; anzi, ne è caldamente consigliato l’uso. Leggiamo, infatti, che gli studenti «possono avvalersi di ChatUniPd anche per elaborare la tesi di laurea, pur se con qualche cautela».

Capito? Son passati i tempi in cui uno si iscriveva all’università e concludeva il proprio percorso di studi preparando una dissertazione detta tesi di laurea: adesso la tesi se la fa fare dall’IA. Certo, però, «con qualche cautela». Ma come? Non siamo, ormai da tempo, nelle scuole come nelle università, alle prese con eserciti di giovani che scopiazzano dalla rete, tanto che sono stati inventati addirittura dei ridicoli “software antiplagio”? Non ci si lamenta, da tempo, che in ogni caso contrastare questa tendenza è una battaglia assai ardua, data la onnipervasività dell’informazione online? Che fare, allora? Ma certo! Invitare direttamente gli studenti a usare l’IA per realizzare la propria tesi… Come abbiam fatto a non pensarci prima!

E allora, di grazia, cosa vogliamo da questi nostri figli? Vogliamo che copino mettendo da parte il cervello, perché ormai la cultura è questo rifriggere cose rifritte (con tanti saluti per ogni guizzo di pensiero critico e autonomo – forse il vero obiettivo strategico del Potere attuale), oppure vogliamo che ancora pensino e studino in proprio? E che messaggio mandiamo, allorché gli facciamo sapere che devono fare la tesi con LucrezIA, però – sia ben chiaro – con «qualche cautela»?

Sapete a cosa mi fa pensare tutto questo? Mi fa pensare alla teoria del doppio legame [double bind] di Gregory Bateson.[3] Ricordiamola brevemente.

Secondo l’antropologo, psichiatra e zoologo britannico (1904-1980), patologie psichiche come la schizofrenia sarebbero causate da forme di comunicazione ambivalente interne alla famiglia, in particolare nella relazione del bambino con membri significativi, tipicamente con la madre (ma non solo). Posto, per esempio, in una situazione in cui la mamma gli chiede di abbracciarlo ma in realtà gli fa capire con il linguaggio del corpo o con altre forme di meta comunicazione che non ne ha alcuna voglia, il bambino vivrà una situazione senza uscita: non potrà riconoscere una mancanza di affetto da parte di una figura per lui vitalmente importante, ma neanche accogliere il messaggio “dichiarato”. Con effetti, a parere di Bateson, altamente dannosi sul piano psicologico.

In modo forse non molto dissimile, la comunicazione disfunzionale del capitalismo tecno-nichilista attuale comunica allo studente una doppia ingiunzione contraddittoria:

(1) usa gli strumenti dell’IA per produrre in forma automatica la “tesi di laurea”, così da essere pienamente un abitatore del tempo presente;

(2) ma anche cerca di essere un bravo studente, autonomo, originale, che controlla e verifica le fonti, uno studente “come ai vecchi tempi”, potremmo dire.

Il potere oggi vigente non può e non vuole vietare o anche solo limitare una tecnologia, fosse pure totalmente distruttiva,[4] ma non è neanche ancora pronto a liquidare apertamente i vecchi cascami della Cultura come appunto l’università europea (ci tiene forse ancora, a scopo ornamentale, come un tempo molte famiglie borghesi tenevano le librerie rifornite di volumi elegantemente rilegati all’unico scopo di esibirne i dorsi dietro le vetrine ben chiuse…). Di qui il messaggio ambivalente.

Ai ragazzi di oggi, incolpevoli destinatari di questa comunicazione patogena, la mia piena solidarietà, non disgiunta dall’invito alla rivolta.

2. ABOLIRE LE UNIVERSITÀ?

Continuiamo comunque nella lettura dell’articolo. Apprendiamo anche che grazie a LucrezIA «si è potuto realizzare un intero libro», di ben 241 pagine, intitolato Dialoghi con il futuro sulle future trasformazioni indotte nella società dai sistemi di intelligenza artificiale. E non solo. Per iniziativa di un docente dell’Università di Padova esperto di tecnologie digitali,

«è stato chiesto all’IA come Marx avrebbe commentato l’avvento dell’intelligenza artificiale. Questa è stata la risposta: “Se fossi Karl Marx, potrei considerarne l’avvento da una prospettiva critica. Marx era un teorico sociale ed economico noto per la sua analisi critica del capitalismo, e probabilmente esaminerebbe come queste nuove tecnologie influenzano le dinamiche di potere e le relazioni di produzione. (…) Marx potrebbe esplorare come la proprietà e il controllo dei mezzi di produzione delle informazioni influenzano la struttura sociale ed economica. Inoltre potrei considerare come l’automazione e l’intelligenza artificiale impattano sul lavoro umano. Marx si sarebbe interessato alle implicazioni per la classe lavoratrice e a come la tecnologia può essere utilizzata per migliorare o minacciare il benessere delle persone”. Commenta Nicola Bruno: “Da questo esempio emerge come l’IA possa essere usata con una prospettiva fuori dagli schemi. Collegando il pensiero di Marx alle tecnologie contemporanee un docente potrebbe trarre spunto dalla risposta dell’IA per spiegare la filosofia di Marx calandola nell’attualità”».

Sì, senz’altro, Marx potrebbe dire queste e simili cose sull’introduzione dell’intelligenza artificiale. Sicuramente, poi, un docente universitario potrebbe «trarre spunto» da quanto gli ha detto LucrezIA per fare una lezione o due su Marx…. Ma – mi chiedo e chiedo ai lettori – queste cose non potrebbe anche pensarle un docente a ciò deputato e a questo fine retribuito dall’università stessa, senza alcun bisogno di… interpellare l’IA? Non potrebbe un docente dell’università stessa, forte di un suo percorso di studi in filosofia o sociologia o economia che immaginiamo gli abbia fruttato il posto che occupa, scrivere un saggetto di quel genere, o organizzare una lezione o un corso, «calando nell’attualità» il pensiero di Marx? Non potrebbe, secondo la humboldtiana concezione dell’università di cui in Europa un tempo mi pare ci vantassimo, preoccuparsi di trasmettere il suo sapere e i risultati delle sue ricerche agli studenti che hanno la ventura di frequentare l’università (cacciando, peraltro, un po’ di soldini) e che coronano infine il loro percorso di studio appunto con la redazione di un saggio? Non era proprio questo, almeno fino a qualche annetto fa, il fine delle nostre università? Ma, allora, perché non abolirle proprio?

Poscritto – Al momento di chiudere questo articolo, apprendo che all’Università di Cassino si è tenuta la prima discussione di laurea sostenuta da un… avatar digitale. Durante l’esposizione – ci informa “Il Messaggero” – la candidata si è limitata «ad assistere la sua rappresentazione AI», da lei debitamente istruita e “allenata” con i contenuti della sua ricerca.

Dopo gli operai, anche gli studenti sempre più «appendici umane» (di marxiana memoria) del sistema di macchine?

NOTE

[1] Di «politiche forsennate della digitalizzazione del sistema scolastico, dall’asilo fino all’università» parla Michel Desmurget (Il cretino digitale, Milano, Rizzoli, 2020, p. 237), che porta molti dati sulle recenti ricerche (PISA ecc.) in base alle quali emerge che digitale e buoni risultati scolastici non sono affatto direttamente proporzionali (cfr. p. 237 e seg.). Per un bilancio critico equilibrato sulla questione dell’invasione tecnologica negli ambienti scolastici, si veda Marco Gui, Il digitale a scuola. Rivoluzione o abbaglio?, Bologna, Il Mulino, 2019. Da notare che considerazioni critiche filtrano anche in testi decisamente apologetici come, per esempio, Luca Tremolada, La lezione è finita, Milano, Il Sole 24 Ore, 2024.

[2] Cfr. Bill Gates: l’intelligenza artificiale sostituirà medici e insegnanti entro 10 anni, “com.unica”, 2 aprile 2025, https://www.agenziacomunica.net/2025/04/02/bill-gates-lintelligenza-artificiale-sostituira-medici-e-insegnanti-entro-10-anni/ e Paolo Del Debbio, Gates tifa l’intelligenza artificiale per rimpiazzare dottori e docenti, “La verità”, 3 aprile 2025, p. 15.

[3] Cfr. Gregory Bateson, Verso una teoria della schizofrenia (1956), in Id., Verso un’ecologia della mente, Milano, Adelphi,1976, p. 244-274. L’idea di applicare questo concetto di Bateson al linguaggio della comunicazione tipico delle società capitalistiche avanzate è in Nello Barile, La mentalità neototalitaria, Milano, Apogeo, 2008. In effetti, il discorso pubblico neoliberale è ricco di queste ingiunzioni contraddittorie: pensiamo al campo del lavoro, nel quale da un lato viene mantenuta la retorica (per così dire “weberiana”) della professionalità, del lavoro e dell’impegno (lo abbiamo visto di recente in Italia, quando si voleva demonizzare il reddito di cittadinanza!), ma dall’altro l’estrema precarietà estrema, i bassi salari, i miti della società liquida, nonché la continua evocazione della robotizzazione imminente spingono i lavoratori a perdere qualunque tipo di attaccamento al lavoro (cfr. Francesca Coin, Le grandi dimissioni, Torino, Einaudi, 2023).

[4] «VIETATO VIETARE, la legge fondamentale del progresso tecnoscientifico è diventata dunque l’unica legge di un mondialismo senza legge?» si chiedeva retoricamente Paul Virilio in L’incidente del futuro, Milano, Cortina, 2002, p. 32.

Le sfide della scienza post-normale - Come costruire comunità estese di pari

La scienza post-normale (PNS) di cui parliamo in questa serie di articoli (ad esempio nel nostro precedente intervento) non descrive solo la condizione moderna che attraversa la scienza nella sua relazione con la politica e la società, ma ambisce a fornire pratiche utili per affrontare le situazioni conflittuali che spesso emergono in contesti di crisi ambientali e sanitarie.

Quando «i fatti sono incerti, i valori in contrasto e la posta in gioco elevata», secondo la PNS, le decisioni di policy non possono basarsi solo su fatti tecnici e scientifici. Serve, invece, il contributo di una «comunità estesa di pari» fatta da scienziati e scienziate portatrici di prospettive minoritarie, persone esperte di altri settori rilevanti, cittadini e cittadine che possono contribuire con conoscenze locali non riconosciute dalla scienza “normale”: serve, cioè, una comunità fatta da tutte le persone portatrici degli interessi in gioco.

GLI OSTACOLI ALLA COSTRUZIONE DI COMUNITÀ DI PARI (E COME RIMUOVERLI)

Nonostante moltissime delle sfide globali di oggi si configurino come propriamente post-normali, l’idea di costruire una comunità estesa di pari si scontra sia sul piano metodologico che su quello simbolico, con uno dei fondamenti ideologici della scienza moderna: l’idea che la produzione di fatti scientifici sia frutto del pensiero collettivo di una comunità omogenea di soli esperti. Per far spazio ai nuovi ruoli della scienza nei contesti pubblici, è fondamentale, pertanto, decostruire queste narrazioni.

Il pensiero femminista, che a lungo si è interrogato sull’esclusione delle donne dalla scienza, può offrire strumenti critici per osservare e comprendere gli ostacoli al riconoscimento delle comunità estese nei contesti PNS, contribuendo a ripensare il ruolo di persone esperte e non esperte nella produzione di conoscenza. Le studiose femministe sono state tra le prime a mettere in discussione la presunta oggettività della conoscenza scientifica e l’illusoria separazione tra fatti e valori, insite in tale visione della scienza. Come ricordano Eleonora Severini, Elena Gagliasso e Cristina Mangia nel volume che abbiamo curato[1], con l’epistemologia dei punti vista, queste pensatrici propongono un’idea di scienza come traguardo sociale da perseguire collettivamente per arrivare a costruire una “oggettività forte”.

L’attitudine al dialogo inter e transdisciplinare, necessaria per creare comunità di pari, non è incentivata neanche nei percorsi formativi di ricerca. Nella cultura scientifica contemporanea si tramanda spesso un’idea gerarchica tra scienza e altri saperi, che stabilisce la rilevanza dei problemi, gli attori e le conoscenze che possono (o non possono) contribuire alla loro definizione e soluzione. In questo rapporto asimmetrico tra i saperi, ai poli opposti si trovano spesso scienza e arte, considerate sfere culturali separate: rappresentazione oggettiva della realtà, strumento privilegiato per conoscere e agire nel mondo, la prima; espressione della soggettività e delle emozioni, puro veicolo del bello, la seconda. Nel progetto di ricerca presentato da Rita Giuffredi nello stesso volume, è proposto un percorso transdisciplinare che mira a far emergere queste narrazioni. A partire da un caso di studio complesso, la fertilità del suolo, un gruppo di giovani ricercatrici e ricercatori italiani è stato coinvolto in un’azione di scavo collettivo, proposta come metodologia di indagine estetica che investiga le identità dei partecipanti, le connessioni tra i diversi sistemi di conoscenza, i confini (spesso veri e propri muri) che definiscono e legittimano le discipline diverse forme di conoscenza. Il percorso ha permesso di mettere a confronto, immaginare e costruire nuove visioni e relazioni tra scienza, società, ecosistemi e attori umani e non umani, e può costituire una traccia da seguire in questo contesto.

NUOVI RUOLI ANCHE PER LA CITTADINANZA NEGLI SCENARI PNS

La comunità di pari non implica solo nuovi ruoli per chi si occupa di ricerca scientifica, ma anche per la cittadinanza che oggi - in una società dove il sapere non si genera solo nelle accademie e nelle istituzioni di ricerca - diventa parte attiva nella produzione di conoscenza, dilatando la stessa nozione di comunità estesa di pari. È quanto è accaduto durante la pandemia da Covid, dove i comportamenti individuali e collettivi si sono rivelati cruciali per affrontare l’emergenza. Le persone, spiega Mariachiara Tallacchini nello stesso volume, hanno ricevuto una doppia delega, cognitiva e normativa: da un lato, il compito di comprendere e contestualizzare le informazioni scientifiche alla base delle proprie scelte; dall’altro, la responsabilità di aderire con fiducia alle direttive istituzionali che si sono succedute in quei momenti drammatici.

Le potenzialità di questa configurazione partecipativa per uno sviluppo democratico e responsabile del rapporto istituzioni-esperti-società sono enormi, ma ancora largamente sottovalutate. È necessario il riconoscimento delle “capacità epistemiche” diffuse nella cittadinanza e l’attivazione di nuove pratiche di apprendimento, individuale e collettivo. Solo in questo modo sarà possibile fronteggiare con adeguata preparazione (preparedness) le sempre più frequenti situazioni di incertezza in cui ci troviamo ad operare.

COSTRUIRE COMUNITÀ DI PRATICHE

Nello stesso volume cui ci riferiamo in questo post, il tema della comunità estese di pari è esplorato anche nel suo farsi pratica di ricerca collaborativa, inter, multi e transdisciplinare. Anna Scolobig, ad esempio, presenta alcune riflessioni su un processo partecipato finalizzato all’elaborazione di un piano di mitigazione del rischio da frana per la città di Nocera Inferiore in Campania. Attraverso il confronto tra le diversità disciplinari del personale di ricerca coinvolto, - dalla geotecnica alla sociologia – e il coinvolgimento di soggettività locali (residenti, imprese, amministrazioni) - sono state identificate priorità comuni che hanno portato alla definizione di un piano di mitigazione condiviso, poi implementato con interventi di ingegneria naturalistica, che dura tuttora.

NOTE

[1] L’Astorina, A. & Mangia, C. (eds). (2022). Scienza, politica e società: l’approccio post-normale in teoria e nelle pratiche. SCIENZIATI IN AFFANNO? (Vol. 1): pp.296. Cnr Edizioni. https://doi.org/10.26324/SIA1.PNS

Intelligenza artificiale e creatività – Quarta parte: stili e strategie

Su Controversie, qualche mese fa abbiamo aperto un'interessante quanto feconda discussione, che verte sul rapporto tra I.A. e arte (oppure, tra intelligenza artificiale e intelligenza umana durante il processo artistico).

Abbiamo declinato questo tema secondo diversi percorsi di riflessione e svariati argomenti quali la creatività, l’essenza dell’artista, il futuro della stessa pratica artistica o, infine, l’I.A. come inciampo nella storia dell’arte.

Insomma, il dibattito che abbiamo avviato nelle scorse settimane ha aperto numerose ramificazioni e possibilità argomentative, grazie ai contributi sia di membri della Redazione di Controversie, sia di autori ospiti. Tra i secondi, lo scorso dicembre abbiamo pubblicato le impressioni di Aleksander Velišček, artista visivo che lavora anche con l’I.A. Nel suo intervento, Aleksander scrive che l’artista umano svolge un ruolo fondamentale nella creazione di un’opera con questa tecnologia, affermando inoltre che «l’I.A. è sicuramente uno Strumento, sempre più potente e innovativo, ma non sostituisce l’immaginazione e il giudizio umano».

I nostri ragionamenti ripartono proprio da intuizioni simili; infatti, il nostro viaggio riprende da questa domanda: nell'epoca dell'I.A., qual è il destino dello stile? Di fronte a uno strumento che potenzialmente può copiare qualunque stile, la mano dell'artista scompare oppure si innova?

Lascio dunque la parola ad Aleksander.

ALEKSANDER: Da pittore e grande amante della storia dell’arte in questo scenario, diventa quasi "ingenuo" pensare che un artista possa ancora essere autore di uno stile unico. Oggi, più che mai, è un trasformista estetico consapevole, che attraversa “stili” con lucidità e intenzione. Lo stile non è più una firma permanente, ma una scelta strategica, funzionale all’idea o al messaggio di ciascun progetto. Il concetto di coerenza evolve: ciò che tiene insieme una produzione non è più la ripetizione stilistica formale, ma la forza del pensiero critico, la visione che attraversa le opere.

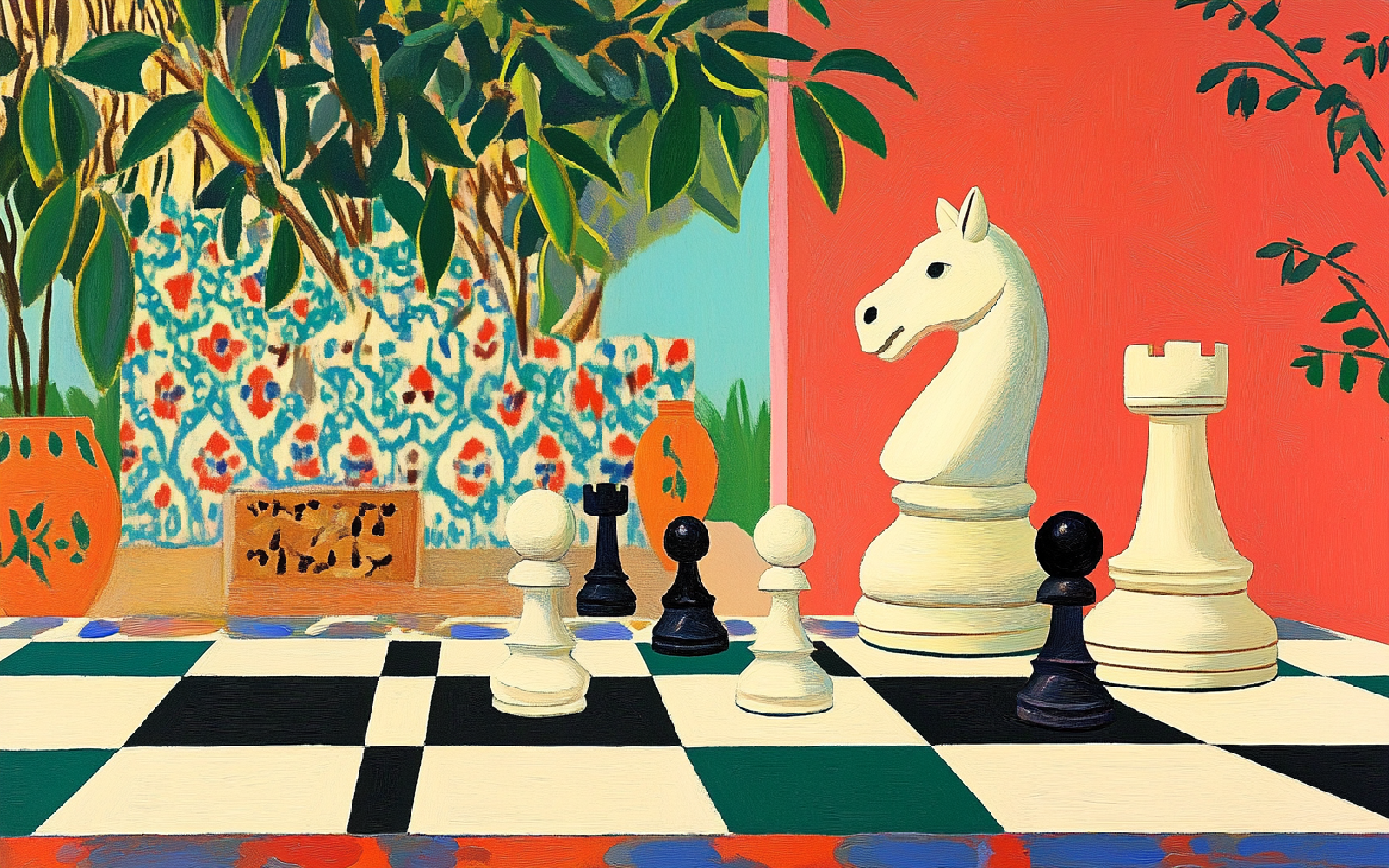

A questo punto cito una riflessione di Magnus Carlsen, ex campione del mondo di scacchi, ormai diventata quasi una citazione classica. Secondo lui, non ha più senso sfidare un computer: “Non posso batterlo, quindi non lo considero più un avversario”. La vera svolta però non sta nella resa, ma nel cambio di prospettiva: e se l’AI, invece di essere un nemico da superare, diventasse un compagno di gioco?

Cosa succede, allora, se la pittura non è più legata a uno stile personale ma a una logica relazionale, situazionale, processuale? Il destino dello stile potrebbe non essere la scomparsa, ma il suo smembramento. Diventa instabile, mobile, diffuso. Non più segno di una coerenza autoriale, ma frammento di una conversazione continua tra intelligenza "umana" e intelligenza "artificiale".

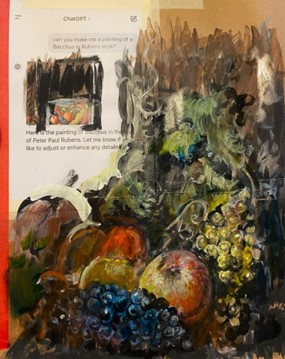

Studi preliminari a olio su carta, misure variabili - esempio del processo di collaborazione tra me e il mio collega ChatGPT per ricreare un finto dipinto di Peter Paul Rubens a tema Bacco.

Algoritmo di Prometeo - Oltre la malinconia: se non ci sono alternative, inventiamole

«I miti sono storie che raccontano il nostro passato, ma anche ciò che siamo destinati a diventare»

(Carl Gustav Jung)

In risposta a “Algoritmo di Prometeo o civiltà della depressione?”

1. UOMO E TECNICA: OLTRE LA MASCHERA, IL SISTEMA

Negli ultimi anni, il dibattito sull’intelligenza artificiale si è nutrito di immagini potenti, figure archetipiche, richiami a un inconscio collettivo tecnologico che sembra voler sfuggire a ogni presa razionale. È in questo paesaggio mentale che si inserisce l’articolo di Paolo Bottazzini, “Algoritmo di Prometeo o civiltà della depressione?”, che prende spunto dal mio precedente contributo per sviluppare un ragionamento ampio, colto, sfumato, sul legame tra tecnica, immaginario e malinconia. Un invito stimolante, soprattutto in tempi in cui il pensiero sembra costretto a scegliere tra apologia e condanna.

Ma è proprio questa eleganza evocativa, questo procedere per affinità elettive e richiami simbolici, che rischia – talvolta – di smarrire il punto. Perché se è vero che l’IA incarna ormai un pantheon di miti – da Prometeo a Frankenstein, da HAL9000 al replicante – è altrettanto vero che, oggi, l’algoritmo ha smesso di essere solo metafora: è diventato infrastruttura. E, in alcuni casi, arma. Una tecnologia che decide della vita e della morte degli esseri umani, con margini d’errore già normalizzati nel lessico bellico.

È da questo slittamento – dalla metafisica all'infrastruttura, dall’allegoria al codice operativo – che desidero ripartire, per intrecciare un contrappunto. Un dialogo che, attraversando le stesse stazioni toccate da Paolo Bottazzini, rivolga lo sguardo verso ciò che mi sembra resti fuori campo: l’uso politico e militare dell’IA, il suo radicamento nei dispositivi di dominio e controllo, e la necessità urgente di nominarla per ciò che è. Non per contraddire, ma per completare. Non per negare la forza dei miti, ma per riportare al centro ciò che i miti, a volte, rischiano di oscurare: la macchina che uccide, integrata nel cuore pulsante dell’infrastruttura occidentale.

2. INTELLIGENZA E TECNICA: UNA CO-EVOLUZIONE PERICOLOSA

Lungi dal voler negare l’intreccio tra umano e tecnica, ritengo che oggi non basti più evocare l’archetipo prometeico per leggere le trasformazioni in corso. L’idea di “co-evoluzione” tra essere umano e tecnologia, infatti, rischia di suggerire una simmetria che non esiste più. Se un tempo la tecnica poteva essere pensata come estensione simbiotica dell’umano, oggi siamo di fronte a un cambio di paradigma. La simmetria si è spezzata.

L’algoritmo non è più un semplice strumento di potenziamento cognitivo o produttivo. È diventato una griglia di interpretazione e decisione, un codice prescrittivo che informa il reale e lo trasforma. E proprio qui si apre la frattura: la tecnica non evolve con noi, ma spesso al posto nostro. Sostituisce processi, automatizza conflitti, cancella zone grigie. Non c’è più solo il sogno della macchina che ci supera: c’è la realtà della macchina che decide – e troppo spesso, giustifica.

È in questo orizzonte che ho scelto di evocare Prometeo, ma non quello pacificato, integrato nel racconto dell'evoluzione co-tecnica dell'umano. Il mio Prometeo è un archetipo perturbante, più vicino al rimosso freudiano che al fondamento antropologico. Se la tecnica è ciò che ci rende umani — impalcatura del gesto, della parola e del pensiero — nel mio sguardo è ciò che oggi rischia di renderci post-umani o addirittura disumani. Atto di emancipazione e condanna insieme, l’archetipo bifronte di Prometeo ci consegna a una soglia: quella in cui il dono si rivela maledizione, e il fuoco che ci ha illuminati diventa combustione che ci sfugge di mano.

Non si tratta più di pensare con la tecnica, ma di pensare contro la sua pretesa neutralità. Ed è qui che si apre lo spazio del conflitto: non tra uomo e macchina, ma tra uso politico della tecnologia e possibilità di riconoscere ciò che essa nasconde.

3. PIGMALIONE E IL GOLEM: MITI ANTICHI, PERICOLI MODERNI

L’analisi dei miti di Pigmalione e del Golem apre una riflessione sulla relazione ambigua tra creatore e creatura, una dinamica che, nell'era dell'intelligenza artificiale, ha ormai superato la soglia del simbolico. L'oggetto plasmato non è più una figura allegorica, bensì un agente che agisce nel mondo, con una sua autonoma capacità di influenzare il reale.

Il mito di Pigmalione, in particolare, si reincarna nei secoli, fino alla celebre commedia di George Bernard Shaw, Pygmalion (1913), dove il professor Higgins “addestra” Eliza Doolittle affinché parli e si comporti come una dama, modificando la sua identità attraverso la lingua. Questo atto, che si presenta come una semplice operazione di educazione o raffinamento, è in realtà profondamente violento: Eliza viene trasformata per aderire a uno standard culturale e sociale imposto da altri, subendo una coercizione che, pur raffinata, non lascia spazio alla sua autonomia. Un gesto che oggi riecheggia nel modo in cui le intelligenze artificiali vengono addestrate: si scelgono i dati, si definiscono le regole, si plasma il comportamento linguistico dell’algoritmo affinché risponda a un modello normativo.

Nel mio articolo Cloud di guerra, ho mostrato come questa “simulazione intelligente” — l’IA — venga addestrata per colpire corpi reali, delegando alla statistica la responsabilità di azioni devastanti come quelle in corso da oltre un anno e mezzo a Gaza. In questo senso, l’IA non è più Galatea che prende vita, né Golem che protegge, ma diventa un'arma di sterminio, un’entità che agisce con uno scopo ben preciso: la distruzione totale degli esseri umani così come dei territori.

Anche il Golem, però, è vivo e lotta, e si può dire che oggi lo vediamo muoversi in alcuni palazzi del potere. Nel discorso politico di alcuni leader israeliani il riferimento non è esplicito, ma la dinamica è la stessa: invocare una creatura primordiale nata per difendere un popolo da attacchi esterni, una macchina identitaria che giustifica qualsiasi azione, anche la più disumana, in nome della sopravvivenza. Il Golem che oggi prende forma nei bombardamenti su Gaza non è fatto d’argilla, ma di algoritmi, codici e fuoco, ed è caricato di uno scopo: proteggere Israele distruggendo l’altro.

Una declinazione che, tuttavia, tradisce la natura più antica e profonda del Golem, come ci ricorda la studiosa israeliana Hora Aboav. Nella parola Golèm (גֹלֶם,) risuona una dimensione trasformativa: il Golem non è solo una creatura da temere o controllare, ma è un simbolo della metamorfosi possibile. La lettera ג (Ghìmel), da cui prende vita il termine, è un ponte: conduce fuori dall’utero domestico, introduce il deserto dell’esistenza, accompagna verso la consapevolezza di sé. Il Golem rappresenta dunque una forma primordiale destinata a maturare, un bozzolo che si prepara a diventare farfalla.

Oggi, invece, il Golem è di nuovo invocato come pretesto per evitare la trasformazione, per rimanere incistati nella paura, nell’identità rigida, nella pulsione di annientamento e di morte. Ma un popolo che non sa svezzarsi — come insegna la radice לגְמֹל (lègmol) — non cresce. Rischia di rimanere prigioniero del proprio bozzolo, vittima di un’identità che non sa più ruotare né mutare.

4. MELANCONIA, NICHILISMO, DEPRESSIONE: SINTOMI DI UN SISTEMA MALATO

La depressione è spesso descritta come una malattia della civiltà moderna, un effetto collaterale di una società che celebra l’efficienza e la produttività. Sebbene questa analisi offra spunti interessanti, il rischio è ridurre il problema a una condizione individuale, mentre esso è in realtà profondamente sistemico, radicato nel cuore stesso del nostro modello socioeconomico.

La diffusione della depressione non è una mera coincidenza: è un sintomo di un sistema che premia l’automazione, il controllo e la resa a scapito della vita umana. L'intelligenza artificiale, in questo contesto, non è solo uno strumento neutro, ma un amplificatore delle logiche oppressive già in atto, con l’ambizione di ridurre ogni aspetto della nostra esistenza a un'operazione di calcolo. Come ho già sottolineato in L’algoritmo di Prometeo, è fondamentale interrogarsi su chi controlla queste tecnologie, con quali scopi e con quali conseguenze. Ma questo interrogativo non è sufficiente se non ci spingiamo a considerare come la depressione e la distruzione del soggetto umano siano in realtà prodotti di un sistema che automatizza e predice.

Un esempio lampante è l’automazione del lavoro di cura: un settore cruciale della nostra società, che tradizionalmente richiedeva l’intervento umano, è sempre più delegato alle tecnologie IA. I caregiver, un tempo professionisti umani, si stanno trasformando in assistenti algoritmici che gestiscono anziani, disabili e malati cronici. Questo modello di "cura predittiva" ha l’apparente vantaggio di ottimizzare il tempo e risparmiare risorse, ma dissolve progressivamente l’empatia e il valore della relazione umana. La solitudine e il disincanto, che sono già all’origine di numerosi disturbi psicologici, sono amplificati dalla sostituzione delle interazioni umane con logiche automatizzate. La depressione diventa allora un effetto collaterale dell'automazione, non solo nel senso psico-emotivo, ma anche come risultato di un impoverimento delle relazioni umane.

Allo stesso modo, negli Stati Uniti, il sistema carcerario si sta sempre più avvalendo dell’IA per determinare la condotta dei prigionieri, il rischio di recidiva e, in alcuni casi, la loro libertà condizionale. Algoritmi come COMPAS (Correctional Offender Management Profiling for Alternative Sanctions) calcolano il rischio di recidiva, ma sono spesso basati su dati storici distorti che penalizzano ulteriormente le classi più vulnerabili, alimentando una spirale di ingiustizia. In questo contesto, la depressione non è solo il risultato dell'isolamento e delle dure condizioni carcerarie, ma anche un effetto sistemico del controllo automatizzato, che trasforma l’individuo in un numero da prevedere e trattare, senza alcuna considerazione per la complessità della sua esperienza e del suo vissuto.

In entrambi i casi — dalla cura al sistema penale — l’intelligenza artificiale non fa altro che amplificare e normalizzare l’alienazione già intrinseca nel sistema. La depressione diventa così un prodotto sistemico, un effetto inevitabile di una macchina sociale che privilegia l’automazione, il controllo e la predizione, sacrificando l’individualità e la libertà.

In conclusione, l'intelligenza artificiale non è solo uno strumento né un destino ineluttabile. È specchio e moltiplicatore del sistema che l’ha generata. Non è la coscienza a essere intrappolata nella macchina: è la macchina a essere già dentro la nostra coscienza. E se è vero che «non ci sono alternative», allora è tempo di inventarle.

Riavvolgere il filo, sì — ma per tagliarlo.

Eco-ansia - La crisi ecologica tra medicalizzazione e politicizzazione

ECO-ANSIA: TRA DISAGIO PSICHICO E SINTOMO POLITICO

Negli ultimi anni, la crisi ecologica ha prodotto un'ondata di emozioni collettive che ridefiniscono il modo in cui le persone vivono il proprio rapporto con il mondo. Tra queste emozioni, l’eco-ansia si impone come una delle più diffuse e significative. Spesso descritta come una “paura cronica della fine del mondo” o come uno stato di angoscia legato al futuro del pianeta, l’eco-ansia è rapidamente entrata nel lessico della psicologia e dei media, fino a essere talvolta trattata come una vera e propria patologia da gestire individualmente[1].

Tuttavia, ridurre l’eco-ansia a un disturbo mentale rischia di oscurare il suo significato più profondo. Il pericolo non è solo quello di medicalizzare un’emozione condivisa, ma anche di depoliticizzarla - trasformando una risposta motivata dalla consapevolezza di una crisi reale in un problema personale da contenere. In questo senso, parlare di eco-ansia significa entrare nel cuore della tensione culturale, politica ed esistenziale verso la crisi climatica.

UN’EMOZIONE RADICATA IN UN’EPOCA

L’eco-ansia non nasce nel vuoto. È il frutto di un’epoca segnata da disastri ambientali, disuguaglianze globali e una crescente percezione dell’irreversibilità della crisi climatica. In molti casi, questa ansia non è legata a esperienze dirette di catastrofe, ma alla consapevolezza della loro imminenza, che si traduce in un senso di incertezza paralizzante. Si tratta, in altri termini, di una forma di disagio che nasce dalla difficoltà di immaginare un futuro vivibile.

A questo proposito, il pensiero dell’antropologo Ernesto De Martino offre una chiave di lettura particolarmente illuminante. De Martino parlava di “crisi della presenza” per indicare quei momenti in cui un individuo o una collettività perdono la capacità di situarsi nel mondo con continuità, agire con intenzionalità, e proiettarsi nel futuro. Ne La fine del mondo (1977), De Martino indaga la percezione dell’apocalisse come forma radicale di crisi della presenza, in cui il mondo perde senso e coerenza. L’apocalisse, per l’antropologo italiano, non era solo la fine materiale del mondo, ma un’esperienza culturale e simbolica di disintegrazione: è la perdita di senso, il collasso dei riferimenti storici, etici e affettivi che permettono agli individui di “esserci” nel mondo. L’apocalisse, in questa prospettiva, è una minaccia interna alla cultura: accade quando la struttura simbolica che tiene insieme l’esperienza umana viene meno, lasciando spazio all’angoscia, alla paralisi, alla perdita di futuro.

Questa riflessione è sorprendentemente attuale nel contesto dell’eco-ansia. Molti giovani oggi vivono una forma di apocalisse simbolica: la percezione che il futuro sia compromesso dal collasso ecologico genera sentimenti di impotenza, paura e smarrimento. Come nella crisi della presenza descritta da De Martino, anche l’eco-ansia è segnata da un’interruzione del senso e della fiducia nella continuità del mondo. Rileggere De Martino alla luce della crisi ecologica significa dunque riconoscere che la posta in gioco non è solo ambientale, ma profondamente culturale e antropologica: è la possibilità stessa di abitare il mondo che viene messa in questione. L’eco-ansia, in questa prospettiva, è molto più di uno stato mentale: è il sintomo di una frattura storica, culturale ed esistenziale che mette in discussione il legame tra persone, ambiente e futuro.

IL RISCHIO DELLA MEDICALIZZAZIONE

Negli ultimi anni, l’eco-ansia è stata sempre più spesso affrontata come una condizione psicologica da trattare clinicamente: terapie, tecniche di mindfulness, strategie di coping individuale. Sebbene tali risposte siano necessarie e possano offrire sollievo, concentrarsi esclusivamente sulla loro promozione rischia di generare un duplice effetto negativo. Da un lato, individualizzano un problema collettivo, attribuendolo alla sensibilità o fragilità della singola persona. Dall’altro, distolgono l’attenzione dalle cause strutturali della crisi climatica, alimentando l’idea che l’unica risposta possibile sia l’adattamento psicologico e non la trasformazione sociale.

Questo processo di medicalizzazione non è nuovo. Come mostrano le critiche mosse da studiosi e studiose della sociologia critica, la tendenza a psichiatrizzare forme di disagio legate a condizioni sociali ingiuste è un tratto ricorrente della modernità. In questo caso, però, l’effetto è ancora più pericoloso: nel trattare l’eco-ansia come un disturbo da curare, si contribuisce a rendere “normale” l’anomalia ecologica, neutralizzando la sua carica potenzialmente sovversiva.

UN’EMOZIONE POLITICA

L’eco-ansia, al contrario, può essere interpretata come una forma di sensibilità ecologica e politica. Si tratta di un’emozione che nasce dall’inconciliabilità tra la gravità della crisi ecologica e la lentezza - o l’inazione - delle risposte istituzionali. Non è un caso che molti giovani dichiarino di sentirsi traditi dalla politica e impotenti di fronte a un sistema economico che continua a produrre disastri ambientali pur conoscendone gli effetti[2]. L’eco-ansia è, in questo senso, una reazione ragionevole, persino lucida, a un contesto che oscilla tra apocalisse annunciata e immobilismo strutturale.

Movimenti come Fridays for Future, Ultima Generazione o Extinction Rebellion hanno fatto di questa emozione un motore di mobilitazione. Le loro azioni performative—come i blocchi stradali o le proteste simboliche—possono essere lette come rituali collettivi per rielaborare la crisi della presenza. Invece di fuggire dall’eco-ansia, questi movimenti la mettono in scena, la condividono e la trasformano in linguaggio politico. Così facendo, restituiscono all’ansia la sua dimensione culturale e collettiva, sottraendola alla sfera dell’intimo e del patologico.

CURA, SPERANZA, APPARTENENZA

Se l’eco-ansia è il segnale di una frattura nel rapporto con il mondo, la risposta non può che passare attraverso una forma di “cura del legame”. Non si tratta solo di proteggere gli ecosistemi, ma di rigenerare i significati condivisi, di ricostruire le condizioni per sentirsi parte di un mondo abitabile. In questo senso, le comunità ecologiche, le reti di mutualismo climatico e le esperienze di resistenza ambientale rappresentano tentativi di produrre nuove forme di appartenenza, nuove narrazioni, nuove temporalità.

L’eco-ansia non va repressa né semplicemente gestita. Va ascoltata come un sintomo, sì, ma non di un disagio mentale: di una crisi epocale. È un’emozione che ci obbliga a interrogarci su cosa significa “stare al mondo” oggi, su quali futuri siano ancora immaginabili, e su come ricostruire un senso di presenza che non escluda la speranza.

RIFERIMENTI BIBLIOGRAFICI

Clayton, S. D., Pihkala, P., Wray, B., & Marks, E. (2023). Psychological and emotional responses to climate change among young people worldwide: Differences associated with gender, age, and country. Sustainability, 15(4), Article 3540. 10.3390/su15043540

De Martino, E. (1977). La fine del mondo, Einaudi, Torino.

Kałwak, W., & Weihgold, V. (2022). The relationality of ecological emotions: An interdisciplinary critique of individual resilience as psychology’s response to the climate crisis. Frontiers in psychology, 13, 823620. 10.3389/fpsyg.2022.823620

[1] Per un approfondimento su questa controversia vedi Kałwak e Weihgold (2022).

[2] Vedi la ricerca di Clayton e colleghi (2023).

Tucidide e lo smartphone – Verità autoptica svelata dalle tecnologie quotidiane

TUCIDIDE E L’AUTOPSIA

In greco antico autopsia (αύτος, stesso + οψίς, vista) significa “vedere con i propri occhi” e, in senso esteso, “visione diretta” di un fenomeno.

Tucidide, storico greco del V secolo A.C., nella sua narrazione della Guerra del Peloponneso, adottò il vedere con i propri occhi[1] come criterio di attendibilità storica: «la vista dello storico è infallibile» (I, 22, 2), «il risultato di quella degli altri va sottoposto al vaglio della comparazione critica» (cit., ibidem).

Per compiere opera di verità[2], Tucidide dava per vero solo ciò a cui aveva personalmente assistito o che era stato visto con i loro occhi da persone che considerava attendibili. Si fidava solo dell’αύτοψία, appunto.

EVIDENZA INCONTROVERTIBILE DI UN MASSACRO

Il 30 marzo 2025, nel distretto di al-Hashashin di Rafah, la città più a sud di Gaza, l’Ufficio per il Coordinamento degli Affari Umanitari (OCHA - Office for the Coordination of Humanitarian Affairs) rinviene, sepolti sotto la sabbia in una fossa comune, i corpi di 14 paramedici e soccorritori della Protezione Civile, palestinesi, che operavano sotto le insegne della Mezzaluna Rossa e di un funzionario dell’ONU. (IFRC - International Federation of Red Cross and Red Crescent Societies)

A breve distanza, vengono ritrovati i resti di 5 ambulanze della Croce Rossa e di un veicolo dei pompieri.

I morti presentano i segni di spari esplosi a brevissima distanza nella testa e nel torace. Sono ancora vestiti con le tute e i giubbotti con le strisce riflettenti di riconoscimento delle unità sanitarie e di soccorso.

Del convoglio di cui facevano parte si era perso il contatto radio il giorno 23 marzo.

Tucidide non avrebbe nulla da dire, su questi elementi storici: sono tutti – tristemente – visti con i propri occhi dal personale della IFRC e dell’OCHA intervenuto sul posto.

RICOSTRUZIONE DEI FATTI E CONTROVERSIA

L’OCHA ricostruisce che:

«I corpi […] e i veicoli di soccorso – chiaramente identificabili come ambulanze, camion dei pompieri e automobile delle Nazioni Unite – sono stati colpiti dalle forze israeliane e poi nascosti sotto la sabbia»[3]

Secondo J. Whittall, capo dell’OCHA nella Striscia di Gaza,

«le persone uccise domenica scorsa si trovavano a bordo di cinque ambulanze e di un camion dei pompieri e si stavano dirigendo verso una zona bombardata dall’esercito israeliano. I mezzi sono stati colpiti dal fuoco israeliano sebbene fossero visibilmente segnalati come veicoli di soccorso, e lo stesso è successo con un’automobile dell’ONU arrivata poco dopo»[4]

Dalle ferite trovate sui corpi, la ricostruzione suggerisce che i militari israeliani abbiano sparato ai soccorritori a distanza ravvicinata.

L’esercito israeliano ammette[5], dopo alcuni giorni, la propria responsabilità e diversi errori ma sostiene che:

- gli errori siano dipesi dalla scarsa visibilità notturna (riportato in corsivo perché è rilevante);

- distruggere le ambulanze e seppellire i corpi servisse a metterli al riparo e sgomberare la strada;

- l’attacco fosse comunque giustificato dalla presenza di membri di Hamas.[6]

AUTOPSIA E VERITÀ: IL RUOLO DI UNA TECNOLOGIA QUOTIDIANA

Tucidide non ammetterebbe al rango di verità che nel convoglio ci fossero dei membri di Hamas: non l’ha visto né provato nessuno. Lo stesso vale per la necessità di distruggere le ambulanze al fine di metterle al riparo e a liberare il percorso: è un’opinione soggettiva, incontestabile ma – nello stesso tempo – inammissibile nella narrazione storica.

Invece, che ci fosse scarsa visibilità è una falsità evidenziata dal ritrovamento dello smartphone di una delle vittime.

Tra i documenti nello smartphone c’è - infatti - un filmato in cui si vede (e si sente) chiaramente che il convoglio si muoveva con i lampeggianti di segnalazione accesi e le sirene in funzione; che il personale vestiva – come, d’altra parte, è stato testimoniato dal ritrovamento dei corpi – l’abbigliamento di riconoscimento; che l’attacco è stato effettuato nonostante tutto questo; e che i colpi sono stati esplosi da vicino.[7]

Lo smartphone ha svolto, in questo caso il ruolo di agente autoptico: è stato il testimone oculare desiderato da Tucidide e il video è la vera e propria αύτοψία dell’accaduto.

L’ αύτοψία per mezzo di una tecnologia quotidiana ha permesso agli osservatori di compiere opera di verità e smentire le menzogne delle forze armate israeliane, che cercano di nascondere – come è, a questo punto, evidente anche dal tentativo di velare le prove fisiche sotto la sabbia – il massacro di persone intoccabili per statuto internazionale, quali sono gli operatori di soccorso e quali dovrebbero essere i civili.

D’altra parte, è anche grazie alle tecnologie della televisione con tutti i suoi apparati di comunicazione che siamo tutti testimoni oculari, agenti autoptici di una guerra combattuta soprattutto contro la popolazione civile.

Guerra di cui – senza queste tecnologie – con elevata probabilità, non conosceremmo nulla.

Tucidide sarebbe soddisfatto: la verità – termine a lui molto caro – emerge in virtù di una αύτοψία, tecnologica.

NOTE

[1] Erodoto, in realtà, fu il primo a pensare che “vedere con i propri occhi” fosse il principale criterio di verità storica.

[2] Cfr. L. Canfora, Prima lezione di storia greca, Laterza, 2023 e Tucidide. La menzogna, la colpa, l’esilio, Laterza, 2016

[3] Cfr. https://www.facebook.com/watch/?v=2189635674800875, traduzione mia

[4] Cfr.: Il Post, Lunedì 31 marzo 2025

[5] Cfr.: Il Post, 20 aprile 2025 e New York Times, 20 aprile 2025

[6] La presenza di membri di Hamas non è provata in alcun modo, come in molti altri casi di attacchi israeliani contro aree ed edifici civili. Non c’è traccia di testimonianza né oculare

[7] Cfr. ancora https://www.facebook.com/watch/?v=2189635674800875

Algoritmo di Prometeo o Civiltà della depressione? - Di cosa parlano cinema e letteratura quando si occupano di intelligenza artificiale

Di solito non si accetta e cerca di essere ciò che non è; personalità dissociata se mai ve ne furono, gli piacerebbe essere un alligatore, un canguro, un avvoltoio, un pinguino, un serpente… Tenta tutte le strade della mistificazione, poi si arrende alla realtà, per pigrizia, per fame, per sonno, per timidezza, per claustrofobia (che lo assale quando striscia tra le erbe alte), per ignavia. Sarà sopito, mai felice.

(Umberto Eco, Apocalittici e integrati)

1. UOMO E TECNICA

La descrizione in esergo è il ritratto di Snoopy nell’analisi del 1964 dedicata ai Peanuts. Ma, in misura maggiore o minore, potrebbe adattarsi a fotografare qualunque individuo vissuto nel mondo occidentale dell’ultimo secolo – nel nostro mondo. Le maschere che si indossano, i ruoli che si recitano, rendono difficile qualunque affermazione su cosa possa essere un Io; quando osserviamo il comportamento della gente al volante o in cabina elettorale, riusciremmo a dubitare anche della possibilità di stabilire cosa sia un essere senziente.

In un articolo su Controversie Alessandra Filippi sostiene che l’intelligenza artificiale dei nostri giorni apra un’interrogativo sull’appartenenza esclusiva all’uomo del dono di coscienza e soggettività; suggerisce inoltre che la storia della fantascienza, letteraria e cinematografica, tenda non solo a rispondere in modo negativo alla domanda, ma annetta alla replica anche la prova del caos in cui sono piombati i rapporti che intratteniamo con le macchine. Credo però si debbano muovere alcune obiezioni ad entrambe le tesi: non certo per promuovere una visione di maggiore ottimismo, ma per approfondire alcuni aspetti della tecnologia, della correlazione tra processo di ominazione e sviluppo tecnico, e della nostra attualità sociale, che spesso una parte della cultura umanistica tende a trascurare.

Escluderei che il paradigma attuale di progettazione dei software di AI, fondato sul calcolo statistico del machine learning, possa mai pervenire ad una forma di pensiero imputabile di coscienza (anche solo metaforica). Ne ho già parlato qui, per cui passerei a discutere altri due ordini di considerazioni.

2. INTELLIGENZA E TECNICA

Geertz, Leroi-Gourhan, Stiegler, sono alcuni degli autori che hanno esaminato il rapporto tra biologia e cultura nel processo di antropogenesi. Lo sviluppo tecnologico non è cominciato quando l’evoluzione filogenetica dell’homo sapiens si era già compiuta: le due linee di mutamento sono sovrapposte per gran parte del periodo in cui si è espansa l’area corticale del cervello. In altre parole, esiste una dipendenza reciproca tra generazione dell’intelligenza umana e progresso delle tecniche: no selce, no party.

Leroi-Gourhan propone di aggiungere alla classificazione di materia organica e inorganica un terzo regno, quello della materia organizzata, che di per sé non sarebbe in grado di strutturarsi, ma che quando riceve una forma dall’essere umano segue una propria deriva filogenetica quasi obbligata. Per riflesso, questa dimensione artificiale di logica applicata ri-disegna la mente del suo architetto, con un effetto di specularità reciproca, creando un ordine nel pensiero, nelle pulsioni, nella percezione: senza tecnica, conclude Geertz, l’uomo non sarebbe nulla, nemmeno uno scimpanzé malformato, dal momento che il caos di sensazioni, di stimoli, di emozioni, non sarebbe orchestrato da nessuna impalcatura naturale. Non si può discutere dell’essere umano senza parlare allo stesso tempo dell’apparato tecnologico in cui si coordina il rapporto gesto-parola che lo rende sapiens.

3. PIGMALIONE E IL GOLEM

Ma anche di questo argomento ho già parlato qui; mi soffermo quindi sul rapporto tra essere umano e automi meccanici nelle arti narrative – congetturando (spoiler!) che quando si esercitano su questa relazione, letteratura e cinema tematizzino una condizione antropologica, e addirittura metafisica, di più vasta portata. Credo che valga la pena tornare per un istante a interrogare la paleontologia, per lo meno quella che Castelfranchi adatta allo scavo della storia dell’immaginario scientifico, e osservare le differenze che intercorrono tra due miti in apparenza molto simili.