La cattura del regolatore - Come l’industria piega le regole alle proprie necessità

Per cattura del regolatore si intende quella pratica attraverso la quale un settore regolato dell’industria si impossessa del regolatore, e lo piega alle proprie necessità.

Per l’economista Ernesto Dal Bó, «la cattura del regolatore è quel processo attraverso il quale interessi particolari influenzano l’intervento dello stato in ciascuna delle sue forme, in aree diverse come l’imposizione di tasse, le scelte di politica estera o monetaria, o le leggi che regolano la ricerca e lo sviluppo».

L’attività regolatoria viene studiata in economia seguendo due diverse scuole di pensiero. La prima è quella dell’Interesse Pubblico e la seconda quella della Cattura del Regolatore.

Secondo la prima scuola il mercato fallisce nel conseguimento di politiche orientate al bene comune, per esempio per la formazione di monopoli, ed è quindi necessaria una istituzione, il regolatore appunto, che difenda i cittadini ed i consumatori.

All’estremo opposto la seconda scuola vede l'istituzione di un meccanismo di regolazione come il risultato di una cattura istituzionale: gli interessi industriali ed economici favoriscono essi stessi la creazione di un regolatore che li difenda dalla concorrenza. La seconda scuola non vede questa creazione come risultato di un fallimento dei mercati.

Il lettore italiano ricorderà il motto di Giovenale: ‘Quis custodiet ipsos custodes’, cioè chi custodisce i custodi, a significare che se il regolatore deve regolare, ci si deve accertare che non venga esso stesso regolato a seguito di un fenomeno di cattura.

Il fenomeno osservato da Giovenale nel secondo secolo dopo Cristo è probabilmente antico quanto lo stabilirsi di prime forme di controllo tese ad assicurare il corretto svolgimento della vita pubblica. Tanto ciò è vero che la cattura del regolatore viene considerata come ineluttabile in entrambe le scuole summenzionate.

George J. Stigler, esponente della scuola della cattura del regolatore, e uno dei padri fondatori della Chicago School of Economics, ritiene che «la regolamentazione viene richiesta principalmente dall’industria ed è disegnata ed operata principalmente per il beneficio della stessa». Questa teoria si occupa dei meccanismi che conducono a leggi di regolamentazione identificando i gruppi che traggono profitto dagli effetti redistributivi della legislazione medesima.

Anche per gli economisti Marver H. Bernstein e Beryl R. Crowe la cattura è ineluttabile. Questi prevedono l’esistenza di cicli, laddove una agenzia regolatrice viene creata inizialmente per rispondere ad un allarme o preoccupazione sociale, in seguito gruppi di interesse ben organizzati ne prendono il controllo con la conseguenza che l’operato dell’agenzia li favorisce. Nella fase finale del ciclo l’agenzia regolatrice fornisce rassicurazioni e soddisfazioni simboliche al pubblico mentre “l’attività e le decisioni giornaliere dell’agenzia contribuiscono, rafforzano e legittimano le richieste di piccoli ma ben organizzati gruppi".

In conclusione, per Stigler, meglio non creare affatto i regolatori e lasciare al mercato mano libera, nell’ottica di small government tipica della scuola di Chicago, mentre i sostenitori della regolamentazione insistono sulle strategie di controllo per evitare la cattura – quali ad esempio migliori compensi per i regolatori, maggiori controlli governativi e la creazione di gruppi di interesse pubblico fra i cittadini che si occupino di monitorare l’azione delle agenzie.

La cattura può anche essere culturale: in tal caso il regolatore non viene sedotto dalle offerte dei lobbisti, ma finisce per vedere il mondo come lo vedono i settori regolati. La scienza al servizio degli interessi privati può giocare un ruolo importante in questo tipo di cattura. Secondo alcuni, un caso evidente degli effetti della cattura culturale, politica e cognitiva è proprio l’ultima recessione, resa possibile dalla conquista delle autorità di supervisione finanziaria da parte delle banche medesime.

Un concetto più recente è quello del capitalismo della regolamentazione, come parte di un mondo globalizzato all’interno del quale l’esistenza di regole e standards favorisce il potere degli incumbents (cioè di coloro che dominano il mercato al momento dato) – si parla in questo caso anche di tragedia della mercificazione. Un esempio di questo tipo di evoluzione trova la sua dimostrazione nel passaggio della tutela della conoscenza da organizzazioni quali UNESCO e la UNCTAD all’Organizzazione per il Commercio Mondiale, World Intellectual Property Organization ed al GATT (General Agreement on Tariffs and Trade), dove la conoscenza è trattata come un bene privato da proteggere per consentirne il commercio.

Un importante caso di cattura è quello relativo alla scienza aperta, dove aspirazioni ad una democratizzazione della conoscenza sono state catturate dalla potente macchina lobbistica degli editori scientifici, finendo per aggravare disuguaglianze e squilibri globali nord-sud e favorire – a detta di alcuni – una ulteriore concentrazione del potere delle mani di pochi giganti del settore.

Seveso, 1976 - Il Comitato tecnico scientifico popolare attraverso le fonti orali e d’archivio

Nell’articolo Le nuvole scrivono il cielo di Seveso - Il crimine di pace, la scienza e il potere di qualche settimana fa avevo brevemente introdotto che cosa accadde il 10 luglio 1976 a Seveso-Meda, che cos’era l’Icmesa e alcuni problemi nati con il “disastro”, che interpellano il rapporto tra produzione industriale, ricerca scientifica, ambiente, salute e popolazione, alternando l’utilizzo di fonti bibliografiche, articoli di cronaca e interviste realizzate durante la mia ricerca etnografica a Seveso. Nelle prossime righe mi concentrerò sulle vicende del “Comitato tecnico scientifico popolare” che nacque all’indomani del “disastro”.

Con l’evento del 10 luglio 1976, a Seveso sorsero nuovi gruppi organizzati di abitanti e nuove soggettività sociali e politiche. Il rovesciamento della dimensione quotidiana e l’affacciarsi di una «crisi della presenza»1 avevano portato all’emergenza di coaguli di persone che «non si limitavano al ruolo di vittime, come dicevamo noi, ma appunto hanno cercato di costruire dei legami e dei rapporti e di darsi degli strumenti di comprensione critica»2 e la cui sede principale a Seveso era il Circolo del Vicolo. Stefano, un ragazzo di vent’anni nel 1976 che lavorava in una falegnameria e aveva l’intenzione di iscriversi all’università, ricorda nel documentario «Seveso, Memoria di parte» il momento di fondazione del circolo.

«

Ci si è trovati in un momento in cui la gente era estremamente preoccupata per la propria salute, ma avevano a che fare con un tossico impalpabile, inodore, incolore, invisibile. Il momento della fuoriuscita, che era il momento evidente, era passato. Il tossico ormai era depositato sui tetti, sui muri, sui pavimenti lastricati, sui terreni, ma non si vedeva. Per cui la gente iniziava ad avere la preoccupazione per la propria salute, ma andava esorcizzata perciò ci si appellava al matto di turno che diceva “non è successo niente, io vado a mangiare l’insalata lì dentro”, perché questo abbassava la tensione. Questo è servito per molti in buona fede, per molti altri ne hanno avuta un meno di buona fede dicendo le medesime cose, serviva per tenere moderata la tensione che vivevano quotidianamente. Abbiamo costruito questo che si chiamava Circolo del Vicolo perché la sede si trovò in una via che di chiamava Via del Vicolo, da lì Circolo del Vicolo.3

»

Stefano racconta che l’ingente lavoro politico e culturale prodotto dal circolo nasceva dalla necessità di rispondere a bisogni e desideri che riguardavano l’esistenza intera. Per lui è stato un periodo nel quale la gente discuteva dappertutto e vi era un’adesione sociale molto elevata a qualsiasi tipo di situazione per un «trascinarsi probabilmente di quello che era la partecipazione alle lotte operaie»[4].

Il Circolo del Vicolo, nella sua dimensione locale, era un’espressione di questa stagione dei “movimenti” e, come sottolinea Stefano, il movimento operaio e le lotte dei lavoratori e delle lavoratrici per il salario e la salute in fabbrica trascinarono e crearono momenti di mobilitazione estesi e partecipati. Tra i gruppi che attraversarono il laboratorio politico del Circolo del Vicolo vi era il “Comitato tecnico scientifico popolare”.

Per Davide, fu il gruppo più importante nel ciclo di lotte locali a seguito del “disastro” dell’Icmesa.

«

Il [gruppo, N.d.R.] più importante sicuramente è stato il Comitato tecnico scientifico popolare che era stato creato quasi subito da alcuni lavoratori dell’Icmesa, anche membri del consiglio di fabbrica, da giovani del territorio di allora e si è avvalso subito del supporto appunto di Medicina democratica che era a sua volta collegata alle lotte per la tutela della salute nelle fabbriche. In particolare, erano arrivati quelli del gruppo di Castellanza dove c’era un grosso stabilimento Montedison, dove si erano sviluppate delle esperienze molto interessanti di lotta ma anche di autotutela da parte dei lavoratori. E quindi diciamo sono arrivati qui e si sono messi in contatto con le realtà locali e appunto poi non solo, sono nati anche gruppi per esempio legati al movimento femminista il “Gruppo donne Seveso-Cesano”. E successivamente nacquero altri gruppi più piccoli come il “Comitato di controllo zone inquinate”. Insomma, erano nate diverse realtà spontanee che erano collegate un po’ da una serie di volontà di comprensione critica e di avere un ruolo nella tutela della propria salute e anche di verità rispetto a quanto accaduto e alle responsabilità rispetto a quello che era accaduto.5

»

Il comitato era un organismo di base di contro-informazione e di lotta e aveva relazioni con altri soggetti politici della sinistra extra-parlamentare o delle componenti meno allineate alla politica di solidarietà nazionale del Pci degli anni Settanta. In particolare, vi erano dei collegamenti con “Medicina democratica movimento di lotta per la salute” e con la consigliera regionale del Pci, Laura Conti.

Fin dai primissimi giorni successivi alla fuoriuscita della nube tossica, il CTSP assunse fondamentali funzioni di informazione, controllo e organizzazione nei confronti degli operai dell’Icmesa e della popolazione sevesina. Il suo primo impegno a circa otto-dieci giorni dallo scoppio del reattore fu quello di fornire una prima sommaria ricostruzione dell’accaduto sulla base del materiale documentario raccolto e fornito dal confronto con i lavoratori dell’Icmesa. Fu così esaminato il ciclo produttivo del triclorofenolo all’interno della fabbrica per comprendere le cause che avevano portato al fatto-tragedia-disastro di Seveso. Questo lavoro fu realizzato dal confronto tra gli operai della fabbrica medese e il Gruppo P.I.A della Montedison di Castellanza, congiuntamente a Bruno Mazza dell’Istituto di chimica, fisica, elettrochimica, metallurgia del Politecnico di Milano e Vladimiro Scatturin dell’Istituto di chimica generale e inorganica dell’Università degli studi di Milano. Il documento prodotto dal titolo “Contributo del CTSP costituitosi in seguito all’inquinamento prodotto dall’ICMESA, in appoggio ai lavoratori e alla popolazione colpita” fu presentato nell’assemblea organizzata dalla Federazione unitaria Cgil-Cisl-Uil nelle scuole medie di Cesano Maderno il 28 luglio 1976. La ricostruzione del ciclo produttivo è stata in seguito pubblicata come primo articolo[6] nel numero monografico di «Sapere» dedicato a Seveso. Comprendere l’eziologia del “disastro” era un passaggio fondamentale per riflettere e agire sulle conseguenze dello stesso e per farlo era imprescindibile il coinvolgimento di chi nella fabbrica passava le sue giornate. Nella ricerca si evidenziò che l’Icmesa aveva introdotto delle varianti nel ciclo produttivo con lo scopo – secondo il Gruppo P.I.A., Mazza e Scatturin – di ridurre radicalmente i costi di produzione, scegliendo di operare in condizioni sempre più pericolose. La logica adottata dalla multinazionale svizzera era volta alla massimizzazione del profitto e faceva tendere all’infinito il «coefficiente di rischio» della produzione di sostanze ad alto rischio di tossicità, trasformando – quindi - in una certezza la possibilità di un “incidente”.

Lo scopo dell’approfondito lavoro di ricostruzione del ciclo produttivo realizzato da un’apposita commissione del CTSP metteva in questione l’astrattezza dei concetti di «univocità» e «oggettività» del ciclo produttivo e di scienza.

«

Va detto, in conclusione, che il gruppo operaio non accetta in modo astratto la «univocità» e la «oggettività» del ciclo produttivo e della scienza e tecnologia che lo hanno imposto.7

»

Il documento racchiudeva e metteva al centro la soggettività operaia riferita al ciclo stesso di produzione per fornire uno strumento utile alla comprensione del rischio vissuto quotidianamente e per partire dal punto di vista degli operai stessi.

Nelle conclusioni dell’articolo, vengono evidenziate due tipi di culture e di progresso: quella «del capitale» e quella dello «sviluppo sociale». Se la prima, spinta dalla molla del profitto economico privato, persegue lo sviluppo di una cultura basata sulla neutralità ed asetticità della scienza, sulla sua separazione dalla politica, sugli incentivi per la ricerca che provengono dai poteri privati, la seconda è portatrice di istanze critiche nei confronti del “progresso” inteso come fine ineluttabile delle società umane. Al contrario, la “cultura sociale” si proponeva di azzerare il «coefficiente di rischio» attraverso lo sviluppo di una diversa forma di sapere avente come linea portante un inedito rapporto tra tecnici-operai-popolazione. Il CTSP si proponeva come esempio di tale relazione tra l’interno e l’esterno della fabbrica. Davide ricorda proprio questo passaggio come centrale nello sviluppo della lotta sevesina.

«

Mentre nello stesso periodo le autorità sanitarie balbettavano, non sapevano cosa dire, non potevano forse dire tutto. Quindi per una fase iniziale nei primi mesi sì, [il CTSP, N.d.R.] era molto ascoltato, poi magari non tutti erano d’accordo, ma sicuramente molto ascoltato. E devo dire che inizialmente questo rispecchiava anche un legame che si stava un po’ instaurando tra territorio e fabbrica, tra territorio e lavoratori della fabbrica. Ora non la faccio troppo lunga, ma per come si era sviluppata l’industria nel territorio, nel nostro territorio c’era molto uno distacco tra la fabbrica e il territorio agricolo-artigianale di quegli anni. Tra chi lavorava in fabbrica e gli altri erano mondi un po’ strani, convivevano, ma senza proprio incontrarsi. Per un attimo quella vicenda nella sua drammaticità aveva costruito un legame perché per la prima volta quelle nocività uscivano sul territorio. Quelle nocività che non solo nella fabbrica, erano percepite come un problema della fabbrica si riversano in modo traumatico sul territorio. Quindi è la prima cosa che fa la popolazione non operaia andare a dire bah, chissà, forse chi ci lavora dentro qualcosa sa. C’è un’intervista a un lavoratore del Consiglio di Fabbrica dell’ICMESA, che racconta che alcuni genitori di bambini con la cloracne hanno contattato loro perché le autorità risposte sembravano non darne o comunque non ne parlavano volentieri e quindi si rivolgono ai lavoratori. Tra l’altro è da lì che anche i lavoratori prendono coscienza definitiva della gravità di quello che è accaduto e sospendono la produzione. Proclamano lo sciopero ad oltranza. È praticamente la fine dell’Icmesa.8

»

Gli obiettivi del comitato furono esplicitati nel bollettino pubblicato nel settembre del 1976 e si posero in contrapposizione con l’operato delle istituzioni locali, regionali e nazionali che – secondo il CTSP – avevano coperto e soffocato ogni tipo di protesta e di organizzazione degli abitanti della zona, non fornendo sufficienti informazioni sulla situazione per fare maturare una consapevolezza collettiva del rischio.

Nel prossimo articolo sul CTSP, partirò proprio da qui per scendere nel sottobosco dei documenti conservati dall’Archivio Seveso. Memoria di parte e della storia del comitato.

NOTE

1 Per «crisi della presenza» si intende una situazione in cui un individuo o un gruppo umano si trovano ad affrontare un particolare evento, come per esempio la malattia o la morte, durante il quale si sperimenta un’incertezza, una crisi radicale della possibilità di esserci nel mondo e nella storia, tanto da scoprirsi incapaci di agire e di determinare la propria azione. Si veda, E. De Martino, La fine del mondo. Contributo all’analisi delle apocalissi culturali, Torino, Einaudi, 1977.

2 Intervista a Davide, abitante di Desio e testimone del “disastro” dell’Icmesa, 27 gennaio 2024.

3 Archivio Seveso Memoria di parte (Asmp), b. CTSP, Interviste-documentario “Seveso, Memoria di parte”. Si tratta di un documentario autoprodotto dall’ “Archivio Seveso Memoria di parte”.

4 Ibidem.

5 Intervista a Davide, abitante di Desio e testimone del “disastro” dell’Icmesa, 27 gennaio 2024.

6 Si veda, Gruppo P.I.A., B. Mazza, V. Scatturin, “ICMESA: come e perché”, in «Sapere», n. 796, nov.-dic. 1976, Bari, Dedalo, pp. 10-36.

7 Ivi, p. 34.

8 Intervista a Davide, 27 gennaio 2024.

Le nuvole scrivono il cielo di Seveso - Il crimine di pace, la scienza e il potere

In questo scritto racconterò brevemente che cosa accadde il 10 luglio 1976 e che cos’era l’Icmesa. In seguito, solleverò alcuni problemi nati con il disastro che interpellano il rapporto tra produzione industriale, ricerca scientifica, ambiente, salute e popolazione, alternando l’utilizzo di fonti bibliografiche, articoli di cronaca e interviste realizzate durante mia ricerca etnografica a Seveso.

10 luglio 1976, ore 12.37

«Eravamo a pranzo. Era anche una bella giornata di sole. Tutto ad un tratto sentiamo pof. Poi un sibilo forte, come se fosse scoppiata una gomma. Ma più forte, come se ci fosse dell’aria che usciva. Io sono corsa sul balcone e come esco dal balcone davanti ho una casa con un altro mio amico. Anche lui era fuori e faceva così [indica il cielo con il dito]. Mi giro e vedo ‘sta nuvola fantastica, bellissima. Bianca. Proprio di un bianco, proprio bello. Bella, sì1».

Chi era presente quel giorno a Seveso non si aspettava una nuvola così bella e così pericolosa proprio in quel momento. Tuttavia, il sentore che sarebbe potuto accadere qualcosa era nell’aria.

«[Hoffmann e La Roche, N.d.R.] hanno sempre considerato l’incidente del 10 luglio ‘76 come un evento casuale. E io ho sempre detto: vero, nel dire casuale il dieci luglio 1976 alle 12.37. L’impianto era talmente obsoleto, la fabbrica e i relativi controlli erano talmente privi di sistemi di sicurezza che un incidente era nelle corde»2, mi ha raccontato Massimiliano Fratter, sevesino dalla nascita e responsabile del progetto il Ponte della memoria. Non solo il cielo fu scritto dal passaggio delle nuvole velenose, ma il risveglio sensoriale interessò anche l’olfatto. Infatti, Maria racconta che poco dopo aver visto quella nuvola bellissima ha sentito anche l’odore di saponetta, «quell’odore buono di profumo». Quello solito a cui era abituata3. L’Icmesa era soprannominata dagli abitanti della zona la fabbrica dei profumi4 per gli odori che la sua produzione esalava.

Le origini della fabbrica risalivano al 1921. Prima della seconda guerra mondiale l’azienda aveva sede a Napoli. Dopo la distruzione dello stabilimento campano a causa dei bombardamenti, la fabbrica fu trasferita Meda, sotto il controllo del gruppo svizzero Givaudan, che ne deteneva il pacchetto azionario di maggioranza e che a sua volta era stata acquisita dalla multinazionale farmaceutica Hoffmann-La Roche5. La produzione dello stabilimento cominciò tra il 1946 e il 1947 e consisteva nella realizzazione di componenti chimici, alcuni dei quali ad alto tasso di pericolosità. In particolare, dal 1969 il reparto B era stato utilizzato per la fabbricazione del 2,4,5-triclorofenolo (TCF), una sostanza impiegata principalmente per la preparazione di alcuni tipi di erbicidi e per la produzione di esaclorofene, un antibatterico utilizzato in alcuni tipi di cosmetici, di saponette e di disinfettanti6.

Tuttavia, per una parte della popolazione di Seveso, per alcuni medici e giornalisti di cronaca locale, l’Icmesa non solo inquinava da anni e avvelenava gli operai e la gente, ma produceva sostanze pericolose non solo per la cosmesi. La fuoriuscita di diossina sarebbe stata una prova.

L’8 agosto 1976 Pierpaolo Bollani intervista (per il Tempo) Fritz Möri, l’ingegnere che aveva progettato il reattore per la produzione di triclorofenolo. Nelle scettiche parole del tecnico di Losanna rispetto all’eventualità di formazione di TCDD nel reattore “a meno di compiere errori madornali», viene presentata la possibilità «che all’Icmesa in quel reattore, La Roche producesse in realtà altre cose»7. Lo stesso direttore tecnico della Givaudan Jörg Sambeth ha ammesso che l’Icmesa era una dreck fabric, una fabbrica sporca, dove l'impianto veniva fatto funzionare al di sotto di qualsiasi standard ragionevole di sicurezza e dove si portavano avanti due linee di produzione: una feriale, più pulita e probabilmente destinata a usi civili, e una festiva, realizzata a temperature critiche, vicine al punto di combustione e di sintesi della diossina.

Anche se non sapremo mai con certezza che cosa producesse l’Icmesa, quanto è accaduto a Seveso pone delle domande attuali in merito al rapporto tra la produzione industriale – e la correlata ricerca scientifica – e l’ambiente, la salute, la popolazione e la guerra. In un intervento contenuto nell’autoproduzione Topo Seveso. Produzioni di morte, nocività e difesa ipocrita della vita8 viene considerata la sottile separazione tra le «produzioni chimiche per la guerra o per la pace»9 perché «è durante la pace che si prepara e si arma la guerra: sono le stesse aziende che producono materiale da imballaggio, detergenti, disinfettanti, che poi preparano anche la base per le bombe e le altre armi chimiche, così come sono le aziende che producono le pentole e le travi per la costruzione che confezionano anche le armi. E le aziende che producono altro, non direttamente implicabile con la guerra, possono sempre investire nel mercato delle armi, più o meno legalmente»10.

Si tratta di una questione centrale per il momento storico in cui viviamo e che toglie il velo di Maya dalla ricerca scientifica intesa come attività neutrale e ab-solutas. Ci fa interrogare sui programmi di ricerca e applicazione delle istituzioni in cui studiamo e dei luoghi in cui lavoriamo. L’evento straordinario di Seveso amministrato secondo le regole dell’ordinaria amministrazione – come Laura Conti ha evidenziato nel reportage Visto da Seveso11 – ci parla ancora oggi delle relazioni che intercorrono tra industria, tecnologia e ambiente. I termini con cui l’evento del 10 luglio 1976 è stato definito sono numerosi e carichi di significati e orizzonti culturali e politici diversi tra loro: incidente, tragedia, fatto, disastro, catastrofe, crimine.

A mio avviso, il concetto di catastrofe, liberato dal particolare uso linguistico sevesino, è utile per focalizzare alcuni nodi della questione. La catastrofe genera paradossi e campi di forze contradditorie. I conflitti nati dall’evento catastrofico hanno interessato la concezione di progresso, di scienza, di salute e di ambiente di un intero Paese. L’agone tra le differenti e opposte prospettive di trattare l’evento straordinario dell’Icmesa ha avuto luogo nelle strade di Seveso, negli ufficiali comunali e nelle aule del Parlamento, nei centri di ricerca nazionali e internazionali, negli articoli di giornale e nelle fabbriche e ha svelato le forze, gli interessi e le asimmetrie di potere strutturali italiane e globali.

Le catastrofi sono totalizzanti e per questo come scrive Mara Benadusi sono «oggetti antropologici e filosofici “buoni da pensare”»12 . Ponendosi come cesure che differenziano un prima e un dopo temporale e spaziale, investono ogni sfera della vita umana e sociale. Le traiettorie biografiche individuali e collettive sono state catapultate dalla dimensione locale a quella globale. Sandro, un abitante di Seveso incontrato durante il mio lavoro di ricerca etnografico nelle zone del disastro dell’Icmesa, riesce a trasmettere la repentinità dell’evento eccezionale ed emergenziale nella sua uscita dalla dimensione locale della Brianza.

«Questa cosa è sicuramente stata molto importante dal punto di vista comportamentale della popolazione perché eri passato da una emerito sconosciuto a uno stronzo che sta inquinando il mondo. Non so come dire […] È una cosa che magari c'è chissà da quante altre parti. Ma finché non succede il fattaccio, nessuno lo viene a sapere»13.

Il crimine di pace – come lo ha definito Giulio A. Maccacaro, ha sconvolto le comunità di Seveso, Meda, Desio e Cesano Maderno14. In quei territori approdo delle migrazioni interne dell’Italia del secondo dopoguerra, l’economia di tipo artigianale, l’identità di campanile e i valori del lavoro e della religiosità cristiana cattolica furono sconquassate dalla nube del 10 luglio 1976 e dalle lotte sociali e politiche che seguirono. Bruno Ziglioli scrive:

«La popolazione si riaggregò e si divise su basi completamente diverse: tra gli evacuati della zona A che desideravano rientrare nelle proprie abitazioni e gli abitanti rimasti che temevano di essere esposti al veleno; tra coloro che erano sistemati al residence di Bruzzano (cioè vicino a casa) e quelli che invece erano alloggiati al motel Agip di Assago (molto più distante); tra chi tendeva a minimizzare e chi a enfatizzare il pericolo; tra chi era favorevole all’incenerimento in loco del terreno contaminato e chi invece chiedeva di sperimentare tecniche di decontaminazione meno invasive. Vi furono manifestazioni, proteste, blocchi stradali; gli sfollati rioccuparono a più riprese le case nella zona ad alto inquinamento. Come spesso accade in queste situazioni, si innescò anche la caccia al capro espiatorio: i lavoratori dell’Icmesa, e con loro i sindacati, furono additati da una parte degli abitanti come corresponsabili dell’incidente, perché avrebbero conosciuto e taciuto i rischi del processo produttivo e le scarse condizioni di sicurezza dello stabilimento»15 .

Tuttavia, furono proprio gli operai a interrompere la produzione della fabbrica perché dalla direzione non era arrivata nessuna indicazione chiara. Amedeo Argiuolo, operaio dell’Icmesa, ha raccontato in una recente intervista per il Giorno che «all’inizio, l’azienda tentò di minimizzare. Il reparto B era chiuso, e noi ci chiedevamo perché…i responsabili dell’Icmesa dicevano che era solo un piccolo incidente, che era tutto sotto controllo, anzi aveva mandato qualcuno di noi, solo guanti e mascherine, a fare carotaggi: dicevano che avevano mandato tutti ai laboratori di Basilea e ci avrebbero fatto sapere. Secondo loro, bisognava continuare a lavorare»16.

Il Consiglio di fabbrica dell’Icmesa ha avuto un ruolo fondamentale per fare emergere la pericolosità dell’accaduto non solo all’interno della fabbrica, ma per la popolazione e il territorio circostante. Alberto, abitante delle zone interessate dal disastro, ricorda che: «Qui [a Seveso] era nato anche un comitato. Si chiamava Comitato tecnico scientifico popolare17 e metteva insieme sia il Consiglio di fabbrica dell’Icmesa che ha avuto un ruolo importante in questa vicenda sia gli scienziati»18 .

Il CTSP con il medico G. A. Maccacaro e la rivista Sapere hanno messo in discussione la “scienza ufficiale” che procedeva a tentoni e in un primo momento aveva tentato di insabbiare e poi di minimizzare l’accaduto. Il CTSP fece un lavoro di informazione e controinformazione teso a prendere sul serio l’evento sevesino, rompendo «i giorni del silenzio» di Icmesa-Givaudan-Hoffman-La Roche e delle istituzioni italiane. Infatti, durante l’Assemblea Popolare del 28 luglio 1976, organizzata dalla Federazione Unitaria di CGIL-CISL-UIL nelle scuole medie di Cesano Maderno, i membri del CTSP hanno segnalato prima di qualsiasi altro organo ufficiale l’avvelenamento della popolazione e del territorio da parte dell’Icmesa. Gli operai del Consiglio di fabbrica che decisero di chiudere la stabilimento per avere maggiore chiarezza erano una parte fondamentale e attiva nel Comitato. Tra le pagine del numero di Sapere interamente dedicato a Seveso, il Gruppo P.I.A.19 dopo aver ricostruito il ciclo produttivo dell’Icmesa nei minimi dettagli conclude interrogando la differenza tra due tipi antagonisti di “cultura e di progresso” e di scienza. Il Gruppo P.I.A. scrive:

«Chi è spinto dalla molla del profitto e adotta la regola che i guadagni sono privati, mentre le perdite sono pubbliche, persegue lo sviluppo di una cultura basata sulla neutralità ed asetticità della Scienza, sulla sua separazione dalla politica, sugli incentivi per la ricerca che provengono dal profitto e dal potere individuali od oligarchici»20 .

Quanto accaduto a Seveso ha aperto la scatola nera in cui sono inestricabilmente imbricate una concezione della scienza neutrale tesa al progresso scientifico-tecnologico, una visione lineare del progresso e delle scelte economiche e politico-istituzionali. Lo scoppio della scatola-reattore ha portato tutte queste questioni e i loro intrecci fuori dalla fabbrica e ha dato vita a un ciclo di lotte per la salute e per l’ambiente di ampia portata, ancora oggi attuali.

NOTE

1 Intervista condotta dall’autrice a Maria, abitante della frazione Baruccana di Seveso, in data 14 settembre 2023.

2 Intervista condotta dall’autrice a Massimiliano Fratter in data 28 luglio 2023. M. Fratter è nato a Seveso, è il responsabile del progetto Il ponte della memoria, ha lavorato all’Ufficio Ecologia del Comune di Seveso e ora è impiegato nella biblioteca dell’omonima città.

3 I riferimenti agli odori insistenti, all’inquinamento del torrente Certesa e alla moria di animali che pascolavano nei prati vicini all’Icmesa possono essere rintracciati nei documenti degli archivi comunali di Meda e di Seveso. Per una loro interpretazione storica, vedi M. Fratter, Seveso. Memorie da sotto il bosco, Milano, Auditorium Edizioni, 2006, pp. 53-75.

4 Il giornalista Daniele Bianchessi nel 1995 ha pubblicato il suo primo libro d’inchiesta intitolato La fabbrica dei profumi. La prima edizione è stata pubblicata da Baldini & Castoldi. Il volume è stato rieditato nel 2016 da Jaca Book.

5 Per un maggiore approfondimento sulla storia e la composizione societaria vedi Camera dei deputati, Senato della Repubblica, Relazione conclusiva, Commissione parlamentare di inchiesta sulla fuga di sostanze tossiche avvenuta il 10 luglio 1976 nello stabilimento ICMESA e sui rischi potenziali per la salute e per l’ambiente derivanti da attività industriali, VII legislatura, doc, XXIII, n. 6, 25 luglio 1978, p. 58; B. Ziglioli, La mina vagante. Il disastro di Seveso e la solidarietà nazionale, Milano, Franco Angeli, 2010, p. 16.

6 Per avere una conoscenza più approfondita dei prodotti dell’Icmesa vedi Camera dei deputati, Senato della Repubblica, Relazione conclusiva, op. cit., pp. 62-64.

7 P. Bollani, Io fabbrico morte. Ecco cosa è successo, «Tempo», 8 agosto 1976, in Giunta regionale della Lombardia, Stampa italiana. 10 luglio 1976, Seveso il dramma della nube tossica, n. 1, p. 24. Per ulteriori informazioni sulla possibili produzioni per la guerra chimica, vedi C. Risé, C. Cederna, V. Bettini, Dietro l’Icmesa in Icmesa. Una rapina di salute, di lavoro e di territorio, Milano, Mazzotta, 1976, pp. 58-69; M. Aloisi [et al.] (a cura di), Seveso. La guerra chimica in Italia, «Quaderni di Triveneto», n. 1, Verona, Bertani, 1976.

8 Aa. Vv., Topo Seveso. Produzioni di morte, nocività e difesa ipocrita della vita, Milano, Autoproduzione, 2007. Vedi, http://tuttaunaltrastoria.info/wp-content/uploads/2022/05/POIDIMANI-Atti_Topo_Seveso.pdf.

9 Ivi, p. 12.

10 Ivi, pp. 11-12.

11 L. Conti, Visto da Seveso. L’evento straordinario e l’ordinaria amministrazione, Milano, Feltrinelli, 1976.

12 M. Benadusi, Antropologia dei disastri. Ricerca, Attivismo, Applicazione. Un’introduzione in Antropologia Pubblica, Vol. 1 n. 1-2, 2015, p. 41.

13 Intervista condotta dall’autrice a Sandro, abitante della frazione Baruccana di Seveso, condotta nel mese di settembre 2023.

14 Si tratta dei quattro comuni della Brianza maggiormente contaminati.

15 B. Ziglioli, La mina vagante. Il disastro di Seveso e la solidarietà nazionale, Milano, Franco Angeli, 2010, p. 46.

16 https://www.ilgiorno.it/monza-brianza/cronaca/operaio-icmesa-fuoriuscita-diossina-0de68f02

17 Da questo punto, userò l’acronimo CTSP per riferirmi al Comitato tecnico scientifico popolare.

18 Intervista condotta dall’autrice ad Alberto presso la sede del Circolo Legambiente – Laura Conti in data 22 agosto 2023. Quando si è verificato il disastro, Alberto aveva 15 anni e andava a scuola a Cesano Maderno.

19 È il Gruppo di prevenzione e di igiene ambientale del Consiglio di fabbrica della Montedison di Castellanza.

20 Gruppo P.I.A, B. Mazza, V. Scatturin, ICMESA: come e perché in Seveso. Un crimine di pace, «Sapere», n. 796, nov.-dic. 1976, Bari, Dedalo, p. 34.

Gestione sostenibile delle foreste - Una risposta concreta ai problemi climatici e ambientali

Il cambiamento climatico è un dato oggettivo.

La comunità scientifica discute sulle cause e sulle conseguenze, ma non sul fatto che le temperature sul nostro pianeta siano più calde di 30, 50 o 100 anni fa. E anche sulle cause, sono pochissimi gli scienziati che negano l’effetto delle attività umane. La discussione rimane invece aperta rispetto al peso percentuale di queste attività sul fenomeno del riscaldamento globale.

Quindi, possiamo dire che il modello di sviluppo industriale novecentesco è stato largamente responsabile di questa situazione. Parliamo essenzialmente dell’emissione di gas a “effetto serra” che impediscono al calore di disperdersi oltre l’atmosfera. Si tratta dei gas emessi dal bruciare di combustibili fossili per uso industriale, soprattutto per la mobilità e delle emissioni principalmente di CO2, ma anche di metano e protossido di azoto.

Un ulteriore aspetto da non dimenticare è il popolamento degli esseri umani sulla Terra. Non va dimenticato che gli abitanti della Terra sono passati da circa 1,5 miliardi a inizio Novecento a circa 8 miliardi oggi. Otto miliardi di persone che devono nutrirsi e che generano attività economiche, quindi consumano energia. Se il problema sono i combustibili fossili, da tempo sono noti dei possibili rimedi. In primis, la sostituzione del petrolio e dei suoi derivati con energie pulite rinnovabili (sole, vento, maree), l’efficientamento dei processi produttivi e poi il formidabile potere delle foreste.

Ma se la sostituzione del fossile non è affatto semplice perché il bisogno di energia è in continua crescita, sulle foreste il discorso diventa molto interessante. Le foreste sono un formidabile strumento di stoccaggio della CO2, di regolazione del ciclo delle piogge e di conservazione della biodiversità.

Il ricercatore inglese Thomas Crowther dell’ETH di Zurigo stima che attualmente sulla Terra ci siano circa 3.000 miliardi di alberi (!!) ma che 12.000 anni fa fossero più del doppio. Egli stima anche che sul nostro pianeta ci sia spazio per piantare circa 1.000 miliardi di nuovi alberi, che darebbero un contributo enorme a risolvere il problema dei gas serra. Basti pensare che recenti studi hanno constatato che mediamente un albero ad alto fusto assorbe ogni anno 25 kg di CO2 (dato prudenziale, fonte: Ecotree). Naturalmente una piantumazione così massiccia è impossibile all’atto pratico, ma questi dati dovrebbero far capire che la strada della salvaguardia delle foreste esistenti e dell’implementazione di nuove è imprescindibile per risolvere il problema del riscaldamento globale.

Invece è triste constatare come, tutt’ora, il saldo tra deforestazione e nuove foreste sia largamente negativo con circa 10 milioni di ettari persi ogni anno e con la sola eccezione virtuosa dell’Europa che ha 158 milioni di ettari di terreni boschivi, in aumento (Fonte: Rapporto Foreste Legambiente 2023).

---------

Dopo aver brevemente contestualizzato il problema e l’argomento di discussione, ora veniamo al tema dei crediti di carbonio. Si tratta di titoli negoziabili che sono stati concepiti a seguito degli accordi del Protocollo di Kyoto. I crediti di carbonio sono strumenti finanziari introdotti con la finalità di rendere conveniente economicamente la salvaguardia delle foreste. Ogni credito equivale allo stoccaggio di una tonnellata di CO2. Di fatto le imprese possono acquistare questi titoli (su base obbligata per le grandi aziende molto energivore, su base volontaria per le altre) che corrispondono a una gestione forestale virtuosa delle grandi aree forestali africane, sudamericane e asiatiche.

I titoli di credito di carbonio possono essere emessi da consorzi che si sono dotati di un Piano di Gestione Forestale Sostenibile certificato. In queste aree vi è quindi la certezza (non sempre reale, temiamo) che la foresta sarà protetta e ci saranno piani di tagli programmati per aumentare comunque la massa legnosa e l’assorbimento netto di CO2. Tra regolamenti complessi, processi non sempre trasparenti e mille polemiche, in poco come di vent’anni di vita, il meccanismo dei crediti di carbonio non è stato un pieno successo, dal momento che non ha bloccato la deforestazione. Tuttavia, ha generato delle ricadute positive soprattutto con il concetto di Gestione Forestale Sostenibile.

Ma veniamo all’Italia. Nel nostro Paese le foreste godono di buona salute (forse contrariamente al sentire comune). In Italia ci sono circa 11 milioni di ettari di boschi e foreste, e questo dato è in continuo aumento dal dopoguerra (Fonte: Ministero dell’Agricoltura, Rapporto sullo stato delle foreste in Italia).

Grafico di Forest Sisef

Nel nostro Paese si sta diffondendo anche la pratica delle Gestione Forestale Sostenibile: i proprietari di grandi boschi (siano enti pubblici o privati) possono costruire questi piani grazie al lavoro di dottori forestali specializzati che pianificano il monitoraggio accurato dello stato della zona interessata e definiscono le pratiche per salvaguardare il bosco e per incrementare la sua capacità di protezione della biodiversità e dello stoccaggio di CO2. I piani di GFS devono essere costruiti secondo standard di enti riconosciuti. In Italia operano le filiali nazionali dei due maggiori enti internazionali: FSC (Forest Stewardship Council) e PEFC (Programme for Endorsement of Forest Certification).

Qual è il vantaggio di certificare i boschi? Chi vuol vendere legno a scopi industriali ha un plus se ha la certificazione, perché, sempre più, l’industria e i regolamenti richiedono legname certificato. D'altro canto, anche chi vuole promuovere l’uso di boschi per escursioni avrà un vantaggio nel dire che il suo è un bosco gestito in modo virtuoso.

Infine si stanno muovendo dei meccanismi economici. La GFS può generare dei crediti di sostenibilità, ovvero titoli che riconoscono una corretta gestione dei servizi della foresta (ecosistemici). Si tratta di un mercato ancora largamente agli inizi, che il legislatore, sia nazionale che europeo, sta facendo molta fatica a definire e regolamentare. Tuttavia oggi nel nostro Paese esistono consorzi che hanno ottenuto il via libera dagli enti certificatori per emettere crediti di sostenibilità, sulla base di una verifica di un beneficio dei servizi ecosistemici, segnatamente un calcolo dell’addizionalità nello stoccaggio di CO2 del bosco interessato.

Il prezzo di questi titoli oggi non si basa su criteri oggettivi ed è dato da accordi privati tra ente venditore e acquirenti.

Ci si chiederà: che vantaggio acquisisce chi acquista questi titoli? Si tratta di un vantaggio esclusivamente reputazionale. Un’azienda che acquista questi titoli racconta di aver investito nella salute dei boschi e delle comunità che li abitano.

È auspicabile che tutto questo sia solo l’inizio di una crescita di consapevolezza dell’importanza del ruolo di boschi e foreste. Se così sarà, questa consapevolezza potrà innestare un circolo virtuoso tra aziende finanziatrici e sistema naturale a beneficio di ambiente, territorio e comunità.

Triangolo, Spazio bianco, Trapezio - Strutture geometriche del management scientifico

Abbiamo visto come il manager utilitarista abbia evoluto la classica struttura piramidale del management scientifico in una strana forma composita: un triangolo, dato dal vertice e da pochi eletti; una base trapezoidale indistinta; uno spazio bianco che evita il contatto tra le due figure precedenti.

Oggi vediamo le caratteristiche di queste 3 figure del management scientifico moderno all’opera.

Il triangolo: questo livello presenta sia caratteristiche comuni a tutte le impostazioni aziendali, di qualsiasi dimensione e industry, che caratteristiche specifiche dell’impostazione utilitarista. Concentriamoci su queste ultime, ricordando che parliamo di un qualcosa che riguarda lo 0,000003% della popolazione aziendale.

- La prima specificità è la seguente: tutti i componenti sono di netta matrice utilitarista e presentano - le attitudini manageriali che abbiamo visto nel precedente articolo e sulle quali non mi soffermerò qui. -

- La seconda specificità riguarda i criteri di scelta: i criteri per la scelta dei componenti sono differenti a seconda delle aree (commerciale, governance, Digital/IT). Non ci sarebbe nulla di strano, se non fosse per il modello adottato.

- Area commerciale: criterio classico. I componenti devono avere una forte presa sulla rete di vendita e una forte business vision. Quindi: basso turnover e provenienza dalla stessa industry e in quasi sempre – incredibile dictu – dalla stessa azienda.

- Area di governance: criterio conservativo. Questa area in realtà è vista come un peso da sopportare per il semplice fatto che bisogna averla per legge o normative di settore. I componenti devono esserne consapevoli, perché a fronte di questo presupposto devono preoccuparsi solo di non fare danni e di compiacere il vertice. Stop. Quindi: medio turnover, provenienza dalla stessa industry e quasi mai dalla stessa azienda.

- Area Digital/IT: criterio di sperimentazione sociale. Questa è l’area dove l’utilitarismo si sbizzarrisce in quanto i componenti sono fungibili al mantenimento del proprio network auto referenziato e alla sperimentazione di nuove forme di management scientifico. Ricordando le caratteristiche dell’utilitarismo, non sorprende che questo criterio venga adottato proprio in questa area: è quella in cui ci sono ancora nuovi ambiti/scambi da poter controvalorizzare da zero. Quindi: alto turnover, provenienza da qualsiasi industry e mai dalla stessa azienda.

- I componenti del Triangolo sono ottimi comunicatori all’esterno, sanno scegliere in maniera perfetta gli argomenti, i canali, le tempistiche e soprattutto la platea di riferimento. I destinatari delle loro comunicazioni all’esterno sono quasi sempre loro peer o membri del proprio network

- Chi appartiene a questo livello non ha execution risk dal punto di vista del proprio percorso di carriera. gli verrà riconosciuto il merito per qualsiasi successo che l’Azienda raggiungerà nel breve termine, non risponderà di qualsiasi danno o fallimento sperimentato dall’Azienda nel breve/medio/lungo termine. Questo è ovvio, considerando i punti sopra riportati, e rappresenta un aspetto fondamentale perché consente di comprendere i diversi livelli di accountability che concretamente il singolo manager mette in atto.

Lo spazio bianco: questo livello è la vera novità della nuova struttura organizzativa. Vi chiederete da che punto di vista vada analizzato, dato che al suo interno non sono presenti risorse aziendali.Ebbene, questo spazio va studiato dal punto di vista della comunicazione. Infatti, avendo rinunciato a una cinghia di trasmissione manageriale tra i 2 livelli, l’Azienda utilitaristica basa la propria coesione sulla sola capacità di comunicare e diventa quindi fondamentale comprendere le modalità di riempimento di questo spazio bianco.

- Argomenti affrontati:

- Quelli dall’alto verso il basso sono sempre generici e quindi inconfutabili; difficilmente il Triangolo entra nel vivo della vita aziendale quando comunica e preferisce toccare temi sociali o di contesto su cui tutti non possono che riconoscersi. Da questo punto di vista, assistiamo quasi al paradosso di vedere l’utilitarismo sposare uno degli esiti della morale kantiana.

- Quelli dal basso verso l’alto sono sempre appiattiti e a scarso valore aggiunto per chi fosse, eventualmente, interessato a raccoglierli Questo può essere dovuto a più ragioni che non si riescono a esplorare in maniera esaustiva nello spazio di questo articolo. Sicuramente l’esito è quello di un’occasione persa.

La combinazione di questi due aspetti fa sì che sia molto più facile sapere cosa sta accadendo dentro e fuori l’azienda andando a leggere i mezzi di comunicazione pubblici, piuttosto che i contenuti presenti nello Spazio Bianco.

- Impostazione:

- Dall’alto verso il basso si assiste a un wording asettico; è questa un’evoluzione rispetto al puro formalismo, perché si tratta di un linguaggio che vorrebbe essere coinvolgente ma non riesce ad esserlo, e né d’altronde potrebbe riuscirci. Infatti tra l’attenzione al politically correct e la necessità di evitare termini che potrebbero urtare chissà quale sensibilità, al destinatario non rimane nulla del messaggio che si vorrebbe trasmettere. Questo è sicuramente frutto della volontà di fare override di qualsiasi caratteristica culturale, per omogeneizzare la popolazione aziendale.

- Dal basso verso l’alto il linguaggio è diretto, a volte sfrontato. Il limite principale è quello di usare ancora un wording che dà troppo per scontato che i destinatari della comunicazione abbiano lo stesso background culturale dei mittenti, mentre non è più così. Quindi a volte si rischia di essere o troppo diretti oppure fraintesi. Da questo punto di vista i componenti del Trapezio devono ancora fare uno sforzo significativo per essere maggiormente efficaci nel comunicare.

La combinazione di questi due aspetti fa sì che chi dall’esterno legge le comunicazioni presenti nello Spazio Bianco, possa pensare di trovarsi di fronte a un verbale di un’assemblea generale di un grande Partito politico della Prima Repubblica.

- Tempistiche:

- Dall’alto verso il basso il timing è calibrato nell’ottica del “poi non dire che non te lo avevo detto”. La comunicazione istituzionale viaggia con tempi che nascondono - neanche troppo – il fatto che la stessa sia vissuta come un atto dovuto, nulla più.

- Dal basso verso l’alto il timing è diverso in base al tipo di comunicazione: si va dal random (nel caso di condivisione di fatti di vita aziendale) al very last minute (nel caso di comunicazione istituzionale).

- Canali: ormai i canali di comunicazione sono molteplici ed efficienti; si va dalla mail ai social, passando per tool aziendali più o meno complessi, a seconda dei casi e delle necessità. Qui esiste una vera e propria mappa dei canali da usare rispetto alla finalità della comunicazione. Rimarco solo l’impiego sempre più decrescente del canale più antico del mondo, e cioè quello fisico: anche qui le ragioni sono varie e occuperebbero troppo spazio.

Vale la pena riportare giusto una nota differenziante del nuovo management scientifico, e cioè lo slogan “per chi vuole, la mia porta è sempre aperta”. Questa è una perla che, unita a tutti gli altri punti, sintetizza il valore dello Spazio Bianco nella nuova struttura aziendale

Il Trapezio: questo livello chiaramente c’è sempre stato, mentre nel tempo è cambiata la sua composizione ed è quindi da questo punto di vista che lo analizziamo.

- Competenze: così come avviene in molti contesti attuali, l’estrema specializzazione del lavoro porta all’aumento del mix di competenze presenti nel Trapezio. La partizione di competenze, già in fieri sin dal concepimento del management scientifico, è adesso arrivata a livelli estremi per cui non esiste più nessuno che possa essere veramente autonomo nel condurre la propria attività. Un tempo questa impostazione era tipica delle catene di montaggio, adesso viene applicata anche ai cosiddetti “lavori di concetto” e questo fa ben capire il ruolo e la dignità del capitale umano nella concezione utilitaristica al lavoro. Questo livello quindi è pieno di competenze diverse, il che le rende a lungo andare tutte uguali nel senso che sono tutte pienamente fungibili, con chiari benefici da parte del Triangolo.

- Gerarchie: in questo livello le gerarchie sono molto sfumate, fenomeno paradossale considerando il suo evidente ispessimento rispetto a solo 50 anni fa; adesso fanno parte del Trapezio figure che un tempo sarebbero sicuramente state in livelli superiori dell’organizzazione anche se non nel Triangolo (il cosiddetto middle management, ad esempio), eppure questa differenziazione sta perdendo di significato. Non serve più distinguere per livelli in maniera sostanziale: nel Trapezio hanno tutti la stessa valenza decisionale ed esecutiva di fronte all’azienda e resta qualche residuo legato ad alcuni aspetti istituzionali, quali il processo valutativo o remunerativo, ma sempre più pilotati dall’alto, lasciando poche leve a chi li deve agire dal basso.

Nel breve termine questo aspetto viene percepito molto positivamente da tutti i componenti, nel medio si inizia a percepire l’inganno che si nasconde dietro a questo apparente “mondo degli uguali”.

- Anzianità: questa è chiaramente funzione dell’industry di cui parliamo, e del ciclo di vita in cui si trova l’Azienda. Un aspetto che differenzia l’impostazione utilitarista dalle altre è l’impiego delle risorse in età pre-pensionabile. Nelle aziende non utilitariste queste risorse, negli ultimi mesi/anni di attività vengono impiegate, anche part-time, per la formazione e per il passaggio di consegne. Nelle aziende utilitariste, prive di memoria, le stesse risorse vengono accantonate per non contaminare il futuro con il passato

- Fidelizzazione: il fatto che questa sia decrescente è comprensibile in base a quanto spiegato fin qui, e d’altronde non sembra che la fidelizzazione sia un tema che stia particolarmente a cuore in questo tipo di impostazione. E’ invece interessante studiare l’interazione tra i giovani e l’azienda: infatti possiamo immaginare che i profili giovani siano quelli che meglio aderiscono ai nuovi standard, semplicemente perché sono cresciuti nella convinzione – trasmessa dagli stessi decision maker che compongono il Triangolo - che questi standard siano gli unici possibili e corretti. Quello che andrà capito è quanto, nel medio termine, questo binomio sia sostenibile nelle aziende di grandi dimensioni. Chi, dei giovani che oggi compongono il Trapezio, entrerà per vie traverse (e non per carriera interna, per quanto detto prima) a far parte del Triangolo? E che impostazione saprà dare all’Azienda? Quale stile avrà il giovane di oggi e manager di domani, cresciuto in un contesto lavorativo senza memoria?

Ancora non c’è una serie storica significativa per rispondere a queste domande, almeno in Italia. Sicuramente ne riparleremo alla prossima generazione del management scientifico!

La memoria e la sua corruzione nell’era digitale - A confronto con il pensiero di Platone

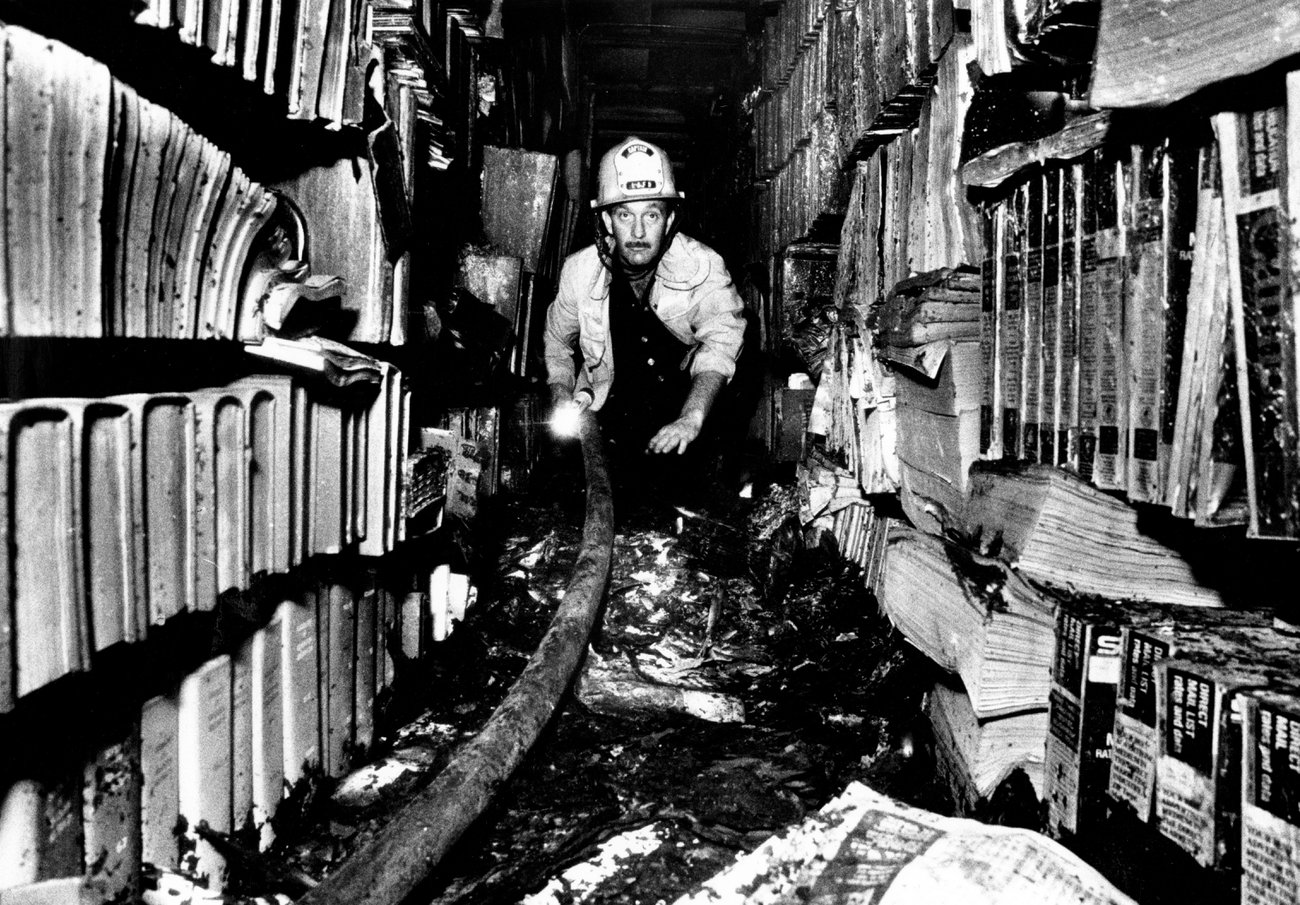

Immagine: Incendio della Public Library di Los Angeles del. 29 aprile 1986

Se ancora oggi Platone viene inquadrato come filosofo sradicato dalla concretezza del mondo e proiettato nell’Iperuranio, ciò è dovuto perlopiù alla ormai superata (ma ancora presente) visione diffusa dalla formazione scolastica ordinaria. Invece, la filosofia di Platone è profondamente radicata nel mondo fisico e materiale.

Della “memoria”, in Platone, è noto che ve ne sia un genere immortale, il quale provvede alla reminiscenza (anamnesis) degli oggetti intelligibili. Meno noto e poco esplicito nei dialoghi è invece l’altro genere, quello della memoria “mortale” (non è questo il termine platonico), inteso come proprio della condizione incarnata dell’Anima immortale in un vivente (zoòn).

La Memoria (mneme) è una delle facoltà dell’anima, quella di imprimere, tracciare o racchiudere nella forma di ricordo (hypomnema) le informazioni che otteniamo da oggetti incontrati attraverso l’esperienza empirica. Essa è l’insieme di ciò che si è sedimentato nell’anima a partire dalle sensazioni memorabili, prodotte dall’esperienza, che facciamo di oggetti che esistono fisicamente nel mondo empirico (il processo completo è esposto nel discorso fisiologico contenuto nel Timeo[1]).

Il tema che ci interessa indagare in questo post è quello della “volatilità” del sapere in Platone, per produrre nuovi spunti di riflessione utili nel dibattito odierno.

La reminiscenza (anamnesis) è un’operazione prodotta dalla sola Anima immortale. Più propriamente essa è una forma del ri-memorare oggetti visti nella condizione disincarnata. L’operazione dell’apprendimento (mathesis) di nozioni avviene, invece, durante la vita e il contenuto di una memoria “mortale” (il ricordo) può dissolversi irrimediabilmente. La memoria nella sua totalità cessa definitivamente la propria esistenza con la morte del vivente che lo possiede, perciò con lo scioglimento dei vincoli tra l’anima e il corpo.

----------

In primo luogo possiamo affermare l’esistenza di una memoria “mortale” nel pensiero di Platone poiché non ci è pervenuta nessuna testimonianza o accenno a proposito della possibilità di reminiscenza di ricordi appartenenti a vite passate - come invece è presente nelle dossografie pitagoriche[2], che Egli conosceva e custodiva gelosamente nella propria biblioteca. In secondo luogo, nei dialoghi che affrontano problemi legati sia alla reminiscenza che alla metempsicosi, troviamo l’idea che a ogni nuova incarnazione debba esservi un “reset” della memoria in relazione alla vita empirica (si veda nello specifico il “Mito di Er”[3])

Parrebbe anche che, sul piano mortale, le conoscenze pratiche e dell’esperienza empirica siano più durevoli rispetto a quelle epistemologicamente superiori (“scientifiche”) del filosofo o del matematico (che hanno come proprio oggetto ultimo gli intelligibili).

Questo lo si può dedurre in particolare da un passo del prologo drammaturgico del Timeo. Qui Crizia il Giovane riporta un racconto che apprese da bambino, in cui Solone incontrò in Egitto un sacerdote che così affermava:

«“Siete tutti giovani d’animo (voi greci)”, rispose il sacerdote, “perché non avete nelle vostre anime nessuna opinione antica trasmessa attraverso una tradizione che proviene dal passato né alcun sapere ingrigito dal passare del tempo».

Prosegue poi con la motivazione di questa brevità della memoria collettiva dei greci:

«ogni cosa viene registrata, fin dall’antichità, nei nostri templi e conservata alla memoria», mentre in Grecia «a intervalli regolari di tempo, come una malattia, torna il flusso del cielo che vi inonda e non lascia illesi fra voi che gli illetterati e i nemici delle Muse (gli incolti), sicché ricominciate nuovamente dal principio, come tornati giovani». Per di più, aggiunge il sacerdote: «nel corso di molte generazioni, i sopravvissuti sono morti senza aver fissato la loro voce nella scrittura». (Tim. 22 d – e)

In questo passo possiamo individuare almeno sei punti ri-attualizzabili al giorno d’oggi:

- la scrittura esprime qui il suo ruolo di strumento tecnico corruttibile ma preservabile dalla distruzione, perciò tramandabile;

- la scrittura è uno strumento tecnico ausiliario, che richiede una stabilità materiale continuativa della società per essere mantenuto e motivato nell’uso ordinario;

- il vivente mortale, se non ha né la possibilità né la premura di tramandare il prodotto della propria conoscenza, non conserverà un sapere collaudato da mettere a disposizione dei posteri;

- la condizione del dopo-catastrofe è analoga a un “momento zero” della memoria mortale, un “cominciare nuovamente da principio”;

- i saperi pratici “degli illetterati e degli incolti” sopravvivono più facilmente rispetto a quelli di filosofi e scienziati, propedeutici a porre le basi di quella stabilità materiale che rende possibile l’accumulo del sapere;

- l’accumulo di un sapere avanzato e complesso, come quello “scientifico” (episteme), non è necessario alla vita, ma è un “in più”.

Platone ci indica anche che, quando si sia memorizzata un’informazione, la sua durevolezza dipenderà non solo dalle condizioni in cui il suo proprietario la custodisce e preserva, ma anche da come egli l’ha ottenuta. Ad esempio, Crizia il Giovane racconta una storia di cui ha acquisito un ricordo “vivido”, in quanto giovane, attento e partecipativo nel momento del suo apprendimento[4]. Un caso diverso è invece quello di Fedro che, nel dialogo omonimo, deve confrontarsi con un’opera scritta che necessita di rileggere più volte per ricordarla “alla lettera” al fine di tenere il proprio discorso[5].

Nel primo caso, quello di Crizia, la qualità del ricordo è dovuta alle caratteristiche che contraddistinguono il momento in cui egli ha appreso un’informazione, ossia la pregnanza dell’esperienza di apprendimento. Nel secondo caso, quello di Fedro, la qualità della formazione del ricordo sarà dovuta all’ausilio di strategie mnemotecniche, quali la rilettura e la ripetizione a voce alta.

Per concludere, il problema della conservazione, del tramandare e della possibile perdita della memoria (nel senso più ampio che comprende storie, tradizioni, tecniche e conoscenze) è un fenomeno oggi ancora più complesso.

In particolare se guardiamo al fenomeno di progressiva sostituzione dei mezzi di trasmissione “tradizionali” dell’oralità e della scrittura manuale in favore della digitalizzazione dell’informazione.

Quante tipologie e forme di “memoria” abbiamo a oggi sviluppato e quali si stanno depotenziando o stanno scomparendo?

Quante forme della scrittura possediamo e quali competenze sono necessarie per farne uso?

Quanti livelli di linguaggio e quante forme di linguaggio esistono per la sola codificazione informatica dell’informazione?

Quali i pericoli a cui si espone la loro conservazione?

Ai cataclismi menzionati dal sacerdote egizio che ha incontrato Solone, evidentemente presenti e comunque imprevedibili ancor oggi, quali si aggiungono?

---------

Ovviamente, sono domande complesse che richiedono risposte altrettanto articolate. Ad esempio, per i supporti di archiviazione digitale, da cui oramai dipendiamo largamente, sono deleteri i fenomeni elettrici, magnetici ed elettromagnetici, i quali sono tutti in grado di cancellare, corrompere o rendere inaccessibili, se non addirittura irrecuperabili, le informazioni registrate.

La stessa obsolescenza delle tecnologie e delle tecniche di conservazione e riproduzione dell’informazione, giorno per giorno avvia verso la fine la riproducibilità delle precedenti forme di “memoria”, sia collettiva che individuale (foto, video, documenti, scansioni di immagini, etc.). Gli attuali dispositivi che possediamo saranno sempre meno reperibili con l’avanzare di nuove tecnologie e dei relativi sistemi che ne permettono il funzionamento?

I dispositivi attualmente in uso, per quanto collaudati, non saranno un giorno più compatibili con quelli più avanzati, per protocolli di scrittura e lettura?

Saranno reperibili le tecnologie di giunzione che permettono di interfacciare fisicamente vecchi e nuovi dispositivi di archiviazione di memoria?

Le tecnologie di traduzione e conversione reciproca tra vecchi e nuovi protocolli di archiviazione dell’informazione saranno ancora implementate sui nuovi dispositivi o saranno ancora reperibili e adoperabili?

Quali altre problematiche sono riscontrabili o sono di imminente larga diffusione?

La memoria è un affare complesso, sia individuale che collettivo.

NOTE

[1] Tim. 42 d - segg. e 69 c - segg.

[2] Centrone, B. 1996, Introduzione a i pitagorici, Editori Laterza, Roma-Bari, pp. 52-61

[3] Resp. 614 b - 621 d

[4] Tim. 26 b

[5] Phaedr. 228 a

OpenAI e Sam Altman - Anatomia di un Qomplotto (prima parte)

Si è molto parlato (nelle scorse settimane) del licenziamento di Sam Altman, amministratore delegato di OpenAI, un laboratorio di ricerca sull'intelligenza artificiale costituito dalla società no-profit OpenAI, Inc. e dalla sua sussidiaria for-profit OpenAI, L.P. L'obiettivo dichiarato della sua ricerca sarebbe promuovere e sviluppare un'intelligenza artificiale amichevole (friendly AI) in modo che l'umanità possa trarne beneficio.

Cerchiamo di ricostruire la vicenda.

1. AMERICAN HISTORY Q

Nella cultura americana contemporanea la Q non è una lettera come le altre, perché esercita una forza mitopoietica di cui il resto dell’alfabeto è privo.

Il 6 gennaio 2021 coloro che assaltano la sede del Congresso a Washington brandiscono bandiere con la Q di QAnon: la teoria del complotto universale che per milioni di persone negli USA (e nel resto del mondo) ha trasformato Donald Trump in un supereroe da fumetto contro i poteri occulti del deep state.

Il 22 novembre 2023 la «Reuters» spiega che il licenziamento di Sam Altman da parte del consiglio di amministrazione di OpenAI sarebbe stato giustificato da una lettera di delazione[1], con cui alcuni dipendenti dell’azienda hanno illustrato ai membri del board i pericoli per l’umanità in agguato nelle prossime versioni di ChatGPT.

Il progetto Q* ha appena superato con successo i primi test e si prepara a liberare nel mondo un’AGI – un’intelligenza artificiale generale – armata di una competenza letteraria vasta quanto l’universo, che include le storie sul Golem e sulle altre hybris del genere Frankenstein.

L’assalto al Campidoglio non ha avviato la guerra civile; la minaccia che dai progressi dei software di OpenAI si inneschi l’«esplosione» di un’intelligena artificiale destinata a sostituire l’uomo nel dominio della Terra confida su una probabilità nulla di avverarsi.

La destituzione di Altman, avvenuta il 18 novembre, è un evento simile ad un colpo di stato; anche più di quello tentato dallo Sciamano e dai suoi compagni al Campidoglio nel gennaio 2021, se si considera che OpenAI ha beneficiato di un investimento di 13 miliardi di dollari da parte di Microsoft[2], equivalente al doppio del PIL della Somalia, superiore a quello di un’altra decina di nazioni africane, e pari a quello dell’Armenia, del Madagascar e della Macedonia.

Il finanziamento è in larga parte da ascrivere al rapporto di fiducia tra Kevin Scott, CTO di Microsoft, e Altman; la sua cacciata non è stata preceduta da alcun segnale di crisi, e si è consumata in una fase di espansione e di prosperità dell’azienda.

ChatGPT 3.5 si è laureato nel gennaio 2023 come il servizio internet con la crescita di utenti più veloce di sempre: in soli due mesi dal lancio ha raggiunto la quota di 100 milioni di utenti attivi[3], bruciando in questa competizione il risultato di TikTok (nove mesi) e quello di Instagram (due anni e mezzo).

Il trionfo ha imposto il tema dell’intelligenza artificiale e delle reti neurali all’attenzione del pubblico di massa, ma ha anche riconsegnato a Microsoft una posizione di primato tra le protagoniste dell’innovazione tecnologica.

Il motore di ChatGPT è stato integrato in Bing, e il suo inserimento strutturale nei prodotti di Office (con il marchio «Copilot») è in fase di sperimentazione avanzata.

Trasformerà il rapporto dei colletti bianchi di tutto il pianeta con i loro computer, convertendo in automatico poche idee scarabocchiate con un elenco puntato in un documento di cinque pagine, o in una presentazione Power Point attrezzata di tutto punto; per converso, sarà capace di tradurre il vaniloquio di ore di riunione in un report agile da condividere via mail, e gestirà le operazioni di controllo delle entrate e delle uscite su Excel.

Tuttavia, i burocrati diventeranno ancora più fannulloni, gli impiegati ancora più analfabeti, e Microsoft gioirà sulle disgrazie umane con un valore di mercato anche più immenso di quello attuale.

Quindi siamo di fronte a un caso di «Q di Qomplotto», per usare un’espressione presa in prestito dall’analisi del caso Qanon elaborata da Wu Ming 1 (2023)?

2. INTELLETTUALI E IMPRENDITORI

La stupidità spiega molti più misteri del retropensiero, e persino più della serietà del giornalismo di inchiesta.

Potrà sembrare un paradosso, ma lo scenario dei profitti smisurati e la prospettiva di una nuova forma di dominazione culturale sulla produzione dei contenuti business, sono all’origine del colpo di mano del CDA contro Altman.

La governance di OpenAI presentava fino al 18 novembre una configurazione ereditata dalla missione originaria della società, fondata sulla strategia «open source» di Altman, Elon Musk e Peter Thiel[4]: il metodo per assicurare un progetto di intelligenza artificiale a beneficio dell’umanità, e priva di rischi per il futuro, coincide con lo sviluppo di modelli accessibili a tutti, quindi sottoposti al controllo dell’intera comunità degli esperti. Anche dopo l’uscita di Musk dal consorzio, e la maggiore integrazione in Microsoft dal 2020, il comparto di OpenAI destinato alla produzione di servizi for-profit è rimasto sottoposto allo scrutinio di un consiglio di amministrazione nominato dalla componente no-profit.

Nel novembre 2023 il board annoverava oltre ad Altman altri quattro personaggi: Helen Toner, Ilya Sutskever, Adam D'Angelo, Tasha McCauley. Toner ha maturato una carriera di primo piano nell’ambito delle organizzazioni umanitarie grazie al suo coinvolgimento nel movimento accademico dell’«altruismo efficace»[5], che si richiama alla lezione dei filosofi morali Peter Singer, Toby Ord, William MacAskill, e che esercita un’influenza di ampio respiro sull’upper class americana.

Dai temi della beneficienza e del miglioramento delle condizioni di vita nei Paesi più poveri del pianeta, questa corrente di pensiero è passata alla riflessione sulle professioni meritevoli di essere intraprese, e si è estesa ai «rischi esistenziali» e ai «rischi di catastrofe globale»; con una forte vocazione di futurologia che oscilla tra parossismo e parodia (involontaria) del «principio responsabilità» di Hans Jonas (1979).

In questo contesto viene intercettato l’insegnamento di Nick Bostrom (2014), che arruola tra i propri fedeli anche McCauley e Sustkever, nonostante la loro formazione tecnica di altissimo livello, e li allea alle preoccupazioni di Toner. Le tesi di Bostrom sulle «superintelligenze» sono molto famose, anche grazie alle metafore che ha inventato per rendere più persuasiva la distopia che alimenta la sua ansia: mancano pochi anni all’esplosione delle capacità di raziocinio delle intelligenze artificiali, che travolgeranno quelle naturali per velocità, vastità e precisione di intuizione, quantità di memoria, organizzazione e controllo; ma l’attivazione delle loro facoltà produrrà più conseguenze rovinose per l’umanità rispetto a quelle utili.

Qualunque sia lo scopo cui sarà indirizzata, ciascuna superintelligenza tenderà in modo necessario a perseguire comportamenti utili per la propria sopravvivenza e per il raggiungimento degli obiettivi che compongono la sua ragion d’essere: in primo luogo attraverso l’affinamento della potenza di calcolo e della raccolta di risorse necessarie. Di conseguenza, la macchina cui sarà assegnato, per esempio, il compito di creare graffette, agirà in modo da ottimizzare al massimo l’ambiente a questo scopo, riducendo la Terra intera a un deposito di materiale lavorabile e di graffette già confezionate – genere umano incluso.

L’iperbole di Bostrom potrebbe implicare una critica al modello liberistico della visione del mondo, in cui la razionalità coincide con una subordinazione degli elementi della natura e del lavoro dell’uomo (tutti convertiti in risorse) agli obiettivi di produzione, senza alcun interesse per l’orizzonte di senso in cui il processo dovrebbe essere calato. Questo genere di valutazione può incrociare l’allarme per le conseguenze che l’automazione introdotta dal Copilota nella suite Office potrà determinare nelle facoltà di riflessione, di elaborazione strategica, persino di articolazione linguistica, di gran parte degli impiegati e dei dirigenti del mondo.

Di certo si può paventare una scivolata nel processo di proletarizzazione tecnologica degli individui (di tutte le fasce sociali) impegnati in una professione di tipo intellettuale, almeno nei termini di Stiegler (2012). Ma la furia distopica di Bostrom non si placa a così poco prezzo: brama molto di più di una situazione critica che potrebbe suscitare un dibattito serio; esige che la conversione degli esseri umani nei cervelli in una vasca di Putnam (1981) diventi un canovaccio plausibile, il paradigma delle minacce reali.

Per il CDA di OpenAI il passaggio dal Copilota alle graffette è fin troppo breve; tanto più che Microsoft ha già attentato alla pazienza dell’umanità con Clippy dal 1996 al 2007, il mostruoso assistente di Office a forma di graffetta antropomorfa. È bastato un incidente qualunque nel rapporto tra Altman e Toner per innescare i cinque giorni di crisi che negli uffici di Seattle sono stati battezzati, senza alcun aiuto di copywriting da parte di ChatGPT, il Turkey-Shoot Clusterfuck di OpenAI.

Appena annunciata la notizia della deposizione di Altman, la piattaforma Reddit è stata presa d’assalto da un tumulto di commenti[6] e tentativi di interpretazione del colpo di mano ai vertici di OpenAI, molti dei quali in chiave di Qomplotto. Q* è davvero la culla dell’AI che ci trasformerà tutti in graffette? È il Clippy odioso che abita dentro ciascuno di noi, la nostra anima di silicio?

Lo sapremo a breve, con un nuovo post.

NOTE

[1] https://www.reuters.com/technology/sam-altmans-ouster-openai-was-precipitated-by-letter-board-about-ai-breakthrough-2023-11-22/

[2] https://www.newyorker.com/magazine/2023/12/11/the-inside-story-of-microsofts-partnership-with-openai

[3] https://www.reuters.com/technology/chatgpt-sets-record-fastest-growing-user-base-analyst-note-2023-02-01/

[4] https://www.nytimes.com/2015/12/12/science/artificial-intelligence-research-center-is-founded-by-silicon-valley-investors.html

[5] https://it.wikipedia.org/wiki/Altruismo_efficace

[6] https://www.reddit.com/r/singularity/comments/181oe7i/openai_made_an_ai_breakthrough_before_altman/?rdt=54043

Un manager utilitarista - Il management scientifico alla prova dei fatti

Negli ultimi mesi ho modo di vedere l’etica utilitarista messa in opera da parte di un gruppo di manager di un’azienda multinazionale.

Non parlo di attitudini caratteriali o di comportamenti specifici che ognuno di noi può avere, parlo proprio di un’impostazione che permea il pensiero, le parole, le azioni e le decisioni dell’individuo.

Parlo di un qualcosa di sistematico che, se applicato alla conduzione di un’azienda, può a ragion veduta definirsi management scientifico: c’è un metodo standard, c’è uno stile manageriale reiterabile, c’è l’estrema specializzazione del lavoro che – in ultima istanza – porta alla piena fungibilità dello stesso.

E la prima volta che mi capita di osservare una cifra etica così netta e chiara; e la cosa non va sottovalutata, perchè tutta la storia della globalizzazione degli ultimi 250 anni si basa su questa etica.

Volete sapere come me ne sono accorto?

Eccovi alcuni esempi.

Il manager utlitarista presenta i risultati di fine esercizio senza commentare neanche un numero della situazione attuale, e concentra tutto l’intervento sul nuovo livello di aspettative del mercato, sulla propria visione strategica e su cosa fare per migliorare la propensione degli investitori.

Cosa è stato raggiunto o fallito nel passato non conta; conta la decisione, adesso, decontestualizzata dalle ragioni che hanno portato ad un determinato stato dell’arte.

Il passato conta solamente in quanto deve essere rimesso in discussione, ma attenzione: non lo si rimette in discussione, per preconcetto o per dare un messaggio di discontinuità.

Lo si rimette in discussione perché è eticamente giusto farlo, perchè il processo decisionale passa dal discreto al continuo, e l’esistenza stessa dell’individuo è un continuo decidere e rielaborare la decisione.

Non a caso il manager utilitarista dichiara sin dall’inizio che sì, è vero, esiste un piano strategico, ma che poi all’interno di tale piano si può (anzi si deve) cambiare direzione n+1 volte.

Certo che è strano: una scienza basata sulle aspettative e non sulla accumulazione delle esperienze...mai vista!

Ma forse sì, se la si applica al management di azienda può essere sostenibile... sicuramente l’utilitarismo consente di fare un passo avanti rispetto ai nostri stereotipi…

Poi, il manager utilitarista identifica dal mercato i propri collaboratori, manager a riporto diretto, presentandoli come il meglio possibile per l’azienda, e rimuovendoli dopo poche settimane senza neanche sentirsi in dovere di spiegare il perchè e cosa sia cambiato rispetto al loro ingresso di poco tempo prima.

Il fatto che ogni ingresso a quei livelli comporti l’avvio di riorganizzazioni aziendali e di nuove relazioni personali non conta, visto che per lui è uguale essere a capo dell’azienda X o dell’azienda Y, sono invarianti anche i nomi dei propri collaboratori e i diversi possibili set up organizzativi.

Tutto è pienamente fungibile, quando si deve massimizzare l’utilità.

Questa me la spiego facilmente dai... il sapere scientifico deve essere invariante rispetto all’individuo, altrimenti è soggettivo; giusto, giusto, sarà per questo che le organizzazioni del manager utilitarista sono tutte piatte: un vertice (il manager stesso), un “cerchio della fiducia” di poche decine di eletti, e migliaia di persone appiattite.

Ah, un attimo, c’è qualcosa che non torna... la scienza applicata all’azienda prevede una struttura piramidale ben definita, qui invece abbiamo: un triangolo, uno spazio bianco, e un grandissimo trapezio sotto. Che roba è? Mi sembra quasi che si sia passati dalla massimizzazione del profitto di azienda alla massimizzazione del profitto individuale. Ma forse, anzi sicuramente, mi sto sbagliando....

Ancora: il manager utilitarista trasforma in valore economico anche le ultime categorie che erano rimaste non oggetto di scambio: l’ambiente e l’identità sessuale.

Essendoci un legame diretto tra massimizzazione dell’utilità e valore degli scambi, negli ultimi anni si stava osservando un problema abbastanza serio per l’utilitarismo: era finito il genere di item passibili di scambio.

E allora ecco che il manager utilitarista definisce come oggetto di scambio, e quindi portatore di valore da massimizzare, cose che prima non lo erano: l’aria, l’acqua, l’identità di genere, e gli dà un nome: ESG.

L’ossigeno? Lo si produce forestizzando i terreni pastorizi del Paese X, lo si “impacchetta” e lo si vende a lotti virtuali alle aziende che inquinano nel Paese Y.

Il pride? Rappresenta un target di clientela nuovo, interessante: e allora perchè non fare un’analisi delle abitudini di spesa dei partecipanti, venderla al Comune ospitante, che così decide i percorsi dei cortei in modo da ottimizzare la presenza degli esercizi commerciali che rispondono a tali abitudini di spesa?

Tutto è pienamente scambiabile, quando si deve massimizzare l’utilità.

La Data Science applicata al management di azienda, ecco: questo è uno spunto veramente “scientifico”! Certo, il fatto che si basi su una funzione che tende asintoticamente a zero, perchè prima o poi gli oggetti di scambio finiranno veramente, potrebbe far pensare che non mi stessi sbagliando poi tanto con la mia precedente impressione...chissà!

In ultimo: il manager utilitarista ci dice che il futuro della cultura è nel Metaverso e nella Generative AI: nuove esperienze, felicità garantita, poter essere contemporaneamente in più luoghi senza essere realmente da nessuna parte.

Non è ancora chiaro cosa muova il manager utilitarista: forse la massimizzazione dell’utilità e della felicità individuale; forse lo spirito “scientifico”.

Quello che non ho ancora capito è qual’è il vantaggio per il manager utilitarista: mi auguro che lo scopo sia, anche qui, semplicemente quello di avere un nuovo item oggetto di scambio; mi auguro a questo punto che sì, le impressioni che ho manifestato in precedenza fossero corrette, e che ce la caviamo banalmente dicendo che l’utilitarismo applicato in un’azienda “scientificamente” organizzata porta solo alla massimizzazione del valore per un singolo individuo.

Non è bello ma me lo auguro perchè, se così non fosse, se ci fosse qualche altro razionale, gli effetti finali potrebbero essere ben più devastanti.

Sostenibilità - Una sfida scientifica, tecnologica e sociale per le aziende

Da qualche anno si parla tantissimo di sostenibilità e di sviluppo sostenibile, ma di cosa parliamo esattamente?

Il concetto di sviluppo sostenibile è stato fissato dalla Commissione Brundtland (Onu) nel rapporto “Our common future” del 1987. In quel rapporto si parlava della necessità di garantire il benessere delle generazioni future, letteralmente: “Lo sviluppo sostenibile è quello sviluppo che consente alla generazione presente di soddisfare i propri bisogni senza compromettere la possibilità delle generazioni future di soddisfare i propri”.

A partire da quegli anni ci si è resi conto che gli squilibri tra il nord e il sud del mondo non erano più accettabili e che il modello di sviluppo del mondo industrializzato non poteva durare per i danni ambientali e sociali che portava con sé.

È nato quindi il concetto di sostenibilità basato su tre pilastri: la sostenibilità economica, ambientale e sociale; tre aree di intervento che sono chiaramente interconnesse fra loro. E dai primi anni 90 in poi l’argomento è diventato sempre più al centro del dibattito internazionale e sempre più diffuso anche tra il grande pubblico.

Vediamo di fare qualche considerazione sull’oggi centrata sul nostro Paese:

- La sostenibilità è uscita dal recinto del dibattito per tecnici ed è diventata anche un driver di business per le imprese

- Per le imprese è un elemento di rafforzamento della corporate reputation ma può diventare argomento pericoloso e scivoloso, quelle che sbandierano le loro virtù sostenibili sono anche le più vulnerabili ad attacchi mediatici per come agiscono