La concezione tecnologica del vivente: dalla partenogenesi artificiale alla biologia sintetica - Prima parte

Nel corso della storia della biologia sono emerse diverse concezioni su cosa sia un essere vivente. Ci si è spesso chiesti come distinguere ciò che è vivo da ciò che non lo è, da cosa è composta la materia vivente, come è organizzata e da dove deriva questa organizzazione. Gli antichi materialisti, per esempio, sostenevano che gli esseri viventi nascessero per generazione spontanea, cioè da un incontro casuale di determinati tipi atomi e da una sorta di “selezione naturale” che lasciava persistere solo quei composti atomici, e quindi quelle forme, che si inquadravano in certi tipi di ambiente. Aristotele, nelle sue principali opere filosofiche e biologiche, rifiutò l’idea che l’organizzazione degli esseri viventi potesse essere frutto dell’incontro fortuito di atomi. L’organizzazione biologica richiedeva per Aristotele un principio ordinatore: un’anima che dava forma alla materia, ne permetteva la riproduzione e ne garantiva la permanenza.

Dalla critica di Aristotele alla concezione materialistica nacque così un’altra visione del vivente: quella ilemorfica. Questa visione non solo affermava che un organismo era costituito di materia e forma, ma supponeva anche che in un essere vivente “il tutto era maggiore della somma delle sue parti”, ove il “tutto”” doveva spiegare perché le parti si organizzano in un modo e non in un altro. Il “naturalista” Aristotelico doveva pertanto studiare i fenomeni biologici partendo da quella “totalitá”, cioè dalle funzioni, dagli scopi e fini che spiegano la persistenza e conformazione della materia. Questo paradigma rimarrà dominante fino all’età moderna, quando un autore spagnolo ancora poco conosciuto, il medico medinense Gómez Pereira, propose, in un testo alquanto oscuro, intitolato Antoniana Margarita e pubblicato nel 1554, un’idea diversa: il principio organizzatore, cioè l’anima, esiste solo negli esseri umani. Animali, piante e organismi in generale, secondo Pereira, sarebbero semplici macchine e andrebbero studiati come tali. Cartesio riprenderà questa intuizione e ne farà un vero e proprio programma di ricerca. Un programma che conobbe un discreto successo, suscitando numerose critiche e controversie fino ai nostri giorni.

Si può senz’altro sostenere che la concezione meccanicistica sia, in realtà, già una concezione tecnologica, nella misura in cui trae ispirazione dalle macchine. Il meccanicismo, dopotutto, prende le sue mosse dalla costruzione di macchine: orologi, automi, fontane automatiche e dispositivi dedicati alla produzione. Tuttavia, come si cercherà di mostrare in ciò che segue, esistono differenze fondamentali tra la concezione meccanicistica classica e la concezione tecnologica che emergerà nel XX secolo, anche se entrambe condividono l’idea che il fare o costruire sia il principio cardine del conoscere. Per avvicinarsi alla concezione tecnologica che sto qui delineando, propongo quindi di considerare altre due coordinate fondamentali, oltre a quella d’ispirazione cartesiana. Si tratta, cioè, del passaggio da una scienza delle ipotesi a una scienza dei dati, e del carattere essenzialmente promissorio di questa visione, che alimenta aspettative riguardo a future soluzioni tecniche volte alla trasformazione direzionata del vivente in tutti i suoi aspetti. In sintesi, sostengo che la concezione tecnologica del vivente si collochi nello spazio delimitato da tre coordinate principali (pur senza escluderne altre possibili): fare, codificare e promettere.

Partiamo dalla prima coordinata. Un testo fondamentale che andrebbe riconsiderato è La concezione meccanicista della vita pubblicato nel 1912. L’autore è il fisiologo statunitense Jacques Loeb. In estrema sintesi, il libro di Loeb afferma due cose principali: primo, la vita è totalmente riducibile a fenomeni fisico-chimici; e secondo, l’obiettivo della biologia deve essere la creazione e il controllo dei fenomeni viventi. La biologia, dunque, non dovrebbe più appartenere al campo delle scienze naturali, ma collocarsi nell’ambito più concreto dell’ingegneria. Loeb giustifica le proprie conclusioni richiamando uno dei suoi esperimenti più celebri: quello sulla partenogenesi artificiale, in cui riuscì a indurre lo sviluppo di uova di riccio di mare senza fecondazione, ma tramite determinati stimoli fisico-chimici (soluzioni saline e cloruro di magnesio). Egli interpretò questo risultato come una prova decisiva del fatto che la vita potesse essere manipolata e attivata artificialmente. Il suo intento era dimostrare che, in linea di principio, tutti i processi vitali potevano essere ricondotti a meccanismi chimico-fisici, riproducibili e controllabili in laboratorio.

Come era prevedibile, le conclusioni di Loeb suscitarono numerose reazioni e controversie. Basti ricordare la reazione del biologo statunitense e primo direttore dello Scripps Institution of Oceanography, William Emerson Ritter. Nel 1919, dunque 7 anni dopo la pubblicazione del libro di Loeb, Ritter diede alle stampe un testo polemico intitolato The Unity of the Organism; Or, The Organismal Conception of Life. Nel testo, Ritter sosteneva che la concezione “meccanicistica” di Loeb dovesse essere sostituita da una concezione “organicista”. Le entità biologiche, infatti, non sono riducibili ai soli processi fisico-chimici, poiché possiedono proprietà emergenti che vanno considerate nella loro totalità. Il progetto di un’ingegnerizzazione del vivente si scontrava, secondo lui, con l’estrema complessità e flessibilità degli organismi. La concezione organicista da lui difesa poneva l’accento sull’unità e integrità delle entitá organiche. Il vivente costituiva una categoria ontologica autonoma, estranea a ogni riduzione ingegneristica. Inoltre, Ritter contrapponeva all’ideale di una scienza puramente sperimentale, orientata all’ingegneria del vivente, una visione più tradizionale delle scienze naturali, intese come discipline fondate sull’osservazione diretta dei fenomeni naturali.

Non c’è dubbio che, al di là delle differenti prospettive e sensibilità scientifiche e intellettuali, tra Loeb e Ritter esistessero anche divergenze politiche. Se Loeb rappresentava una visione tecnocratica, convinta che il progresso sociale e politico dovesse passare attraverso il controllo della vita stessa, Ritter, al contrario, rappresentava una visione più sistemica e “democratica”, in cui la biologia costituiva un sapere importante, ma non esclusivo, nella gestione dell’essere umano e della società. Non è un caso, per esempio, che Ritter fosse anche un critico acerrimo di ogni forma di determinismo genetico, che egli considerava una manifestazione di fatalismo.

La controversia tra Loeb e Ritter, infatti, si sviluppa in un momento storico particolare. Come sostiene David F. Noble nel suo libro America by Design (1977), negli Stati Uniti di fine Ottocento e inizio Novecento si generò una tensione tra le scienze naturali tradizionali e le nuove professioni emergenti legate alle “arti” applicate. In questo contesto, la professione dell’ingegnere acquisisce un prestigio crescente. A partire dal 1860, Università come il MIT, Harvard e Yale istituiscono corsi di scienze applicate, mentre grandi industrie come General Electric, DuPont ed Eastman Kodak fondano laboratori di ricerca propri, assumendo scienziati formati nelle università tradizionali con l’obiettivo di sviluppare nuove tecnologie. Nasce cosí quello che Noble definisce “science-based industry”. È in questo contesto storico che l’aggettivo “ingegneristico” assume un significato particolare. Quando Loeb parla di “biologia ingegneristica”, intende affermare che la biologia deve appartenere alle scienze produttive, cioè a quelle discipline capaci di trasformare materiali e processi vitali a fini umani. In altre parole, la biologia deve trovare il proprio posto all’interno di questa “science-based industry”. A posteriori, si può affermare che la visione ingegneristica di Loeb abbia avuto un successo di gran lunga superiore rispetto a quella di Ritter, che è rimasta piuttosto marginale (anche se non è mai scomparsa).

Un esempio significativo che ha sancito il successo di questa visione loebiana è rappresentato dalla biologia molecolare. Come mostra Lily Kay nel suo libro The Molecular Vision of Life (1993), questa disciplina fu plasmata non solo da esigenze interne alla scienza, ma anche da contesti ideologici e istituzionali. Gia a partire dagli anni trenta del XX secolo, fondazioni come la Rockefeller e istituzioni come il Caltech promossero una visione riduzionista, meccanicistica e orientata al controllo, che in seguito sarebbe entrata in sintonia con le logiche della Guerra Fredda. In un altro volume, Who Wrote the Book of Life? A History of the Genetic Code (2000), Kay analizzò lo sviluppo delle scienze della vita nel secondo dopoguerra, mettendo in evidenza l’emergere di metafore derivate dalla teoria dell’informazione e dall’ingegneria, che, secondo l’autrice, influenzarono profondamente la biologia, sia prima sia dopo la scoperta della struttura molecolare del DNA nel 1953. La concezione del DNA come “codice”, ovvero come un insieme di informazioni discrete contenute nelle macromolecole che costituiscono il materiale ereditario, deve molto all’ingegneria dell’informazione. L’organismo stesso viene così concepito come un sistema di input e output governato da leggi prevedibili. Come sottolinea Kay, la metafora del “codice” non è mai stata neutrale ma ha condizionato lo sviluppo della disciplina stessa. Tuttavia, tale “visione molecolare” ha spesso ignorato le complessità ambientali, epigenetiche e sistemiche che caratterizzano i fenomeni viventi.

La prossima settimana analizzeremo la seconda e la terza coordinata, codificare e promettere.

L’orologio dell’apocalisse e il pericolo della guerra atomica

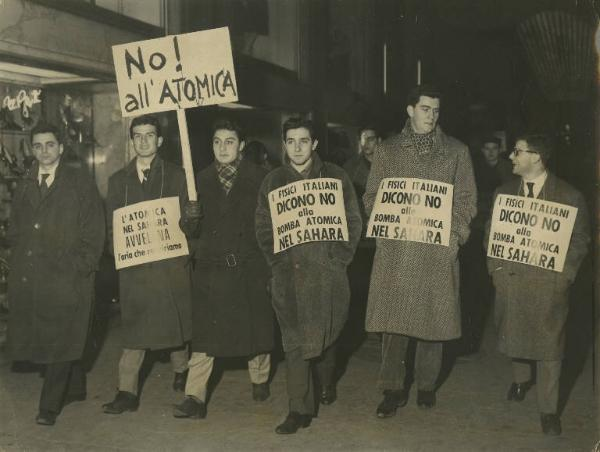

Roberto Fieschi (classe 1928), professore emerito dell’Università di Parma, è un fisico italiano e insieme a figure come Angelo Baracca (scomparso due anni fa) è stato fin dagli anni Sessanta, e ancora oggi, un campione della lotta per la pace e contro la proliferazione delle armi nucleari. È autore di numerosi libri, tra i quali segnaliamo l’importante Macchine da guerra. Gli scienziati e le armi, insieme a C. Paris De Renzi (Einaudi, 1995) e, recentissima, una Breve storia della bomba. La nascita delle armi nucleari 1938-1955, Fiorenzo Albani Editore, 2023.

L'articolo ci è stato cortesemente concesso da "Ideeinformazione" che l'ha pubblicato a marzo di quest'anno.

dal Amico di lunga data di Piero Basso e del collettivo Ideeinformazione, ci ha inviato questo articolo (pubblicato anche sulla rivista online “Striscia rossa”), che volentieri proponiamo ai nostri lettori

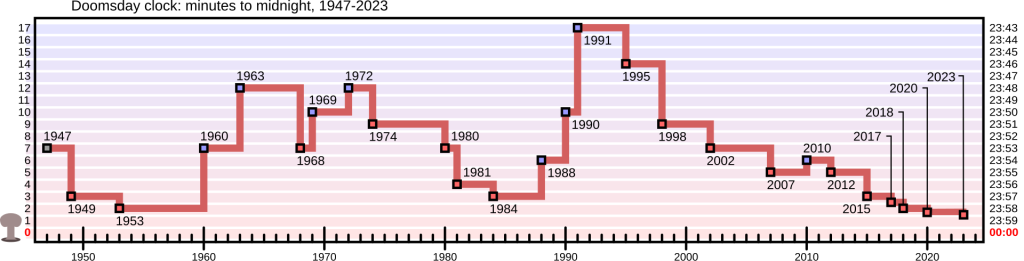

Il Bulletin of the Atomic Scientists è stato fondato nel 1945, dopo il bombardamento atomico di Hiroshima e Nagasaki, da scienziati che avevano contribuito a sviluppare le prime armi atomiche nel Progetto Manhattan. Obiettivo: informare sui pericoli di una guerra atomica. Per descriverne il rischio, il Bulletin inventò l’Orologio dell’apocalisse (Doomsday Clock – 1947), orologio metaforico che misura il pericolo di un’ipotetica fine del mondo a cui l’umanità è sottoposta: la mezzanotte simboleggia l’apocalisse, i minuti precedenti rappresentano la distanza ipotetica da tale evento. La posizione originale, nel 1947, era di sette minuti alla mezzanotte.

Il Clock trasmette le minacce all’umanità e al pianeta ed è diventato un indicatore universalmente riconosciuto della vulnerabilità del mondo alla catastrofe globale causata dalle tecnologie create dall’uomo.

Il Doomsday Clock viene impostato ogni anno, consultando anche vari premi Nobel.

La lancetta dei minuti dell’Orologio venne spostato verso mezzanotte per la prima volta nel 1949, in seguito al test nucleare sovietico.

Nel corso degli anni, a fronte dell’evoluzione della situazione mondiale, l’orologio si è allontanato o avvicinato alla mezzanotte; il momento di minor pericolo si è avuto nel 1991 alla fine della guerra fredda (17 minuti) per poi via via aggravarsi negli anni successivi fino a raggiungere nel 2023 l’estremamente pericolosa distanza di soli 90 secondi.

L’immagine mostra l’evoluzione delle indicazioni del Clock.

2025 – DICHIARAZIONE DELL’OROLOGIO: MANCANO SOLO 89 SECONDI ALLA MEZZANOTTE. E’ IL MOMENTO PIÙ VICINO ALL’APOCALISSE CHE CI SIA MAI STATO.

Dall’ultimo Bollettino del Consiglio per la scienza e la sicurezza degli scienziati atomici:

“Nel 2024, l’umanità si è avvicinata sempre di più alla catastrofe. Le tendenze che hanno profondamente preoccupato lo Science and Security Board sono continuate e, nonostante i segnali inequivocabili di pericolo, i leader nazionali e le loro società non sono riusciti a fare ciò che era necessario per cambiare rotta.

Di conseguenza, ora spostiamo l’Orologio dell’apocalisse da 90 a 89 secondi alla mezzanotte, il momento più vicino alla catastrofe che ci sia mai stato. La nostra fervente speranza è che i leader riconoscano la difficile situazione esistenziale del mondo e adottino misure coraggiose per ridurre le minacce poste dalle armi nucleari, dal cambiamento climatico e dal potenziale uso improprio della scienza biologica e di una varietà di tecnologie emergenti.

Spostando l’Orologio di un secondo più vicino alla mezzanotte, inviamo un segnale forte: poiché il mondo è già pericolosamente vicino al precipizio, uno spostamento anche di un solo secondo dovrebbe essere interpretato come un’indicazione di pericolo estremo e un avvertimento inequivocabile che ogni ritardo nell’inversione di rotta aumenta la probabilità di un disastro globale.

Continuare ciecamente nel percorso attuale è una forma di follia. Gli Stati Uniti, la Cina e la Russia hanno il potere collettivo di distruggere la civiltà. Questi tre paesi hanno la responsabilità primaria di salvare il mondo dall’orlo del baratro, e possono farlo se i loro leader avviano seriamente discussioni in buona fede sulle minacce globali. Nonostante i loro profondi disaccordi, dovrebbero fare quel primo passo senza indugio. Il mondo dipende da un’azione immediata.

Mancano 89 secondi a mezzanotte.”

VEDIAMO I PRINCIPALI AVVENIMENTI CHE GIUSTIFICANO L’ALLARME DEL BULLETIN.

La guerra in Ucraina potrebbe diventare nucleare in qualsiasi momento a causa di una decisione avventata o per un incidente o un errore di calcolo; Vladimir Putin ha minacciato l’Occidente di usare le armi nucleari “in risposta alla guerra della Nato”. La Russia ha cambiato la dottrina nucleare: potrà usare l’arma atomica per difendersi, anche quando dovesse essere minacciata da un Paese non nucleare ma appoggiato da un Paese nucleare (prima d’ora l’impiego della bomba nucleare era ammesso solo come risposta a un attacco con armi nucleari o di distruzione di massa). Armi nucleari tattiche russe sono state installate in Bielorussia, le trattative per il controllo e la riduzione delle armi nucleari (Trattato New Start) sono arenate; la Duma russa ha votato per ritirare la ratifica del Trattato di messa al bando totale degli esperimenti nucleari; l’Iran continua ad aumentare le proprie scorte di uranio altamente arricchito. L’arsenale nucleare cinese è cresciuto fino a circa 600 testate; gli Stati Uniti sono impegnati nella modernizzazione nucleare più costosa al mondo.

La guerra in Medio Oriente minaccia di estendersi; in questi ultimi giorni Donald Trump è arrivato a sostenere “Gli Stati Uniti prenderanno il controllo di Gaza, un controllo a lungo termine che porterà stabilità al Medio Oriente… i palestinesi devono lasciare Gaza e vivere in altri Paesi in pace.” Vuole espellere 1.700.000 persone dalla loro terra: questa si chiama pulizia etnica.

Ci auguriamo che le minacce di Putin siano un bluff, anche perché l’impiego di bombe atomiche tattiche su un fronte molto esteso, con bassa densità di uomini e mezzi bellici, sarebbe poco efficace. Tuttavia il segnale è allarmante.

L’unica iniziativa di controllo delle armi nucleari è stata la proposta della Cina: estendere un trattato sul reciproco non-uso-per-primi di armi nucleari; proposta che non ha ricevuto risposta. Nell’ottobre 2024, Sun Xiaobo (direttore del Dipartimento per il controllo degli armamenti del Ministero degli affari esteri della Cina) ha affermato al dibattito generale della Prima commissione dell’Assemblea generale delle Nazioni Unite: “Gli stati dotati di armi nucleari dovrebbero negoziare e concludere un trattato sul reciproco non-primo-utilizzo delle armi nucleari o rilasciare una dichiarazione politica al riguardo, al fine di prevenire la corsa agli armamenti nucleari e ridurre i rischi strategici”. Queste aperture al “no-primo-utilizzo”, tuttavia, non hanno ricevuto risposta dagli altri quattro membri permanenti del Consiglio di sicurezza delle Nazioni Unite.

COME RIPORTARE INDIETRO L’OROLOGIO

Lo scopo del Doomsday Clock è quello di avviare una conversazione sui rischi prima che sia troppo tardi. Continuare ciecamente sul percorso attuale è una forma di follia. Gli Stati Uniti, la Cina e la Russia nonostante i loro profondi disaccordi hanno la responsabilità primaria di salvare il mondo dall’orlo del baratro.

E NOI, POSSIAMO DARE UN NOSTRO CONTRIBUTO ALLA DISTENSIONE E ALLA SICUREZZA?

Si deve trovare il modo di rendere consapevoli i governi, a cominciare dal nostro, del rischio derivante dagli arsenali di armi nucleari.

A Roma alcuni europarlamentari insieme a rappresentanti di alcune associazioni (inclusa RUniPace) si sono riuniti per delineare una strategia comune per la pace e il disarmo.

Il gruppo No-first-Use Global ha diffuso l’appello in cui si sottolinea che i governi sono sorprendentemente non preoccupati (unconcerned) dal rischio di una guerra nucleare. Un primo passo per ridurre tale rischio sarebbe l’adozione di una politica del non primo uso dell’arma atomica (NFU).

Già nel 2021 l’Unione scienziati per il disarmo (USPID) aveva lanciato un appello al Parlamento italiano a favore del concetto di NFU.

Un gruppo di giornalisti ha lanciato un appello: alla radio e in TV i pacifisti sono sistematicamente assenti. Facciamo sentire la voce della pace nei dibattiti!.

Ma nel complesso le reazioni della società e della politica sono scarse.

Recensione di Oltre la tecnofobia, il digitale dalle neuroscienze all’educazione - Prima parte

A maggio di quest’anno è uscito un libro, Oltre la tecnofobia, Il digitale dalle neuroscienze all’educazione di Vittorio Gallese, Stefano Moriggi, Pier Cesare Rivoltella, che – dichiaratamente, fin dal titolo – intende proporre una visione in controtendenza rispetto alla tecnofobia che sta dilagando tra media, common sense, e riflessioni accademiche.

Abbiamo accolto con grande interesse la riflessione critica, acuta e articolata, di Simone Lanza che, con il pretesto di confrontarsi con le tesi degli autori, costruisce un ragionamento parallelo su tematiche quali la metafora del cervello come computer, l’identità di rappresentazione dei mondi analogico e digitale, e il presunto autoritarismo celato da divieti e restrizioni dell’uso delle tecnologie digitali a bambini e ragazzi.

In questo primo articolo presentiamo la sintesi della recensione del libro; nei successivi tre seguiremo il ragionamento analitico di Simone Lanza.

-----

Il saggio di Vittorio Gallese, Stefano Moriggi, Pier Cesare Rivoltella si scaglia contro la tecnofobia, figlia di una lunga tradizione storica che ha visto demonizzare ogni rivoluzione tecnologica “dall’invenzione del fuoco agli smartphone” (p.22), dalla scrittura alfabetica alla fotografia, dal cinema alla televisione, fino all’attuale panico morale. Gli autori si adoperano a smontare con vigore le tesi di Jonathan Haidt (La generazione ansiosa), secondo cui i giovani sarebbero vittime passive di tecnologie portatrici di ansie sociali; a loro avviso, il vero problema non è il digitale ma la paura culturalmente costruita che lo circonda, una nostalgia reazionaria per un passato idealizzato, sostenuta da divieti inefficaci e da un’autorappresentazione sociale che colpevolizza le nuove generazioni.

Il limite più rilevante del saggio è che, credendo di criticare la diffusione della tecnofobia, non analizza il mondo odierno, ben plasmato in profondità dalle piattaforme digitali, che invece mettono a valore le paure sociali, che sono la leva e non la resistenza alla diffusione di massa di queste tecnologie. Il libro, soprattutto, fa un pessimo uso delle sue tre fonti principali chiamate a corroborare l’impostazione teorica: Walter Benjamin, Bernard Stiegler, Paulo Freire. Se quindi in questa recensione si darà eccessivo spazio a questi testi non è tanto per restituire alle tre fonti la loro forza critica, completamente rimossa nel libro in questione, quanto perché questa operazione consolida, con il linguaggio scientifico, una serie di luoghi comuni, che qui si intendono invece sottoporre a critica. Presenterò subito i contenuti.

Nella prima parte (gnoseologica), ispirata alle ricerche delle neuroscienze, gli autori demoliscono la metafora del cervello come computer. L’essere umano è dotato di intersoggettività corporea e i neuroni motori si attivano anche nella percezione di stimoli visivi o tattili senza produrre movimento effettivo. Questa simulazione motoria dimostrerebbe che “i meccanismi cervello-corpo che consentono la nostra relazione fisica e diretta con il mondo (…) e quelli che intervengono nel mondo – analogico e digitale – con cui rappresentiamo il mondo con storie e immagini, sono molto simili” (p.37). Non esiste così una differenza qualitativa o ontologica nel modo in cui “rappresentiamo” (p.41) il mondo perché il primo medium sarebbe il corpo (p.21). Il riferimento principe della prima parte è al filosofo Walter Benjamin, primo critico ad avere compreso che i media trasformano la stessa percezione dell’esperienza del mondo reale. Ne L’opera d’arte al tempo della sua riproducibilità tecnica sostiene che i media (essenzialmente fotografia e cinema) hanno cambiato il modo di percepire il reale.[1] Sulla confusione tra esperienza di mondo di Benjamin con la rappresentazione del mondo si tornerà più avanti, perché questa confusione permette di sovrapporre la rappresentazione del mondo analogico a quella digitale, perdendo di vista la dimensione esperienziale del mondo reale, di cui il virtuale è solo una parte.

Nella seconda parte (ontologica) si sostiene la tesi che l’indistinzione percettiva sia anche costitutiva del reale, cioè che virtuale e reale siano sovrapponibili. Un’idea dura a morire per la resistenza del buon senso umanista a cui i nostri autori contrappongono le tesi del filosofo Bernard Stiegler, per il quale la tecnologia non è esterna all’umano, perché l’evoluzione umana è “tecnologico-umana” (p.23). A ulteriore conferma portano una tesi di Debord riproposta in modo forse impreciso: “tutto ciò che un tempo veniva vissuto direttamente è ora semplicemente rappresentato a distanza (sic).” (p.43). Secondo me, la traduzione corretta è “tutto ciò che era direttamente vissuto si è allontanato in una rappresentazione”. Che poi è proprio ciò che i nostri autori non vogliono capire: lo schermo trasforma (e allontana) il vissuto in rappresentazione, come si vedrà più avanti.[2] In ogni caso la loro argomentazione è che la contrapposizione tra umano e tecnologia sia sterile, storicamente infondata e filosoficamente inadeguata, seguendo le tesi del filosofo francese Bernard Stiegler, in Italia sicuramente non abbastanza riconosciuto. Stiegler elabora da Derrida la nozione di tecnica come pharmakon (veleno e farmaco insieme): come la scrittura per Platone così anche il digitale è intrinsecamente ambiguo potendo avvelenare o curare a seconda della dose.

Questa prospettiva smaschererebbe la tecnofobia umanista, radicata al contrario in una nostalgia metafisica che contrappone artificiosamente l’uomo alla macchina, il naturale al tecnologico. Da questa prospettiva teorica, per altro assolutamente condivisibile, anche alla luce del dibattito filosofico in corso sul post-umano (dibattito non menzionato), si passa però velocemente a polemizzare con le soluzioni di "buon senso" derivate da questa visione semplicista: ecco che il concetto di "benessere digitale" è una trappola che scarica sulle macchine responsabilità umane, mentre i divieti (come gli smartphone vietati sotto i 14 anni, le circolari del Ministero, etc...) ignorano la complessità del rapporto coevolutivo tra essere umano e tecnica. Qui gli autori si buttano nelle braccia dello psicologo Matteo Lancini: per gli adolescenti in ritiro sociale (hikikomori), i media digitali non sarebbero la causa del male, ma il farmaco che evita esiti psicotici, permettendo loro di restare agganciati al mondo. Viviamo ormai in una realtà onlife, dove ogni distinzione tra on line e off line sarebbe obsoleta. Gli autori ci invitano ad "abitare farmacologicamente (e dunque consapevolmente) la catastrofe" (p.107): riconoscere le tossicità del digitale senza rinunciare alle sue potenzialità curative. Questa parte teorizza l’inseparabilità di umano e tecnologico deducendone la polemica contro il buon senso umanista sulle misure da prendere per gli abusi degli smartphone in età adolescenziale. Da un lato polemizzano contro le misure di buon senso dall’altro si limitano a segnalare solo alcune storture delle tecnologie informatiche nominando essenzialmente i rischi dei deepfake e della disinformazione delle fake news che viaggiano più veloci delle notizie vere. Gli autori sono fermamente convinti che “l’avvento dei media digitali ha democratizzato l’accesso alle informazioni” (p. 56) e che “l’ascesa delle piattaforme sociali ha permesso ai politici di interagire direttamente [sic] con gli elettori” (p.57): convinzione quest’ultima che forse alla fine del XX secolo poteva essere anche condivisibile, ma che dopo la Brexit e il ruolo di Cambridge Analytica, per non parlare della fine di ogni regolamentazione avanzata da Trump, suona quanto meno goffa, se non persino collusa.

La critica si fa totalmente pedagogica nella terza parte, dove ogni suggerimento pratico volto a limitare l’uso delle tecnologie è definito autoritario. Per questa operazione si scomoda il pedagogista Paulo Freire citandolo in esergo e avvalendosene nell’argomentazione: secondo gli autori i divieti inibiscono la capacità critica e deresponsabilizzano gli adulti e chi si vuole educare. Portano l’esempio di genitori cattivi che negano le carte Pokémon ai propri figli, i quali finiscono però per riceverle dai loro pari per una sorta di giustizia compensativa, traendo questa conclusione: “i divieti non reggono all’urto dei gruppi di pari” (p.144). L’ansia di controllo – già evidente in Platone con la sua diffidenza verso la scrittura – sarebbe il vero male: vietare informazioni ai minori è un modello fallimentare, poiché il gruppo dei pari compensa sempre le privazioni. Qui proprio gli autori abbracciano una posizione molto netta: “ogni scelta di protezione [sic] o di divieto, in senso proprio, non è educativa” (p.147). Anche qui mi sia lecito approfondire la questione per capire come Freire la pensasse davvero, ma soprattutto se l’antiautoritarismo non sia oggi qualcosa che potremmo ritenere inadeguato nonché anche abbondantemente superato dai dibattiti pedagogici contemporanei sulla crisi dell’autorità genitoriale.

Questo libro ci dà l’occasione per criticare sette luoghi comuni di cui questo manifesto “tecno-ottimista” sarebbe la versione “scientifica”. Lo sforzo dei nostri autori consiste nel convincere che ciò che viene vissuto sia sostanzialmente identico a ciò che viene rappresentato a distanza: stare tutto il giorno davanti a uno schermo sarebbe la stessa cosa che fare esperienze nel mondo reale, a due anni come a novanta, senza curarsi di dire qualcosa di critico sul fatto che ciò che passa oggi attraverso lo schermo è selezionato e personalizzato da algoritmi progettati da un pugno di miliardari che stanno aumentando le loro ricchezze e che non hanno alcuna finalità pedagogica se non quella di modellare i comportamenti di miliardi di persone.

NOTE

[1] Gallese aveva già ampiamente sviluppato queste tesi con M. Guerra in Lo Schermo Empatico. Cinema e Neuroscienze, Milano 2015. Su Walter Benjamin cf. anche: V. Gallese, Digital visions: the experience of self and others in the age of the digital revolution, in “International Review of Psychiatry”, n. 36, 2024, pp. 656–666. Per una ricostruzione analitica di Benjamin mi sia consentito rimandare a: S. Lanza, L’educazione nell’epoca della riproducibilità tecnica. note su Walter Benjamin, in “Quaderni Materialistici”, n. 23, 2024, pp. 155-176

[2] La traduzione della Società dello spettacolo proposta autonomamente dai nostri autori è quanto meno discutibile: meglio sarebbe stato conservare la traduzione dal francese di Stanziale “Tutto ciò che era direttamente vissuto si è allontanato in una rappresentazione [c’est éloigné dans une raprésentation]”. La traduzione di questo passaggio diventa pertanto proprio il tradimento proprio di ciò che Debord denuncia: con la società capitalistica l’esperienza vissuta viene mercificata e sostituita da una rappresentazione, spettacolo è quindi “il movimento autonomo del non-vivente”, etc.… proprio perché Debord auspicava una società diversa capace di usare in modo migliore le tecnologie.