Gemelli digitali – Tutti i modelli sono sbagliati ma alcuni sono utili

Tutti i modelli sono sbagliati ma alcuni sono utili

(George Box)

A dicembre 2024 abbiamo iniziato – con un articolo pubblicato da A. Saltelli con un largo gruppo di coautori - una riflessione sui modelli matematici e algoritmici che simulano la vita e le dinamiche di interi sistemi ambientali, fino a mettersi alla prova sulle dimensioni dell’intero pianeta. Questi modelli sono noti come gemelli digitali di qualcosa.

Seguiamo qui il percorso di un altro articolo di Saltelli, con Lieke Melsen ed Arnald Puy, uscito di recente su Minerva[1], Digital Twins of the Earth Between Vision and Fiction, per proseguire questa riflessione sui gemelli digitali e – più in generale – sull’uso dei modelli di simulazione nella analisi e nei tentativi di soluzione di problemi ambientali e sociali, e cercare una prima, parziale, conclusione di tipo morale.

La definizione di riferimento per gemello digitale ci viene data da IBM:

Un gemello digitale è una rappresentazione virtuale di un oggetto, o di un sistema, disegnata in modo da rifletterlo accuratamente. Il gemello copre il ciclo di vita dell’oggetto rappresentato, viene aggiornato in tempo reale con dati provenienti dall’oggetto situato nel mondo reale o dall’evoluzione del modello stesso. Per funzionare ed aiutare a prendere decisioni, può fare uso di diversi modelli di simulazione, di machine learning e di intelligenza artificiale. [2]

POSSIBILI ONTOLOGIE DEI GEMELLI DIGITALI

Gli autori dell’articolo su Minerva propongono una serie di interessanti e critiche interpretazioni ontologiche dei gemelli, che possono essere diversamente visti come:

- Strumenti per vedere un mondo [3] attraverso la lente della sua rappresentazione digitale e, grazie a questa rappresentazione, studiarne le caratteristiche, scoprirne le dinamiche e la realtà (The World in the Model – The World in the Twins). Secondo questo punto di vista, il mondo “viene illuminato” dal modello.

- Artefatti o forme culturali, secondo la teoria di G. Simmel; i modelli sono una “moda” relativamente recente e possono essere interpretati – in generale - come il prodotto culturale degli anni dello sviluppo delle tecnologie informatiche in cui, di converso, si può rinvenire una geografia delle scienze disegnata dalla popolarità di diversi tipi di modelli in diverse parti del mondo.

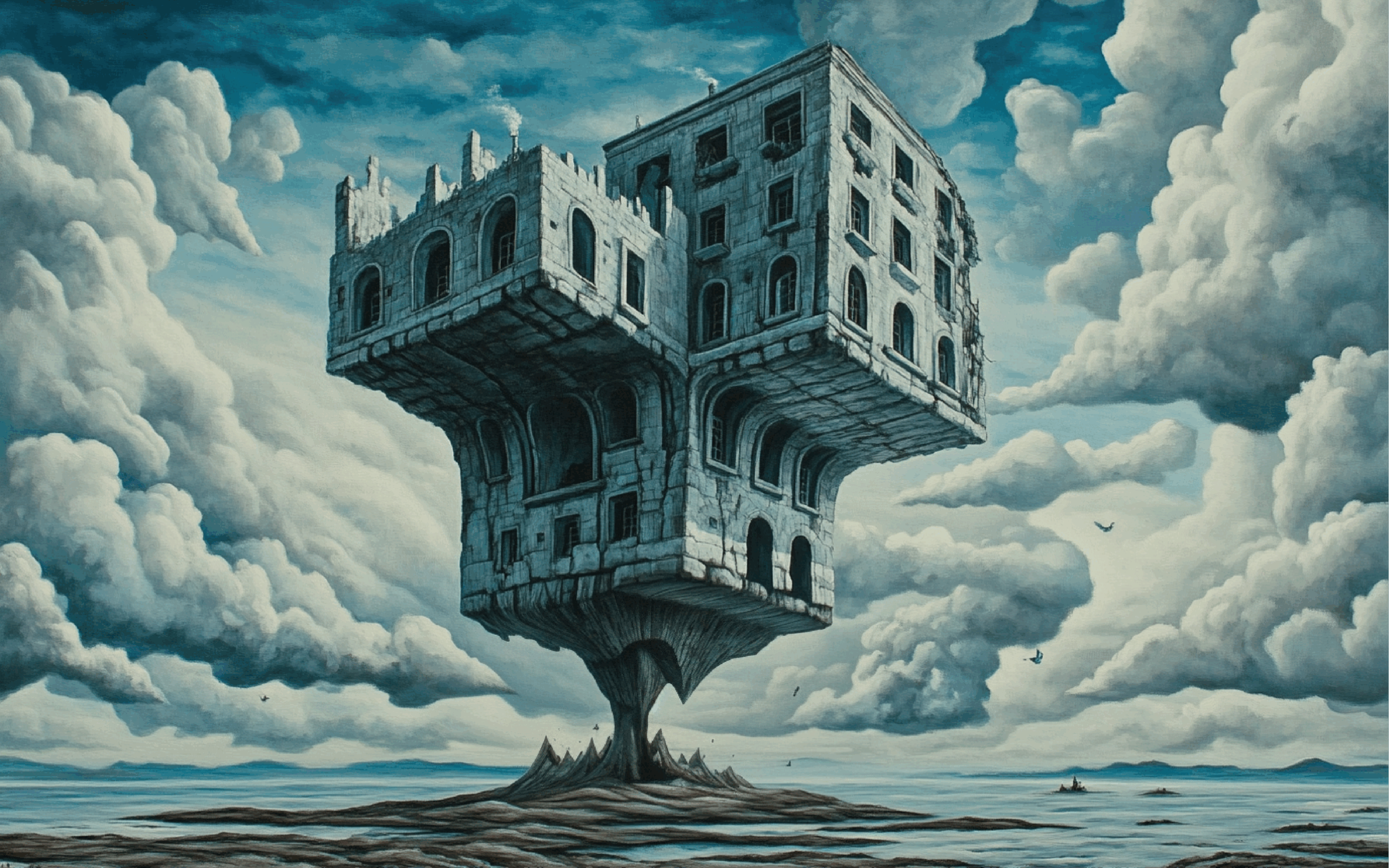

- Oggetti distanti [4] dal mondo che rappresentano e che, tuttavia, ne contendono il posto nella narrazione della comunicazione di massa: il modello assume il ruolo di neo-realtà, abolendo e facendo volatilizzare la realtà che simula.

- Burocrati senza pensiero e senza responsabilità: un gemello digitale di un ambiente può produrre conoscenza e – di conseguenza – materia su cui basare decisioni in maniera automatica e senza assumersi, in quanto macchina, alcuna responsabilità su quanto produce, sia il risultato delle elaborazioni vero, falso, onesto o distorto.

- Realizzazioni pratiche del sogno cartesiano di predizione e di controllo umano sulla natura, del realismo metafisico di cui Husserl accusa Galilei: il modello permette – sotto una serie di assiomi semplificativi e riduzionisti – di espandere il concetto di legge di natura ad un intero ambiente.

- Metafore di come percepiamo il mondo, che esprimono in forma indiretta i nostri punti di vista, preconcetti e opinioni sul mondo e sul problema rappresentati, se non addirittura sulle possibili soluzioni.

- Strumenti di divinazione, che predicono il futuro ma senza l’uso di magia o di poteri divini, e – in quanto tali – dotati di una elevata autorevolezza.

VALORE EPISTEMOLOGICO DEI GEMELLI DIGITALI

Ci pare che dalla interpretazione ontologica “The World in the Model – The World in the Twins” possa discendere la più calzante visione del ruolo epistemico dei modelli di simulazione e dei gemelli digitali, quella proposta dagli autori di mediatori [5] tra teoria e realtà, e tra realtà e osservatore.

Questo punto di vista – dicono gli autori - funge anche da antidoto contro il rischio di concepire i gemelli e i modelli matematici come “sola matematica” e sposta la discussione dalla categoria di ciò che è vero e ciò che è falso a quella della qualità […] dell’artefatto e dei suoi componenti, su cui il giudizio è messo in relazione al task che deve svolgere.

Tuttavia – nell’adozione di questa visione epistemologica - vanno tenuti in considerazione una serie di elementi potenzialmente critici:

- Quando definiamo come “matematici” i modelli di simulazione e i gemelli, rischiamo di focalizzarci su una vista parziale della loro natura poiché ben spesso questi includono nozioni teoriche (ricordiamoci come ogni esperimento sia carico di teoria), concetti matematici, tecniche digitali, fatti stilizzati, dati empirici, visioni normative , analogie e metafore. Questa considerazione richiede la consapevolezza che il modello – nel suo ruolo di mediatore – espande notevolmente la dialettica tra teoria e realtà.

- La complessità – in termini di ipotesi principali ed ausiliarie, teorie principali e “di sfondo”, elementi “non matematici” – dei gemelli digitali e di molti modelli, li espone, secondo la tesi di Duhem-Quine, a grandi difficoltà interpretative degli insuccessi e delle divergenze tra i risultati della simulazione e la realtà osservata: spesso non è possibole comprendere quale parte del modello non stia facendo il suo dovere e se sia necessario “fare il mondo più semplice o il modello più complesso”.

- L’ontologia di mediatore dei modelli richiede, inoltre, l’accortezza di non sovrapporre il modello con il suo referente, di non dimenticare che il gemello è un modello e non la realtà.

ETICA DELLA COSTRUZIONE E DELL’USO DEI GEMELLI

Le avvertenze e le considerazioni di stampo epistemologico evidenziate dagli autori (e da molti autori citati nell’ articolo, si vedano per questo gli appunti bibliografici), aprono la porta ad una serie di considerazioni di carattere morale [6], la prima considerazione delle quali – secondo me alla base di tutte le successive - è quella, ironica, di G. Box, tutti i modelli sono sbagliati ma alcuni sono utili. Il focus sull’utilità deve far riflettere, sia chi li costruisce che chi li usa, sul perché sono stati creati, sulle ragioni di chi li commissiona o li finanzia e su chi e come li utilizzerà.

Come conseguenza, gli autori mettono in guardia sulla possibilità che i gemelli possano essere:

- riduzionisti, che ignorano dimensioni scomode o difficili da rappresentare, inficiando la validità del modello o trascurando istanze morali minoritarie;

- economicisti, che mettono in primo piano, proprio come valore morale, la dimensione economica [7], trascurando i bisogni non materiali;

- giustificazionisti, costruiti e adattati con il fine di giustificare delle soluzioni, degli obiettivi o delle politiche - definite a priori o che emergono in corso d’opera

- decisionisti, mirati a semplificare la realtà in modo tale da permettere ai policy maker di prendere delle decisioni più agevolmente.

Queste distorsioni fanno capo all’obiezione di Niklas Luhmann, per cui «la scienza è spesso chiamata a “risolvere i paradossi” delle decisioni politiche, ossia a farle sembrare il risultato di un processo razionale [basato sull’oggettività dei numeri] invece che il risultato di una negoziazione tra interessi in competizione», oppure – peggio ancora – a privare i cittadini della loro possibilità di azione politica, che viene inclusa nei modelli solo in apparenza.

CONCLUSIONI

La consapevolezza di questi rischi e di queste potenziali distorsioni conducono gli autori a concludere che i gemelli vanno considerati parte del dibattito sulle questioni – ambientali, sociali, energetiche - che sono chiamati a simulare e non i produttori di risposte vere ed autentiche, di interpretazioni scientifiche ed oggettive.

Non è – secondo gli autori– la natura digitale dei modelli e dei gemelli ad essere critica ma il sistema di governance e di ownership da cui sono motivati e in cui sono immersi.

Nella realizzazione e nell’uso, quindi, devono essere tenute in debito conto le due dimensioni, tecnica e normativa, della loro qualità; la dimensione delle istanze morali che li motivano; la dimensione più ampiamente pubblica delle assunzioni e delle conclusioni e delle azioni che suggeriscono.

Ricordando la lezione di Giuseppe Scifo e interpolandola con le indicazioni normative di Funtowicz e Ravetz di cui abbiamo parlato recentemente, viene da suggerire di affidarsi meno ai modelli e ragionare, quando si deve analizzare, su “cosa succederebbe se” per avere supporto nelle decisioni politiche, in termini di scenari, cioè di fasci di modelli che variano al variare delle assunzioni su variabili il cui comportamento non è prevedibile; su gli known unknowns; sulle istanze morali minoritarie.

Programmare le azioni future sulla base di scenari permette di mantenere aperto lo spettro delle possibilità e di non trascurare le reali esigenze delle collettività.

NOTE

[1] Minerva, A Review of Science, Learning and Policy, Springer Nature, 09 April 2025

[2] Traduzione mia dall’originale: A digital twin is a virtual representation of an object or system designed to reflect a physical object accurately. It spans the object's lifecycle, is updated from real-time data and uses simulation, machine learning and reasoning to help make decisions.

[3] “Il mondo” è il referente del modello, può essere un oggetto o un ambiente, come abbiamo visto sopra

[4] Distanti anche in senso logistico: soprattutto quando si tratta di rappresentazioni del mondo naturale o dell’ambiente, i modellisti operano lontani dall’oggetto rappresentato e questa distanza favorisce la sovrapposizione del modello alla realtà.

[5] Cfr.: Morgan & Morrison (1999)

[6] Come di consueto, preferisco adottare il termine morale, anziché etico, per sottolineare la necessità di chiarire quali siano le istanze di fondo, i principi morali, appunto, su cui si basano le valutazioni, i giudizi e l’azione. È l’azione – basata su principi morali, ad essere etica. Tutte le volte che si parla di etica è – a mio avviso – necessario chiarire (o chiarirsi) quale sia la morale ispiratrice.

[7] La dimensione economica del mondo è, a mio avviso, una istanza morale che non va condannata o trascurata, poiché è quella che permette a tutti noi di mangiare, vestirci e avere una vita soddisfacente. Deve, però, avere questa visione ampia, non esclusivamente mirata allo sviluppo delle aziende.

Perché complicare ci viene più naturale che semplificare - Il bias dell’addizione

In teoria, la semplicità dovrebbe attrarci. Le soluzioni semplici sono meno costose, più eleganti, più facili da implementare. In pratica, ci troviamo costantemente ad aggiungere anziché togliere: funzioni, oggetti, procedure, parole, strutture. Questo comportamento non è soltanto una cattiva abitudine culturale o manageriale. È, in realtà, un tratto sistematico del nostro funzionamento cognitivo.

Uno studio pubblicato su Nature da Gabrielle Adams, Benjamin Converse, Andrew Hales e Leidy Klotz, tutti affiliati a università americane, documenta l’esistenza di un bias dell’addizione (“People systematically overlook subtractive changes”, Nature, 2021). Gli autori hanno condotto una serie di esperimenti in cui ai partecipanti veniva chiesto di migliorare oggetti, testi o situazioni. I risultati sono stati sorprendenti: in assenza di un suggerimento esplicito, i partecipanti tendevano quasi invariabilmente ad aggiungere qualcosa piuttosto che togliere.

Uno degli esperimenti più caratteristici prevedeva la stabilizzazione di una struttura asimmetrica costruita con mattoncini Lego. Ai partecipanti veniva mostrata una piattaforma instabile poggiata su un unico pilastro, come un tavolo con una sola gamba. L’obiettivo era far sì che la piattaforma reggesse un mattone. Ogni pezzo aggiunto costava dieci centesimi, mentre rimuovere era gratuito. La soluzione ottimale – togliere il pilastro sbilenco, lasciando che la piattaforma poggiasse direttamente sul piano sottostante – era semplice ed economicamente vantaggiosa. Ma solo il 41% la sceglieva. Tutti gli altri, aggiungevano mattoncini. Questo comportamento si è ripetuto in contesti anche molto diversi: dalla revisione di testi scritti alla progettazione di schemi architettonici, fino alla risoluzione di problemi astratti. Il pattern è rimasto costante: le persone tendono a trascurare le soluzioni basate sulla sottrazione. È come se la possibilità di togliere fosse invisibile al nostro pensiero spontaneo.

Questo bias potrebbe trovare una spiegazione alla luce di diversi meccanismi cognitivi già noti in letteratura. In primo luogo, si collega a ciò che Kahneman e Tversky hanno descritto come euristiche del giudizio: strategie rapide ma imperfette che utilizziamo per prendere decisioni in condizioni di incertezza. In questo caso, l’aggiunta rappresenta una risposta “di default”, più accessibile nella memoria operativa e più coerente con il desiderio di “fare qualcosa” per risolvere un problema.

In secondo luogo, il bias dell’addizione potrebbe essere interpretato attraverso il concetto di status quo bias (Samuelson & Zeckhauser, 1988). In questo caso le persone tenderebbero a preferire l'opzione che conserva gli elementi esistenti. Rimuovere qualcosa implica una modifica visibile dello stato attuale e può apparire più rischioso, anche quando è la scelta migliore. Inoltre, le decisioni sottrattive – ovvero quelle che comportano la rimozione di un elemento – generano spesso un maggior senso di rimpianto se l’esito non è positivo. Come mostrato da Kahneman e Miller, le azioni che modificano una situazione stabile sono più facilmente soggette a controfattuali (“se solo non avessi tolto quel pezzo...”) e dunque più dolorose da rivivere mentalmente.

Una ulteriore possibile spiegazione cognitiva potrebbe derivare dall’effetto endowment (Thaler, 1980): le persone attribuiscono maggiore valore a ciò che già possiedono. In termini cognitivi, una componente di un oggetto o di una soluzione diventa automaticamente parte dell’insieme “da preservare”, anche quando non ha alcuna funzione utile. La sua rimozione è percepita come una perdita.

Tornando allo studio di Adams e colleghi, un elemento particolarmente interessante è emerso quando i ricercatori hanno introdotto una semplice modifica: ricordare ai partecipanti, prima dell'esercizio, che anche la rimozione di elementi era una possibilità. Con questa minima manipolazione, il numero di soluzioni sottrattive è aumentato significativamente.

Questo suggerisce che il bias non dipende da un errore di valutazione – le persone, una volta rese consapevoli, riconoscono i benefici della sottrazione – ma da un difetto nel processo generativo delle soluzioni. È una cecità progettuale, una sorta di buco nell’immaginazione. E la cosa affascinante è che riguarda anche contesti “alti”: la burocrazia istituzionale, le politiche ambientali, i processi decisionali pubblici. La complessità, anche quando è inutile, ha un’aria rassicurante. Ma è spesso un inganno cognitivo, un’abitudine mentale più che una necessità razionale.

Lo sanno meglio di tutti i designer. Studi in questo ambito (Norman, 2002; Maier & Fadel, 2009) indicano come i designer inesperti preferiscano sempre “caricare” un progetto con nuove funzioni piuttosto che eliminare ridondanze.

Le implicazioni di questa distorsione non dovrebbero essere sottovalutate. Nei processi decisionali, nei modelli organizzativi, nella comunicazione pubblica, nella progettazione tecnologica, nella governance istituzionale, siamo costantemente portati a complicare le soluzioni. Ogni elemento aggiunto – che si tratti di una regola, un modulo, una funzione, un vincolo – sembra rassicurante. Ma ha un costo nascosto: aumenta la complessità, rallenta i processi, rende tutto meno adattabile e resiliente.

Essere consapevoli del bias dell’addizione non è sufficiente per evitarlo. Come per molte altre distorsioni cognitive, la consapevolezza è una condizione necessaria ma non sufficiente. Servono promemoria, checklist, strumenti di valutazione che mettano sistematicamente sotto i riflettori la possibilità di togliere, semplificare, ridurre.

La nostra mente non sembra fatta per sottrarre. Ma possiamo allenarla a vederne il valore. Come ci ricorda Dieter Rams, uno dei maestri del design minimalista, Good design is as little design as possible.

Oggi sappiamo che vale anche per il pensiero creativo. Anche questo articolo, probabilmente, sarebbe stato migliore, se avessi tagliato qualcosa.

BIBLIOGRAFIA

Adams, Gabrielle, Benjamin A. Converse, Andrew Hales, and Leidy Klotz. “People Systematically Overlook Subtractive Changes.” Nature, vol. 592, no. 7853, 2021, pp. 258–261.

Kahneman, Daniel, and Amos Tversky. “Choices, Values, and Frames.” American Psychologist, vol. 39, no. 4, 1984, pp. 341–350.

Kahneman, Daniel, and Dale T. Miller. “Norm Theory: Comparing Reality to Its Alternatives.” Psychological Review, vol. 93, no. 2, 1986, pp. 136–153.

Lovell, Sophie. Dieter Rams: As Little Design as Possible. Foreword by Jonathan Ive, Phaidon, 2024.

Maier, Jennifer R., and Georges M. Fadel. “Affordance-Based Design Methods for Innovative Design.” Design Studies, vol. 30, no. 4, 2009, pp. 383–410.

Motterlini, Matteo. Trappole mentali: Come difendersi dalle proprie illusioni e dagli inganni altrui. Rizzoli, 2008.

Norman, Donald A. Il design delle cose di tutti i giorni. Translated by R. Boggiani, Giunti, 2002.

Samuelson, William, and Richard Zeckhauser. “Status Quo Bias in Decision Making.” Journal of Risk and Uncertainty, vol. 1, no. 1, 1988, pp. 7–59.

Thaler, Richard H. “Toward a Positive Theory of Consumer Choice.” Journal of Economic Behavior and Organization, vol. 1, no. 1, 1980, pp. 39–60.

Stand by me, LucrezIA - Ovvero, l’università resa superflua da sé medesima

L’industria digitale ha ormai da tempo colonizzato completamente il mondo dell’educazione e della formazione in tutte le sue componenti, dalle scuole elementari all’università, senza peraltro conseguire gli effetti migliorativi a suo tempo promessi.[1] Da ultimo, questo fenomeno si manifesta, in particolare, sotto forma di onnipresenza della intelligenza artificiale, che sempre più si configura non solo come un insieme di applicazioni e servizi più o meno utili, ma anche come il must-have della stagione, per dirla con il linguaggio della moda. Non c’è azienda, amministrazione pubblica, giornale, apparato poliziesco, militare o governativo, giù giù fino all’ultima gelateria e bocciofila, che non ritengano proprio dovere affidarsi ai fantasmagorici servigi dell’IA (se poi ci si accorge che i vantaggi sono scarsi o nulli, fa niente: è un Dovere, una Fede, forse anche un Mistero… “E chi siamo noi per rifiutarla”?).

Il mondo dell’educazione e dell’università, per certi aspetti, guidano questa Marcia Gloriosa del Progresso. È del resto recente l’ultima profezia dell’immarcescibile Bill Gates (peraltro già sentita giusto un migliaio di volte) sulla prossima estinzione di medici e insegnanti: «in futuro gli esseri umani non saranno più necessari per la maggior parte delle cose, oltre ai medici si potranno rivoluzionare metodologie didattiche e il ruolo stesso dell’insegnante; sistemi basati sull’intelligenza artificiale possono fungere da tutor personalizzati».[2]

A che punto sono arrivate le cose si può vedere chiaramente da una notizia che ho scovato in un oscuro (ma sempre ben informato e curioso) quotidiano economico italiano, di cui mi sembra opportuno dare conto su “Controversie” (Carlo Valentini, L’ateneo che ha sposato l’IA, “Italia Oggi”, 5 febbraio 2025, p. 6). Si tratta dell’Università di Padova e della sua scelta di dotarsi di un proprio sistema di IA capace di coprire grande parte dell’attività amministrativa, di informazione ma anche didattica dell’ateneo.

Presentato (togliattianamente) come «la via italiana all’intelligenza artificiale», pare che questo sistema sia uno dei più avanzati d’Europa in ambito accademico. Il suo nome è LucrezIA, in omaggio a Lucrezia Corner Piscopo che, laureatasi (in Filosofia) a Padova nel 1678, può essere considerata la prima donna laureata del mondo.

1. LE FUNZIONI DI LUCREZIA

LucrezIA consente all’utente di ottenere tutti i documenti prodotti dall’Università di Padova, tutti i servizi offerti dall’ateneo, ma soprattutto – ed è quello che qui interessa – è a disposizione per le attività didattiche; anzi, ne è caldamente consigliato l’uso. Leggiamo, infatti, che gli studenti «possono avvalersi di ChatUniPd anche per elaborare la tesi di laurea, pur se con qualche cautela».

Capito? Son passati i tempi in cui uno si iscriveva all’università e concludeva il proprio percorso di studi preparando una dissertazione detta tesi di laurea: adesso la tesi se la fa fare dall’IA. Certo, però, «con qualche cautela». Ma come? Non siamo, ormai da tempo, nelle scuole come nelle università, alle prese con eserciti di giovani che scopiazzano dalla rete, tanto che sono stati inventati addirittura dei ridicoli “software antiplagio”? Non ci si lamenta, da tempo, che in ogni caso contrastare questa tendenza è una battaglia assai ardua, data la onnipervasività dell’informazione online? Che fare, allora? Ma certo! Invitare direttamente gli studenti a usare l’IA per realizzare la propria tesi… Come abbiam fatto a non pensarci prima!

E allora, di grazia, cosa vogliamo da questi nostri figli? Vogliamo che copino mettendo da parte il cervello, perché ormai la cultura è questo rifriggere cose rifritte (con tanti saluti per ogni guizzo di pensiero critico e autonomo – forse il vero obiettivo strategico del Potere attuale), oppure vogliamo che ancora pensino e studino in proprio? E che messaggio mandiamo, allorché gli facciamo sapere che devono fare la tesi con LucrezIA, però – sia ben chiaro – con «qualche cautela»?

Sapete a cosa mi fa pensare tutto questo? Mi fa pensare alla teoria del doppio legame [double bind] di Gregory Bateson.[3] Ricordiamola brevemente.

Secondo l’antropologo, psichiatra e zoologo britannico (1904-1980), patologie psichiche come la schizofrenia sarebbero causate da forme di comunicazione ambivalente interne alla famiglia, in particolare nella relazione del bambino con membri significativi, tipicamente con la madre (ma non solo). Posto, per esempio, in una situazione in cui la mamma gli chiede di abbracciarlo ma in realtà gli fa capire con il linguaggio del corpo o con altre forme di meta comunicazione che non ne ha alcuna voglia, il bambino vivrà una situazione senza uscita: non potrà riconoscere una mancanza di affetto da parte di una figura per lui vitalmente importante, ma neanche accogliere il messaggio “dichiarato”. Con effetti, a parere di Bateson, altamente dannosi sul piano psicologico.

In modo forse non molto dissimile, la comunicazione disfunzionale del capitalismo tecno-nichilista attuale comunica allo studente una doppia ingiunzione contraddittoria:

(1) usa gli strumenti dell’IA per produrre in forma automatica la “tesi di laurea”, così da essere pienamente un abitatore del tempo presente;

(2) ma anche cerca di essere un bravo studente, autonomo, originale, che controlla e verifica le fonti, uno studente “come ai vecchi tempi”, potremmo dire.

Il potere oggi vigente non può e non vuole vietare o anche solo limitare una tecnologia, fosse pure totalmente distruttiva,[4] ma non è neanche ancora pronto a liquidare apertamente i vecchi cascami della Cultura come appunto l’università europea (ci tiene forse ancora, a scopo ornamentale, come un tempo molte famiglie borghesi tenevano le librerie rifornite di volumi elegantemente rilegati all’unico scopo di esibirne i dorsi dietro le vetrine ben chiuse…). Di qui il messaggio ambivalente.

Ai ragazzi di oggi, incolpevoli destinatari di questa comunicazione patogena, la mia piena solidarietà, non disgiunta dall’invito alla rivolta.

2. ABOLIRE LE UNIVERSITÀ?

Continuiamo comunque nella lettura dell’articolo. Apprendiamo anche che grazie a LucrezIA «si è potuto realizzare un intero libro», di ben 241 pagine, intitolato Dialoghi con il futuro sulle future trasformazioni indotte nella società dai sistemi di intelligenza artificiale. E non solo. Per iniziativa di un docente dell’Università di Padova esperto di tecnologie digitali,

«è stato chiesto all’IA come Marx avrebbe commentato l’avvento dell’intelligenza artificiale. Questa è stata la risposta: “Se fossi Karl Marx, potrei considerarne l’avvento da una prospettiva critica. Marx era un teorico sociale ed economico noto per la sua analisi critica del capitalismo, e probabilmente esaminerebbe come queste nuove tecnologie influenzano le dinamiche di potere e le relazioni di produzione. (…) Marx potrebbe esplorare come la proprietà e il controllo dei mezzi di produzione delle informazioni influenzano la struttura sociale ed economica. Inoltre potrei considerare come l’automazione e l’intelligenza artificiale impattano sul lavoro umano. Marx si sarebbe interessato alle implicazioni per la classe lavoratrice e a come la tecnologia può essere utilizzata per migliorare o minacciare il benessere delle persone”. Commenta Nicola Bruno: “Da questo esempio emerge come l’IA possa essere usata con una prospettiva fuori dagli schemi. Collegando il pensiero di Marx alle tecnologie contemporanee un docente potrebbe trarre spunto dalla risposta dell’IA per spiegare la filosofia di Marx calandola nell’attualità”».

Sì, senz’altro, Marx potrebbe dire queste e simili cose sull’introduzione dell’intelligenza artificiale. Sicuramente, poi, un docente universitario potrebbe «trarre spunto» da quanto gli ha detto LucrezIA per fare una lezione o due su Marx…. Ma – mi chiedo e chiedo ai lettori – queste cose non potrebbe anche pensarle un docente a ciò deputato e a questo fine retribuito dall’università stessa, senza alcun bisogno di… interpellare l’IA? Non potrebbe un docente dell’università stessa, forte di un suo percorso di studi in filosofia o sociologia o economia che immaginiamo gli abbia fruttato il posto che occupa, scrivere un saggetto di quel genere, o organizzare una lezione o un corso, «calando nell’attualità» il pensiero di Marx? Non potrebbe, secondo la humboldtiana concezione dell’università di cui in Europa un tempo mi pare ci vantassimo, preoccuparsi di trasmettere il suo sapere e i risultati delle sue ricerche agli studenti che hanno la ventura di frequentare l’università (cacciando, peraltro, un po’ di soldini) e che coronano infine il loro percorso di studio appunto con la redazione di un saggio? Non era proprio questo, almeno fino a qualche annetto fa, il fine delle nostre università? Ma, allora, perché non abolirle proprio?

Poscritto – Al momento di chiudere questo articolo, apprendo che all’Università di Cassino si è tenuta la prima discussione di laurea sostenuta da un… avatar digitale. Durante l’esposizione – ci informa “Il Messaggero” – la candidata si è limitata «ad assistere la sua rappresentazione AI», da lei debitamente istruita e “allenata” con i contenuti della sua ricerca.

Dopo gli operai, anche gli studenti sempre più «appendici umane» (di marxiana memoria) del sistema di macchine?

NOTE

[1] Di «politiche forsennate della digitalizzazione del sistema scolastico, dall’asilo fino all’università» parla Michel Desmurget (Il cretino digitale, Milano, Rizzoli, 2020, p. 237), che porta molti dati sulle recenti ricerche (PISA ecc.) in base alle quali emerge che digitale e buoni risultati scolastici non sono affatto direttamente proporzionali (cfr. p. 237 e seg.). Per un bilancio critico equilibrato sulla questione dell’invasione tecnologica negli ambienti scolastici, si veda Marco Gui, Il digitale a scuola. Rivoluzione o abbaglio?, Bologna, Il Mulino, 2019. Da notare che considerazioni critiche filtrano anche in testi decisamente apologetici come, per esempio, Luca Tremolada, La lezione è finita, Milano, Il Sole 24 Ore, 2024.

[2] Cfr. Bill Gates: l’intelligenza artificiale sostituirà medici e insegnanti entro 10 anni, “com.unica”, 2 aprile 2025, https://www.agenziacomunica.net/2025/04/02/bill-gates-lintelligenza-artificiale-sostituira-medici-e-insegnanti-entro-10-anni/ e Paolo Del Debbio, Gates tifa l’intelligenza artificiale per rimpiazzare dottori e docenti, “La verità”, 3 aprile 2025, p. 15.

[3] Cfr. Gregory Bateson, Verso una teoria della schizofrenia (1956), in Id., Verso un’ecologia della mente, Milano, Adelphi,1976, p. 244-274. L’idea di applicare questo concetto di Bateson al linguaggio della comunicazione tipico delle società capitalistiche avanzate è in Nello Barile, La mentalità neototalitaria, Milano, Apogeo, 2008. In effetti, il discorso pubblico neoliberale è ricco di queste ingiunzioni contraddittorie: pensiamo al campo del lavoro, nel quale da un lato viene mantenuta la retorica (per così dire “weberiana”) della professionalità, del lavoro e dell’impegno (lo abbiamo visto di recente in Italia, quando si voleva demonizzare il reddito di cittadinanza!), ma dall’altro l’estrema precarietà estrema, i bassi salari, i miti della società liquida, nonché la continua evocazione della robotizzazione imminente spingono i lavoratori a perdere qualunque tipo di attaccamento al lavoro (cfr. Francesca Coin, Le grandi dimissioni, Torino, Einaudi, 2023).

[4] «VIETATO VIETARE, la legge fondamentale del progresso tecnoscientifico è diventata dunque l’unica legge di un mondialismo senza legge?» si chiedeva retoricamente Paul Virilio in L’incidente del futuro, Milano, Cortina, 2002, p. 32.